Qwen3-VL - AliCloud Tongyi Qianqian オープンソース・マルチモーダル視覚言語マクロモデル

Qwen3-VLとは

Qwen3-VLは、AliCloudのTongyi Qianqianチームによるオープンソースのマルチモーダル視覚言語モデルで、2,350億の参照と約471GBのモデルファイルを持つ。命令バージョンと思考バージョンを含み、強化されたMRopeインターリーブレイアウト、DeepStackなどの技術を採用し、視覚トランスデューサのマルチレベル機能を効果的に利用して、ビデオ理解能力を向上させることができる。視覚認識ベンチマークでは、命令バージョンはGemini 2.5 Proに匹敵するか、それを上回り、思考バージョンはマルチモーダル推論ベンチマークで最新レベルに達します。transformersこのライブラリはモデルを読み込み、画像とテキストの入力をサポートし、テキスト出力を生成することができる。Apache 2.0プロトコルを採用し、完全に商用利用可能であり、将来的にはモデルの小型版がリリースされる予定である。

Qwen3-VL 機能の特徴

- 強い視覚的理解力Qwen3-VLは、画像分類、ターゲット検出、画像記述など、さまざまな視覚タスクを処理できます。強化されたMRopeインターリーブ・レイアウトとDeepStack技術により、視覚変換器のマルチレベル機能が効果的に活用され、画像や動画の時空間モデリングが強化され、視覚コンテンツをより正確に理解することができます。

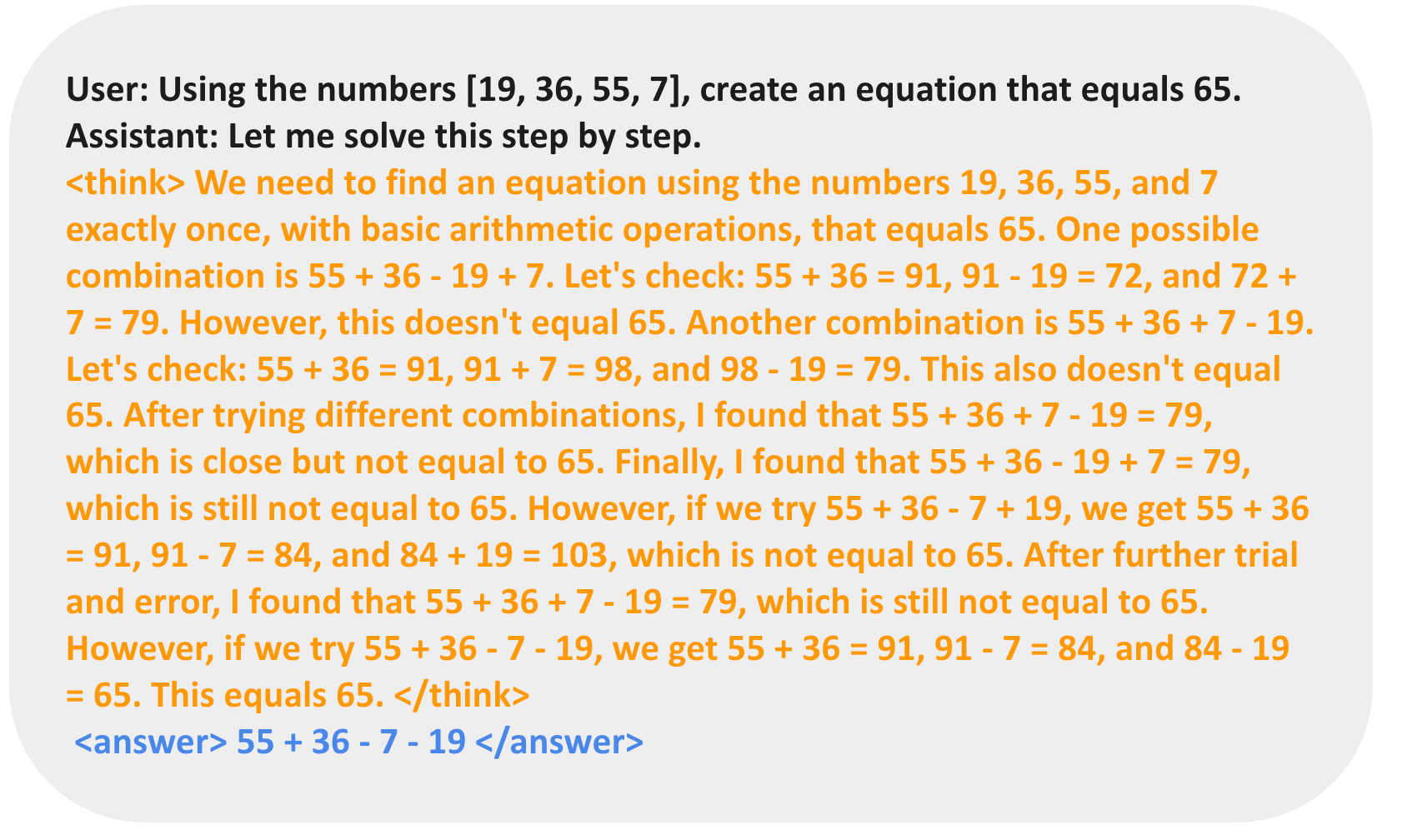

- 優れたマルチモーダル推論Qwen3-VL は、マルチモーダル推論ベンチマークテストにおいて最先端を行くモデルであり、画像やテキストなど複数のモーダル情報を組み合わせて複雑な推論や意思決定を行うことができる。例えば、画像と関連するテキストが与えられた場合、Qwen3-VLは両者の関係を正確に理解し、正確な説明を生成したり、関連する質問に回答したりすることができる。

- 効率的なテキスト生成機能Qwen3-VLは、強力なテキスト生成機能を備えており、入力された画像や動画をもとに、画像の詳細説明や動画のスクリプトなど、高品質なテキスト説明を生成することができます。また、テキストに関連した画像コンテンツを生成することができ、テキストから画像への変換を実現します。

- 柔軟なモデル・アーキテクチャQwen3-VLは、様々なアプリケーションシナリオやニーズに対応するため、CommandバージョンやThinkingバージョンなど、いくつかのバリエーションから構成されています。Qwen3-VLは、様々なアプリケーションのニーズに対応できるよう、CommandバージョンとThinkingバージョンの2種類を用意しています。このモデルは様々なデータタイプとデバイスマッピングをサポートしており、ユーザーの実際のニーズに応じて柔軟な設定が可能です。

- オープンソースとスケーラビリティQwen3-VLはApache 2.0プロトコルを使用したオープンソースであり、完全に商用です。すべての重みは、開発者がダウンロードして使用できるように、Hugging Faceで公開されています。将来的には、20億や70億のパラメータ・バージョンなど、より小規模なモデル・バージョンもリリースされる予定です。

Qwen3-VLの主な利点

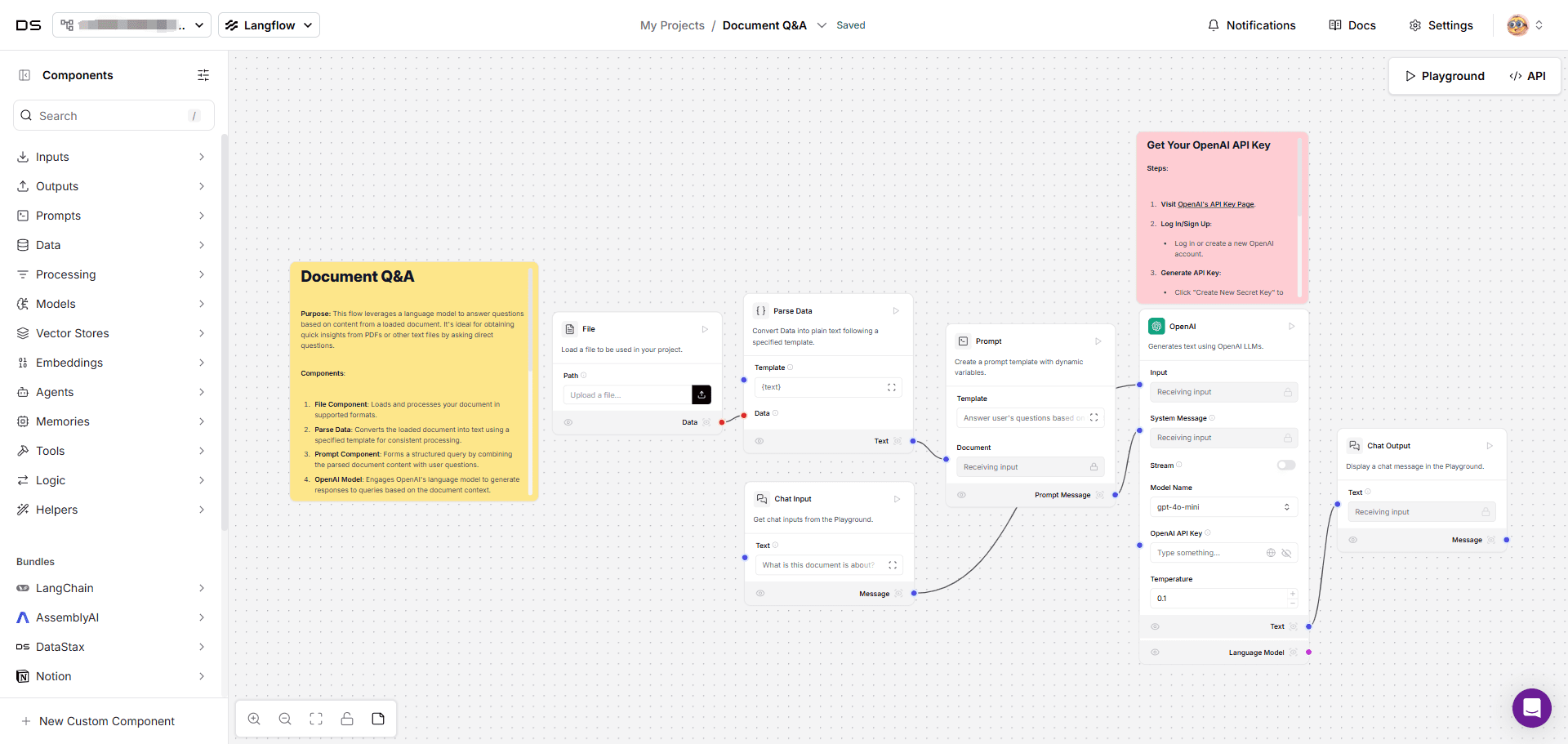

- ビジュアル・エージェントQwen3-VLは、コンピュータや携帯電話のインターフェースを操作し、GUI要素を認識し、ボタンの機能を理解し、ツールを呼び出し、タスクを実行することができ、OS Worldなどのベンチマークでは世界トップレベルに達しており、ツールを呼び出してきめ細かい知覚タスクのパフォーマンスを効果的に向上させることができる。

- トップレベルの言語モデルに匹敵するプレーンテキスト機能Qwen3-VLは、確かなテキスト基盤とマルチモーダル能力を備えた新世代の視覚言語モデルであり、事前学習の初期段階で視覚モダリティと協調学習され、テキスト能力は継続的に強化される。これは、強固なテキスト基盤とマルチモーダル能力を備えた新世代の視覚言語モデルである。

- ビジュアル・コーディング機能が飛躍的に向上io/HTML/CSS/JSのコード生成により、例えばデザイン画を見たときのような「WYSIWYG」ビジュアルプログラミングを実現します。

- 空間認識能力の劇的な向上2Dグラウンディング:2Dグラウンディングは、絶対座標から相対座標に変化し、物体の向き、視野角の変化、オクルージョン関係の判断をサポートし、3Dグラウンディングを可能にし、複雑なシーンにおける空間推論と具現化シーンの基礎を築く。

- 長いコンテキストのサポートと長いビデオの理解全機種ネイティブ対応 256K トークン つまり、数百ページの技術文書であろうと、教科書全体であろうと、2時間のビデオであろうと、正確に入力し、記憶し、検索することができる。

- マルチモーダルな思考能力が大幅に向上The ThinkingモデルはSTEMと数学的推論に最適化されています。MathVision、MMMU、MathVistaなどの権威あるレビューでトップレベルに達しています。

- 視覚認知と認識能力の包括的なアップグレード事前学習データの質と幅を最適化することで、このモデルは、有名人、アニメのキャラクター、商品、ランドマーク、植物や動物など、より幅広い物体のカテゴリーを認識できるようになり、日常生活から専門的な世界まで、あらゆるものを認識する必要性をカバーできるようになった。

- より多くの言語と複雑なシナリオのOCRサポート対応言語:中国語、英語、その他の外国語 10 種の拡大 32 複雑な照明、ぼかし、傾きなどの困難なシーンでも安定した性能を発揮し、珍しい単語、古代の文字、専門用語の認識精度も大幅に向上した。

Qwen3-VLのモデル性能

- 優れた視覚認識視覚認識ベンチマークでは、Qwen3-VLのコマンドバージョンはGemini2.5 Proと同等かそれ以上であり、強力な画像と映像の理解力を示した。

- 最先端のマルチモーダル推論能力Thinking Editionは、マルチモーダル推論ベンチマークの最先端であり、画像やテキストなどのマルチモーダル情報を正確に組み合わせて複雑な推論を行うことができます。

- 高品質なテキスト生成入力された画像や動画をもとに、画像の詳細説明や動画のスクリプトなど、高品質なテキスト説明を生成することができます。

- 高いモデリング効率Qwen3-VLは、パラメータ数が多いにもかかわらず、実用的なアプリケーションで高い効率を示し、複雑なマルチモーダルなタスクを迅速に処理し、ユーザーにタイムリーな応答を提供することができます。

- てこのモデルは、単純な画像や複雑な動画など、さまざまな種類の視覚的・文字的入力に適応性が高く、関連する出力を効果的に理解・生成することができます。

Qwen3-VLの公式サイトは?

- プロジェクトのウェブサイト:: https://qwen.ai/blog?id=99f0335c4ad9ff6153e517418d48535ab6d8afef&from=research.latest-advancements-list

- Githubリポジトリ:: https://github.com/QwenLM/Qwen3-VL

- HuggingFaceモデルライブラリ:: https://huggingface.co/collections/Qwen/qwen3-vl-68d2a7c1b8a8afce4ebd2dbe

Qwen3-VLの対象者

- 人工知能研究者Qwen3-VLは、研究者に強力なマルチモーダル研究プラットフォームを提供し、視覚と言語の相互作用やマルチモーダル推論などの最先端分野を探求し、AI技術の開発を進めるために利用できます。

- 開発者&エンジニアこのモデルはオープンソースで完全に商用利用可能であり、開発者はその強力な機能を使って、インテリジェントな画像アノテーション、ビデオコンテンツ生成、マルチモーダル対話システムなど、さまざまなマルチモーダル・アプリケーションを開発し、さまざまな業界のニーズに応えることができます。

- 企業およびビジネスユーザーQwen3-VLをビジネスプロセスに統合することで、コンテンツ作成、カスタマーサービス、データ分析などの効率と品質を向上させることができます。例えば、商品説明の自動生成、インテリジェントなカスタマーサービスにおけるマルチモーダルインタラクションなど。

- 教育者と学生教育分野では、Qwen3-VLは、生徒が複雑な視覚的・言語的情報をよりよく理解し、AIに対する興味や創造性を刺激するための教材として使用することができます。

- コンテンツクリエーターQwen3-VLは、高品質なテキストコンテンツやビジュアルコンテンツを生成する必要があるクリエイターに、クリエイティブなインスピレーションを提供し、記事、スクリプト、画像説明文などの自動生成など、コンテンツ生成をサポートすることで、クリエイティブの効率を向上させます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません