Qwen2.5-VLノートブックの例題詳細:マルチモーダル視覚モデルを始めよう

最近、Qwenのチームは、このシリーズを誇らしげに発表した。 Qwen2.5-VLユースケースノートブックの例これは、ネイティブ・モデルとAPIのパワーを包括的に示すものです。 この入念に作られたノートブックのコレクションは、開発者やユーザーがネイティブ・モデルやAPIをより深く理解できるように設計されています。 クウェン2.5-VL 強力な視覚的理解と、より革新的なアプリケーションを刺激する。

ノートブックの例:Qwen 2.5-VL入門

これらの詳細なNotebookの例を使用すると、開発者は次のことができます。 Qwen 2.5-VLモデルがあらゆるタスクでどのようなパフォーマンスを発揮するか、スピードアップしてご自身の目でお確かめください!Qwen2.5-VL 複雑なドキュメントの解析、正確なOCRタスクの実行、ビデオコンテンツの詳細な理解など、Qwen2.5-VLは効率的で正確なフィードバックを提供し、その優れたパフォーマンスを実証します。

同時に、Qwenチームは、Qwen 2.5-VLの機能を改善・拡張し、マルチモーダル技術の発展を促進するために、コミュニティからのフィードバックや貢献を期待しています。

🔗 関連記事

- GitHubリポジトリ。 https://github.com/QwenLM/Qwen2.5-VL/tree/main/cookbooks

- オンライン経験。 https://chat.qwenlm.ai (Qwen2.5-VL-72B-Instruct モデルを選択)

- ModelScope モデルリンク: https://www.modelscope.cn/collections/Qwen25-VL-58fbb5d31f1d47

- Parsons Brinckerhoff APIインターフェース。 https://help.aliyun.com/zh/model-studio/user-guide/vision/

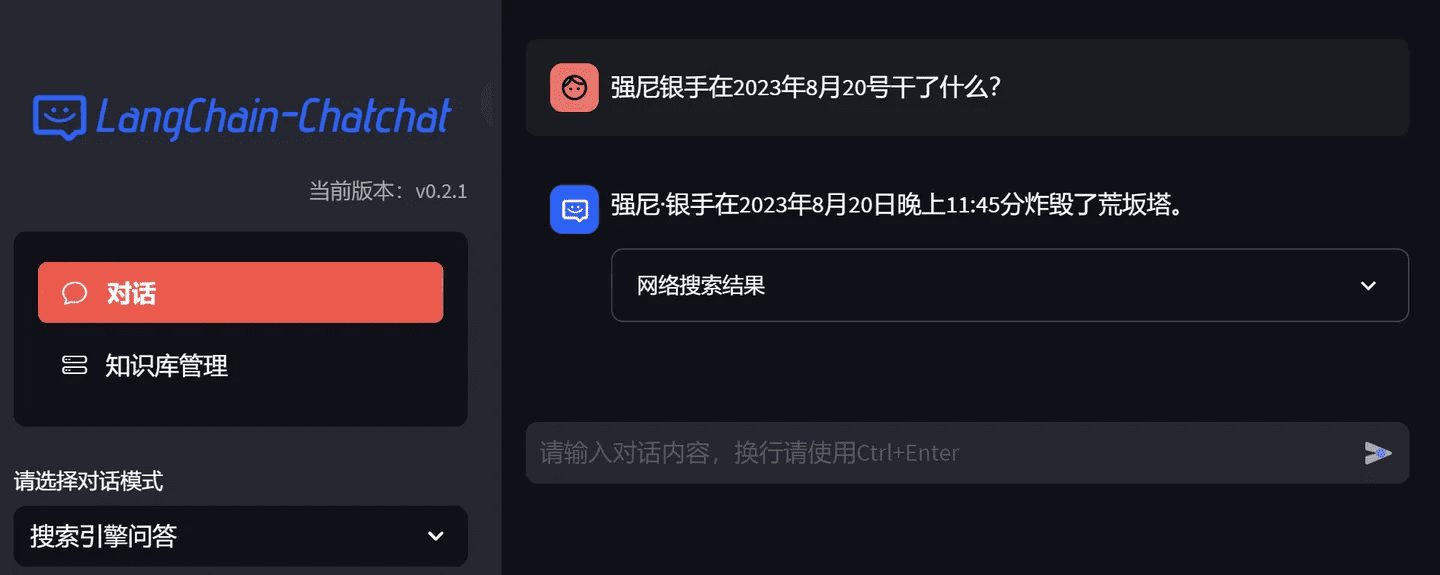

ノートブックの詳細

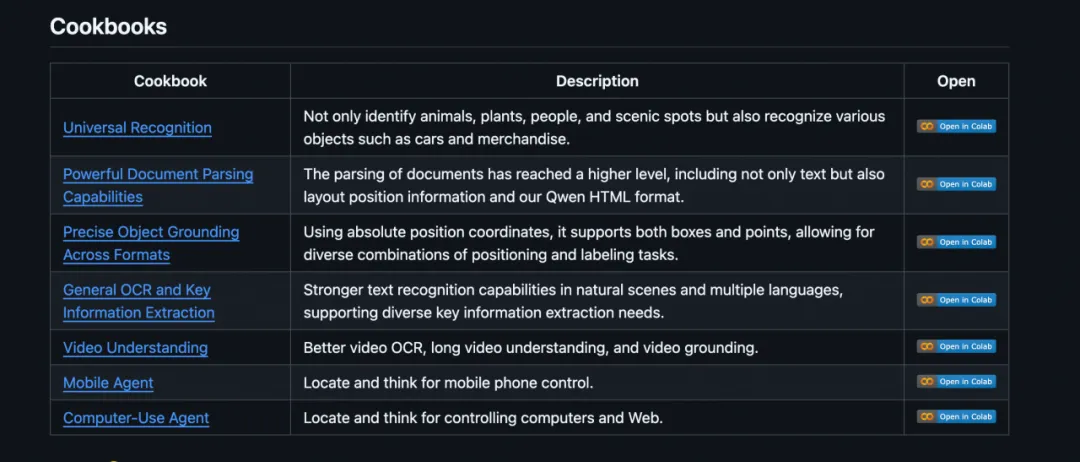

01 コンピュータ使用

このノートブックの例では、Qwen2.5-VL を使用して、コンピュータの使用に関するタスクを実行する方法を示します。

Qwen2.5-VLモデルは、スクリーンショットの内容を分析し、ユーザーの意図を理解し、クリックやタイピングなどの正確な指示を生成することで、コンピュータのインテリジェントな制御を実現します。

👉 ノートブックリンク https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/computer_use.ipynb

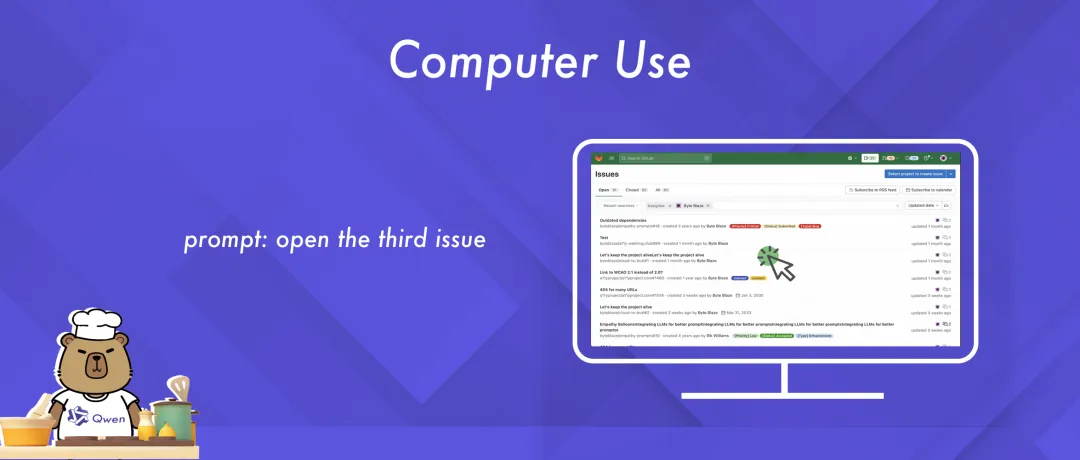

02 空間理解

このノートブックの例では、Qwen2.5-VL の高度な空間定位機能を紹介しています。この機能には、正確な物体検出や画像内の特定ターゲットの定位が含まれます。

この例では、Qwen2.5-VL が視覚と言語による理解を効果的に統合することで、複雑なシナリオを正確に解釈し、高度な空間推論を可能にしていることが分かります。

👉 ノートブックリンク https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/spatial_understanding.ipynb

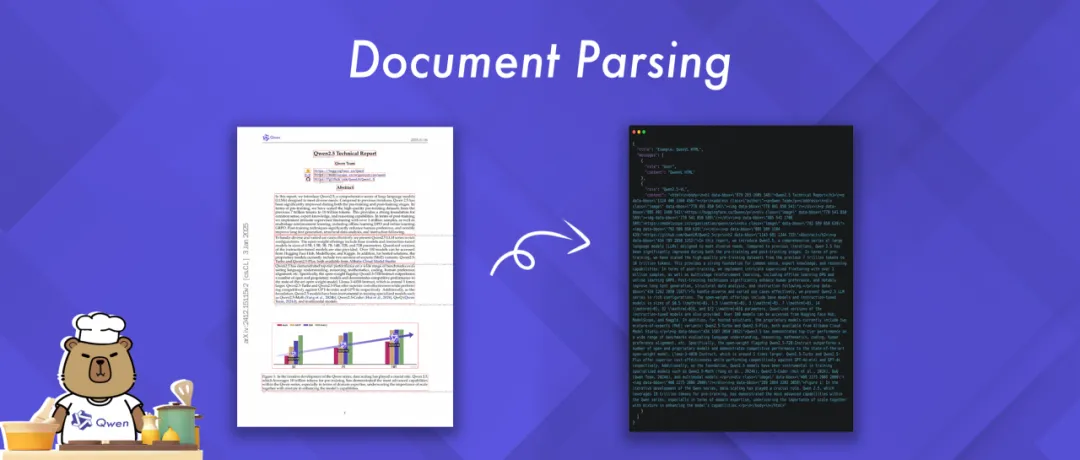

03 ドキュメントの解析

このノートブックの例では、Qwen2.5-VL の強力なドキュメント解析機能を紹介します。 様々な画像形式のドキュメントを処理し、解析結果を HTML、JSON、MD、LaTeX などの様々な形式で出力できます。

特に興味深いのは、Qwen が独自の QwenVL HTML フォーマットを導入したことです。 このフォーマットには、ドキュメント内の各コンポーネントの位置に関する情報が含まれており、ドキュメントの正確な再構築と柔軟な操作が可能です。

👉 ノートブックリンク https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/document_parsing.ipynb

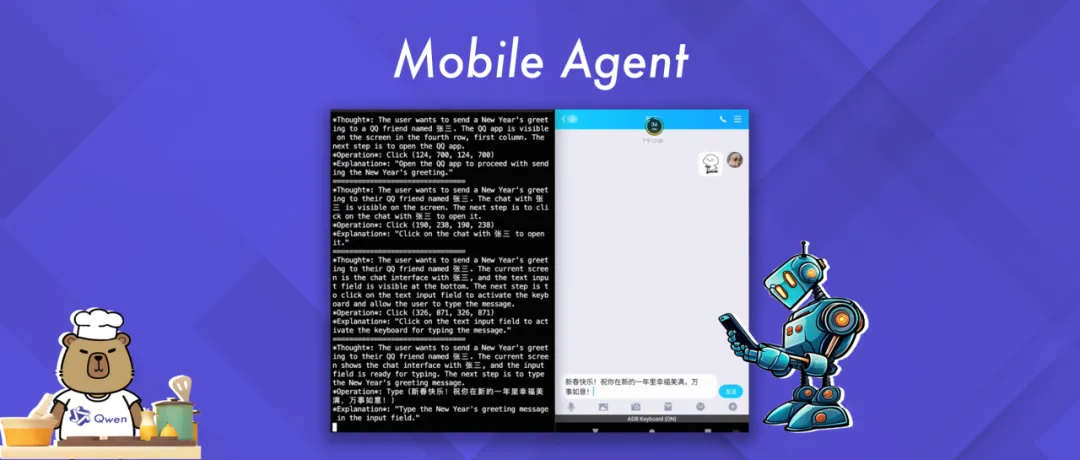

04 モバイルエージェント(モバイルデバイスエージェント)

このノートブックの例では、Qwen2.5-VL のエージェント機能を使用して、モバイル機器とインテリジェントに対話する方法を示します。

この例では、Qwen2.5-VLモデルが、ユーザーのクエリーとモバイル機器の視覚的コンテキストに基づいて、どのようにアクションを生成し、実行するかを示しています。

👉 ノートブックリンク https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/mobile_agent.ipynb

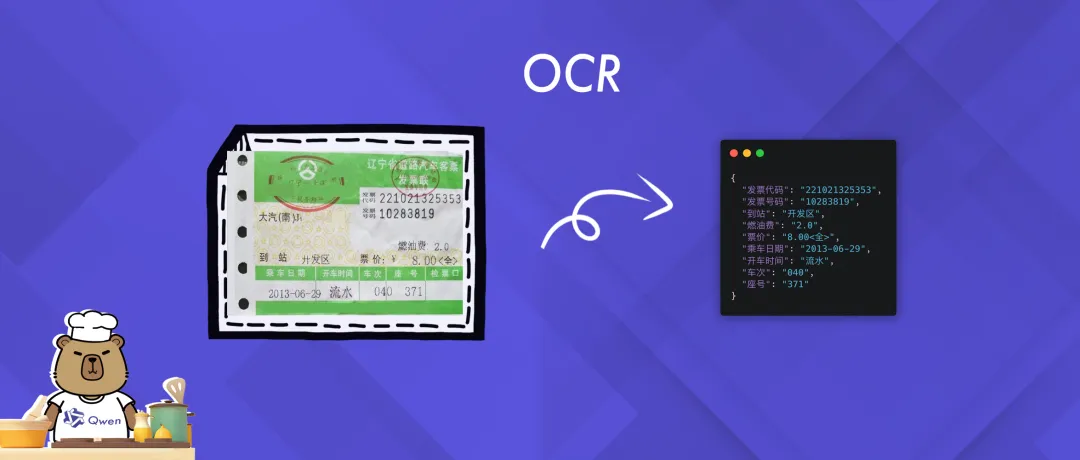

05 OCR(光学式文字認識)

このノートブックの例では、Qwen2.5-VL の OCR(光学式文字認識)機能(画像からテ キスト情報を正確に抽出・認識する機能)のデモンストレーションに重点を置いています。

例題を通して、Qwen2.5-VLが複雑なシナリオにおいて、いかに正確にテキストコンテンツをキャプチャし、解釈できるかを直感的に理解し、その強力なテキスト認識能力を実証することができます。

👉 ノートブックリンク https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/ocr.ipynb

06 ユニバーサル認識

このノートブックの例では、Qwen2.5-VL を一般的な物体認識に使用する方法を示します。

Qwen2.5-VLモデルは画像を分析し、ユーザーのクエリ意図を理解し、対応する認識結果を提供することで、画像コンテンツの包括的な理解を実現します。

👉 ノートブックリンク https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/universal_recognition.ipynb

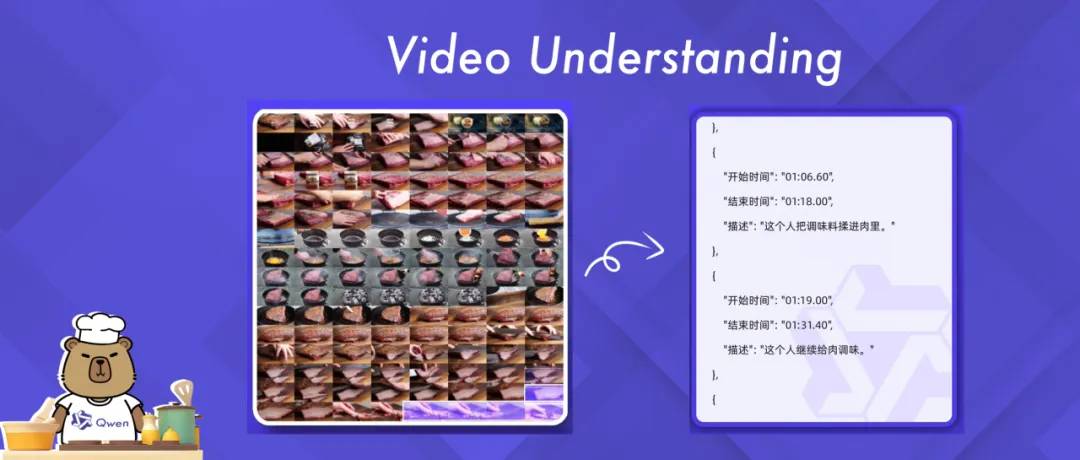

07 ビデオ理解

Qwen2.5-VLは強力な長時間の動画理解能力を持ち、1時間以上の動画コンテンツを扱うことができます。 このNotebookの例では、Qwen2.5-VLのビデオ理解タスクの機能を詳しく説明します。

Qwen2.5-VLは、基本的なOCR(光学式文字認識)から複雑なイベント検出やコンテンツの要約に至るまで、幅広いビデオ解析シナリオにおいてその可能性を実証するよう設計されています。

👉 ノートブックリンク https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/video_understanding.ipynb

マジック・ヒッチのベストプラクティス: 自由な算術プレー クックブックの例

ModelScope Magic Hitchのコミュニティでは、ユーザはこれらのクックブックの例を自由な演算で簡単に体験することができます。

まず、Qwen2.5-VL のコードをダウンロードします。

git clone https://github.com/QwenLM/Qwen2.5-VL.git

NotebookでModels APIを使う: MagicBuilderプラットフォームAPI-Inferenceは、Qwen2.5-VLファミリーのモデルのためのAPIを無償で提供します。このAPIは、クックブックのbase-URLを置き換えてMagicBuilder SDKに記入することで、APIコールを介してMagicBuilderユーザーが直接使用することができます。 トークン 準備はできている。詳細な文書: https://www.modelscope.cn/docs/model-service/API-Inference/intro

from openai import OpenAI

client = OpenAI(

api_key="<MODELSCOPE_SDK_TOKEN>", # ModelScope Token

base_url="https://api-inference.modelscope.cn/v1"

)

response = client.chat.completions.create(

model="Qwen/Qwen2.5-VL-72B-Instruct", # ModelScope Model-Id

messages = [

{

"role": "user",

"content": [

{

"type": "image_url",

"image_url": {"url": "https://modelscope.oss-cn-beijing.aliyuncs.com/demo/images/bird-vl.jpg"}

},

{ "type": "text",

"text": "Count the number of birds in the figure, including those that are only showing their heads. To ensure accuracy, first detect their key points, then give the total number."

},

],

}

],

stream=True

)

ノートブックはローカルモデルを使用している: GPUモデルを選択してください。

結論:一緒に未来を体験し、創造することを歓迎する

将来、Qwen チームは、開発者により包括的なソリューションを提供するために、より便利な機能やアプリ ケーションシナリオを取り入れるために、これらの Notebook のサンプルを更新し、拡張し続けます。 Qwen2.5-VLのGitHubリポジトリやModelScopeを訪問して、これらのNotebookサンプルを体験し、あなたの経験や革新的なアプリケーションを共有してください!Qwenチームは、あなたとQwen2.5-VLの可能性を探求することを楽しみにしています。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません