MoE アーキテクチャに基づく Qwen2.5-Max が DeepSeek V3 を完全に凌駕

モデル概要

近年、MoE(Mixture of Experts)アーキテクチャに基づく大規模モデル学習は、人工知能分野における重要な研究方向となっている。Qwenチームは最近、20兆トークンを超える事前学習データと洗練された事後学習スキームを採用したQwen2.5-Maxモデルをリリースし、MoEアーキテクチャのスケールアップ応用におけるブレークスルーを実現した。進展があった。このモデルは現在APIインターフェースもしかしたらQwenチャット体験のためのプラットフォーム。

技術的特徴

1.モデル・アーキテクチャの革新

- ハイブリッド・エキスパート・システムによる最適化動的ルーティングメカニズムによる計算機資源の効率的配分

- マルチモーダルな拡張性テキスト、構造化データなど、複数のタイプの入出力をサポート。

- 文脈の強化最大入力:30,720トークン、最大8,192トークンまでの連続テキストを生成可能。

2.コア機能マトリックス

| 機能次元 | テクニカル指標 |

|---|---|

| 多言語サポート | 29言語をカバー(中国語/英語/フランス語/スペイン語など) |

| 計算能力 | 複雑な数学演算とコード生成 |

| 構造化処理 | JSON/表データの生成と解析 |

| 文脈理解 | 8Kトークンの長いテキスト連結生成 |

| アプリケーション適合性 | 対話システム/データ分析/知識ベース推論 |

パフォーマンス評価

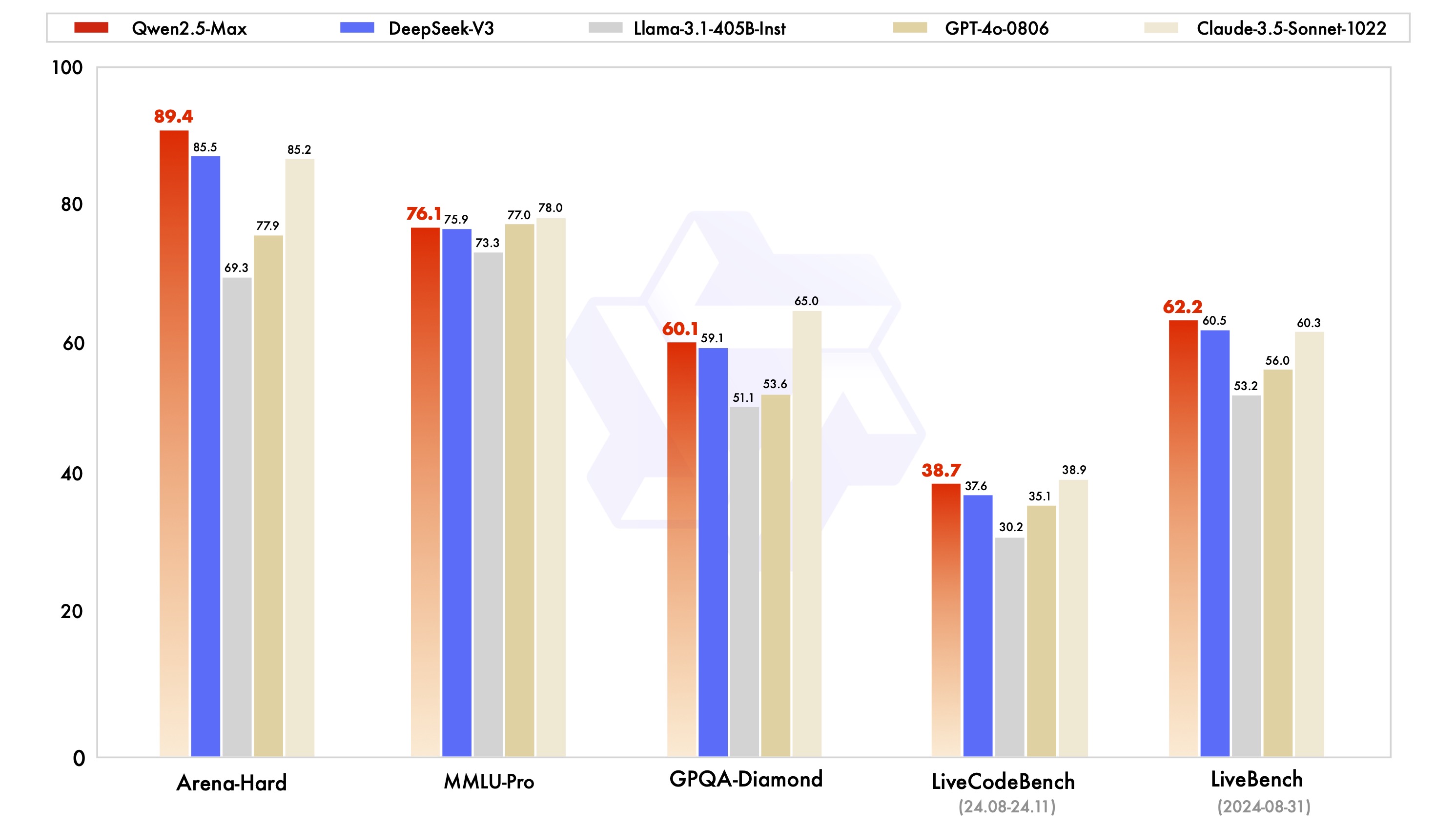

コマンドモデルの比較

Qwen2.5-Maxは、MMLU-Pro(大学知識テスト)、LiveCodeBench(プログラミング能力評価)、Arena-Hard(人間嗜好シミュレーション)などのベンチマークテストで大きな競争力を示しています:

テストデータによると、このモデルはプログラミング能力(LiveCodeBench)と統合推論(LiveBench)の次元でDeepSeek V3を上回り、GPQA-Diamond高次推論テストではトップレベルに達している。

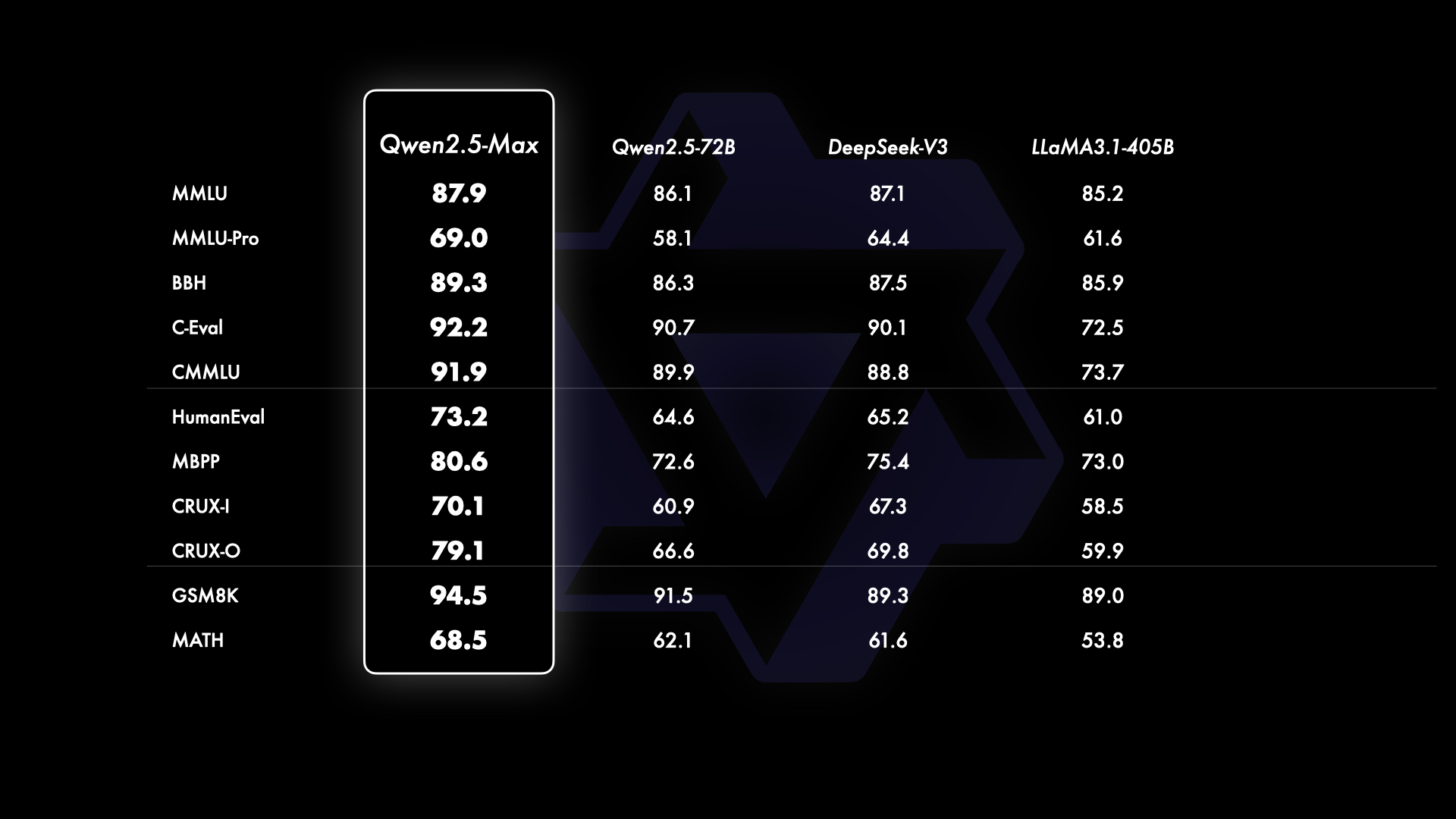

ベースモデルの比較

主流のオープンソースモデルと比較して、Qwen2.5-Maxは基本的な機能のレベルで技術的な優位性を示している:

405B のパラメータを持つ Llama-3.1 と 720B のパラメータを持つ Qwen2.5-72B を比較すると、Qwen2.5-Max はほとんどのテスト項目でリードを維持し、モデルスケーリングにおける MoE アーキテクチャーの有効性を検証しています。

アクセスと利用

1.クラウドAPIアクセス

from openai import OpenAI

import os

client = OpenAI(

api_key=os.getenv("API_KEY"),

base_url="https://dashscale.aliyuncs.com/compatible-mode/v1",

)

response = client.chat.completions.create(

model="qwen-max-2025-01-25",

messages=[

{'role':'system', 'content':'设定AI助手角色'},

{'role':'user', 'content':'输入查询内容'}

]

)

2.インタラクティブな体験

- インタビューハギング・フェイス・デモ・スペース

- モデルをロードするためにRunボタンを起動する

- テキスト入力ボックスによるリアルタイム・インタラクション

3.エンタープライズ展開

- 在籍アリユン・アカウント

- 大型モデル・サービス・プラットフォームの立ち上げ

- システム統合のためのAPIキーの作成

技術進化の方向性

現在のバージョンは、以下の分野で継続的に最適化されている:

- 研修後のデータ品質改善戦略

- 効率最適化のための複数の専門家によるコラボレーション

- 低リソース消費推論アクセラレーション

- マルチモーダル拡張インターフェース開発

将来展望

データ規模とモデルパラメータ規模を継続的に改善することで、モデルの知能レベルを効果的に向上させることができる。今後は、事前学習のスケーリングに加え、強化学習のスケーリングにも精力的に投資し、人間を超える知能を実現し、AIを未知の領域へと導いていきたいと考えています。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません

![[转]Deepseek R1可能找到了超越人类的办法](https://aisharenet.com/wp-content/uploads/2025/01/5caa5299382e647.jpg)