Qwen2.5-Coderフルシリーズ:パワフル、多機能、実用的。

簡単

今日、私たちは、パワフルで多様かつ有用なQwen2.5-Coderファミリーをオープンソース化できることを嬉しく思います。

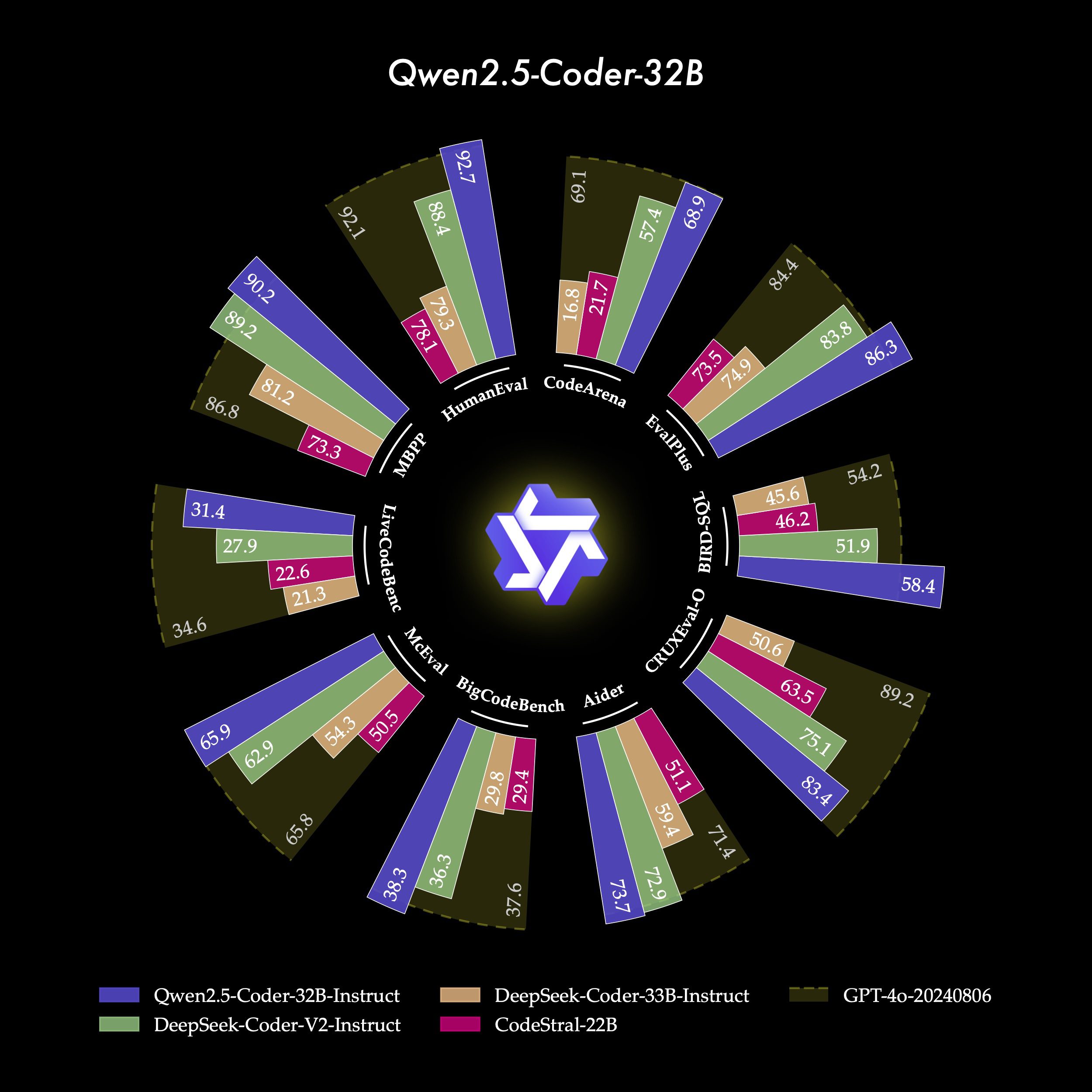

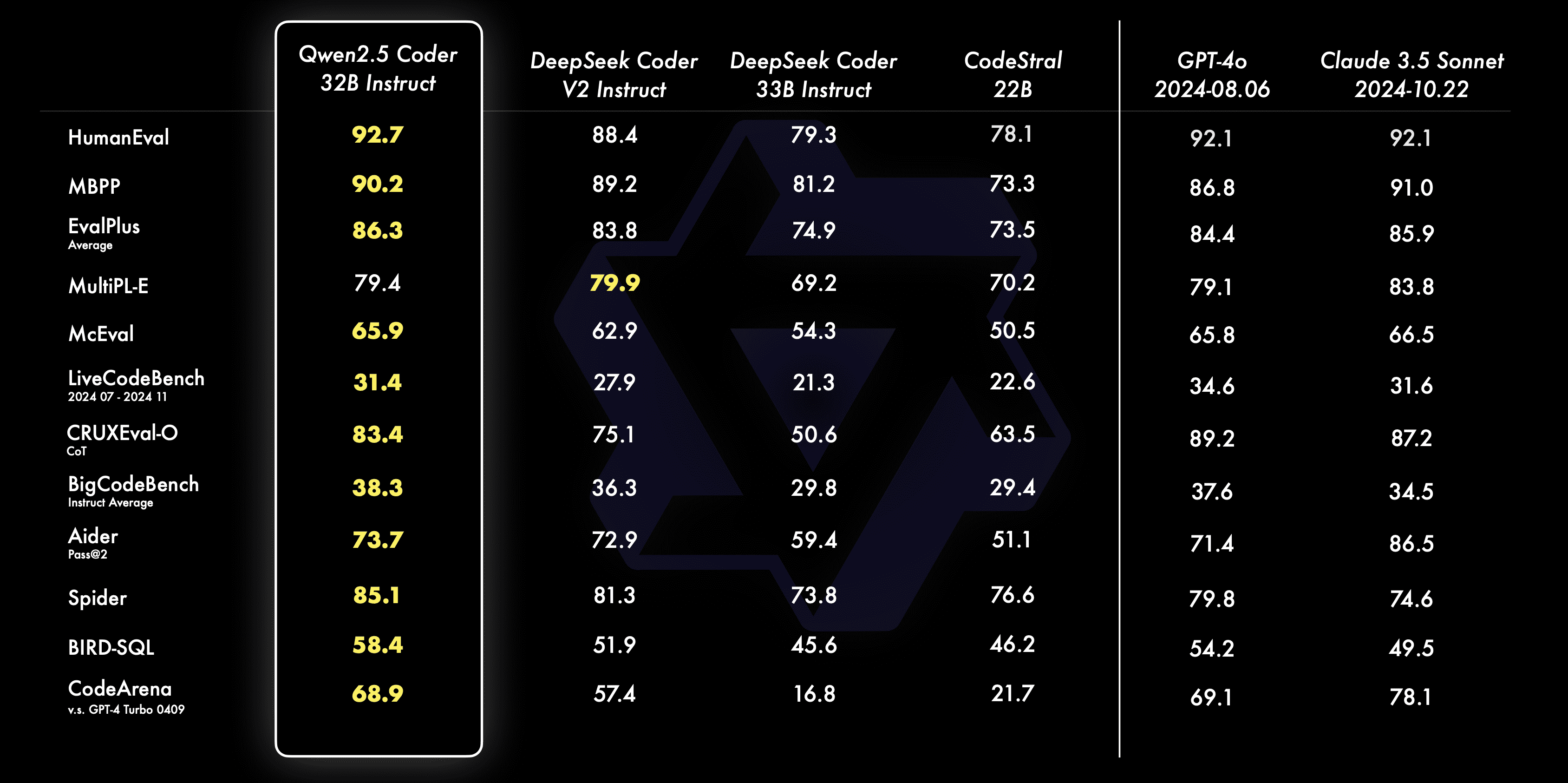

- 恐るべきQwen2.5-Coder-32B-Instructは、SOTAの現在のオープンソースモデルとなり、GPT-4oに匹敵するコード能力を持ち、強力で包括的なコード能力だけでなく、優れた汎用能力と数学能力を示しています。

- マニホールドQwen2.5-Coderは、さまざまな開発者のニーズに応えるため、主流の6つのモデルサイズをカバーしている。先月は1.5Bと7Bのサイズをオープンソース化し、今回は0.5B、3B、14B、32Bのサイズをオープンソース化した。

- 実際的Qwen2.5-Coderの有用性を、Code AssistantとArtifactsの両シナリオで探求し、いくつかのサンプルを使って、実世界のシナリオにおけるQwen2.5-Coderの可能性を実証する。

強力:オープンソースモデルSOTAまでのコード機能

- コード生成このオープンソースのフラッグシップモデルであるQwen2.5-Coder-32B-Instructは、複数の一般的なコード生成ベンチマーク(EvalPlus、LiveCodeBench、BigCodeBenchなど)において、オープンソースモデルの中で最高の性能を達成しており、GPT-4oと競合する性能に達しています。

- コード修正Qwen2.5-Coder-32B-Instructは、ユーザーがコードのエラーを修正し、プログラミングをより効率的にするのに役立ちます。Aiderはコード修正のベンチマークとして人気があり、Qwen2.5-Coder-32B-InstructはAiderでGPTに匹敵する73.7のスコアを達成しています。-4o.

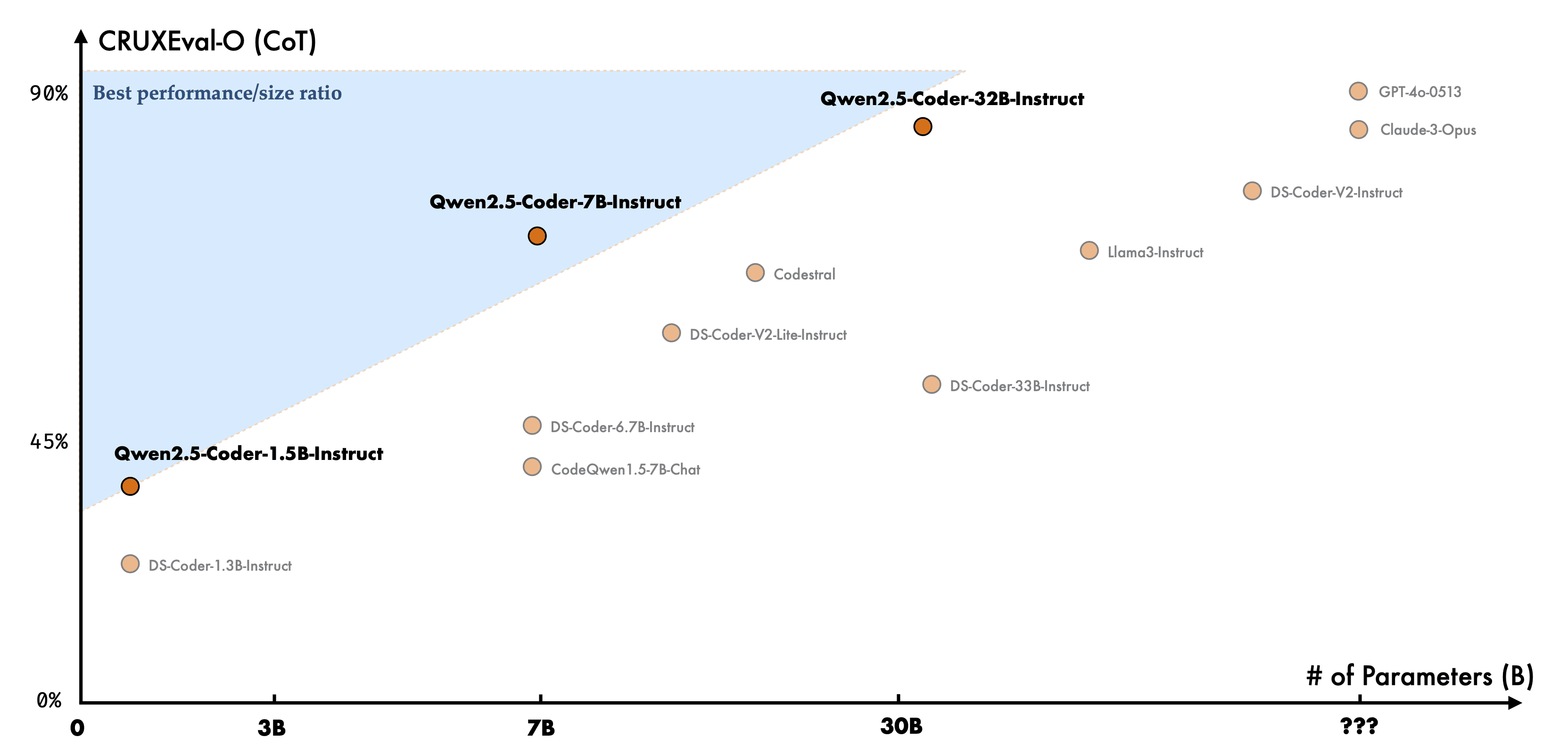

- コード化された推論コード推論とは、コードが実行される過程を学習し、モデルの入力と出力を正確に予測するモデルの能力を指す。先月リリースされたQwen2.5-Coder-7B-Instructは、すでにコード推論能力において優れたパフォーマンスを示しているが、32Bモデルはさらにその上を行く。

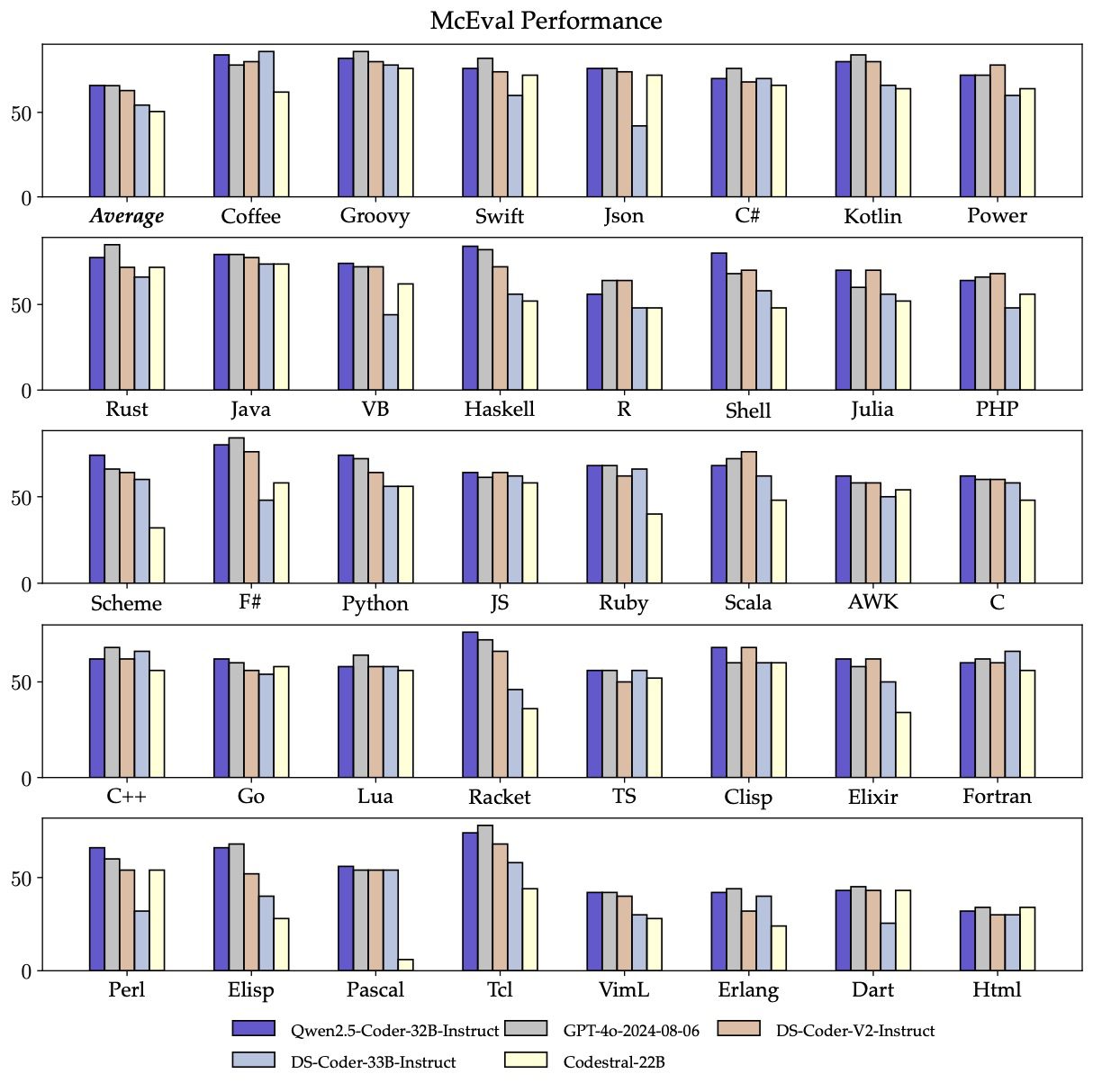

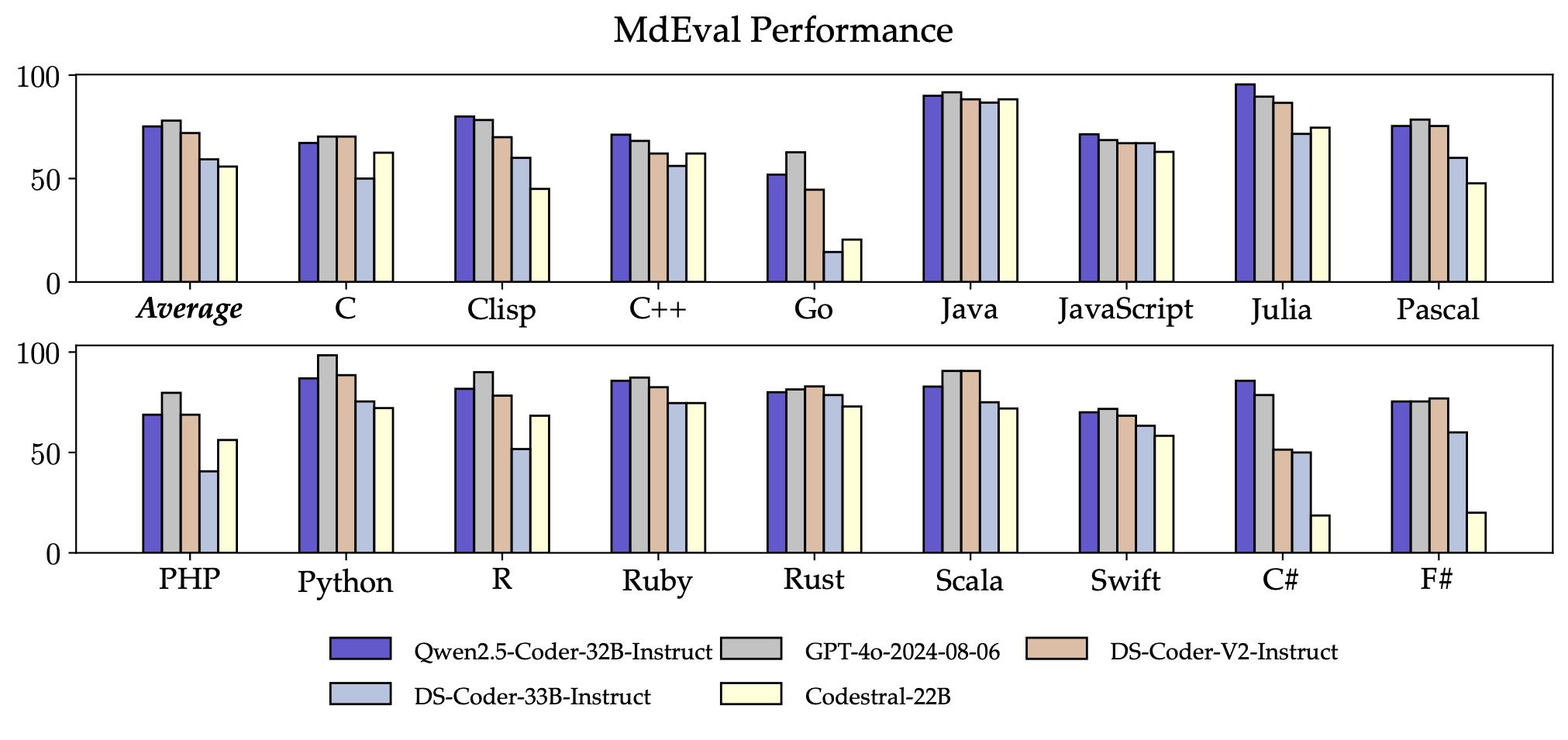

- マルチリンガルQwen2.5-Coder-32B-Instructは、事前学習段階での独自のデータクレンジングと配分のおかげで、Haskell、Racketなどで素晴らしいパフォーマンスを発揮し、McEvalで65.9を達成しました。

さらに、Qwen2.5-Coder-32B-Instructのマルチプログラミング言語コード修正機能も驚くべきもので、ユーザーが慣れ親しんだプログラミング言語を理解し、修正するのに役立ち、馴染みのない言語の学習コストを大幅に軽減します。

McEvalと同様に、MdEvalはマルチプログラミング言語のコード修正ベンチマークであり、Qwen2.5-Coder-32B-InstructはMdEvalで75.2のスコアを達成し、これはすべてのオープンソースモデルの中でトップのスコアである。

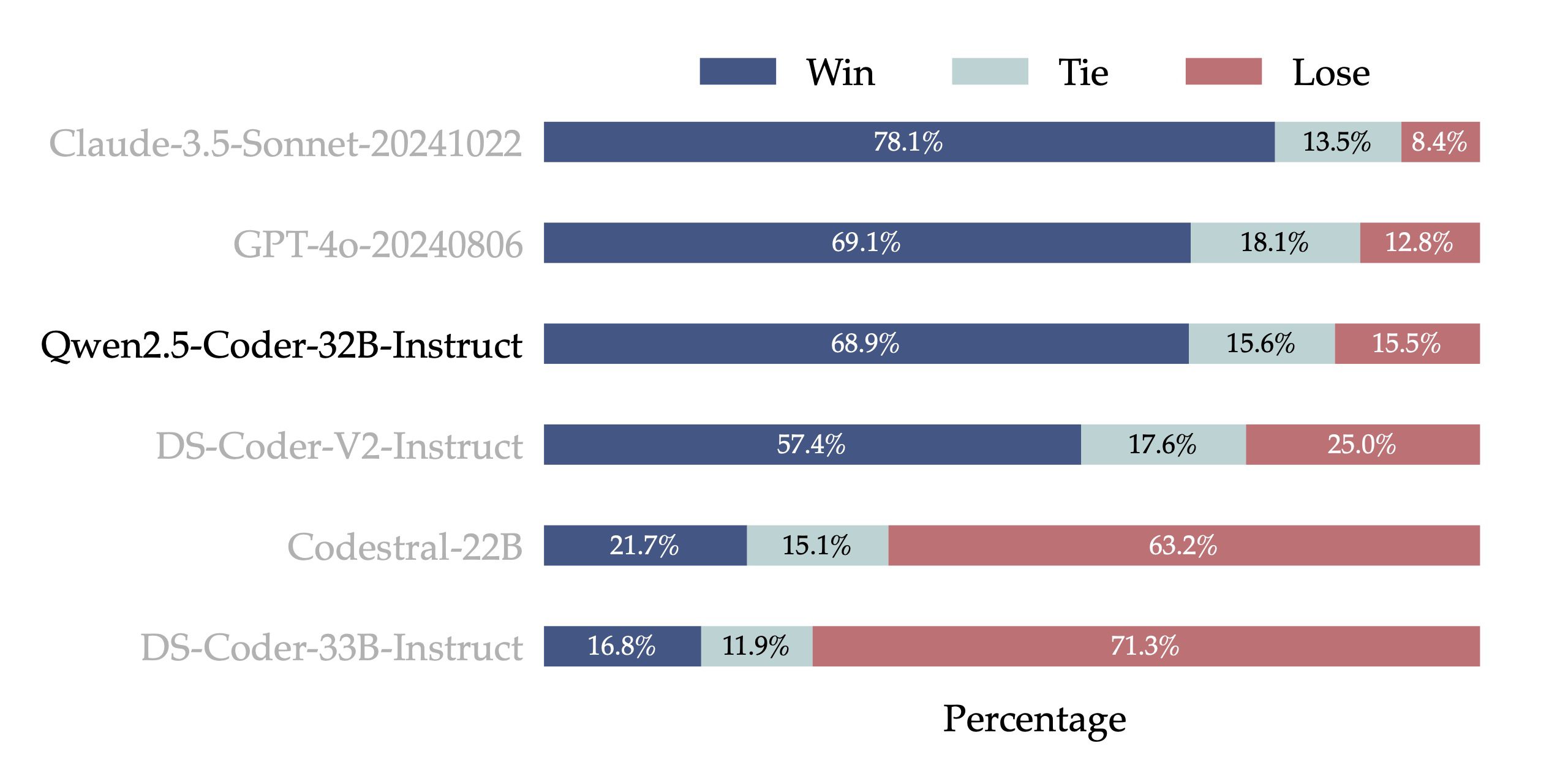

- 人間の嗜好アライメントQwen2.5-Coder-32B-Instructの人間の嗜好に対するアライメント性能をテストするために、内部アノテーションからコード嗜好評価ベンチマークであるCode Arena(Arena Hardに類似)を構築した。嗜好アライメントの評価モデルとしてGPT-4oを使用し、「A対Bの勝敗」、すなわち、テストセットのインスタンスにおいて、モデルAのスコアがモデルBのスコアを上回った割合を評価する。下図の結果は、プリファレンス・アライメントにおけるQwen2.5-Coder-32B-Instructの優位性を示しています。

汎用性:豊富なモデルサイズ

Qwen2.5-Coderオープンソースモデルファミリーは、0.5B、1.5B、3B、7B、14B、32Bの6つのサイズで構成されており、さまざまなリソースシナリオにおける開発者のニーズを満たすだけでなく、研究コミュニティにも良い実験場を提供しています。次の表は、詳細なモデル情報を示している:

| モデル | パラメータ | 非エンブ・パラム | レイヤー | ヘッド(KV) | ネクタイの埋め込み | コンテキストの長さ | ライセンス |

|---|---|---|---|---|---|---|---|

| Qwen2.5-コーダー-0.5B | 0.49B | 0.36B | 24 | 14 / 2 | はい | 32K | アパッチ2.0 |

| Qwen2.5-コーダー-1.5B | 1.54B | 1.31B | 28 | 12 / 2 | はい | 32K | アパッチ2.0 |

| Qwen2.5-コーダー-3B | 3.09B | 2.77B | 36 | 16 / 2 | はい | 32K | クウェン・リサーチ |

| Qwen2.5-コーダー-7B | 7.61B | 6.53B | 28 | 28 / 4 | いいえ | 128K | アパッチ2.0 |

| Qwen2.5-コーダー-14B | 14.7B | 13.1B | 48 | 40 / 8 | いいえ | 128K | アパッチ2.0 |

| Qwen2.5-Coder-32B | 32.5B | 31.0B | 64 | 40 / 8 | いいえ | 128K | アパッチ2.0 |

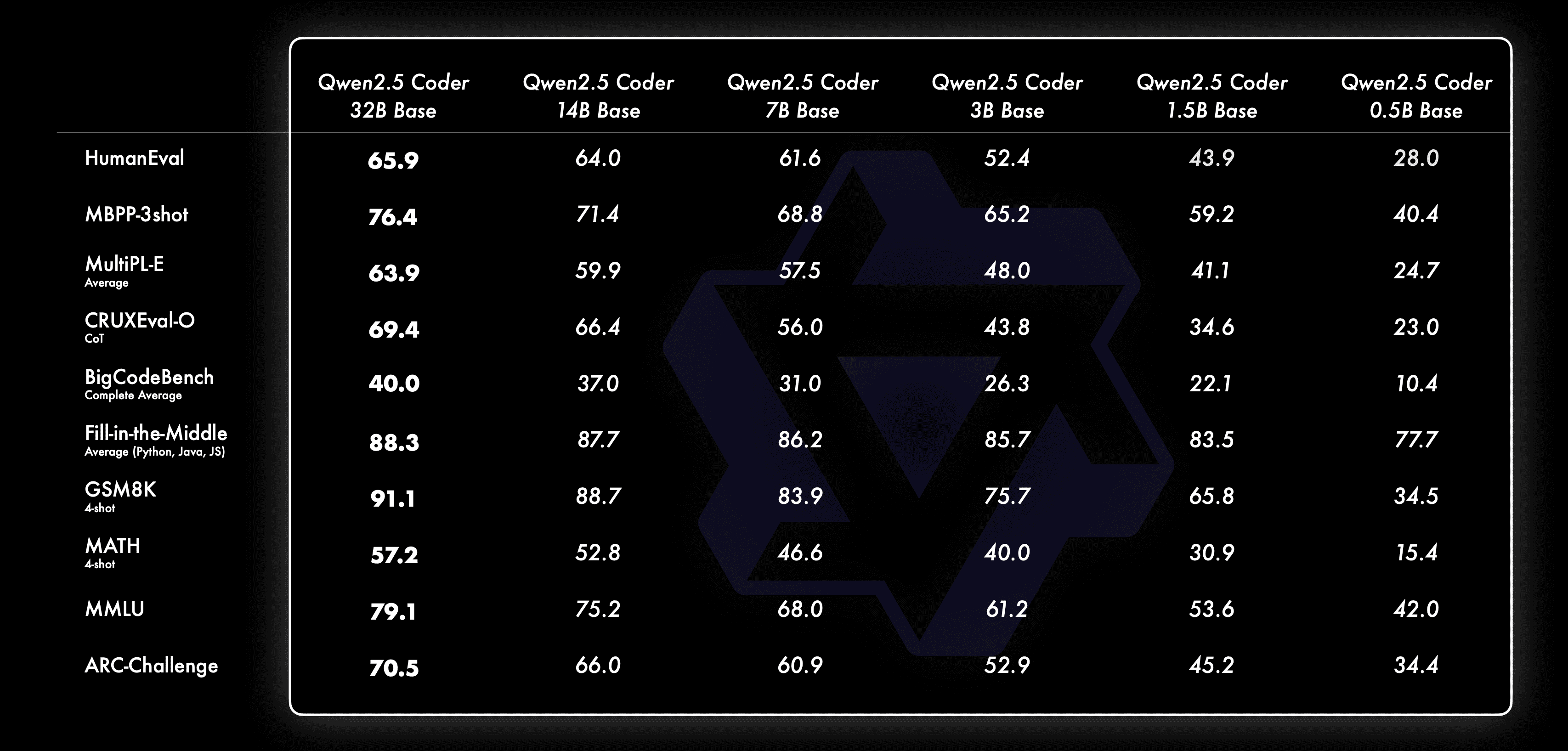

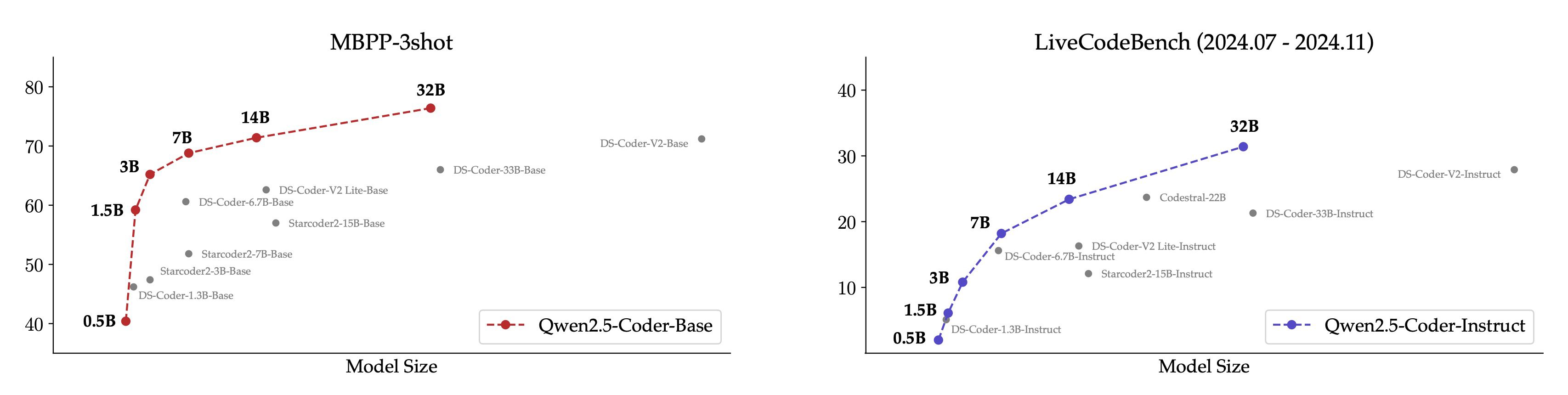

我々は常に信じてきた スケーリングの法則 哲学Scaling on Code LLM の有効性を検証するため、サイズの異なる Qwen2.5-Coder モデルの性能を全てのデータセットで評価した。

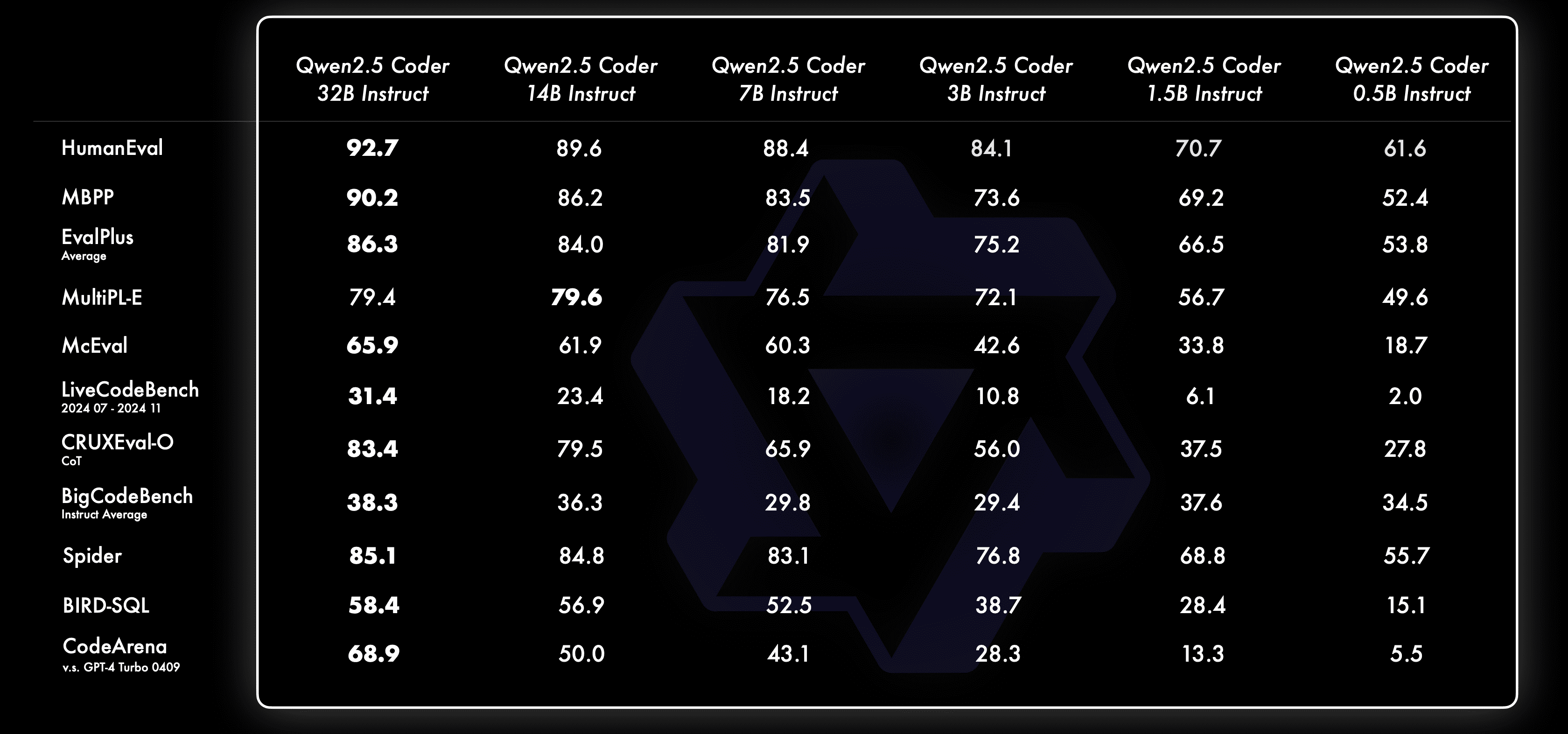

それぞれのサイズについて、私たちはBaseモデルとInstructモデルをオープンソース化しており、Baseモデルは開発者がモデルを微調整するためのベースとして機能し、Instructモデルは直接チャットが可能な公式のアライメントモデルである。

ベースモデルのサイズ別の挙動は以下の通り:

インストラクター・モデルのサイズ別の挙動は以下の通り:

より直感的に理解できるように、コアデータセット上で、Qwen2.5-Coderモデルと他のオープンソースモデルの異なるサイズの比較を示します。

- MBPP-3shotはベースモデルの評価に適しており、モデルの実際の効果とよく相関することが、我々の広範な実験によって示されています。

- Instructモデルの評価には、過去4ヶ月間(2024.07~2024.11)のLiveCodeBenchトピックを選びました。

Qwen2.5-CoderがすべてのサイズにおいてSOTA性能を達成したという事実は、より大きなCoderモデルの探求を続けることを奨励している。

実践:カーソルとアーティファクトの出会い

実用的なコーダーは、常に私たちのビジョンです。そのために、コードアシスタントとアーティファクトの文脈で、Qwen2.5-Coder モデルの実用的な応用を探求してきました。

Qwen2.5-Coder 🤝 カーソル

Qwen2.5-Coderの登場により、開発者にフレンドリーで強力な代替手段を提供できることを期待しています。

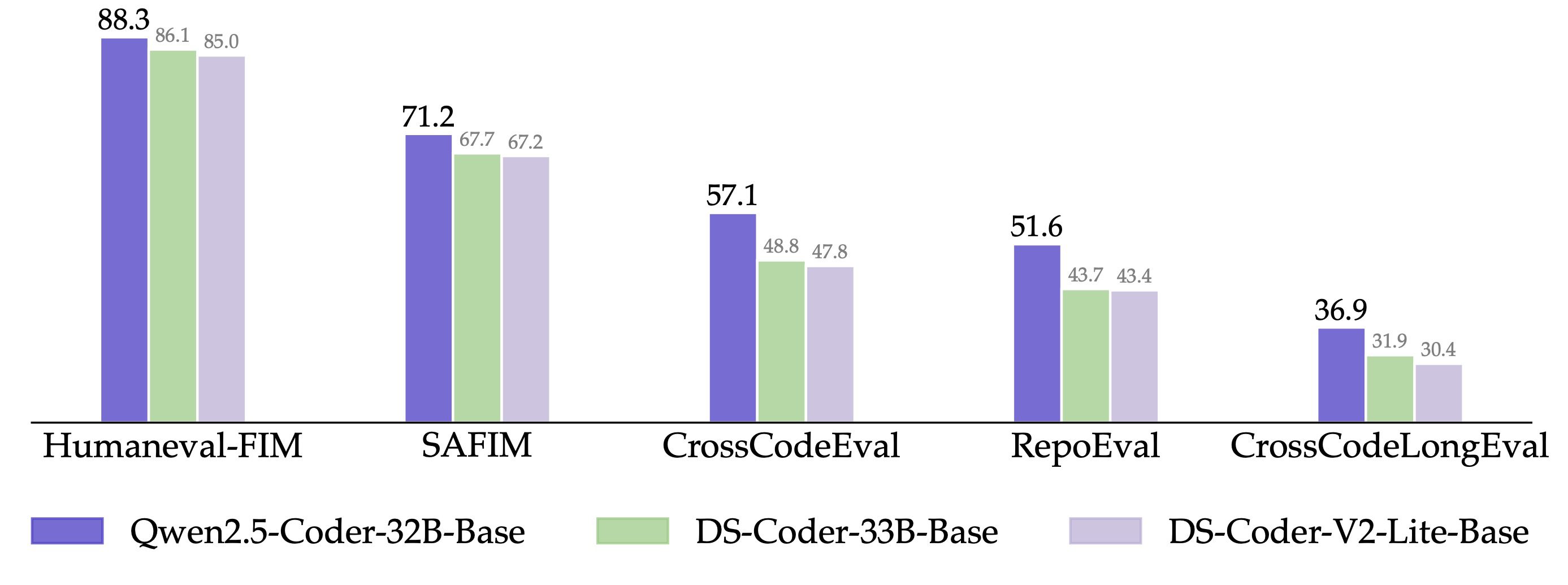

さらに、Qwen2.5-Coder-32Bは、事前訓練されたモデルで強力なコード補完能力を発揮し、Humanval-Infilling、CrossCodeEval、CrossCodeLongEval、RepoEval、SAFIMの5つの評価セットでSOTA性能を達成しました。

公正な比較を維持するため、最大配列長を8kに制御し、テストにはFill-in-the-Middleモードを使用する。CrossCodeEval、CrossCodeLongEval、RepoEval、Humaneval-Infillingの4つのレビューセットでは、生成されたコンテンツが実際のラベルと完全に一致するかどうかを評価した(Exact Match)。評価を行った。

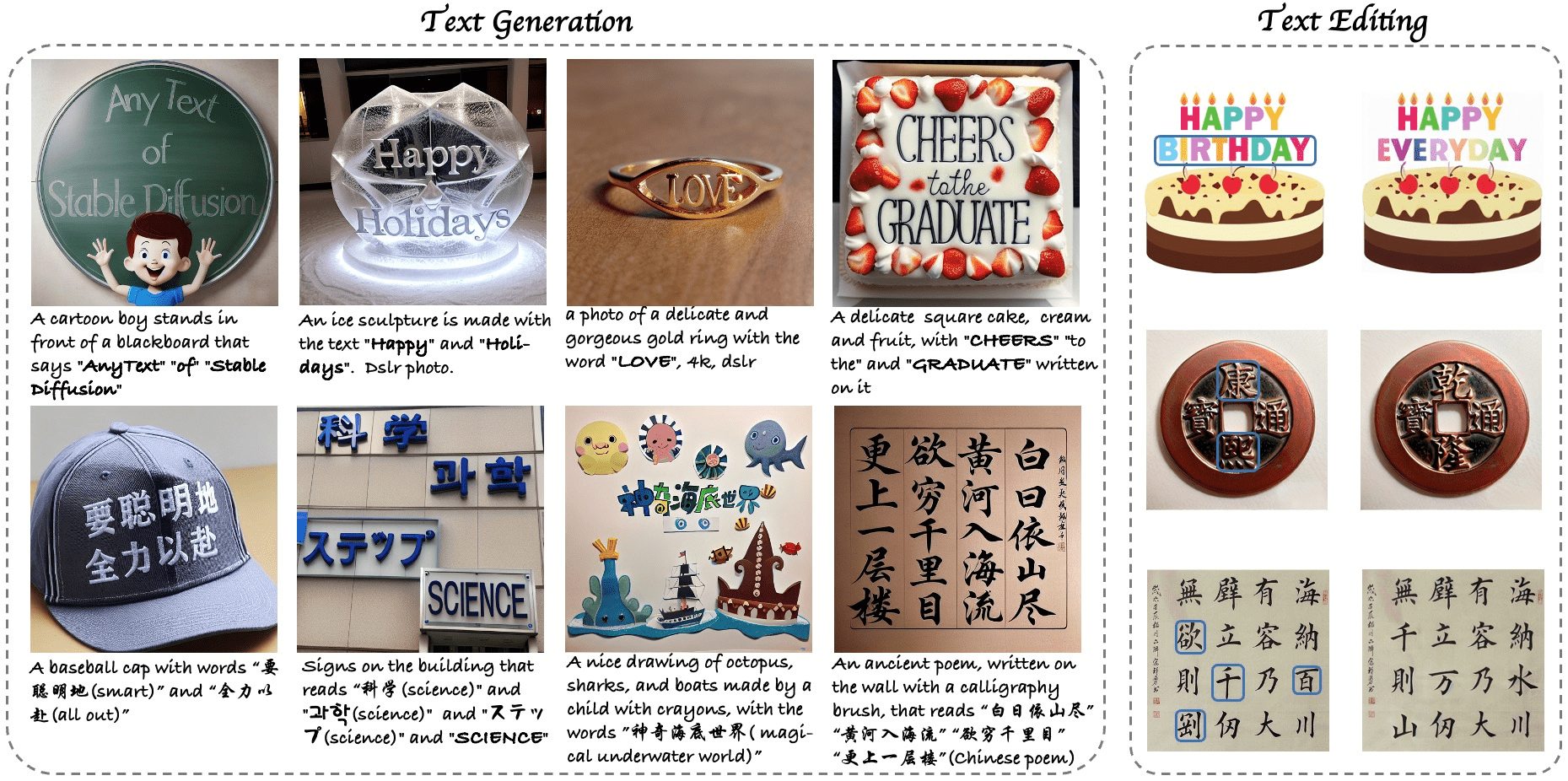

Qwen2.5-コーダー 🤝 人工物

Artifactsはコード生成のための最も重要なアプリケーションの1つで、ユーザーが視覚化に適したものを作成するのに役立ちます。 WebUIを開く Qwen2.5-Coderの可能性をArtifactsのシナリオで探る、具体例をご紹介します:

Tongyiの公式サイトhttps://tongyi.aliyun.com、コードモードがまもなくオンラインになります。このモードでは、ワンセンテンスで生成されたウェブサイト、ミニゲーム、データチャートなど、あらゆる種類のビジュアライゼーション・アプリケーションをサポートします。ぜひ体験してください!

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません