Pyramid Flow:Racerが発表した "Kringle "のオープンソース版で、SD3をベースとし、8GB未満のGPUで動作する(ワンクリックデプロイメント版)。

はじめに

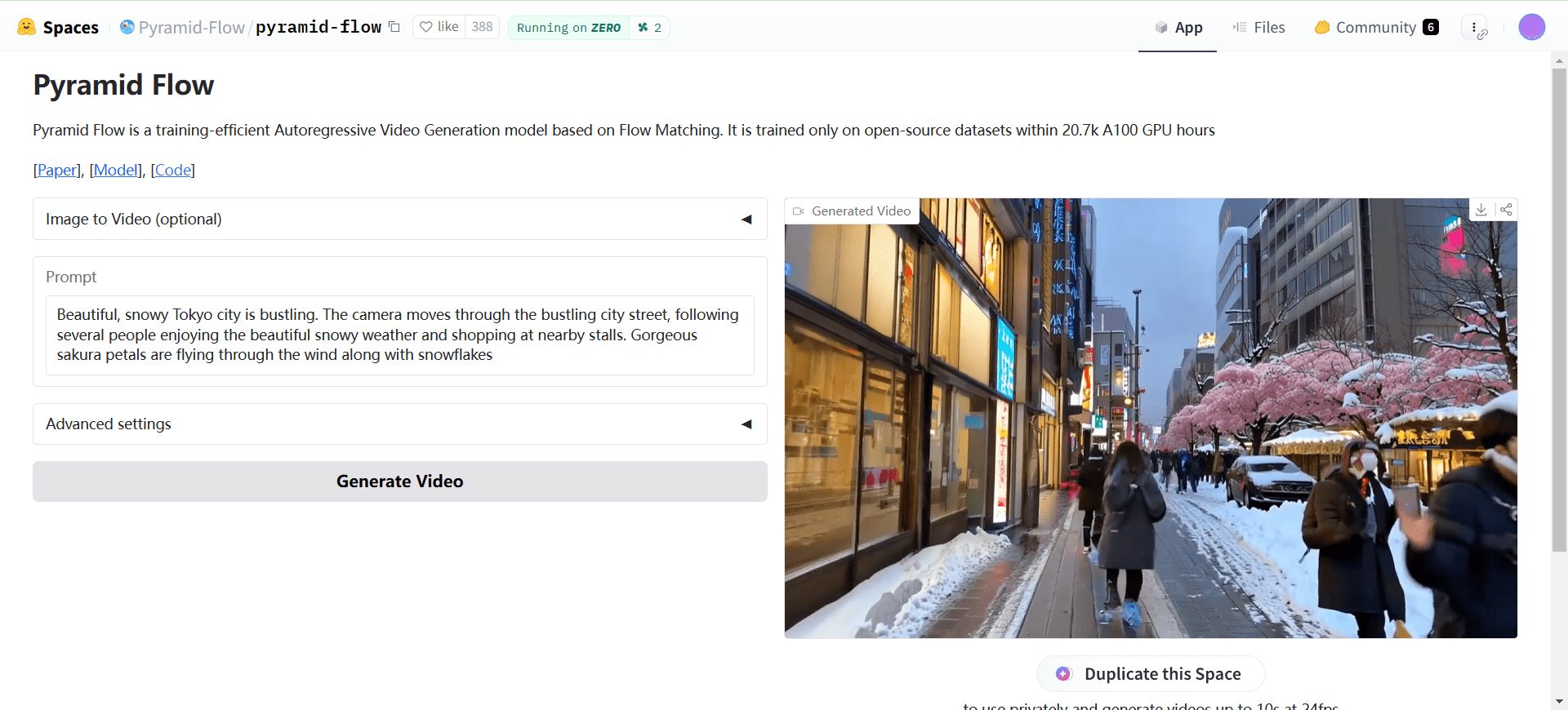

Pyramid Flowは、Flow Matching技術に基づく効率的な自己回帰型ビデオ生成手法である。Pyramid Flowは、768p解像度、24FPSで高品質の10秒ビデオを生成することができ、画像からビデオへの生成をサポートしています。フレームワーク全体は、20.7k A100 GPUトレーニング時間で学習された単一のDiTモデルを使用して、エンドツーエンドで最適化されています。

オンライン経験:https://huggingface.co/spaces/Pyramid-Flow/pyramid-flow

機能一覧

- 効率的なビデオ生成解像度768p、24FPSの高画質10秒ビデオを生成します。

- 画像からビデオへの変換画像からのビデオ生成をサポート。

- マルチレゾリューション対応モデルのチェックポイントは768pと384pの解像度があります。

- CPUオフロードGPUのメモリ使用量を減らすために、2種類のCPUオフロードがサポートされています。

- マルチGPUサポートマルチGPU推論スクリプトを提供し、GPUごとのメモリを節約するためのシーケンス並列性をサポートします。

ヘルプの使用

環境設定

- condaを使って環境を作る:

cd Pyramid-Flow conda create --name pyramid-flow python=3.8.10 conda activate pyramid-flow - 依存関係をインストールします:

pip install -r requirements.txt

モデルのダウンロードと読み込み

- Huggingfaceからモデルのチェックポイントをダウンロードする:

# 下载 768p 和 384p 模型检查点 - ローディングモデル:

model_dtype, torch_dtype = 'bf16', torch.bfloat16 model = PyramidDiTForVideoGeneration( 'PATH', # 下载的检查点目录 model_dtype, model_variant='diffusion_transformer_768p', # 或 'diffusion_transformer_384p' ) model.vae.enable_tiling() model.enable_sequential_cpu_offload()

テキストからビデオへ

- 生成パラメーターを設定し、ビデオを生成する:

frames = model.generate( prompt="你的文本提示", num_inference_steps=[20, 20, 20], video_num_inference_steps=[10, 10, 10], height=768, width=1280, temp=16, # temp=16: 5s, temp=31: 10s guidance_scale=9.0, # 384p 设为 7 video_guidance_scale=5.0, output_type="pil", save_memory=True, ) export_to_video(frames, "./text_to_video_sample.mp4", fps=24)

画像からビデオへの変換

- 生成パラメーターを設定し、ビデオを生成する:

prompt = "FPV flying over the Great Wall" with torch.no_grad(), torch.cuda.amp.autocast(enabled=True, dtype=torch_dtype): frames = model.generate_i2v( prompt=prompt, input_image=image, num_inference_steps=[10, 10, 10], temp=16, video_guidance_scale=4.0, output_type="pil", save_memory=True, ) export_to_video(frames, "./image_to_video_sample.mp4", fps=24)

マルチGPU推論

- 複数のGPUを使った推論:

# 在 2 个或 4 个 GPU 上运行推理脚本

ニウ・ワン・クリック・デプロイメント版

起動ファイルの復号コードはダウンロードアドレスに記載されている。起動後にモデルのダウンロードが中断されることが多い場合は、公式ドキュメントを確認し、30G程度のモデルファイルを別途ダウンロードしてください。

ファイル解凍パスワード: niugee.com

Netflix経由で共有されるファイル: PyramidFlow-Niu Deployment-Free Local One-Click Package

リンク: https://pan.baidu.com/s/1yV4wafDkquBNwG8bS0zjDg?pwd=p5fw 抽出コード: p5fw (新バージョン1.1)

グーグル・ドライブ

https://drive.google.com/drive/u/1/folders/1SIvP6qP2Z4CRHpbsfXawl3tksv5ZBRGo (新バージョン1.1)

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません