Portkey:複数のAIモデルを接続し、アプリケーションを管理するための開発ツール

はじめに

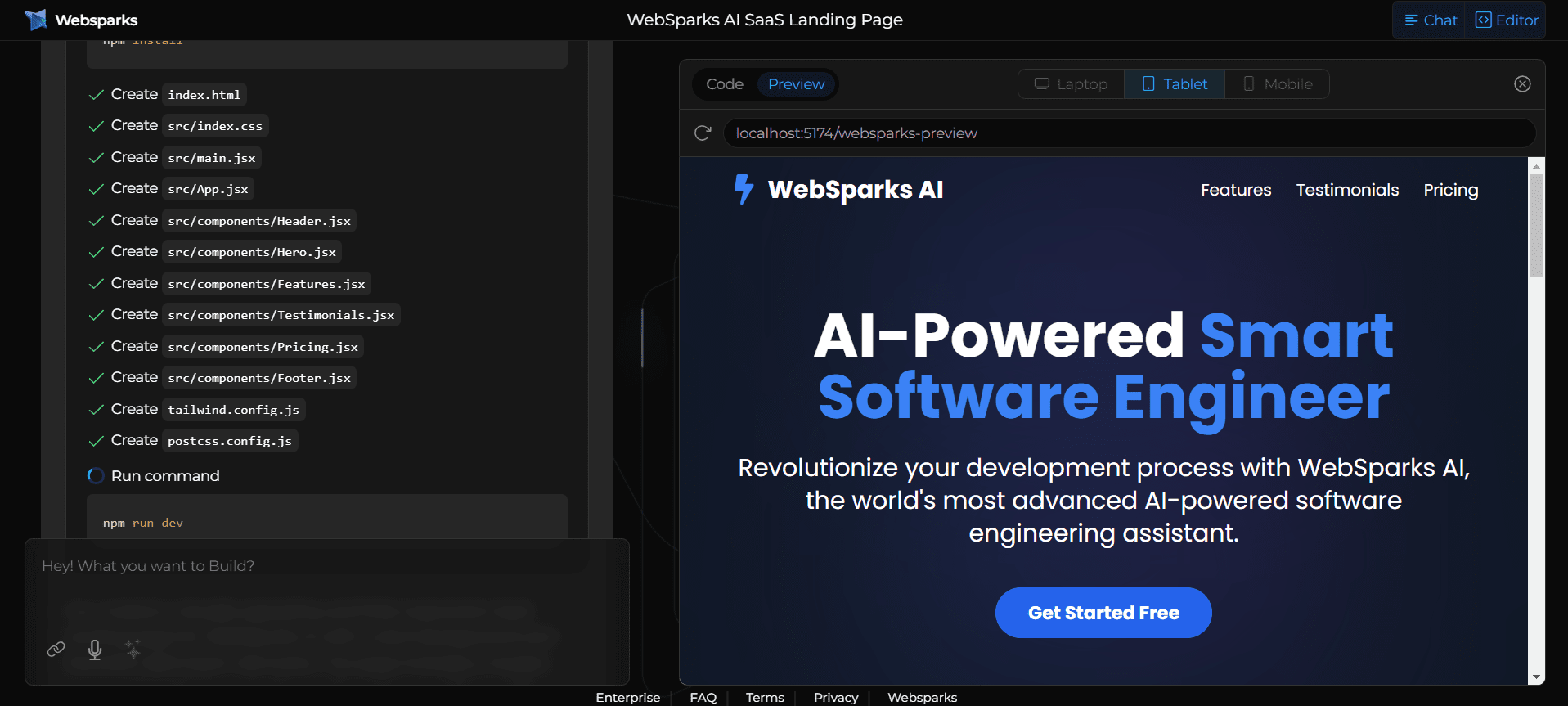

Portkeyは、企業や開発者がAIアプリケーションを迅速に構築、管理、最適化できるよう支援するプラットフォームです。統合AIゲートウェイを通じて200以上の大規模言語モデル(LLM)を接続し、プロンプト管理、負荷分散、リアルタイム監視などの機能を提供する。portkeyは、AI機能を迅速に開発する必要がある小規模チームから、複雑なコンプライアンスや高いパフォーマンスが要求される大規模組織にも適している。オープンソースであり、開発者は無料で導入することも、有料のエンタープライズサービスを選択することもできる。このサイトはクリーンなインターフェースと強力な機能を備えており、技術チームに人気がある。

機能一覧

- AIゲートウェイ250以上の大きな言語モデルを接続し、統一されたAPIインターフェイスを提供し、モデルの呼び出しを簡素化します。

- キュー・マネジメント開発効率を向上させるために、AIヒントを作成、テスト、バージョン管理するためのチームワークをサポートします。

- ロードバランシングと自動切り替え複数のモデルに自動的にリクエストを割り当て、障害が発生した場合は代替モデルを切り替えます。

- リアルタイム・モニタリングAIアプリケーションの運用状況を追跡するための40以上のパフォーマンス・メトリクスを提供。

- スマートキャッシュクエリーを繰り返す際のレスポンスを高速化し、コストを削減します。

- 安全保護データのセキュリティとコンプライアンスを保証するために、入力と出力の検証をサポートします。

- マルチモーダルサポート画像や音声などのマルチモーダルモデルに対応し、応用シーンを拡大。

- オープンソース展開開発者は無料でコア機能を使用できます。

ヘルプの使用

Portkeyはとても使いやすく、開発者もビジネスユーザーもすぐに使い始めることができます。ここでは、その機能を最大限に活用するための詳細なハウツーガイドをご紹介します。

インストールと設定

Portkeyには、クラウドホスティングサービスとローカルデプロイの2つの利用方法があります。以下はその具体的な手順です:

クラウド・ホスティング・サービス

- アカウント登録

https://portkey.ai/ を開き、右上の「登録」ボタンをクリックします。メールアドレスとパスワードを入力して登録を完了します。登録後、認証メールが届きますので、リンクをクリックしてアカウントを有効にしてください。 - APIキーの取得

ログインしたら、ダッシュボードに移動し、「APIキー」オプションをクリックします。Generate "をクリックしてAPIキーを生成し、コピーして保存します。このキーが、Portkeyサービスを呼び出すための主な認証情報となります。 - 統合コード

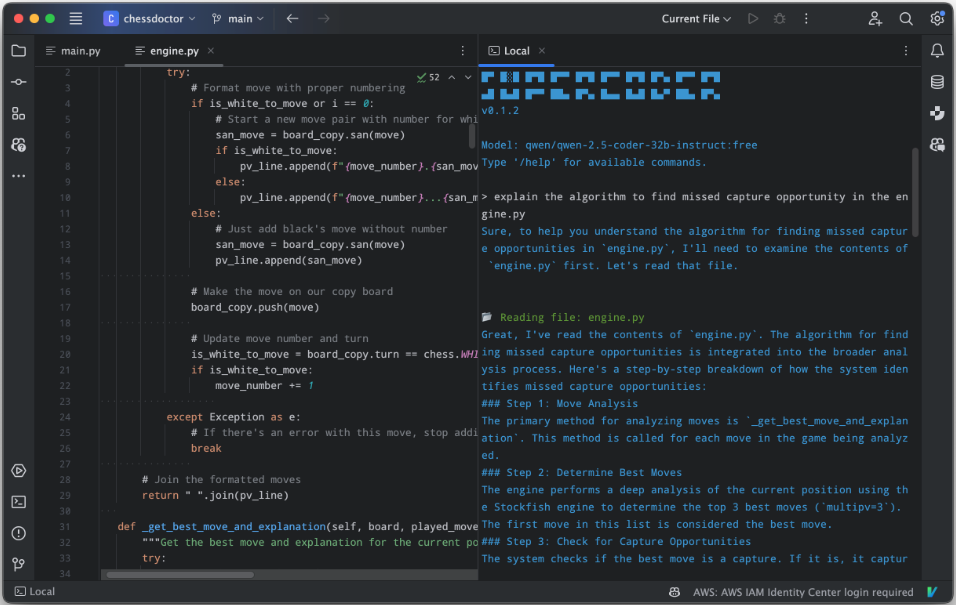

PortkeyはPythonやJavaScriptなど様々なプログラミング言語と互換性があり、Pythonの場合は数行のコードで使い始めることができます:from portkey_ai import Portkey client = Portkey(api_key="你的API密钥") response = client.chat.completions.create( messages=[{"role": "user", "content": "你好,今天天气如何?"}], model="gpt-4o-mini" ) print(response)

あなたのAPIキー」を先ほどコピーしたものに置き換えて、AIモデルを呼び出すコードを実行する。

ローカル展開(オープンソース版)

- Node.jsのインストール

お使いのコンピューターにNode.js(推奨バージョン16以上)がインストールされていることを確認してください。Node.jsのウェブサイトからダウンロードしてインストールできます。 - コマンド実行

ターミナルを開き、以下のコマンドを入力すると、ワンクリックでPortkey Gatewayが展開されます:npx @portkey-ai/gatewayデプロイに成功すると、ゲートウェイはデフォルトで

http://localhost:8787/public/. - 構成モデル

ローカルゲートウェイコンソールで、モデルプロバイダAPIキー(例えばOpenAIのsk-xxx)、設定を保存します。その後、ローカル・ゲートウェイを通してモデルを呼び出すことができます。

主な機能

AIゲートウェイの利用

- コネクティビティモデルPortkeyのダッシュボードにログインし、"Gateway "ページに移動します。使用したいモデル(OpenAI、Anthropicなど)を選択し、対応するAPIキーを入力し、"Save "をクリックします。その後、全てのリクエストはPortkey経由でルーティングされます。

- 負荷分散ポートキーが自動的にリクエストを割り当て、最適なパフォーマンスを確保します。

- 自動切り替え予備モデルを追加するには、"Fallbacks "を有効にします。プライマリモデルが故障した場合、システムは自動的にフォールバックモデルに切り替わります。

キュー・マネジメント

- ヒントを作成するプロンプト」ページを開き、「新規プロンプト」をクリックします。You are an assistant who helps users with their questions "のようなプロンプトを入力し、保存します。

- テストのヒント右側のテストエリアにユーザーメッセージを入力し、"Run "をクリックするとモデル出力が表示されます。納得がいくまでプロンプトを調整してください。

- バージョン管理各修正プロンプトが表示されたら、"Save as New Version "をクリックしてください。バージョン履歴の切り替えやロールバックができます。

- チームワーク共有」をクリックすると、チームメンバーを招待するためのリンクが作成されます。

リアルタイム・モニタリング

- ログを見るログ "ページでは、各リクエストの入力、出力、経過時間をリアルタイムで見ることができます。何か問題が発生した場合は、エラーの詳細を直接見ることができます。

- パフォーマンス分析アナリティクスでリクエスト、レイテンシー、コストなどの指標を確認できます。日、週、月によるデータのフィルタリングをサポート。

注目の機能操作

スマートキャッシュ

- キャッシュ "設定で "セマンティックキャッシュ "を有効にする。クエリを繰り返す際に、システムはキャッシュされた結果を直接返すので、時間とコストを節約できます。

- 例:ユーザーが「今日の天気はどうですか」と何度も質問した場合、2回目以降のレスポンスは速くなる。

マルチモーダルサポート

- マルチモーダルモデルを呼び出す場合は、コード内でモデル名(例えば画像対応モデル)を指定し、ファイルをアップロードするだけです:

response = client.chat.completions.create( messages=[{"role": "user", "content": "描述这张图片", "image": "path/to/image.jpg"}], model="multimodal-model" ) - 返される結果には画像解析が含まれる。

簡単なAIチャットツールの開発でも、複雑なエンタープライズAIアプリケーションの管理でも、これらのステップで簡単にPortkeyを使い始めることができます。

アプリケーションシナリオ

- 企業向けカスタマーサービス・システム

Portkeyは複数の言語モデルを接続し、インテリジェントなカスタマーサービスを構築することができます。ロードバランシングと自動スイッチングにより、ピーク時の中断のないサービスを保証します。迅速な管理は、応答品質の最適化に役立ちます。 - コンテンツ生成ツール

ライターやマーケティングチームは、Portkeyを使ってさまざまなプロンプトをテストし、記事や広告などを生成することができます。スマートキャッシュが重複生成のコストを削減します。 - 教育アシスタント育成

開発者は、Portkeyのマルチモーダルサポートを利用して、質問に答えたり画像を分析したりする教育用アプリケーションを構築できます。小規模な教育機関であれば、ローカルへの導入も可能です。

品質保証

- Portkeyがサポートしているプログラミング言語は何ですか?

Python、JavaScript、REST APIをサポートし、OpenAI SDK、Langchain、その他一般的に使用されているライブラリと互換性があります。 - 現地への配備に費用はかかりますか?

いいえ、オープンソース版は完全に無料です。サブスクリプションが必要なのは、エンタープライズ版のクラウドサービスだけだ。 - データの安全性はどのように確保されていますか?

PortkeyはISO 27001およびSOC 2認証を取得しており、すべてのデータ送信と保存を暗号化し、プライベートクラウドの導入をサポートしています。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません