par_scrape: ウェブデータをインテリジェントに抽出するクローラーツール

はじめに

par_scrapeはPythonベースのオープンソースWebクローラーで、開発者のPaul RobelloによってGitHubで公開された。SeleniumとPlaywrightという2つの強力なブラウザ自動化技術を統合し、AI処理機能と組み合わせることで、単純な静的ページから複雑な動的ウェブサイトまでのデータクローリングをサポートする。価格、タイトル、またはその他の構造化された情報の抽出であろうと、par_scrapeはフィールドを指定することでタスクを素早く完了し、結果をMarkdown、JSON、またはCSVとして出力します。ウェブ上の情報収集を自動化したい開発者、データアナリスト、ユーザーのためのプロジェクト , インストールが簡単で柔軟な機能 , オープンソースコミュニティで人気 .

機能一覧

- インテリジェントなデータ抽出OpenAIやAnthropicのようなAIモデルを使ってウェブコンテンツを分析し、ユーザーが指定したフィールドを正確に抽出します。

- デュアルクローラサポートこのウェブサイトは、SeleniumとPlaywrightの両方の技術をサポートしており、異なるウェブサイト・アーキテクチャに適応させることができる。

- 複数の出力フォーマットキャプチャー結果は、Markdown、JSON、CSV、Excelにエクスポートでき、その後の処理が容易です。

- カスタムフィールドのキャプチャタイトル、説明、価格など、抽出するフィールドをユーザーが指定することができます。

- パラレルキャプチャマルチスレッドクローリングをサポートし、大規模なデータ収集の効率を向上。

- 待機メカニズム動的コンテンツのクロールを確実に成功させるために、さまざまなページ読み込み待機方法(一時停止、セレクタ待機など)を提供する。

- AIモデルの選択複数のAIプロバイダー(OpenAI、Anthropic、XAIなど)をサポートし、さまざまなタスクに柔軟に対応。

- キャッシュの最適化ヒントキャッシュ機能を内蔵し、繰り返しリクエストのコストを削減し、効率を向上。

ヘルプの使用

設置プロセス

par_scrapeを使用するには、まず以下のインストールステップを完了し、環境が整っていることを確認する必要があります。以下は詳細なインストールガイドです:

1.環境準備

- パイソン版Python3.11以降がインストールされていることを確認する。

python --versionチェックする。 - GitツールGitHubからコードをクローンするために使用します。

sudo apt install git(Linux)または公式ウェブサイトからダウンロードしてインストールする。 - UVツール依存関係を管理するためにUVを使用することをお勧めします:

- Linux/Mac:

curl -LsSf https://astral.sh/uv/install.sh | sh - ウィンドウズ

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

- Linux/Mac:

2.プロジェクトのクローン化

ターミナルで以下のコマンドを入力し、ローカルに par_scrape プロジェクトをクローンします:

git clone https://github.com/paulrobello/par_scrape.git

cd par_scrape

3.依存関係のインストール

プロジェクトの依存関係をインストールするにはUVを使用する:

uv sync

またはPyPIから直接インストールする:

uv tool install par_scrape

# 或使用 pipx

pipx install par_scrape

4.脚本家の設置(オプション)

クローラーとしてPlaywrightを選択した場合、ブラウザを追加でインストールし、設定する必要があります:

uv tool install playwright

playwright install chromium

5.APIキーの設定

par_scrapeは複数のAIプロバイダーをサポートしているので、環境変数で対応するキーを設定する必要があります。編集 ~/.par_scrape.env ファイルに以下を追加する(必要に応じて選択):

OPENAI_API_KEY=your_openai_key

ANTHROPIC_API_KEY=your_anthropic_key

XAI_API_KEY=your_xai_key

または、コマンドを実行する前に環境変数を設定する:

export OPENAI_API_KEY=your_openai_key

使用方法

インストールが完了したら、コマンドラインからpar_scrapeを実行することができます:

基本的な使用例

OpenAIの価格ページからタイトル、説明、価格を抽出したいとします:

par_scrape --url "https://openai.com/api/pricing/" -f "Title" -f "Description" -f "Price" --model gpt-4o-mini --display-output md

--url対象ウェブページのアドレス。-f複数回使用可能。--modelAIモデル(例:gpt-4o-mini)を選択します。--display-output出力形式(md、json、csvなど)。

注目の機能操作

- クローラーツールの切り替え

デフォルトではPlaywrightが使われているが、Seleniumを使いたい場合はパラメータを追加できる:par_scrape --url "https://example.com" -f "Title" --scraper selenium - パラレルキャプチャ

効率を上げるために、並列リクエストの最大数を設定する:par_scrape --url "https://example.com" -f "Data" --scrape-max-parallel 5 - 動的ページ待機

動的に読み込まれるコンテンツには、待機タイプとセレクタを設定できる:par_scrape --url "https://example.com" -f "Content" --wait-type selector --wait-selector ".dynamic-content"サポートされているウェイトタイプは以下の通り。

noneそしてpauseそしてsleepそしてidleそしてselector歌で応えるtext. - カスタム出力パス

指定したフォルダに結果を保存します:par_scrape --url "https://example.com" -f "Title" --output-folder ./my_data

作業工程詳細

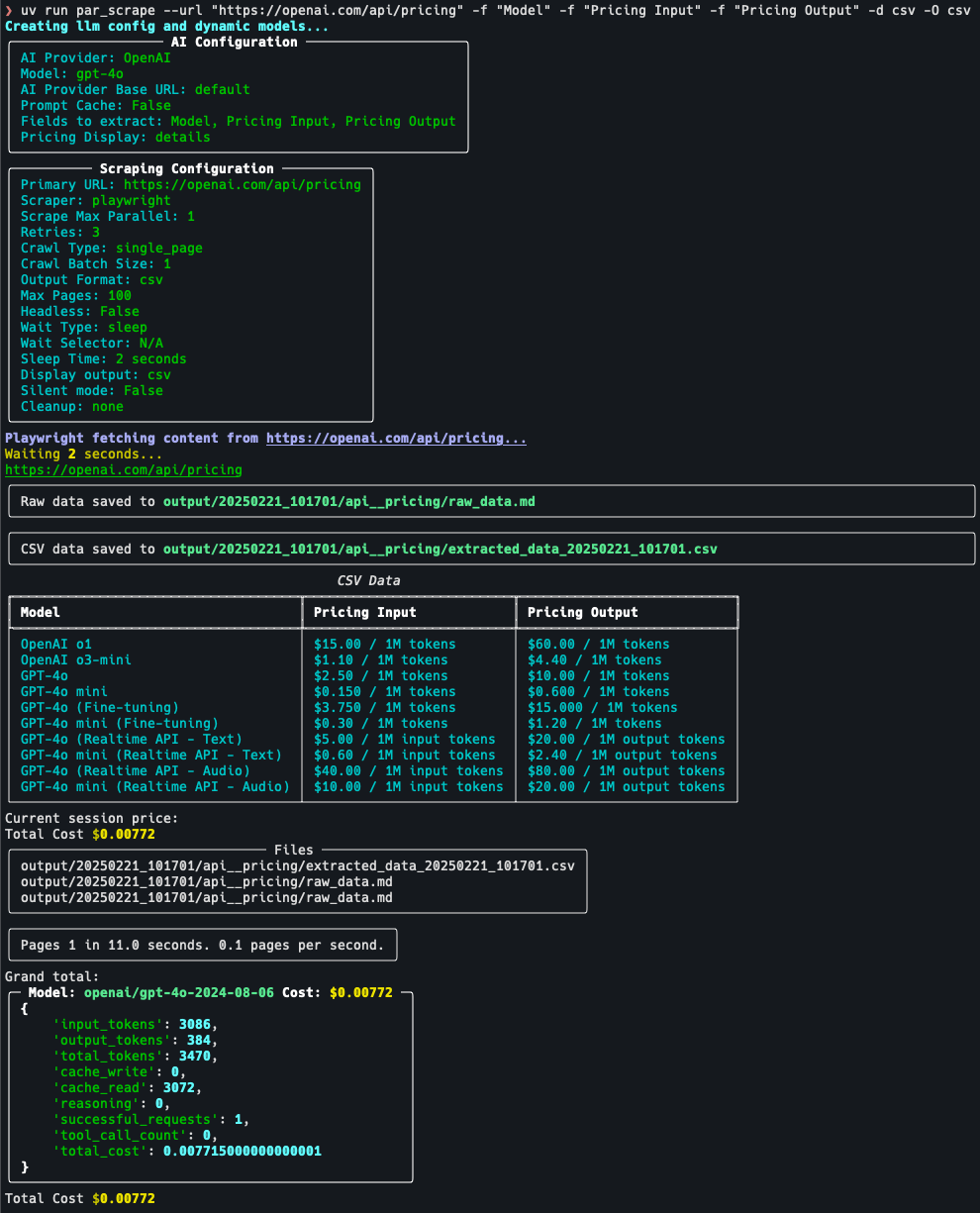

例えば、クロールの料金ページだ:

- 目標設定https://openai.com/api/pricing/ にアクセスし、"モデル"、"価格入力"、"価格出力 "を抽出する必要があることを確認する。Pricing Output" を抽出する必要があることを確認する。

- コマンド実行::

par_scrape --url "https://openai.com/api/pricing/" -f "Model" -f "Pricing Input" -f "Pricing Output" --model gpt-4o-mini --display-output json - 結果を見るコマンド実行後、端末はデータをJSON形式で表示するか、デフォルトの出力ファイルに保存します。

- 調整パラメーターデータに不備がある場合は、以下の項目を追加してみてください。

--retries 5(リトライ回数)または調整--sleep-time 5(待ち時間)。

ほら

- APIキーキーが有効であることを確認してください。有効でない場合、AI抽出機能は使用できません。

- ウェブサイトの制限サイトによっては、クロールを防止する仕組みがある場合があります。

--headless(ヘッドレスモード)またはグラブ周波数を調整する。 - キャッシュの使用同じページを何度もクロールする場合は

--prompt-cacheコスト削減。

以上の手順で、ユーザーはpar_scrapeをすぐに使い始めることができ、ウェブページのデータ抽出タスクを簡単に完了することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません