OpenManus: MetaGPTによるManusのオープンソース版

はじめに

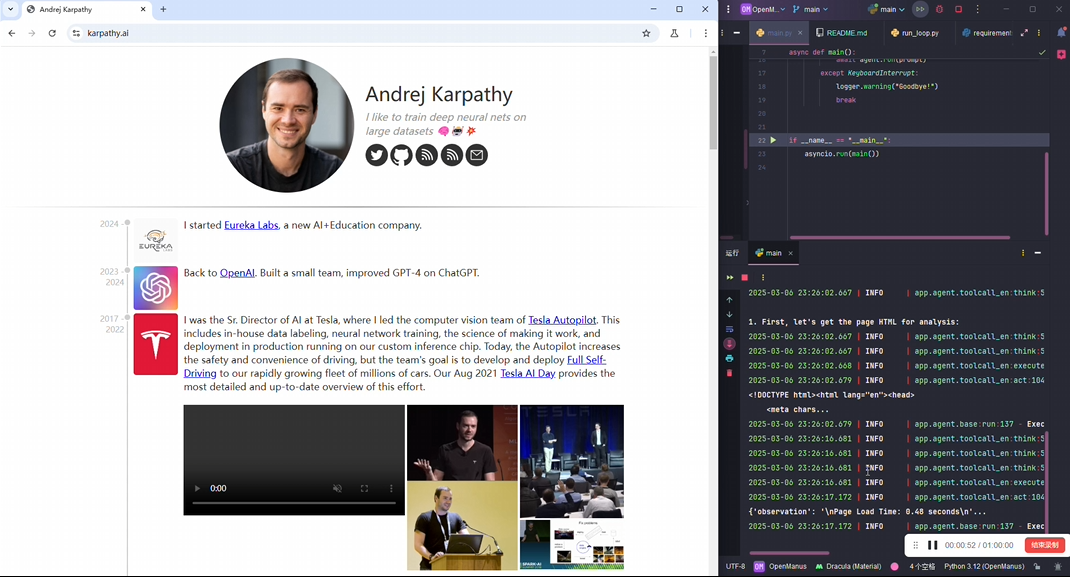

OpenManusは、ユーザーが簡単な設定でローカルにインテリジェンスを実行し、様々な創造的なアイデアを実現できるように設計されたオープンソースプロジェクトです。構成は以下の通りです。 メタGPT コミュニティメンバーの@mannaandpoem、@XiangJinyu、@MoshiQAQ、@didiforgithubがわずか3時間で開発した! MGX 招待コードが必要なManusに比べ、OpenManusは参入障壁が不要です。招待コードを必要とするManusに比べ、OpenManusは参入障壁を必要とせず、ユーザーはコードをクローンし、LLM APIを設定するだけで、すぐに始めることができる。プロジェクトはPython開発に基づいており、単純明快な構造で、端末を通じたタスクの入力をサポートし、インテリジェントな本体を動かしてオペレーションを実行する。現在のところ初歩的な実装であり、チームは提案やコードの提供を歓迎している。 将来の計画には、タスク計画の最適化やリアルタイム・デモンストレーション機能の追加が含まれる。

OpenManus インターフェース・バージョン: https://github.com/YunQiAI/OpenManusWeb

オープンマヌスウェブ(非公式)

機能一覧

- 地元のインテリゲンチャの活動ターミナルからタスクを入力し、設定されたLLM APIを使用してローカルで自動オペレーションを実行します。

- 主流のLLMモデルをサポートGPT-4oはデフォルトで統合されており、ユーザーは必要に応じてモデル構成を調整することができます。

- ワンタッチスタート走る

python main.pyタスク入力モードに素早く入ることができる。 - 実験版提供

python run_flow.py開発中の新機能のテストに使用される。 - 地域社会との協力GitHubを通じて課題やコードを提出し、プロジェクト開発への参加を支援する。

ヘルプの使用

設置プロセス

OpenManusのインストールは簡単で、Pythonに慣れているユーザーに適しています。以下はその詳細な手順です:

1.Conda環境の構築

依存関係の衝突を避けるために、Condaを使用してスタンドアロン環境を作成することをお勧めします:

conda create -n open_manus python=3.12

conda activate open_manus

- 指示最初のコマンドは

open_manus2番目のコマンドは環境をアクティブにし、ターミナルのプロンプトは次のように変わります。(open_manus). - 前提条件Condaをインストールする必要があり、Anacondaのウェブサイトからダウンロードできる。

2.コードリポジトリのクローン

GitHubからOpenManusプロジェクトをダウンロードする:

git clone https://github.com/mannaandpoem/OpenManus.git

cd OpenManus

- 指示最初のコマンドはローカルにコードをクローンし、2番目のコマンドはプロジェクト・ディレクトリに入る。

- 前提条件Gitをインストールする必要があります。

git --version利用可能かどうかを確認し、利用可能でなければgit-scm.comからダウンロードする。

3.依存関係のインストール

プロジェクトに必要なPythonパッケージをインストールします:

pip install -r requirements.txt

- 指示::

requirements.txtファイルには、このコマンドを実行すると自動的にインストールされる依存パッケージがすべてリストされている。 - ネットワーク最適化ダウンロードが遅い場合は、以下のような国内ミラーを利用することができます。

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple.

設定ステップ

OpenManus は、以下に説明するように、スマートボディ機能を駆動するために LLM API を設定する必要があります:

1.設定ファイルの作成

プロジェクトのルート・ディレクトリにある config フォルダに設定ファイルを作成する:

cp config/config.example.toml config/config.toml

- 指示このコマンドは、サンプル・ファイルを実際のコンフィギュレーション・ファイルとしてコピーします。

config.tomlは実行時に読み込まれるファイルである。

2.設定ファイルの編集

見せる config/config.tomlAPIキーとパラメータを入力してください:

# 全局 LLM 配置

[llm]

model = "gpt-4o"

base_url = "https://api.openai.com/v1"

api_key = "sk-..." # 替换为你的 OpenAI API 密钥

max_tokens = 4096

temperature = 0.0

# 可选的视觉模型配置

[llm.vision]

model = "gpt-4o"

base_url = "https://api.openai.com/v1"

api_key = "sk-..." # 替换为你的 OpenAI API 密钥

- パラメータの説明::

modelデフォルトはGPT-4o。base_urlデフォルトはOpenAIの公式インターフェースです。api_keyOpenAIから取得した認証用の鍵。max_tokens単一世代の最大数 トークン 出力長をコントロールする数値。temperature0.0は最も安定した出力を示す。

- APIキーの取得OpenAIのウェブサイトにアクセスし、ログインして "API Keys "ページでキーを生成し、設定ファイルにコピーします。

操作と使用

インストールと設定が完了したら、以下の方法で OpenManus を起動できます:

1.基本操作

メインプログラムを実行する:

python main.py

- ワークフロー::

- 端末にプロンプトが表示されたら、タスクを入力する(例:「週間計画の作成を手伝ってください」)。

- Enter を押してコミットすると、OpenManus は LLM を呼び出してタスクを処理します。

- 処理結果は端末に直接表示される。

- 使用シナリオテキストやコードスニペットの生成など、簡単なタスクの実行や迅速なテストに最適です。

2.実験走行

新機能を体験するには、不安定版を実行してください:

python run_flow.py

- 特性開発中の機能が含まれており、バグがある可能性があります。

- 銘記するコンフィギュレーション・ファイルが正しいことを確認してください。

注目の機能操作

地元のインテリゲンチャの活動

- 機能説明ターミナルからタスクを入力し、OpenManus がローカルで LLM を呼び出して処理し、結果を返します。

- 操作例::

- うごきだす

python main.py. - 入力:「1から100までの和を計算するPython関数を書きなさい」。

- 出力例:

def sum_to_100(): return sum(range(1, 101))

- うごきだす

- ゆうせいデータをアップロードすることなくローカルで実行でき、プライバシーを保護し、応答性に優れています。

主流のLLMモデルをサポート

- 機能説明ユーザーは必要に応じてLLMモデルを切り替えることができます。

- 手続き::

- コンパイラ

config.toml意志model他のモデルに変更する(例"gpt-3.5-turbo"). - 保存して実行する

python main.py. - 様々なモデルのアウトプットを体験するためのインプットタスク。

- コンパイラ

- 提案複雑な作業にはGPT-4o、単純な作業にはGPT-3.5-turboが費用対効果が高い。

よくある質問

- 課題ModuleNotFoundError "エラーで実行されます。

- けっちゃくをつける依存関係が完全にインストールされていることを確認し、再実行する。

pip install -r requirements.txt.

- けっちゃくをつける依存関係が完全にインストールされていることを確認し、再実行する。

- 課題無効なAPIキー」。

- けっちゃくをつける検査

config.toml正鵠を得るapi_keyが正しいか、キーを再生成する。

- けっちゃくをつける検査

- 課題走りがたどたどしかったり、反応が鈍かったりする。

- けっちゃくをつけるネットワーク接続が安定していることを確認するか、接続数を減らしてください。

max_tokensの値を使って計算量を減らす。 - デモを見るプロジェクトが提供するもの デモ映像実際の営業成績を示す。

- けっちゃくをつけるネットワーク接続が安定していることを確認するか、接続数を減らしてください。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません