OpenAIの次世代モデルが大きなボトルネックに、元チーフ・サイエンティストが新ルートを明かす

OpenAIの次世代大規模言語モデル「Orion」が、かつてないボトルネックにぶつかっている可能性がある。The Informationによると、Orionモデルの性能向上は期待を下回っており、品質向上はGPT-3からGPT-4へのアップグレードよりも「はるかに小さい」とOpenAIの社員は語っている。

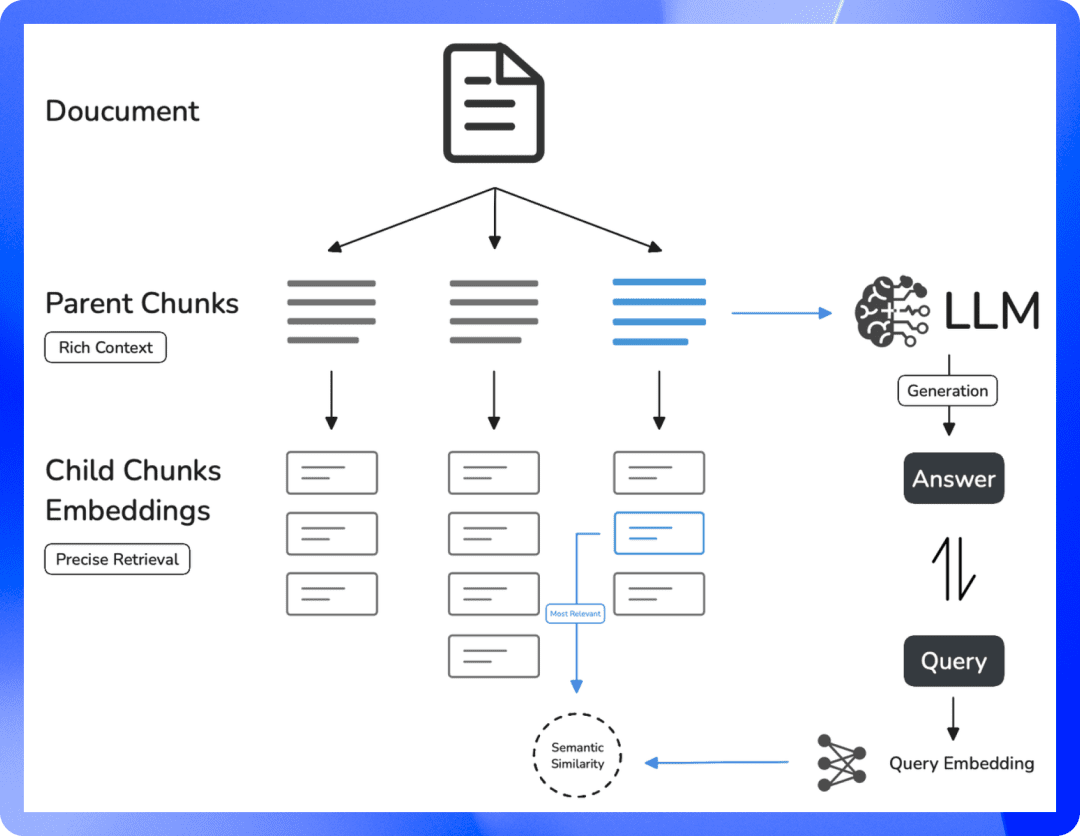

さらに、Orion は、特定のタスクにおいて、GPT-4 の前身ほど安定していない。Orionの言語能力が高いにもかかわらず、プログラミング性能はGPT-4を上回らないかもしれない。高品質のテキストやその他のデータを訓練するためのリソースが減少しているため、高品質の訓練データを見つけることが難しくなっており、大規模言語モデル(LLM)の開発が遅れている。

それだけでなく、将来的なトレーニングは、資金や電力の面でもさらに計算集約的なものになるだろう。つまり、Orionやそれに続く大きな言語モデルの開発コストは大幅に上昇することになる。openAIの研究者であるノーム・ブラウンは最近、TED AIカンファレンスで、より高度なモデルは「経済的に実現不可能」かもしれないと語った:

本当に何千億、何兆ドルもかけてモデルをトレーニングするつもりなのだろうか?ある時点で、スケーリングの法則は崩れるだろう。

OpenAIは、ニック・ライダー率いる基礎チームを立ち上げ、トレーニングデータの不足に対処する方法と、ビッグモデルのスケーリング法則がいつまで続くかを検討している。

ノーム・ブラウン

学習可能なデータが増え、学習プロセスを推進する計算能力が高まる限り、大規模な言語モデルの性能は同じ速度で向上し続ける。つまり、スケーリングの法則は、リソースのインプット(データ量、計算能力、モデルサイズ)とモデル性能のアウトプットの関係を表している。つまり、より多くのリソースを大規模言語モデルに投入した場合に、どの程度性能が向上するかということである。

例えば、大規模な言語モデルのトレーニングは、自動車の生産に例えることができる。当初、工場は小規模で、数台の機械と数人の作業員しかおらず、この時点では、機械や作業員を追加するごとに、追加リソースが直接生産性に反映されるため、生産量が大幅に増加する。しかし、工場の規模が大きくなるにつれて、追加の機械または労働者1人当たりの生産高の増加は、おそらく管理の複雑さの増大または労働者の共同作業の効率の低下により、減少する。

工場がある一定の規模に達すると、機械や労働者を増やしても、生産量の増加には限界があり、その時点で工場は土地供給や物流などの資源の限界に近づいている可能性がある。この時点で、工場は土地、電力供給、ロジスティクスなどのリソースの限界に近づいている可能性があり、さらなる投資はもはや生産能力に見合った増加をもたらさない。これはまさにオリオンのモデルが直面するジレンマである。モデルのサイズが大きくなるにつれて(機械や労働者を増やすのと同じように)、モデルの性能向上は初期および中期段階では非常に顕著であるが、後期段階ではモデルサイズや学習データ量を増やしても性能向上は小さくなる。これを「壁にぶつかる」という。

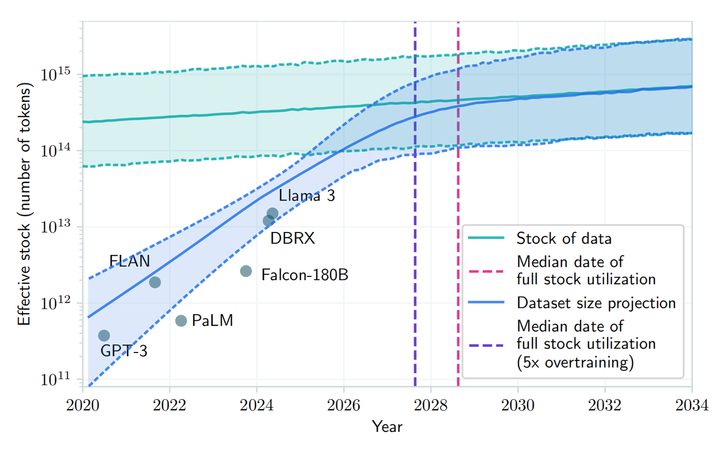

arXivに掲載された論文によると、ビッグ言語モデルの開発により、2026年から2032年の間に、公的な人間のテキストデータの需要が高まり、利用可能なデータが限られているため、公的な人間のテキストリソースが枯渇する可能性があると予測されている。ノーム・ブラウン氏は、将来のモデル訓練には「経済的な問題」があると指摘しながらも、「AIの発展はすぐには減速しない」と主張し、上記に対して反論している。

メタ社のマーク・ザッカーバーグCEO、OpenAIのサム・アルトマンCEO、その他のAI開発企業のCEOも、スケーリングの法則の従来の限界にはまだ達しておらず、学習済みモデルの性能を向上させるために高価なデータセンターを開発中であると公言している。MetaのCEOマーク・ザッカーバーグ、OpenAIのCEOサム・アルトマン、その他のAI開発企業のCEOも、従来のスケーリングの法則の限界にはまだ達しておらず、事前学習済みモデルの性能を向上させるために高価なデータセンターを開発していると公言している。

OpenAIの製品担当副社長であるピーター・ウェリンダー氏もソーシャルメディアで、「人々はテスト時計算の力を過小評価している」と述べた。テスト時計算(TTC)とは機械学習の概念で、モデルが新しい入力データに対して推論や予測を実行するために導入されるときに発生する計算を指し、トレーニング中に発生する計算とは別物である。トレーニング段階は、モデルがデータのパターンを学習するプロセスであり、テスト段階は、モデルが実世界のタスクに適用されるプロセスである。

伝統的な機械学習モデルは通常、一度学習され導入されると、追加の計算をすることなくデータの新しいインスタンスを予測する。しかし、ある種の深層学習モデルなど、より複雑なモデルの中には、テスト時(推論時)に追加の計算を必要とするものもある。OpenAIが開発した「o1」モデルは、このタイプの推論パターンを採用している。AI業界は全体として、初期学習が完了した後のモデルの最適化段階に重点を移しつつある。

ピーター・ウェリンダー

OpenAIの共同設立者の一人であるイリヤ・スッツケバーは、ロイター通信との最近のインタビューで、言語パターンや構造を理解するAIモデルを訓練するために大量のラベル付けされていないデータを使用する事前訓練段階は、効果の向上という点で頭打ちになったことを認めた。「2010年代は拡張の時代だったが、今は再び探索と発見の時代に戻っている」と語った。彼はまた、"精度の向上はこれまで以上に重要である "と指摘した。

Orionは2025年に打ち上げられる予定だが、OpenAIはこれを「GPT-5」ではなく「Orion」と命名しており、おそらくまったく新しい革命を示唆しているのだろう。現在は理論的な制約から「製造が難しい」とされているが、それでもこの新しく名付けられた「新生」が、AIマクロモデリングに変革の機会をもたらすことが期待されている。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません