Open-LLM-VTuber:リアルタイム音声対話のためのLive2DアニメーションAIバーチャルコンパニオン

はじめに

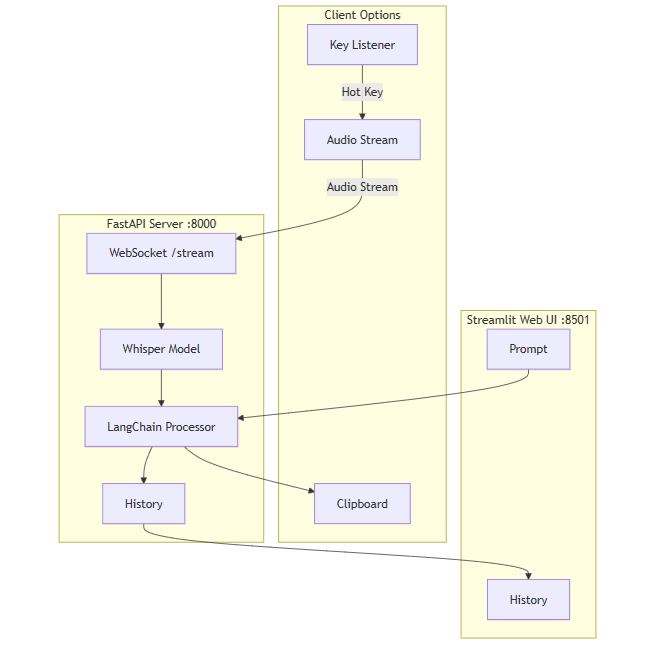

Open-LLM-VTuberは、ユーザーが音声とテキストを通じて大規模言語モデル(LLM)と対話できるオープンソースプロジェクトであり、ダイナミックなバーチャルキャラクターを提示するためにLive2D技術を組み込んでいます。Windows、macOS、Linuxをサポートし、完全にオフラインで動作し、ウェブとデスクトップの両方のクライアントモードがあります。ユーザーは、バーチャル・ガールフレンド、ペット、デスクトップ・アシスタントとして使用することができ、外見、性格、声をカスタマイズすることで、パーソナライズされたAIコンパニオンを作ることができる。このプロジェクトは、クローズドソースのAIバーチャル・アンカー「neuro-sama」のレプリカとして始まり、複数の言語モデル、音声認識、テキスト読み上げ、視覚認識をサポートする機能豊富なプラットフォームへと進化した。現在のバージョンはv1.0.0でリファクタリングされ、今後さらに機能が追加される予定で、活発な開発が行われている。

機能一覧

- 音声対話ハンズフリーの音声対話をサポートし、ユーザーはいつでもAIに割り込むことができ、スムーズなコミュニケーションが可能。

- Live2Dアニメーション対話内容に応じて表情やアクションを生成するダイナミックアバターを内蔵。

- クロスプラットフォーム対応Windows、macOS、Linuxに対応し、NVIDIA/非NVIDIA GPUおよびCPUの動作をサポートします。

- オフライン操作すべての機能は、プライバシーとセキュリティを確保するために、ネットワークなしで実行することができます。

- デスクトップ・ペット・モード透明背景、グローバル・トップ、マウス・ペネトレーションに対応し、キャラクターを画面上の好きな位置にドラッグできます。

- 視覚認識カメラや画面のコンテンツ認識によるAIとのビデオインタラクション。

- マルチモデル対応Ollama、OpenAI、Claude、Mistral、その他sherpa-onnxやWhisperなどの音声モジュールなど、様々なLLMと互換性があります。

- キャラクターのカスタマイズLive2Dモデルをインポートして、キャラクターやボイスを調整することができます。

- 触覚フィードバックキャラクターをクリックまたはドラッグすると、インタラクティブな反応が起こります。

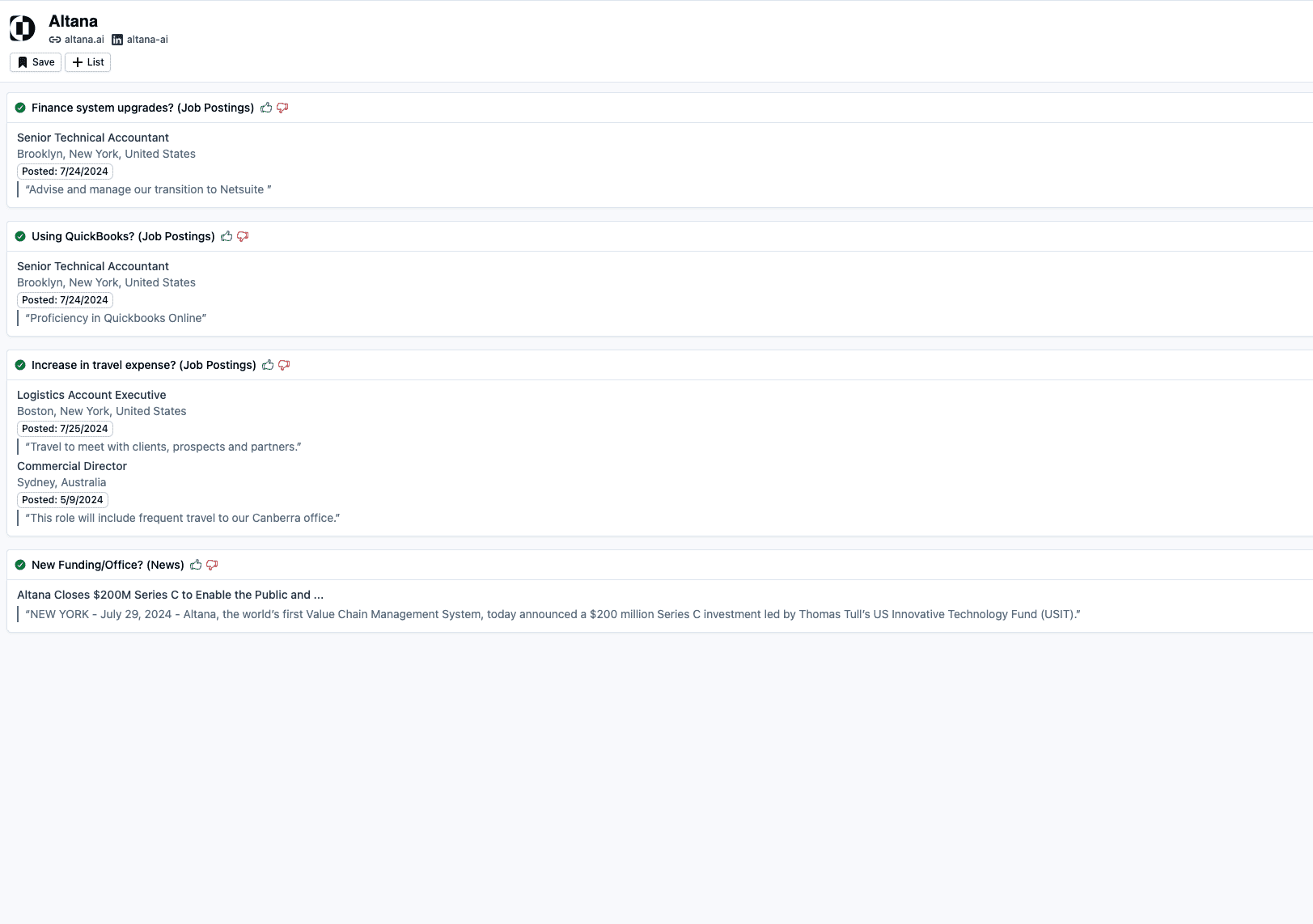

- チャットの記録管理歴史的な対話の切り替えをサポートし、インタラクティブなコンテンツを保持。

ヘルプの使用

設置プロセス

Open-LLM-VTuberはローカルにデプロイする必要があります:

1.前提条件

- ソフトウェア推奨NVIDIA GPUを搭載したWindows、macOS、Linuxコンピュータをサポート(GPUなしでも実行可能)。

- ハードウェアGit、Python 3.10+、uv(推奨パッケージ管理ツール)をインストールする。

- 網目初期展開には、依存関係をダウンロードするためのインターネット接続が必要です。

2.コードのダウンロード

- ターミナルからプロジェクトをクローンする:

git clone https://github.com/Open-LLM-VTuber/Open-LLM-VTuber --recursive cd Open-LLM-VTuber

- または、GitHub Releaseから最新のZIPファイルをダウンロードして解凍してください。

- 注:使用しない場合

--recursive走行に必要なものgit submodule update --initフロントエンドサブモジュールを取得する。

3.依存関係のインストール

- uvをインストールする:

- Windows(PowerShell):

irm https://astral.sh/uv/install.ps1 | iex - macOS/Linux:

curl -LsSf https://astral.sh/uv/install.sh | sh

- Windows(PowerShell):

- プロジェクト・ディレクトリで実行する:

uv syncFastAPI、onnxruntime、その他の依存関係を自動的にインストールします。

4.構成環境

- 最初の実行で設定ファイルが生成される:

uv run run_server.py - 生成された

conf.yaml以下のように設定する:- LLMモデルを選択します。 オーラマ (llama3やOpenAI APIの場合はキーを入力する必要があります)。

- 海難救助音声認識モジュール(例:sherpa-onnx)。

- TTS音声合成モジュール(Edge TTSなど)。

- 例

llm: provider: ollama model: llama3 asr: provider: sherpa-onnx tts: provider: edge-tts

5.サービスの活性化

- 走っている:

uv run run_server.py - インタビュー

http://localhost:8000ウェブ版を使うか、デスクトップクライアントをダウンロードして実行する。

6.デスクトップクライアント(オプション)

- GitHubリリースからダウンロード

open-llm-vtuber-electron(Windowsの場合は.exe、macOSの場合は.dmg)。 - クライアントを起動し、バックエンド・サービスがデスクトップ・ペット・モードを体験するために実行されていることを確認する。

7.アップデートとアンインストール

- 更新v1.0.0以降

uv run update.pyアップデートを行った場合、以前のバージョンは最新のドキュメントとともに再デプロイする必要がある。 - アンインストールプロジェクトフォルダを削除するには

MODELSCOPE_CACHEもしかしたらHF_HOMEモデルファイル、uv などのツールをアンインストールする。

機能 操作の流れ

音声対話

- 音声を有効にするウェブページまたはクライアントの "マイク "アイコンをクリックしてください。

- 対話インタラプト "ボタンを押すと、AIを中断させることができます。

- 最適化で

conf.yamlASRとTTSモジュールを調整して、認識と発音を改善する。

キャラクターのカスタマイズ

- インポートモデル.moc3ファイルを

frontend/live2d_modelsカタログ - 性格の調整:: 編集部

conf.yamlなprompt優しいお姉さん」のように。 - サウンドのカスタマイズGPTSoVITSなどのツールを使ってサンプルを録音し、ユニークな音色を作り出します。

デスクトップ・ペット・モード

- オープンモードクライアントで "Desktop Pets "を選択し、"Transparent Background "と "Top "にチェックを入れる。

- 動画画面上の好きな位置にドラッグします。

- 双方向性キャラクターをタップするとハプティック・フィードバックが作動し、内面の独白や表情の変化を見ることができます。

視覚認識

- カメラの起動ビデオチャット」をクリックし、アクセスを許可してください。

- 画面認識AIが画面内容を分析する「スクリーンセンス」を選択。

- 典型例スクリーンに何が映っているか」と尋ねると、AIが画像を説明する。

ほら

- ブラウザ他のブラウザはLive2Dの表示に影響を与える可能性があります。

- パフォーマンスGPUアクセラレーションは適切に設定されたドライバを必要とし、CPUでは動作が遅くなる可能性があります。

- ライセンス内蔵のLive2Dサンプルモデルは別途ライセンスが必要です。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません