OmAgent:マルチモーダル・スマートデバイス構築のための知的身体フレームワーク

はじめに

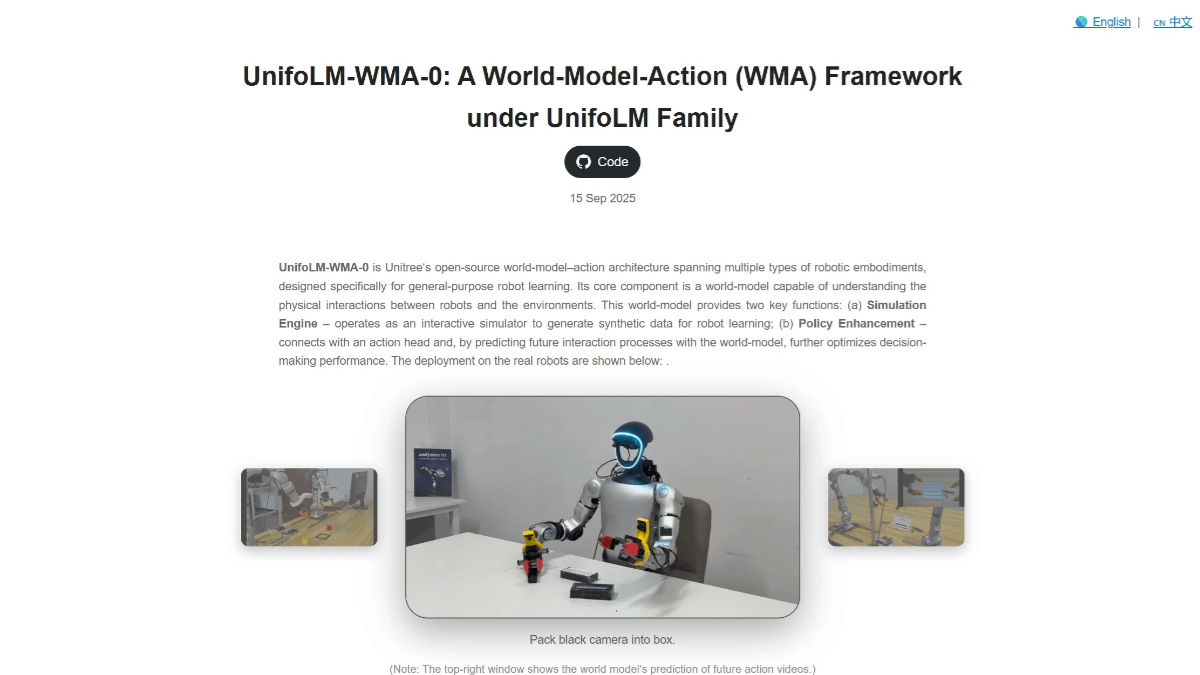

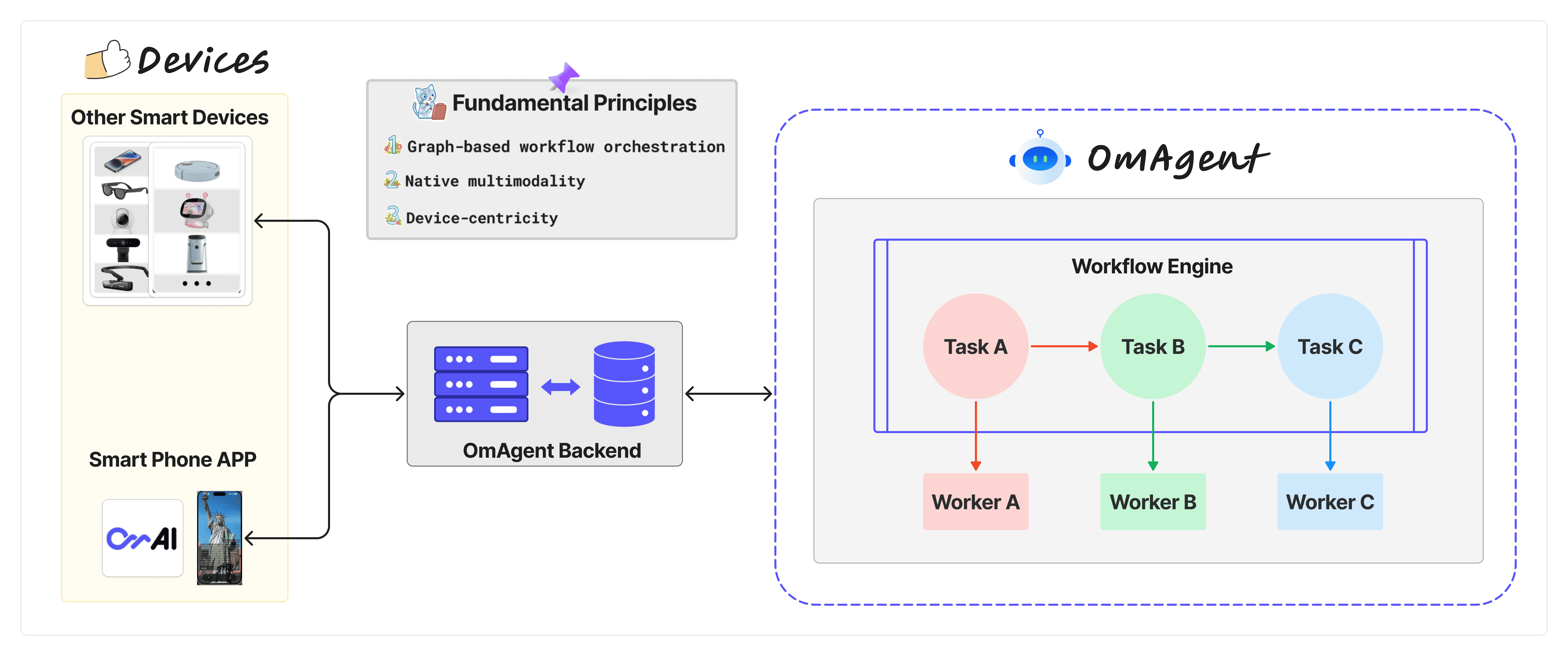

OmAgentは、Om AI Labによって開発されたマルチモーダルインテリジェントボディフレームワークであり、スマートデバイスに強力なAI搭載機能を提供することを目的としている。OmAgentは、テキストや画像の処理だけでなく、スマートフォンから未来のロボットまで幅広いシナリオに対応する複雑なビデオ理解もサポートしている。その中核となるのは、エンドツーエンドの計算を最適化し、ユーザーとデバイス間の自然でスムーズなインタラクションを保証することです。

機能一覧

- マルチモーダルモデルのサポート商用およびオープンソースのマルチモーダルベースモデルを統合し、強力なAIサポートを提供。

- デバイス接続の簡素化携帯電話やメガネなどの物理デバイスとの接続プロセスを簡素化し、デバイス上で動作するアプリの開発をサポートします。

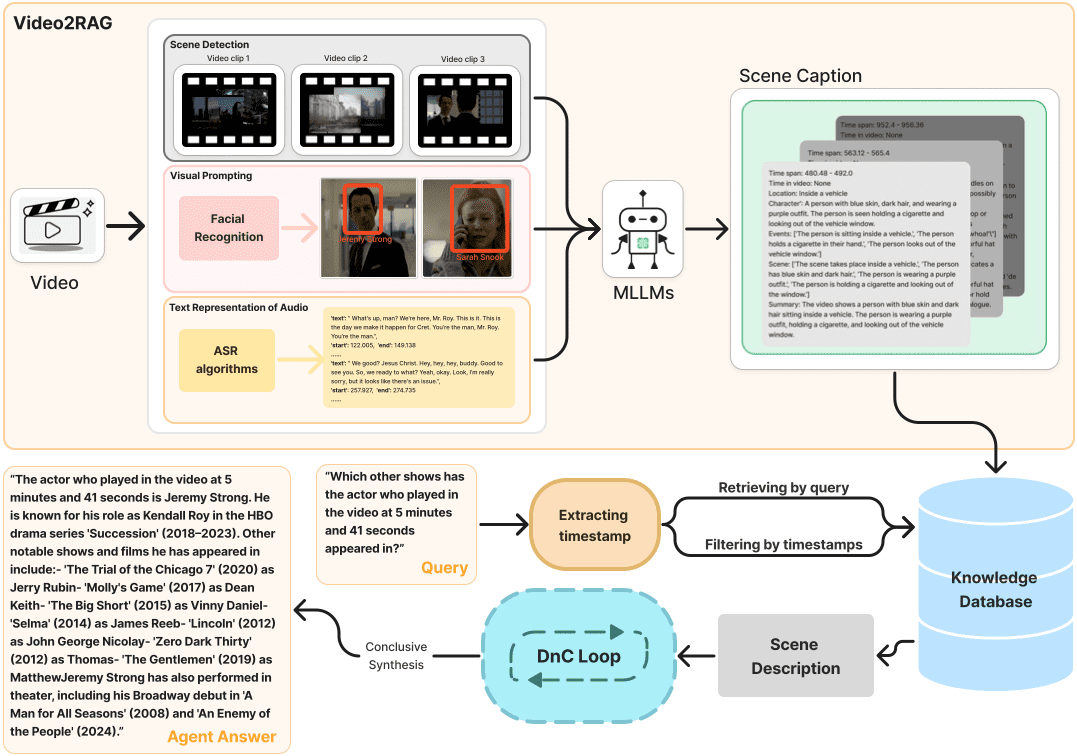

- 複雑な映像の理解分割統治アルゴリズムを使用して、ビデオコンテンツの深い解析と理解を提供します。

- ワークフロー・オーケストレーションConductor ワークフロー エンジンを使用して、ループや分岐などの複雑なオーケストレーション ロジックをサポートします。

- タスクと作業員の管理タスクとワーカーの概念を通して、ワークフローにおける論理的な振り付けとノードの実行。

- 高効率のオーディオおよびビデオ処理音声と映像の処理を最適化し、リアルタイムのインタラクティブな体験を保証します。

ヘルプの使用

設置プロセス

OmAgentはGitHubでホストされているオープンソースプロジェクトであり、インストール手順は以下の通りである:

- クローン倉庫::

- ターミナルを開き、以下のコマンドを実行してOmAgentのGitHubリポジトリをクローンする:

git clone https://github.com/om-ai-lab/OmAgent.git - クローンしたディレクトリに移動する:

cd OmAgent

- ターミナルを開き、以下のコマンドを実行してOmAgentのGitHubリポジトリをクローンする:

- 環境設定::

- Python環境を作成し、有効化する(condaを推奨):

conda create -n omagent python=3.10 conda activate omagent - 必要な依存関係をインストールします:

pip install -r requirements.txt - 特定のコンフィギュレーションが必要な場合(例:bing検索API)、そのコンフィギュレーションを変更します。

configs/tools/websearch.ymlファイルにbing_api_key.

- Python環境を作成し、有効化する(condaを推奨):

チュートリアル

インテリジェント・ボディの開発

- インテリジェンスの創造::

- から行うことができる。

examplesディレクトリ内のサンプルプロジェクトを検索します。step1_simpleVQAシンプルなマルチモーダル視覚クイズインテリジェンスを構築する方法を学びます。 - 例の手順に従って、あなた自身のインテリジェントなボディ・ロジックを書いてください。

- から行うことができる。

- 接続機器::

- OmAgent のアプリ・バックエンド・サービスを使用すると、インテリジェンスをデバイスにデプロイできます。以下を参照してください。

app使用文档デバイスの接続性に関するセクションでは、デバイスとインテリジェンス間の通信がシームレスであることを保証する。

- OmAgent のアプリ・バックエンド・サービスを使用すると、インテリジェンスをデバイスにデプロイできます。以下を参照してください。

- ビデオ理解::

- 利用する

video_understandingビデオ・コンテンツの処理と理解に OmAgent を使用する方法を理解するためのサンプル・プロジェクト。特に、インテリジェントな動画クエリと分析のための分割統治戦略(Divide-and-Conquer Loop)の使用に注目しています。

- 利用する

- ワークフロー管理::

- 作成と編集

container.yamlファイルを使用してワークフローを設定します。各ワークフローは複数のノードを含むことができ、各ノードは独立したタスクまたは複雑な論理ブランチにすることができます。 - をサポートするワークフローエンジンとしてConductorを使用します。

switch-caseそしてfork-joinそしてdo-whileなど、複雑なオペレーションをこなす。

- 作成と編集

- タスクと作業員::

- 開発中に

Taskワークフローロジックを管理する。Workerその後、特定の操作ロジックを実行する。それぞれのSimpleTaskカウンターパートWorkerこのようにして、インテリジェンスの機能を柔軟に構築し、拡張することができる。

- 開発中に

ランニング・インテリジェンス

- 実行例::

- クローンしたプロジェクト・ディレクトリで、サンプル・スクリプトを次のように実行する:

python run_demo.py - 結果は

./outputsフォルダー

- クローンしたプロジェクト・ディレクトリで、サンプル・スクリプトを次のように実行する:

- デバッグとテスト::

- GitHub Actionsを使用して自動テストとデプロイを行い、さまざまな環境でインテリジェンスが安定していることを確認しましょう。

徹底研究

- ドキュメントを見るOmAgent の詳細な API ドキュメントと使用法のチュートリアルは、フレームワークをより深く理解し、活用するのに役立ちます。

- 地域支援Om AI Labのコミュニティに参加して、ディスカッションに参加したり、サポートを受けたり、自分の仕事を共有したりしましょう。

これらのステップに従うことで、開発者はOmAgentの幅広い機能の恩恵を受け、さまざまなスマートデバイス上で動作する洗練されたAIインテリジェンスを作成し、単純なQ&Aから複雑なビデオ分析まで、幅広いタスクのソリューションを提供することができる。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません