Ollamaのインストールと使い方のチュートリアル

については、これまでにも多くの問題があった。 オーラマ インストールとデプロイのチュートリアルの情報はかなり分散しているので、今回はローカルのコンピュータでOllamaを使用する方法について、完全なワンステップのチュートリアルをまとめました。チュートリアルは間違ったつま先を踏まないように初心者を対象にしているので、できる人はOllamaの公式ドキュメントを読むことをお勧めします。そして、Ollamaのインストールと使い方をステップ・バイ・ステップで説明していきます。

大型モデルの現地設置にOllamaを選ぶ理由

多くの新参者は、私がそうであったように、大規模なモデルをデプロイするためのもっと優れたツールがオンライン上にあることを理解していない:Ollamaに似たLLMフレームワークの棚卸し:大規模モデルをローカルに展開するための複数の選択肢 なぜ最後にOllamaをインストールすることを勧めるのですか?

まず第一に、もちろんパソコンへのインストールが簡単であることは言うまでもないが、最も重要なポイントのひとつは、スタンドアロン展開のモデルの性能がパラメータに対してより最適化され、インストールにエラーが発生しにくいことである。例えば、同じ構成のコンピュータのインストール QwQ-32B スムーズな使用が可能なオラマを使用し、「よりパワフル」に変更。 ラマ.cpp 動かなくなったり、出力された答えが正しくなかったりします。Ollamaはllama.cppを一番下に含んでおり、より良い最適化により、llama.cppよりも安定して動作する。

Ollamaはどのような大きなモデルファイルを実行できますか?

Ollamaは、推論エンジンが異なる以下の2つの形式のモデルファイルをサポートしています:

- GGUFフォーマットスルー

llama.cpp理由 - セーフセンサー形式スルー

vllm理由

ということだ:

- GGUF形式のモデルが使用される場合、Ollamaは

llama.cppCPU/GPUによる効率的な推論を行う。 - safetensors フォーマットのモデルを使用する場合、Ollama は

vllmGPUに加えて、GPUはしばしば高性能な推論にも利用される。

もちろん気にする必要はない。ただ、インストールするファイルのほとんどがGGUFフォーマットであることを知っておいてほしい。なぜGGUFを強調するのですか?

GGUFサポート 定量的(例:Q4、Q6_K)能力非常に少ないグラフィックスとメモリフットプリントで優れた推論性能を維持セーフティセンサーは通常FP16/FP32のフルモデルですが、より大きく、より多くのリソースを消費します。詳しくはこちらをご覧ください:モデル量子化とは:FP32、FP16、INT8、INT4データ型の説明.

Ollama 最小構成要件

オペレーティングシステム: Linux: Ubuntu 18.04以降、macOS: macOS 11 Big Sur以降

RAM: 8GB(3Bモデル用)、16GB(7Bモデル用)、32GB(13Bモデル用

ディスク容量: Ollamaとベースモデルのインストールに12GB、モデルデータの保存にモデルによって追加容量が必要です。

CPUだ: 少なくとも4コアの最新のCPUを使用することが推奨され、13Bモデルを実行するには、少なくとも8コアのCPUを使用することが推奨されます。

GPU(オプション): Ollamaの実行にGPUは必要ありませんが、特に大きなモデルを実行する場合、パフォーマンスを向上させることができます。GPUをお持ちであれば、カスタムモデルのトレーニングを高速化するために使うことができます。

Ollamaをインストールする

https://ollama.com/download

コンピュータの環境に応じて選択するだけで、インストールは非常に簡単だが、ここで注意しなければならないのは、ネットワーク環境によっては正しくインストールできない場合があるということだ。

macOS インストール: https://ollama.com/download/Ollama-darwin.zip

Windows インストール: https://ollama.com/download/OllamaSetup.exe

Linuxのインストール:curl -fsSL https://ollama.com/install.sh | sh

Dockerイメージ:(公式サイトでご自身で勉強してください)

CPUまたはNvidia GPU:docker pull ollama/ollama

AMD GPU:docker pull ollama/ollama:rocm

インストールが完了すると、デスクトップの右下にOllamaのアイコンが表示されます。アイコンに緑色のアラートが表示されている場合は、アップグレードが必要なことを意味します。

オーラマのセットアップ

Ollamaのインストールは非常に簡単だが、ほとんどの設定は "環境変数 "を変更する必要があり、初心者には非常に不親切である:

| パラメトリック | ラベリングと設定 |

|---|---|

| OLLAMA_MODELS | モデルファイルが保存されているディレクトリを示します。現在のユーザーディレクトリ務める C:\Users%username%.ollama\modelsWindowsシステム Cドライブに置くことはお勧めしません。ディスクは他のディスク(例えば E:\ollama\models) |

| OLLAMA_HOST | はollamaサービスがリッスンするネットワークアドレスで、デフォルトは127.0.0.1 他のコンピュータ(LAN上の他のコンピュータなど)からOllamaへのアクセスを許可したい場合は推奨設定大丈夫 0.0.0.0 |

| OLLAMA_PORT | ollamaサービスがリッスンするデフォルトのポートを示す。11434 ポートの競合がある場合は、他のポートに設定を変更することができる(例えば、以下のように)。8080など) |

| OLLAMA_ORIGINS | HTTPクライアントのリクエスト元を、カンマで区切られたハーフカラムのリストで示します。 ローカルでの使用が制限されていない場合は、アスタリスクに設定できます。 * |

| ollama_keep_alive | ラージモデルがメモリにロードされた後の生存時間を示す。5mこれで5分だ。 (例えば、プレーンな数字300は300秒を意味し、0はリクエストに対するレスポンスが処理されると同時にモデルがアンインストールされることを意味し、マイナスの数字はモデルが維持されていることを意味する) を設定することをお勧めします。 24h このモデルは24時間メモリに残るため、アクセス速度が向上する。 |

| ollama_num_parallel | 同時に処理されるリクエスト数を示す。1 (すなわち、リクエストの単一同時シリアル処理) 提言は実際のニーズに合わせて調整される |

| ollama_max_queue | リクエストキューの長さを示す。512 キュー長を超えるリクエストは破棄されます。 |

| OLLAMA_DEBUG | はデバッグ・ログの出力を表します。1 (トラブルシューティングのための詳細なログ情報を出力する)。 |

| ollama_max_loaded_models | 同時にメモリにロードされるモデルの最大数を示す。1 (つまり、1つのモデルしかメモリーできない) |

1.大きなモデルファイルのダウンロードディレクトリを変更する

Windowsシステムでは、Ollamaによってダウンロードされたモデルファイルは、デフォルトでユーザーフォルダ下の特定のディレクトリに保存されます。具体的には、デフォルトのパスは通常C:\Users\<用户名>\.ollama\models.ここだ。<用户名>は、現在のWindowsシステム・ログイン・ユーザー名を指す。

例えば、システム・ログイン・ユーザー名がyangfanその場合、モデルファイルのデフォルトの保存パスは次のようになります。C:\Users\yangfan\.ollama\models\manifests\registry.ollama.ai.このディレクトリには、Ollamaを通じてダウンロードされたすべてのモデルファイルがあります。

注:新しいシステムのインストール・パスは一般的にC:\Users\<用户名>\AppData\Local\Programs\Ollama

Cドライブの空き容量が少ない場合、最初に行うべきことは、大きなモデルファイルのダウンロードディレクトリを変更することです。

1.環境変数のエントリーポイントを探す

最も簡単な方法:Win+Rで実行ウィンドウを開き、次のように入力します。 sysdm.cplこのオプションを使いたい場合は、「システムのプロパティ」を開き、「詳細設定」タブを選択し、「環境変数」をクリックします。

その他の方法

1.スタート->設定->詳細システム設定->システムのプロパティ->環境変数。

2.このコンピュータ -> 右クリック -> プロパティ -> 詳細システム設定 -> 環境変数。

3.スタート->コントロールパネル->システムとセキュリティ->システム->システムの詳細設定->システムのプロパティ->環境変数。

4.デスクトップ下部の検索ボックス->入力->環境変数

入力すると、以下の画面が表示されます:

2.環境変数の変更

システム変数からOLLAMA_MODELSという変数を探し、なければNewをクリックする。

OLLAMA_MODELS が既に存在する場合は、それを選択してマウスの左ボタンをダブルクリックするか、選択し て "Edit "をクリックする。

変数の値は新しいディレクトリに変更され、ここではCドライブから、よりディスク容量のあるEドライブに変更している。

保存後、コンピュータを新しいスタートアップから起動し、より安全な結果を得るために再度使用することをお勧めします。

2.デフォルトのアクセスアドレスとポートを変更する

ブラウザでURLを入力: http://127.0.0.1:11434/ 、あなたはそれが実行されていることを示す、次のメッセージが表示されます、まだ環境変数で、変更する必要があるいくつかのセキュリティリスクがここにある。

1.OLLAMA_HOSTの変更

エクストラネットへのアクセスを許可するために0.0.0.0になっている場合は、127.0.0.1に変更します。

2.OLLAMA_PORTの変更

もしそれがなければ、追加し、11434を以下のような任意のポートに変更する。:11331(ポートの変更範囲は1~65535)、ポートの衝突を避けるために1000から始めてください。英語の": "に注意してください。

Ollamaのセキュリティに関する推薦図書を読むために、コンピュータを再起動することを忘れないでください:DeepSeekがOllamaを炎上させる。盗まれた」算数には要注意

大型モデルの設置

URLへ:https://ollama.com/search

モデル選択、モデルサイズ選択、コピーコマンド

コマンドラインツールへのアクセス

コマンドを貼り付けると自動的にインストールされます。

こちらでダウンロードしていますので、遅いようでしたら、より快適なインターネット環境に切り替えることをご検討ください!

もしOllamaが提供していない大きなモデルをダウンロードしたいのであれば、それは可能だ。 ディープシーク-R1 32Bを装着デモの例として使用。

1.huggingface定量的バージョニングモデルの基本コマンド形式のインストール

次のインストール・コマンドの書式を覚えておいてください。

ollama run hf.co/{username}:{reponame}

2.定量版の選択

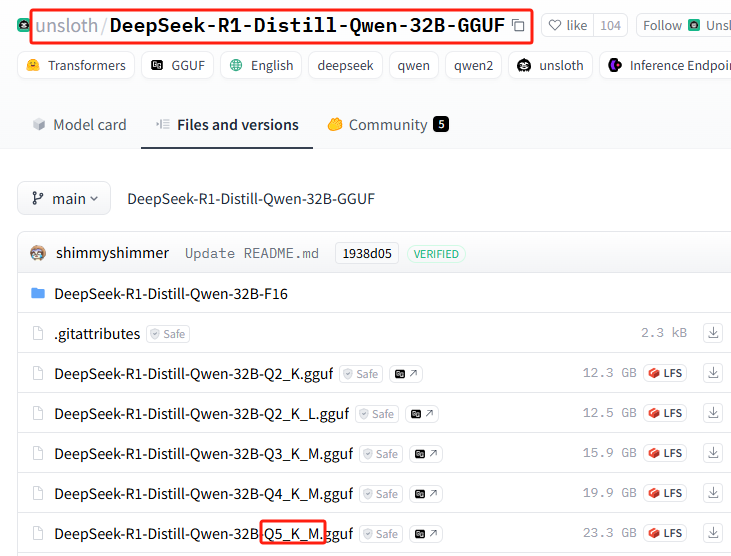

すべての量的バージョンのリスト: https://huggingface.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF/tree/main

このインストレーションではQ5_K_Mを使用します。

3.スプライス取り付けコマンド

{ユーザー名}=unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF

{レポ名}=Q5_K_M

完全なインストール・コマンドを取得するためにスプライスする:ollama run hf.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

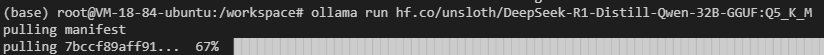

4.Ollamaでインストールを実行する

インストール・コマンドを実行する

ネットワーク障害が発生するかもしれない(幸運を祈る)。

まだ動かない?次のコマンドを試してみてください。hf.co/セクションを次のように修正する。https://hf-mirror.com/(国内のミラーアドレスに切り替える)、完全なインストール・コマンドの最終的なパッチワークは以下のようになる:

ollama run https://hf-mirror.com/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

このセクションの完全なチュートリアルが用意されている:ローカルGPUなしのプライベート展開 DeepSeek-R1 32B

Ollama基本コマンド

| 命令 | 説明 |

|---|---|

ollama serve | オッラマの立ち上げ |

ollama create | モデルファイルからモデルを作成する |

ollama show | モデル情報の表示 |

ollama run | 運用モデル |

ollama stop | 実行中のモデルを停止する |

ollama pull | レジストリからモデルを引き出す |

ollama push | モデルをレジストリにプッシュする |

ollama list | 全モデルをリストアップ |

ollama ps | 走行モデル一覧 |

ollama cp | レプリケーション・モデル |

ollama rm | モデルの削除 |

ollama help | 任意のコマンドのヘルプ情報を表示する |

| シンボライズ | 説明 |

|---|---|

-h, --help | Ollamaのヘルプ情報を表示する |

-v, --version | バージョン情報の表示 |

複数行にコマンドを入力する場合は """ 改行を行う。

利用する """ 終端改行。

Ollamaモデル推論サービスを終了するには /bye.

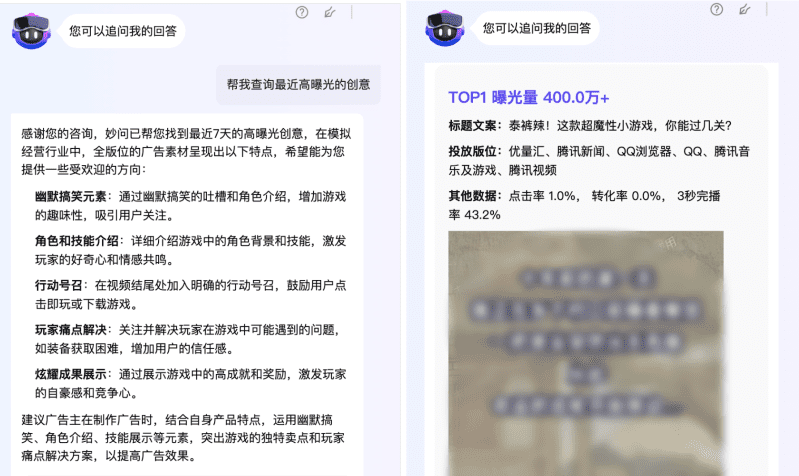

ネイティブAI対話ツールでOllamaを使う

主流のネイティブAI対話ツールのほとんどは、デフォルトですでにOllamaに適応しており、何の設定も必要ない。例えば ページアシスト OpenwebUI。

ただし、一部のローカルAI対話ツールでは、APIアドレスを自分で入力する必要がある。http://127.0.0.1:11434/: (ポートが変更されている場合は注意)

ウェブベースのAI対話ツールの中には、設定をサポートしているものもある。 ネクストチャット :

ローカル・コンピューター上で動作するOllamaを完全に外部に公開したい場合は、cpolarやngrokを独学する必要があるが、これは初心者が使う範囲を超えている。

この記事は非常に長いように見えるが、実は非常にシンプルな4つの知識ポイントの中で、基本的に支障のないOllamaの今後の使い方を学び、もう一度おさらいしてみよう:

1.環境変数の設定

2.大型モデルを設置する2つの方法

3.基本的なモデルの実行と削除コマンドを覚える

4.異なるクライアントでの使用

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません

![[转]从零拆解一款火爆的浏览器自动化智能体,4步学会设计自主决策Agent](https://aisharenet.com/wp-content/uploads/2025/01/e0a98a1365d61a3.png)