Ollama、AIコパイロット・プログラミング・アシスタントにアクセス

簡単

この文書では、次のようなものをローカルで構築する方法について説明します。 コパイロット のプログラミング・アシスタントは、より美しく効率的なコードを書く手助けをする。

このコースでは オーラマ 地元番組アシスタントの統合(以下を含む

- 続ける

- 助っ人

注目してほしい:

- VScodeのインストールと基本的な使い方について説明します。jetbrainの使い方はVScodeとほぼ同じで、vscodeを参照するだけです。

- jetbrainで利用可能な機能や設定可能な機能は、VScodeで利用可能な機能ほど豊富ではないので、VScodeを使用することをお勧めします。

- Copilotをローカルでビルドすると、マシン、特にコードの自動補完部分の要件が高くなるため、特別なニーズがない場合は、APIを購入して使用することをお勧めします。

I. AIプログラミング入門

1.1 なぜAIでプログラミングするのか?

ビッグ・ランゲージ・モデルの歴史は長いが、最も優れたパフォーマンスを発揮してきたのはプログラミングである:

- 善悪の明確な基準。 プログラミングの世界では、コードは動くか動かないかのどちらかだ。この白黒はっきりした性質が、AIがアウトプットの質を判断しやすくしている。

- 的確な表現。 プログラミング言語には曖昧さがあまりない。すべての記号、すべてのキーワードには明確な意味がある。この正確さこそ、AIモデルが得意とするところだ。

- 目標とするミッション コードを書くとき、私たちはたいてい明確な目標を持つ。例えば、"フィボナッチ数列を計算する関数を書け "とか。このような明確な指示があれば、AIは問題に集中しやすくなる。

- 知識の一般化可能性。 一度プログラミング言語の基本概念を学べば、多くのことは他の言語にも転用できる。この知識の移行可能性により、AIモデルはプログラミング領域で特に効率的となる。

1.2 AIを使ってどのようにプログラミングするか?

- ビッグ・モデル・ダイアログ・アプリケーションの使用(ここではこれ以上説明しない)

- 統合開発環境(IDE)の使用

- 続ける

- コマンドラインツールの使用

- 助っ人

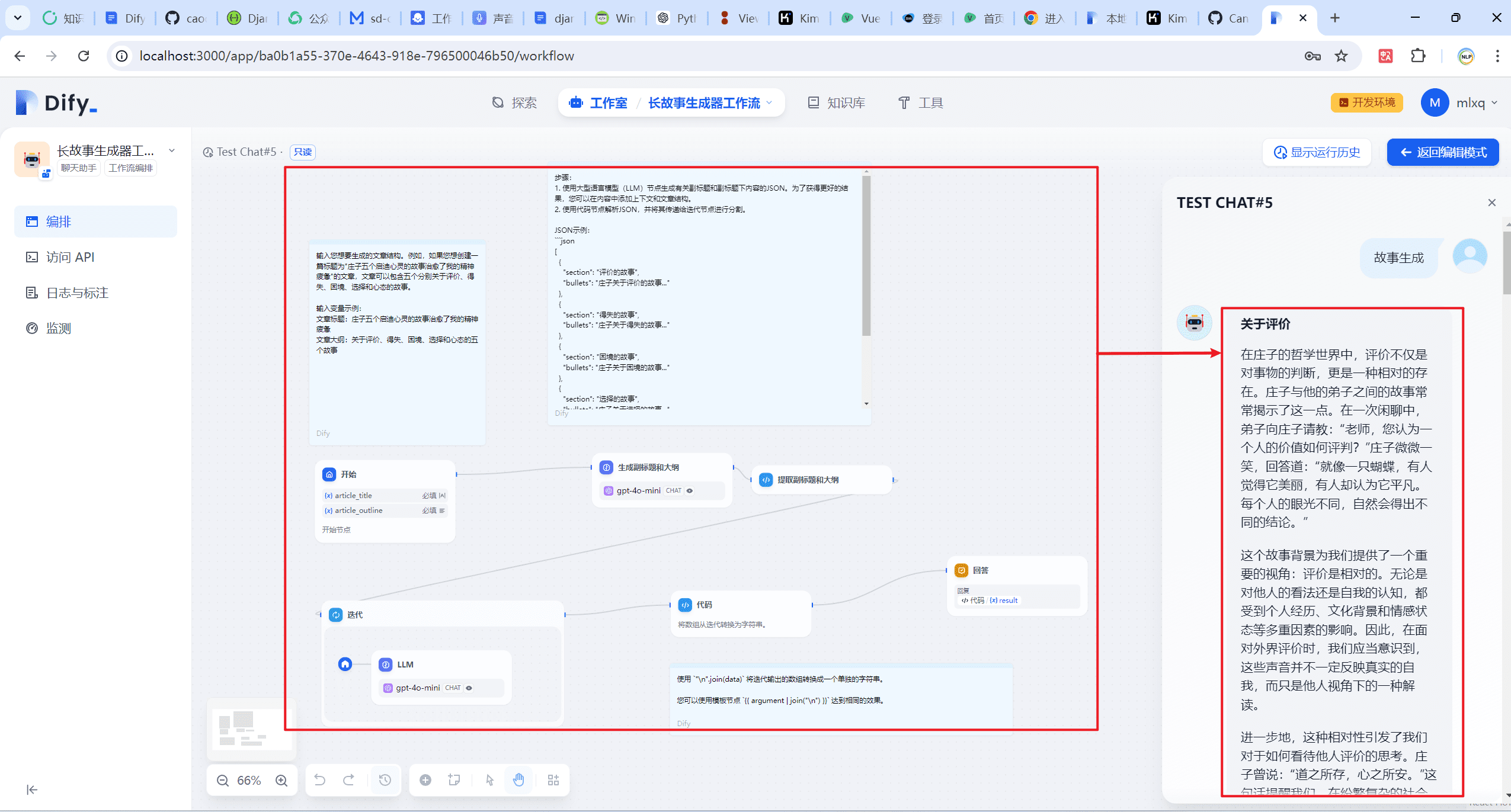

IDEコンティニュー・アクセス

2.1 必要なモデルのインストール

- Ollamaをインストールする

- 以下のモデルを取り付ける。

- ユニバーサル・クエスチョン&アンサー(UQA)モデルの導入

ollama pull llama3:8b - 自動コード補完モデルのインストール。

ollama pull starcoder2:3b - 埋め込みモデルをインストールします。

ollama pull nomic-embed-text

- ユニバーサル・クエスチョン&アンサー(UQA)モデルの導入

2.2 VScodeへのContinueのインストールとローカルOllamaの設定

- VScode プラグイン・ライブラリへのモデルのインストール

Continueを検索し、以下のアイコンが表示されたら、インストールまたはインストールをクリックする。

- (推奨アクション)「Continue」をVS Codeの右サイドバーに移動することを強くお勧めします。これにより、Continueを使用するときにファイルエクスプローラーを開いておくことができ、簡単なキーボードショートカットでサイドバーを切り替えることができます。

- コンフィギュレーション・オラマ

方法1:「モデルを選択」をクリック-「モデルを追加」を選択-「Ollama」をクリック-「自動検出」を選択

これにより、コード推論ツール用にOllamaでダウンロードしたモデルが自動的に選択される。

モード2:図のようにSetupボタンをクリックして設定ページに入り、以下の設定を貼り付ける。{ "models": [ { "title": "Ollama", "provider": "ollama", "model": "AUTODETECT" } ], "tabAutocompleteModel": { "title": "Starcoder 2 3b", "provider": "ollama", "model": "starcoder2:3b" }, "embeddingsProvider": { "provider": "ollama", "model": "nomic-embed-text" } }

2.3 基本的な使用ガイドライン

- 理解しやすいコード

- VSコード

cmd+L( MacOS ) /ctrl+L( Windows ) - ジェットブレインズ

cmd+J( MacOS ) /ctrl+J( Windows )

- Tabキーを使ったコードのオートコンプリート

- VSコード

tab( MacOS ) /tab( Windows ) - ジェットブレインズ

tab( MacOS ) /tab( Windows )

- AIが素早くコードを修正

- VSコード

cmd+I( MacOS ) /ctrl+I( Windows ) - ジェットブレインズ

cmd+I( MacOS ) /ctrl+I( Windows )

- 現在のコード・ディレクトリに基づいて質問する

- VSコード

@codebase( MacOS ) /@codebase( Windows ) - JetBrains : 今後のサポート

- 公式文書に基づいて質問する

- VSコード

@docs( MacOS ) /@docs( Windows ) - ジェットブレインズ

@docs( MacOS ) /@docs( Windows )

2.4 参考文献

公式サイト:https://docs.continue.dev/intro

コマンドライン環境 エイダーアクセス

Aiderはコマンドライン・ベースのプログラミング・アシスタントで、IDEよりもトップレベルのシステム・アクセスや機能利用が可能だが、それは同時に、使い始めるのが難しいということでもある。

以下のチュートリアルでは、Aiderをインストールし、Ollamaサービスに接続する方法を説明します。

また、確認してほしい:

- gitがインストールされており、gitの使用経験があること。

- パイソンの経験

3.1 エイダーの設置

- Aiderはpython環境に依存する部分が多いので、condaを使って新しい環境を作るか、pythonを使って新しい仮想環境を作ることをお勧めします。

- 新しい conda 仮想環境を起動します (python 仮想環境も同じです)

conda create -n aider_env python=3.9 - この仮想環境に入る

conda activate aider_env - 以下のコマンドに従ってインストールする。

python -m pip install aider-chat

- 新しい conda 仮想環境を起動します (python 仮想環境も同じです)

3.2 Ollamaのセットアップと起動

- コマンドラインを起動し、以下のように環境変数を設定する。

export OLLAMA_API_BASE=http://127.0.0.1:11434 # Mac/Linux环境 setx OLLAMA_API_BASE http://127.0.0.1:11434 # Windows环境,设置以后重启shell工具 - cd してローカルリポジトリにアクセスしてください。そうでない場合、Aider は自動的にカレントディレクトリに git リポジトリを初期化します。

#example cd D:\Myfile\handy-ollama\handy-ollama\handy-ollama - 以下のコマンドでAiderを実行する。

aider --model ollama/<你的模型名字> #example #aider --model ollama/llama3:8bまた、.env ファイルを使用して Aider 情報を設定することもできます。

例えば## 指定OPENAI_KEY(如果有的话) OPENAI_API_KEY=xxx ## 指定你使用model AIDER_MODEL=ollama/llama3:8bその他のコンフィギュレーションhttps://aider.chat/docs/config/dotenv.html

- 次のページに入れば成功

- 彼とチャットしたり、コマンドを送ったりして、あなたのコードを直接修正することができる。

3.3 基本的な使い方

- このリポジトリに関する基本的な情報を尋ねることができます。

- ファイルの追加

/add <file1> <file2> ...そして、これらの書類に基づいていくつかの質問をすることができる。

- Aiderはファイルを追加することなく使用することができ、あなたの要求に基づいて編集が必要なファイルを見つけ出そうとします。(しかし、それはしばしば悪いことです)

- 特定のコードやファイルについて変更を加えたり、質問に答えたりするために、関連するファイルを追加する。(余分なファイルをたくさん追加しないでください。ファイルを追加しすぎると、生成の効率が悪くなり、コストが高くなります。 トークン ).

例

- Aiderを使用して、Readmeの最終行に要約を追加するなど、コードファイルやその他のファイルに直接変更を加えることができます。

実際の文書を見る

- Aiderに実際にファイルを操作させたくない場合は、ダイアログの前に演算子/askを付けることができます。

- dropで追加したファイルをすべて削除する

3.4 参考文献

よく使われるスラッシュ・コマンドのリスト:

| 命令 | 説明 |

|---|---|

/add | ファイルをチャットに追加し、GPTが編集や詳細なレビューができるようにする。 |

/ask | ファイルを編集することなく、コードベースに関する質問をすることができます。 |

/chat-mode | 新しいチャットモードに切り替える |

/clear | チャット履歴の消去 |

/clipboard | クリップボードから画像/テキストをチャットに追加 (オプションで画像に名前を付ける) |

/code | コードの変更を要求する |

/commit | チャット外で倉庫に編集を提出する(提出メッセージは任意) |

/diff | 前回のメッセージからの変更点の違いを表示します。 |

/drop | チャットセッションからファイルを削除してコンテキストの空き領域を確保する |

/exit | アプリケーションを終了する |

/git | gitコマンドを実行する |

/help | aiderについて質問する |

/lint | 提供されたファイルまたはチャット(ファイルが提供されていない場合)のコードチェックと修正 |

/ls | すべての既知のファイルを一覧表示し、どのファイルがチャットセッションに含まれているかを示します。 |

/map | 現在の倉庫情報を印刷する |

/map-refresh | 倉庫情報を強制的に更新し、印刷する。 |

/model | 新しい言語モデルへの切り替え |

/models | 利用可能なモデルのリストを検索 |

/quit | アプリケーションを終了する |

/read-only | チャットにファイルを追加。 |

/run | シェルコマンドを実行し、オプションで出力をチャットに追加する(エイリアス: !) |

/test | シェルコマンドを実行し、終了コードが0以外の場合にチャットに出力を追加する。 |

/tokens | チャットコンテキストで現在使用されているトークンの数を報告する。 |

/undo | 最後の git コミットが aider によって行われた場合、それを元に戻す |

/voice | 音声入力の録音と書き起こし |

/web | ウェブページをキャプチャし、マークダウンに変換してチャットに追加する |

詳しい使い方は https://aider.chat/docs/usage.html を参照。

IV.統合開発環境 RooClineアクセス(新規)

4.1 クラインとルークライン

クライン 世界で最もホットなvscode用AIプログラミングプラグインです。市場に出回っている多くのツールとは異なる方法でAI支援を利用する。コードの生成や補完だけに焦点を当てるのではなく、開発環境全体と対話できるシステムレベルのツールとして動作する。この機能は、リファレンスのClineセクションを見ればわかるように、複雑なデバッグ・シナリオや大規模なリファクタリング、統合テストを扱う場合に特に重要である。今日はRoo Clineを紹介します。

RooClineは、開発効率と柔軟性の向上に焦点を当てたClineの拡張バージョンです。複数の言語とモデル(Gemini、Metaなど)をサポートし、スマート通知、ファイル処理の最適化、コードの欠落検出などの機能を提供します。さらに、RooClineは、複数の作業を同時に行う必要がある開発者のために、Clineとの並列実行をサポートしています。

たとえ ルー・クライン まだクラインほどの規模ではないが、急速に成長している。クラインには実験的な機能がいくつか追加されており、わずかな人間の介入だけでコードの一部を自己記述することもできる。

また、クラインはトークンを大量に消費するため、多かれ少なかれ日々の開発コストに影響する。

4.2 VScodeへのRooClineのインストールとローカルOllamaの設定

[](https://github.com/datawhalechina/handy-ollama/blob/main/docs/C7/1.%20%E6%90%AD%E5%BB%BA%E6%9C%AC%E5%9C%B0%E7%9A%84%20AI%20Copilot%20%E7%BC%96%E7%A8%8B%E5%8A%A9%E6%89%8B.md#42-%E5%9C%A8-vscode-%E5%AE%89%E8%A3%85-roocline-%E4%BB%A5%E5%8F%8A%E9%85%8D%E7%BD%AE%E6%9C%AC%E5%9C%B0-ollama)- オッラマの設置モデル( ディープシークR1例えば1.5b)

ollama run deepseek-r1:1.5b - VScode プラグイン・ライブラリへのモデルのインストール

ルー・クラインを検索し、以下のアイコンを見つけたら、インストールまたはインストールをクリックする。

- コンフィギュレーション・オラマ

- 右側のルークラインアイコンをクリックしてください。

- 設定アイコンをクリック

- 入力モデル名

- 完了をクリック

- これでvscodeを他の統合エディター+aiのように使うことができる。

次に、ルー・クラインならではの特徴をいくつか取り上げる!

4.3 ルー・クラインの特徴

これらの機能は、特に制御システムレベルで適用される場合、特定の大規模なモデル機能に依存することに注意してください。この例のdeepseek-r1:1.5bは、以下のこれらの操作を実行する能力を持っておらず、複雑すぎることを報告します。にアクセスすることを推奨します。 ディープシーク apiアクセス(安い)。

以下の1~2の機能については、機能エリアのプロンプトアイコンをクリックして設定ページに入ります。

- 任意のAPI/モデルのサポート

- OpenRouter/Anthropic/Glama/OpenAI/Googleジェミニ/AWS Bedrock/Azure/GCP Vertex

- ネイティブモデル(LM Studio/Ollama)とOpenAI互換のインターフェース

- 異なるモデルを異なるパターンに使用することができる(例えば、アーキテクチャ設計にはハイレベルモデル、日々のコーディングにはエコノミーモデル)。

- セッションレベルの利用トラッキング(トークンの消費とコスト統計)

- カスタム・モード:モードによるカスタマイズ ルー・コード 役割、指示、権限:

- ビルトインモード

- コード モード:デフォルトの多機能コーディングアシスタント

- 建築家 パターン:システムレベルの設計とアーキテクチャ分析

- 尋ねる モデル:綿密な調査と質疑応答

- ユーザー作成モード

- カスタムロールを作成するには、「Create new mode for」と入力してください。

- 各モードは、独立したコマンドとスキルセットを持つことができます(「プロンプト」タブで管理)。

- 高度な機能

- ファイルタイプの制限(例:ask/architectモードではマークダウンのみ編集可能)

- カスタム・ファイル・ルール(例:.test.tsテスト・ファイルのみを操作する)

- モード間の切り替え(例:特定機能の自動コード化モード)

- 新しいモデルの自律的な作成(役割定義とファイル制限付き)

- ビルトインモード

- 粒度制御 ルークラインパーミッション

設定画面をクリックしてください:自動承認設定でルークラインパーミッションをコントロールすることができます。

これは、あなたの同意なしに自動的に実行されるアクションを制御することに注意してください。そうでない場合は、先に進む前に確認プロセスをクリックするよう求められます。

- ファイルとエディターの操作

- プロジェクトファイル作成・編集(差分比較表示)

- コードエラーへの自動対応(インポート漏れ、構文の問題など)

- エディタータイムラインによる変更の追跡(レビュー/ロールバックが容易)

- コマンドラインの統合

- パッケージ管理/ビルド/テストコマンド

- 出力を監視し、エラーに自動的に適応する

- 開発サーバーをバックグラウンドで継続稼動 承認ポリシーのサポート:定型業務の行単位確認/自動承認

- ブラウザ・オートメーション

3つ目のステップでは、ルー・クラインにウェブオートメーション機能を与えるために以下のオプションを選択します。

- ローカル/リモートWebアプリケーションの起動

- タップ/入力/スクロール/スクリーンショット操作

- ランタイムの問題をデバッグするためのコンソールログの収集 エンドツーエンドのテストと視覚的検証のため

- エムシーピー ツール・エクステンション

モデル・コンテキスト・プロトコル (MCP)はRooの機能拡張プロトコルで、Rooが追加のツールやリソースを提供するローカルサーバーと通信できるようにするものです。これは、プログラミング・アシスタントに「外部の頭脳」を搭載することに相当する。

ローカル/クラウドのデュアルモード:コンピュータのローカルツールやサービスを使用できるだけでなく、コミュニティに接続して既製のモジュールを共有することもできる。

ツールを動的に作成する:Rooに「最新のnpmドキュメントを検索するツールを作って」と指示するだけで、ドッキングコードを自動的に生成してくれる。

例を挙げよう:- 地域資源を拾う:他人が作った車輪を使う

例えば、既存の "Weather API Query Tool "にアクセスする。

オープンソースコミュニティによって検証されたツールの直接使用 - 自作プライベートツール:ビジネスニーズに合わせてカスタマイズ可能

社内のログを取得するツールを作ってください。

ルーは自動的に生成される:# 示例自动生成的工具框架 class LogTool(MCPPlugin): def fetch_logs(self, service_name): # 自动对接公司日志系统 # 返回最近1小时的关键错误日志 ...審査を通過すると、そのツールはルーのスキルリストに表示される!

- セキュリティ・メカニズム: 機密性の高いインターフェイスへのランダムな呼び出しを防ぐため、新しいツールはすべて、起動前に手動で確認し、承認する必要がある。

- 地域資源を拾う:他人が作った車輪を使う

- Context@:追加の文脈を提供する方法:

@file埋め込み文書コンテンツ@folder完全なカタログ構造を含む@problemsワークスペースのエラー/警告の導入@urlURLドキュメントの取得(マークダウンへ)@gitGit のコミットログ/不一致分析を提供し、重要な情報に焦点を当て、トークンの使用を最適化します。

参考文献(推薦図書)

ルー・クラインのgithubアドレス: https://github.com/RooVetGit/Roo-Code 現在、以下のアドレスに変更されている。 ルー・コードさらなる新機能を発見してください!

クラインの紹介:Cline (Claude Dev): 自動プログラミングのためのVSCodeプラグイン

AIプログラミングツールの比較:Trae、Cursor、Windsurf AIプログラミングツールの比較

AIプログラミングツールを使って、コードを一行も書かずにAIサービスのウェブサイトをゼロから完成させる https://cloud.tencent.com/developer/article/2479975

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません