Ollamaのインストールと設定 - dockerの記事

簡単

このセクションでは、Docker.comを完了する方法について説明します。 オーラマ のインストールと設定

Dockerはイメージに基づく仮想化コンテナ技術で、さまざまなコンテナを数秒で起動できる。これらのコンテナはそれぞれ、コンテナ間の分離を可能にする完全な実行環境である。

Ollama ダウンロード: https://ollama.com/download

Ollama公式ホームページ:https://ollama.com

Ollama公式GitHubソースコードリポジトリ: https://github.com/ollama/ollama/

公式ドッカー・インストール・チュートリアル:https://hub.docker.com/r/ollama/ollama

I. オラマ鏡を引く

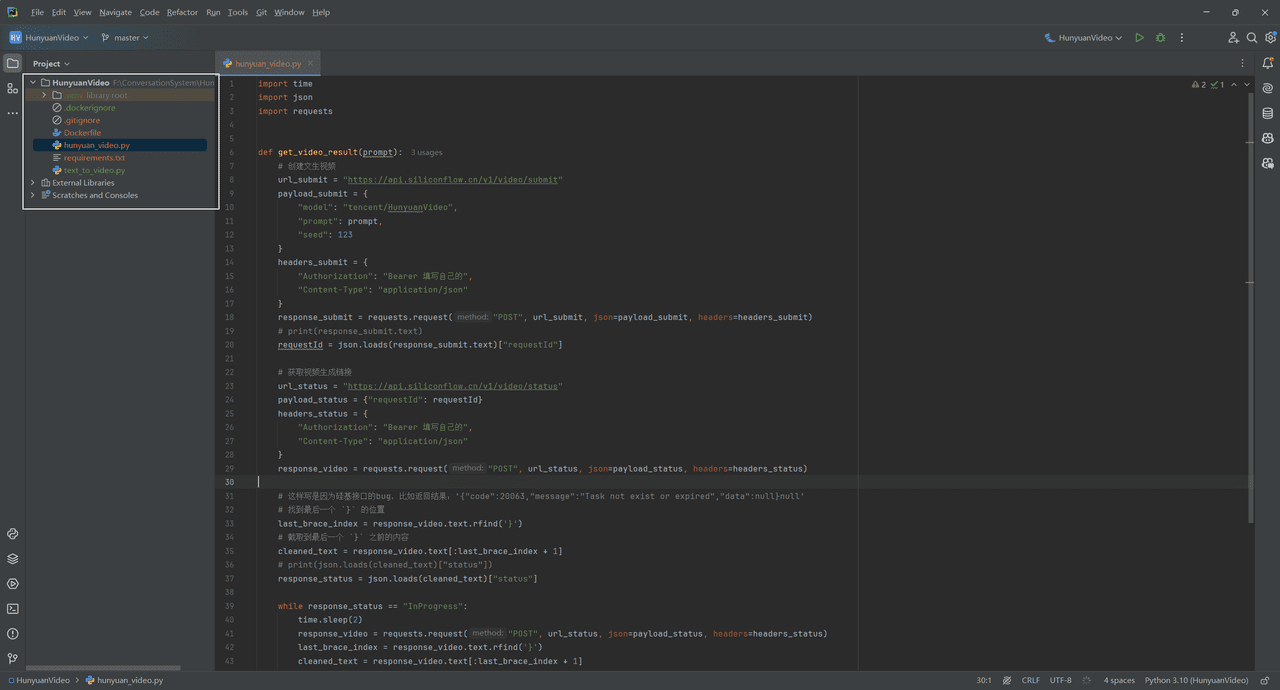

筆者はあらかじめWindows上でdockerをダウンロードしておいた。ドッカーインストールダウンロード公式サイト

方法1:可視化インターフェースでのDockerソフトウェアの検索とダウンロード

方法2:公式サイトでは、以下のコマンドで直接ダウンロードイメージを取り込むことを推奨している。

# CPU 或者 Nvidia GPU

docker pull ollama/ollama

# AMD GPU

docker pull ollama/ollama:rocm

注:読者が実行環境を指定した特定のバージョンのイメージを使用したい場合は、以下のコマンドを使用することができる。

# CPU 或 Nvidia GPU下载ollama 0.3.0

docker pull ollama/ollama:0.3.0

# AMD GPU下载ollama 0.3.0

docker pull ollama/ollama:0.3.0-rocm

II. ollamaイメージの実行

方法1:Dockerはビジュアル・インターフェースでイメージを実行する。

- ダウンロードが完了すると

Images正鵠を得るOllamaミラー、クリックrun実行する前に、オプション設定のポップアップでポート番号(例えば8089)を選択することに注意してください。

- ある

Containersで画像を探す。OLLMOllamaインターフェースへのアクセス

- で、インストールが完了したことを確認する。

Execで入る:

ollama -h

インストールが成功したことを意味します🎉。

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

- ターミナル・ユース・オラマ

以下はOllamaが使用する一般的なコマンドである:

ollama serve #启动ollama

ollama create #从模型文件创建模型

ollama show #显示模型信息

ollama run #运行模型

ollama pull #从注册表中拉取模型

ollama push #将模型推送到注册表

ollama list #列出模型

ollama cp #复制模型

ollama rm #删除模型

ollama help #获取有关任何命令的帮助信息

ライブラリ (ollama.com) ここにはOllamaのモデルライブラリがあります。お望みのモデルを検索して直接起動してください!

ollama run llama3

ダウンロード速度は帯域幅に依存し、すぐに使用できます。

control + D終了チャット

方法2:コマンドライン起動

- CPUバージョン:

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません