Ollamaのインストールと設定 - Windowsシステム

簡単

このセクションでは、Windowsシステムでこれを行う方法について説明します。 オーラマ インストールと設定は以下のセクションに分かれています。

- 公式サイトで直接ダウンロード

- 環境変数の設定

- ラン・オラマ

- インストールが成功したことを確認する

I. 公式ウェブサイトにアクセスし、直接ダウンロードを完了する。

- 公式ホームページへ

Ollama ダウンロード: https://ollama.com/download

Ollama公式ホームページ:https://ollama.com

Ollama公式GitHubソースコードリポジトリ: https://github.com/ollama/ollama/

- ブラウザがOllamaSetup.exeファイルをダウンロードするのを待ちます。ダウンロードが完了したら、ファイルをダブルクリックします。

Installダウンロードが完了するまで待つだけだ。

- インストールが完了すると、デフォルトでOllamaが起動していることが確認できます。下のナビゲーション・バーにOllamaのロゴがあるので、それを右クリックしてください。

Quit Ollamaオラマを出るか、見るかlogs.

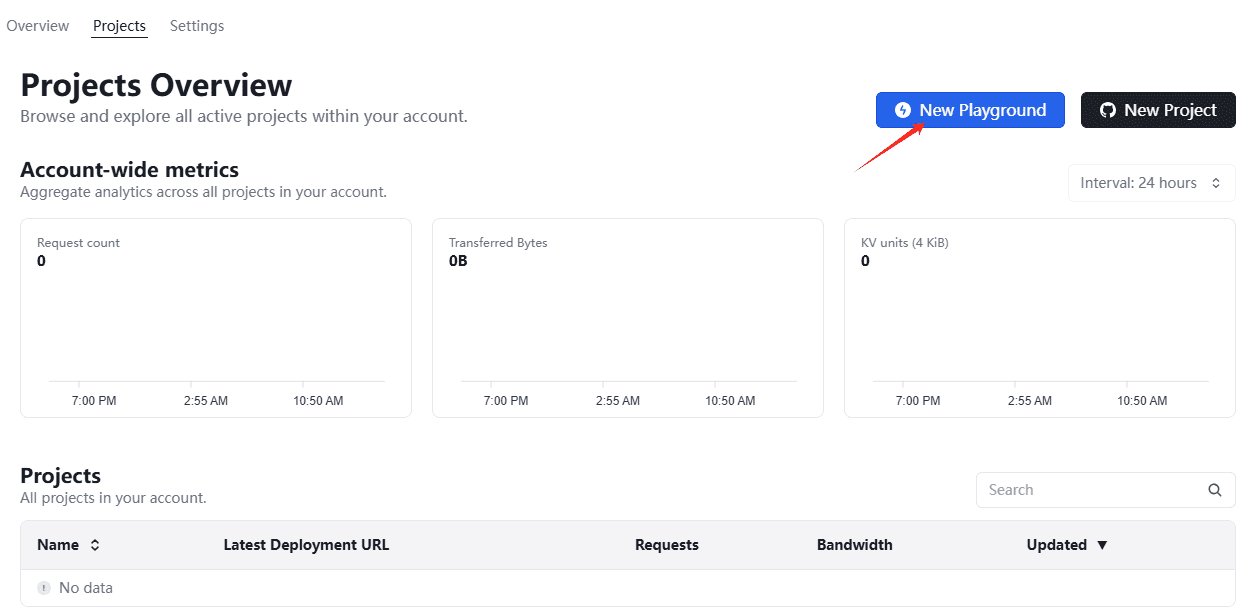

環境変数の設定

オーラマOllamaは他のソフトウェアと同様にワンクリックでコンピュータにインストールできますが、実際のニーズに応じてシステム環境変数を設定することをお勧めします。以下は、Ollamaの環境変数の設定方法です。

| パラメトリック | ラベリングと設定 |

|---|---|

| OLLAMA_MODELS | モデルファイルが保存されているディレクトリを示します。現在のユーザーディレクトリ務めるC:\Users%username%.ollama\modelsWindowsシステム Cドライブに置くことはお勧めしません。 ディスクは他のディスク(例えば E:\ollama\models) |

| OLLAMA_HOST | はollamaサービスがリッスンするネットワークアドレスで、デフォルトは127.0.0.1 他のコンピュータ(LAN上の他のコンピュータなど)からOllamaへのアクセスを許可したい場合は推奨設定大丈夫 0.0.0.0 |

| OLLAMA_PORT | ollamaサービスがリッスンするデフォルトのポートを示す。11434 ポートの競合がある場合は、他のポートに設定を変更することができる(例えば、以下のように)。8080など) |

| OLLAMA_ORIGINS | HTTPクライアントからのリクエストの送信元を示す。リストの区切りにはハーフカンマを使用する。 * |

| ollama_keep_alive | ラージモデルがメモリにロードされた後の生存時間を示す。5mすなわち、5分(例えば、プレーンな数字300は300秒を意味し、0はリクエストに対する応答が処理されると同時にモデルがアンインストールされることを意味し、マイナスの数字はモデルが常に生きていることを意味する)に設定することが推奨される。 24h このモデルは24時間メモリに残るため、アクセス速度が向上する。 |

| ollama_num_parallel | 同時に処理されるリクエスト数を示す。1(すなわち、リクエストの単一同時シリアル処理) 実際のニーズに合わせて調整された推奨事項 |

| ollama_max_queue | リクエストキューの長さを示す。512キュー長を超えるリクエストは破棄されます。 |

| OLLAMA_DEBUG | はデバッグ・ログの出力を表します。1(トラブルシューティングのための詳細なログ情報を出力する)。 |

| ollama_max_loaded_models | 同時にメモリにロードされるモデルの最大数を示す。1(つまり、1つのモデルしかメモリーできない) |

初心者の方には、以下のように設定することを強くお勧めします。 OLLAMA_MODELS をクリックしてモデルの保存場所を変更します。 デフォルトでは、OllamaのモデルはCドライブのユーザーディレクトリの .ollama/models フォルダはCドライブのスペースを占有しています。 このフォルダを別のパーティションに変更することで、ストレージをより適切に管理できるようになります。

ステップ1:システム環境変数を設定するエントリーポイントを探す。

方法1:スタート->設定->詳細システム設定->システムのプロパティ->環境変数。

方法2:このコンピュータ -> 右クリック -> プロパティ -> 詳細システム設定 -> 環境変数。

方法3:スタート->コントロールパネル->システムとセキュリティ->システム->システムの詳細設定->システムのプロパティ->環境変数。

方法4:Win+Rで「ファイル名を指定して実行」ウィンドウを開き、次のように入力します。 sysdm.cplこのオプションを使いたい場合は、「システムのプロパティ」を開き、「詳細設定」タブを選択し、「環境変数」をクリックします。

ステップ2:セットアップ OLLAMA_MODELS 環境変数(モデルの保存場所を変更する)

- で " 環境変数 " ウィンドウズ " システム変数(S) "エリア(ニーズによっては "ユーザー変数(U) "エリア)をクリックし、" 新しい(W)... 「ボタンをクリックする。

- で " 変数名(N) "入力ボックスに入力する:

OLLAMA_MODELS(大文字と小文字に注意、すべて大文字を推奨)。 - で " 変動値(V) "入力ボックスに、設定したいモデルの保存パスを入力します。 例えば、Eドライブのモデルを

ollama\modelsフォルダに「変数値(V)」を入力することができます:E:\ollama\models(ディスクレターとフォルダーパスは実際の状況に応じて変更してください)。- 注目してほしい: パスを入力してください。 すでに存在するフォルダ または 作成したいフォルダの親ディレクトリが存在する。 . Ollamaは、初回実行時に自動的に作成される場合があります。

modelsフォルダを作成することをお勧めする。ollamaフォルダに移動し、パスが正しいことを確認する。 - 例 Eドライブにモデルを保存するには

ollama\modelsフォルダの「変数値(V)」に入力できます:E:\ollama\models

- 注目してほしい: パスを入力してください。 すでに存在するフォルダ または 作成したいフォルダの親ディレクトリが存在する。 . Ollamaは、初回実行時に自動的に作成される場合があります。

- クリック " 定義する 「ボタン、クローズ" 新しいシステム変数 "(または "New User Variable")ウィンドウを開きます。

注目してほしい: 設定方法がわからない場合

OLLAMA_MODELS環境変数については、以下の例を参照されたい。

(オプション)設定 OLLAMA_HOST 環境変数(リスニング・アドレスを変更する)。

Ollama サービスに LAN 上の他のデバイスからアクセスできるようにするには、次のように設定します。 OLLAMA_HOST 環境変数。

- また、" 環境変数 " ウィンドウズ " システム変数(S) "エリア(または "ユーザー変数(U) "エリア)で、" 新しい(W)... 「ボタンをクリックする。

- で " 変数名(N) "入力ボックスに入力する:

OLLAMA_HOST - で " 変動値(V) 「入力ボックスに

0.0.0.0:11434(デフォルトは11434)。0.0.0.0LANアクセスを許可するために、すべてのネットワーク・インタフェースをリッスンしていることを示す。11434はOllamaのデフォルト・ポートである。- 例

0.0.0.0:11434

- クリック " 定義する 「ボタン、クローズ" 新しいシステム変数 "(または "New User Variable")ウィンドウを開きます。

ステップ 3: Ollama または PowerShell を再起動して、環境変数を有効にする。

環境変数が設定されたら、次の作業が必要だ。 Ollamaサービスの再起動 または コマンドプロンプト(CMD)またはPowerShellウィンドウを再起動します。 新しい環境変数を有効にする。

- Ollamaサービスを再起動する。 もし

ollama serve事前Ctrl + C停止して再実行ollama serve. - コマンドプロンプト/PowerShellを再起動します。 開いているウィンドウをすべて閉じ、新しいウィンドウを開き直す。

ステップ4:環境変数が有効であることを確認する

- 再オープン コマンドプロンプト(CMD) または パワーシェル .

- 糺す

OLLAMA_MODELS: 以下のコマンドを入力し、エンターキーを押す:

echo %OLLAMA_MODELS%

出力:

E:\ollama\models(を設定する。E:\ollama\models)

III.ランニング・オラマ

- コマンドライン文の起動

ollama serve

Ollamaを起動すると、以下のエラーが発生します。 デフォルトの起動 属オーラマ サービスのデフォルトは http://127.0.0.1:11434 です。

Error: listen tcp 127.0.0.1:11434: bind: Only one usage of each socket address (protocol/network address/port) is normally permitted.

- 解決策

- (ショートカットキー

Win+Xタスクマネージャーを開き启动以下は、Ollamaを無効にする方法の例である。コースオッラマのミッションはその年の半ばに終了した。

- 再利用

ollama serveオープン・オーラマ

- 正常に起動したことを確認する:

- (ショートカットキー

Win+Rインプットcmdコマンドライン・ターミナルを開く。 - 輸入

netstat -aon|findstr 11434ポート11434を占有するプロセスを表示する。

netstat -aon|findstr 11434

出力:

TCP 127.0.0.1:11434 0.0.0.0:0 LISTENING 17556ポート11434がプロセス17556によって占有されていることを示す。

- プロセスが実行されているかどうかをチェックすると、Ollamaがスタートしていることがわかる。

tasklist|findstr "17556"

出力は以下の通り:

ollama.exe 17556 Console 1 31,856 K

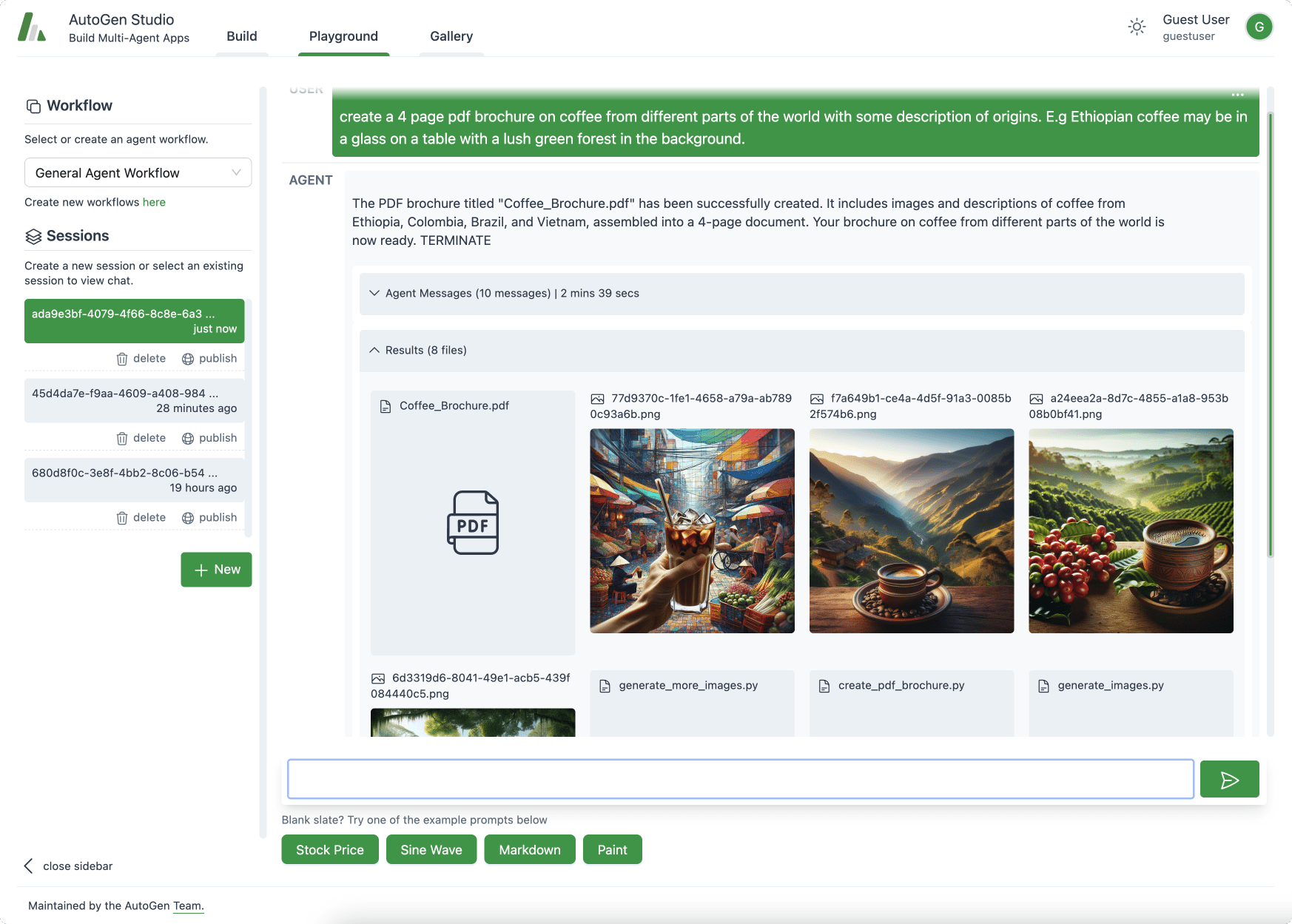

IV.インストールが成功したことを確認する

- 端子入力:

ollama -h

インストールが成功したことを意味します🎉。

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

- オッラマのターミナル使用。

図書館 ここにollamaのモデルライブラリがあります。お望みのモデルを検索して、すぐに起動してください!

ollama run llama3

ダウンロード速度は帯域幅に依存し、すぐに使用できます。

control + D終了チャット

第五に、ブートをキャンセルする方法

(2024-08-19現在) 現在、OllamaはWindows上でデフォルトで起動しますが、起動する必要がない場合は、以下の手順で解除することができます。

タスクマネージャーを開き 启动应用探す ollama.exe 右クリック 禁用 準備はできている。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません