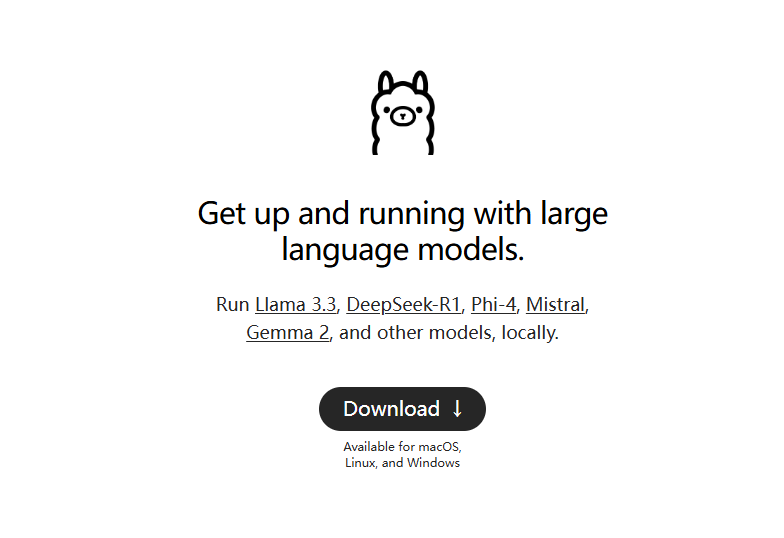

Ollama:オープンソースのビッグ言語モデルをワンクリックでネイティブ導入

オッラマの紹介

ollamaはネイティブ言語モデルを実行するための軽量フレームワークで、大規模な言語モデルを簡単に構築し、実行することができます。複数のクイック・スタートとインストール・オプションを提供し、Dockerをサポートし、ユーザーが選択できる豊富なライブラリ・セットを含んでいます。使いやすく、REST APIを提供し、コミュニティと統合する様々なプラグインや拡張機能を備えています。

ollamaはパーソナルコンピュータ用の純粋なコマンドラインツールで、Open WebUI、Lobe Chat、NextChatのようなローカルチャットインターフェースのデプロイにお勧めします。

デフォルトのインストール・ディレクトリを変更する: https://github.com/ollama/ollama/issues/2859

Ollama機能リスト

大規模言語モデルの迅速な立ち上げと実行

macOS、Windows、Linuxシステムをサポート

ollama-python、ollama-jsなどのライブラリを提供。

ラマ2を含む。 ミストラルジェンマ他、事前構成モデル

ローカルとDockerの両方のインストールに対応

カスタマイズされたモデル機能を提供する

GGUFとPyTorchからのモデル変換のサポート

CLI操作ガイドの提供

REST API サポートの提供

よく使われるollamaコマンド

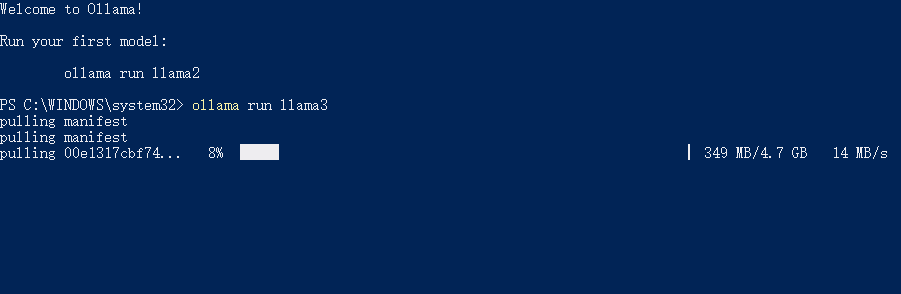

プルモデル: ollama pull llama3.1

実行モデル: llama run llama3.1

削除モデル: llama rm llama3.1

利用可能なすべてのモデルをリストアップ: ollama list

クエリ API サービスアドレス: ollama serve (デフォルト http://localhost:11434/)

Ollamaヘルプ

インストールスクリプトとガイドは、ollamaのウェブサイトとGitHubページから入手できます。

提供されたDockerイメージを使用したインストール

CLI操作によるモデルの作成、引き出し、削除、コピー

ローカルビルドの初期化と実行

モデルの実行と対話

Ollamaがサポートしているモデルの一部

| モデル | パラメータ | サイズ | ダウンロード |

|---|---|---|---|

| ラマ2 | 7B | 3.8GB | ollama run llama2 |

| ミストラル | 7B | 4.1GB | ollama run mistral |

| ドルフィン・ファイ | 2.7B | 1.6GB | ollama run dolphin-phi |

| ファイ2 | 2.7B | 1.7GB | ollama run phi |

| ニューラル・チャット | 7B | 4.1GB | ollama run neural-chat |

| スターリング | 7B | 4.1GB | ollama run starling-lm |

| コード・ラマ | 7B | 3.8GB | ollama run codellama |

| ラマ2無修正 | 7B | 3.8GB | ollama run llama2-uncensored |

| ラマ2 13B | 13B | 7.3GB | ollama run llama2:13b |

| ラマ2 70B | 70B | 39GB | ollama run llama2:70b |

| オルカ・ミニ | 3B | 1.9GB | ollama run orca-mini |

| ビキューナ | 7B | 3.8GB | ollama run vicuna |

| LLaVA | 7B | 4.5GB | ollama run llava |

| ジェマ | 2B | 1.4GB | ollama run gemma:2b |

| ジェマ | 7B | 4.8GB | ollama run gemma:7b |

Ollama ダウンロード

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません