MOFAビデオ:静止画を動画に変換するモーション・フィールド・アダプテーション技術

はじめに

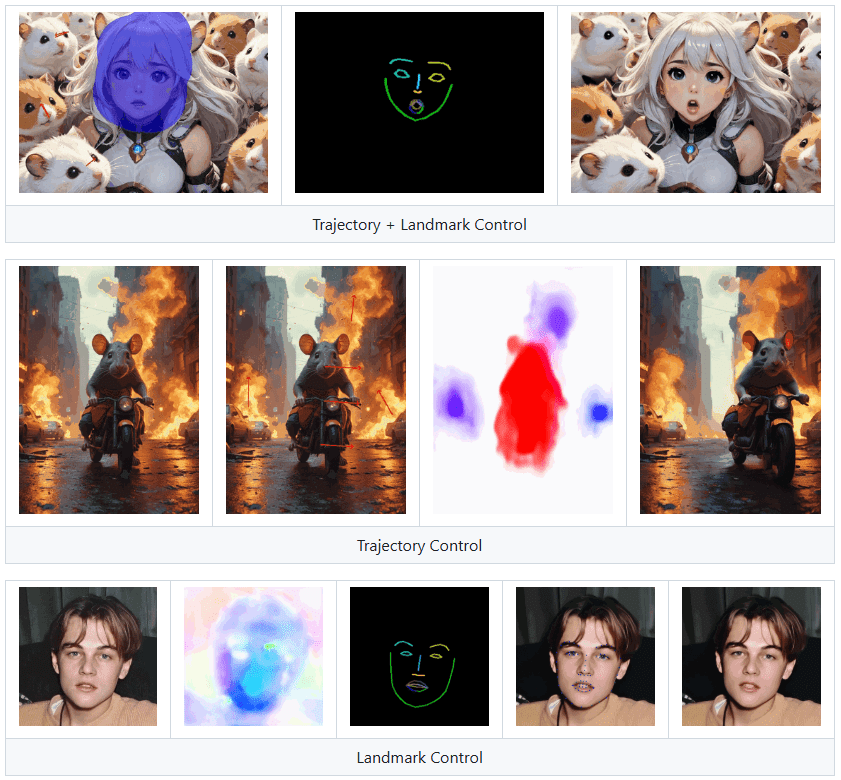

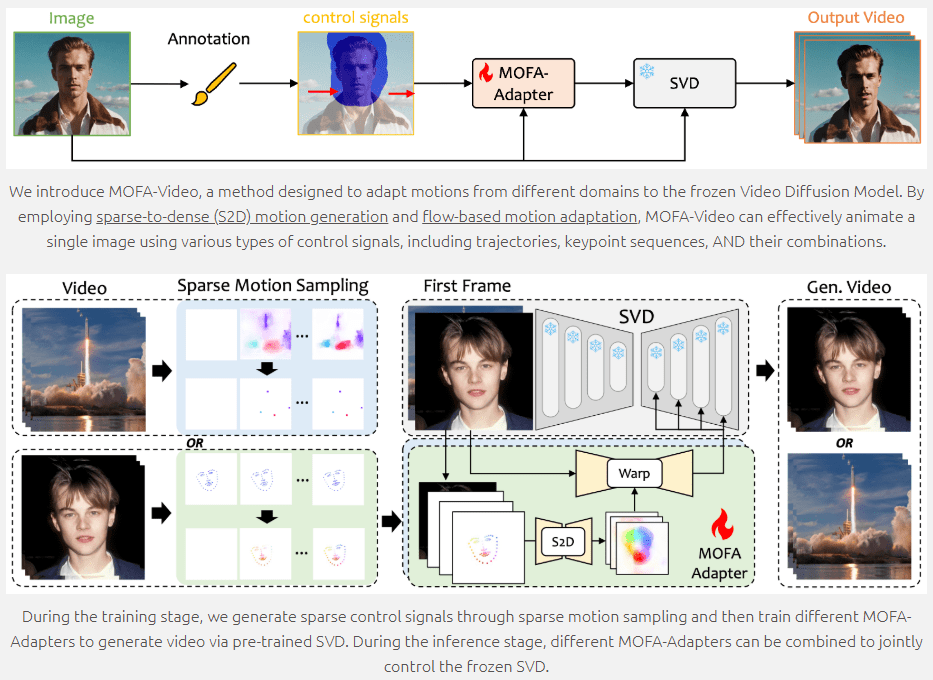

MOFA-Videoは、生成的な動き場適応技術を用いて静止画像を動的な動画に変換する最先端の画像アニメーション生成ツールです。東京大学とTencent AI Labとの共同開発で、ECCV 2024で発表される。MOFA-Videoは、軌跡、キーポイントシーケンス、およびそれらの組み合わせを含む様々な制御信号をサポートし、高品質の画像アニメーションを可能にする。ユーザーはGitHubリポジトリからコードや関連リソースにアクセスし、簡単に使い始めることができる。

ランドマーク・コントロールは、画像の中の人物をしゃべらせることはできるが、デジタル人物のクローンとしての使用には適していない。

機能一覧

- 画像アニメーション生成:静止画像を動画に変換

- 複数の制御信号:軌道、キーポイント・シーケンス、およびそれらの組み合わせをサポート

- モーション・フィールドの適応:疎から密へのモーション生成とフローベースのモーション適応によるアニメーション

- トレーニングおよび推論スクリプト:トレーニングと推論のための完全なコードを提供する。

- グラディオ・デモ:オンライン・デモとチェックポイントのダウンロード

- オープンソース:コードとリソースをGitHubで公開する。

ヘルプの使用

環境設定

- クローン倉庫

git clone https://github.com/MyNiuuu/MOFA-Video.git

cd ./MOFA-Video

- Conda環境の作成と有効化

conda create -n mofa python==3.10

conda activate mofa

- 依存関係のインストール

pip install -r requirements.txt

pip install opencv-python-headless

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

- チェックポイントのダウンロード HuggingFaceのリポジトリからチェックポイントをダウンロードし、それを

./MOFA-Video-Hybrid/models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpointsカタログ

グラディオを使ったデモ

- 音声を使って顔のアニメーションを動かす

cd ./MOFA-Video-Hybrid

python run_gradio_audio_driven.py

- 参考ビデオを使ったフェイシャル・アニメーションのドライブ

cd ./MOFA-Video-Hybrid

python run_gradio_video_driven.py

Gradioのインターフェイスに関連する指示が表示されますので、インターフェイスの指示に従って推論操作を行ってください。

トレーニングと推論

MOFA-Videoは完全なトレーニングと推論スクリプトを提供し、必要に応じてカスタマイズすることができます。詳細な手順については、GitHubリポジトリのREADMEファイルを参照してください。

主な機能

- 画像アニメーション生成:静止画像をアップロードし、制御信号(軌跡、キーポイントシーケンス、またはそれらの組み合わせ)を選択し、ダイナミックビデオを生成するために生成ボタンをクリックします。

- 複数の制御信号:ユーザーは、より豊かなアニメーション効果を達成するために、制御信号の異なる組み合わせを選択することができます。

- モーションフィールドの適応:疎から密へのモーション生成とフローベースのモーション適応技術により、スムーズで自然なアニメーション効果を確保。

MOFA-Videoは、豊富な機能と詳細な手順を提供し、ユーザーが必要に応じて画像アニメーションを生成したり、トレーニングをカスタマイズしたり、簡単に高品質の画像アニメーション効果を実現することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません