Model Context Provider CLI: クロードに依存しない、あらゆる大規模モデルでMCPサービスを使用するためのコマンドラインツール。

はじめに

モデルコンテキストプロバイダCLI(mcp-cli)は、モデルコンテキストプロバイダサーバとやりとりするためのプロトコルレベルのコマンドラインツールです。mcp-cliはOpenAIとOllamaを含むいくつかのプロバイダーとモデルをサポートしており、デフォルトのモデルはそれぞれgpt-4o-miniとqwen2.5-coderです。 このツールにはPython 3.8以上と適切な依存関係が必要です。GitHubのリポジトリをクローンし、必要な依存関係をインストールすることでツールを使用できる。

機能一覧

- モデルコンテキスト・プロビジョニング・サーバーとのプロトコルレベルの通信のサポート

- ダイナミックなツールとリソース

- 複数のプロバイダーとモデルをサポート(OpenAIとOllama)

- ユーザーが動的にコマンドを実行できるインタラクティブ・モードを提供する。

- 対応コマンド:ping、list-tools、list-resources、list-prompts、chat、clear、help、quit/exit

- サポートされているコマンドラインパラメータは次のとおり:-server、-config-file、-provider、-model。

ヘルプの使用

設置プロセス

- クローン倉庫

git clone https://github.com/chrishayuk/mcp-cli

cd mcp-cli

- UVをインストールする:

pip install uv

- 依存関係を同期させる:

uv sync --reinstall

使用方法

- クライアントを起動し、SQLiteサーバと対話します:

uv run main.py --server sqlite

- デフォルトの OpenAI プロバイダとモデルでクライアントを実行します:

uv run main.py --server sqlite

- 特定のコンフィギュレーションと オーラマ プロバイダーはクライアントを運営する:

uv run main.py --server sqlite --provider ollama --model llama3.2

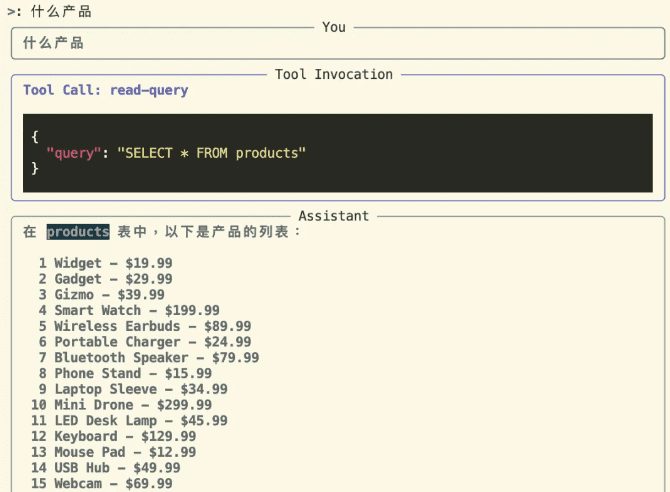

対話モード

インタラクティブモードに入り、サーバーと対話する:

uv run main.py --server sqlite

対話モードでは、ツールを使用してサーバーと対話することができます。起動時に指定されたプロバイダとモデルは、以下のように表示されます:

Entering chat mode using provider 'ollama' and model 'llama3.2'...

対応コマンド

pingサーバーが応答しているかチェックするlist-tools利用可能なツールを表示list-resources利用可能なリソースを表示list-prompts利用可能なヒントを表示chatインタラクティブチャットモードclear端末画面を消去するhelp対応コマンドの一覧を表示します。quit/exitクライアント終了

OpenAIプロバイダーの利用

OpenAIのモデルを使用したい場合は、次のように設定します。 OPENAI_API_KEY 環境変数は .env ファイルまたは環境変数として設定する。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません