ミストラル、オープンソースのミストラル・スモール3をリリース:性能はGPT-4oに匹敵し、ラマ3を上回る

ミストラル スモール3:Apache 2.0プロトコル、81% MMLU、150トークン/秒。

本日、ミストラルAIは、レイテンシーを最適化した240億パラメータモデルのミストラル・スモール3を発表し、Apache 2.0プロトコルの下でリリースした。

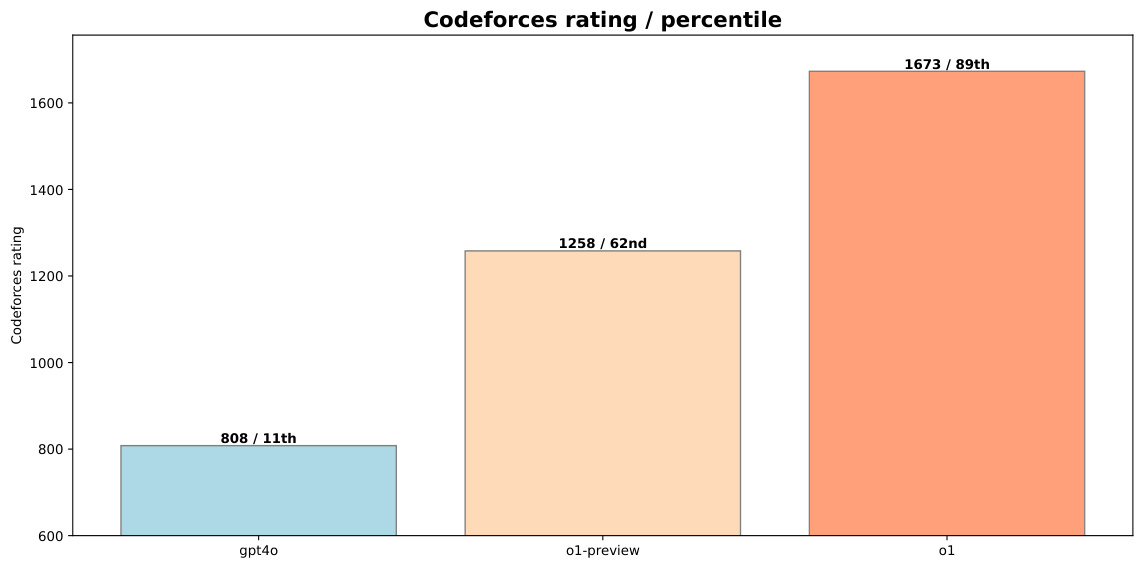

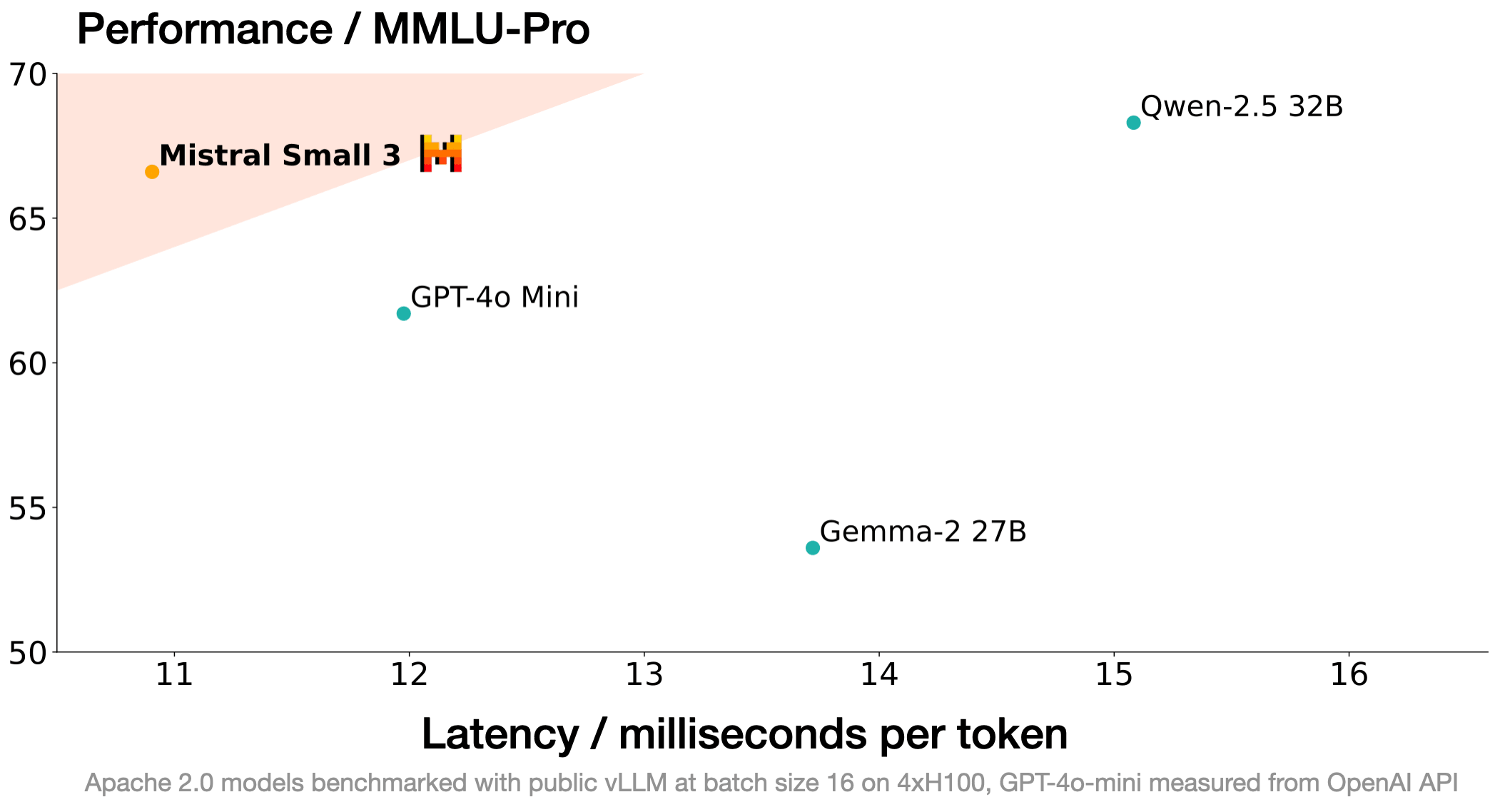

Mistral Small 3は、Llama 3.3 70BやQwen 32Bのような大型モデルに匹敵し、GPT4o-miniのような不透明なプロプライエタリモデルに代わる優れたオープンソースです。Mistral Small 3はLlama 3.3 70Bのインストラクターに匹敵しますが、同じハードウェア上では3倍以上高速です。

ミストラル・スモール3は、強力な言語能力と非常に低いレイテンシーでの命令順守性能を必要とする生成AIタスクにおいて、「80%」のニーズを満たすように設計された、事前に訓練され、命令を微調整したモデルである。

ミストラルAI この新しいモデルは、ローカル展開に適した規模で性能を飽和させるように設計された。特に、Mistral Small 3は、競合モデルよりもはるかに少ないレイヤーを持ち、1回の前方伝播にかかる時間を大幅に短縮しています。81%を超えるMMLU精度と150トークン/秒のレイテンシを持つMistral Smallは、この種のモデルとしてはこれまでで最も効率的なモデルです。

Mistral AIは、Apache 2.0プロトコルの下、事前トレーニングと命令の微調整チェックポイントを公開しています。これらのチェックポイントは、進歩を加速させる強力な基礎となる。Mistral Small 3は、強化学習(RL)も合成データも使用せずに学習されるため、モデル作成プロセスにおいて ディープシーク R1(素晴らしい補完的なオープンソース技術です!)。Mistral AIは、オープンソースコミュニティがどのようにこれを採用し、カスタマイズするかを楽しみにしています。Mistral AIは、オープンソースコミュニティがこれをどのように採用し、カスタマイズしていくかを楽しみにしています。

パフォーマンス

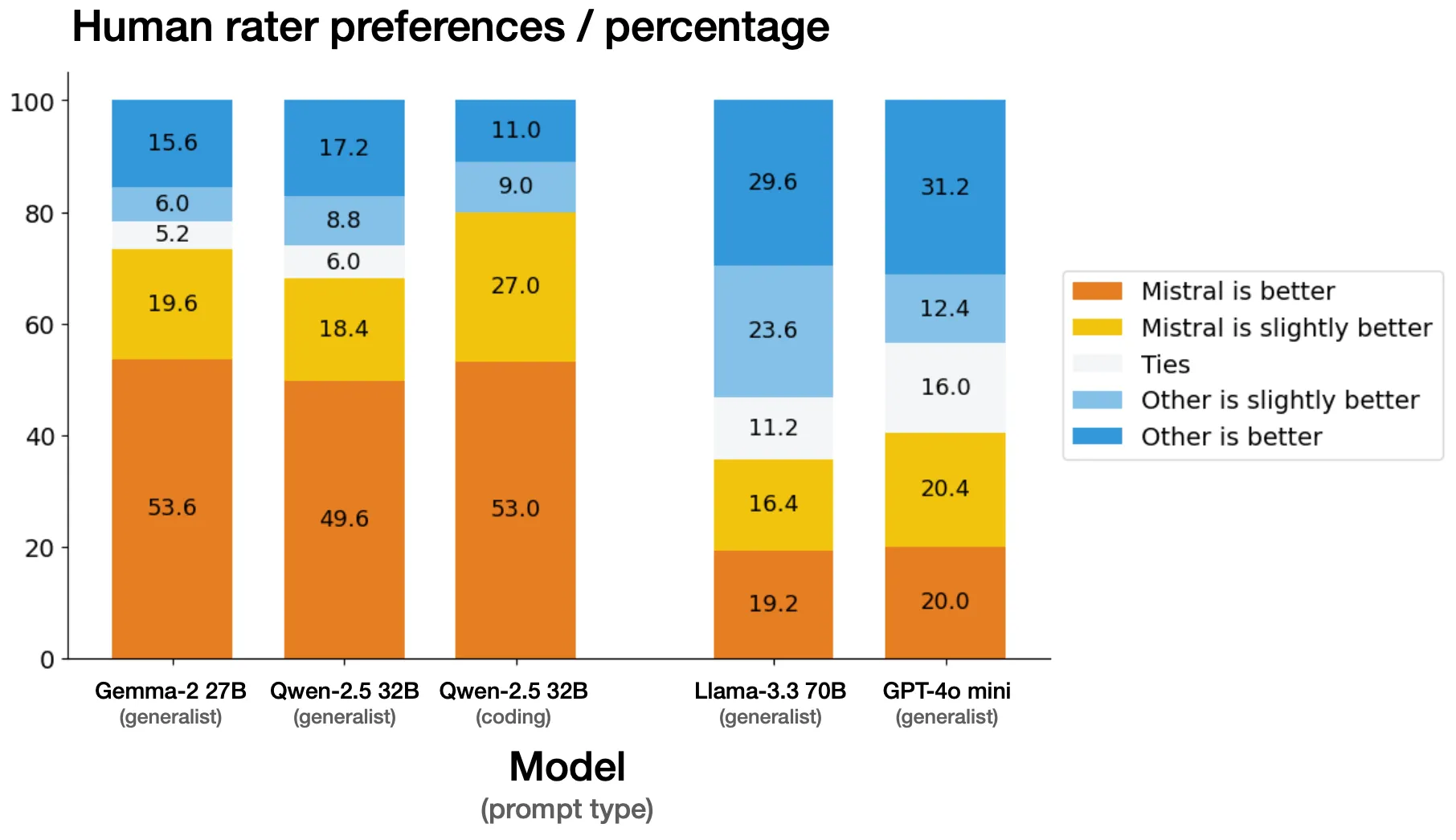

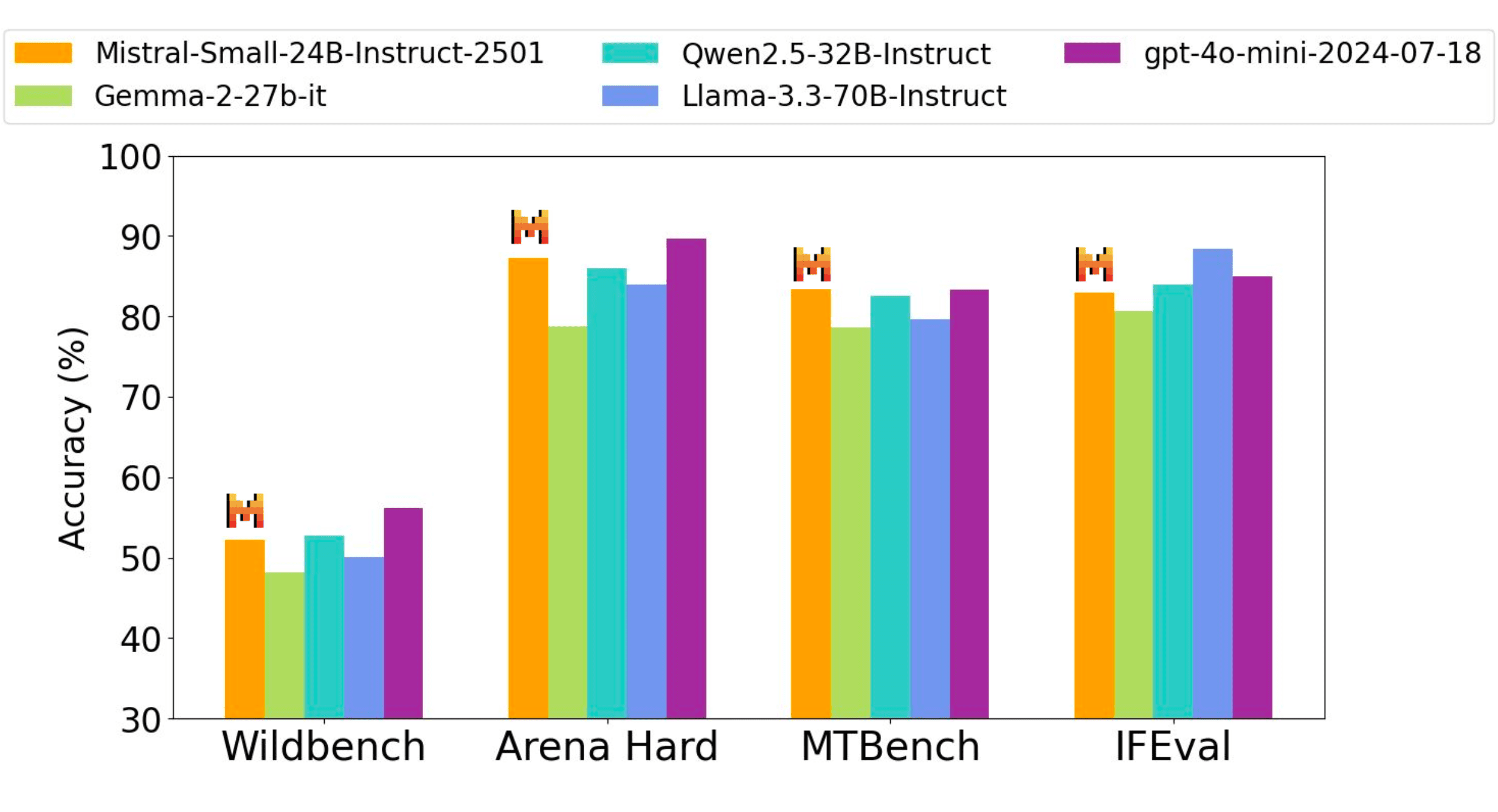

手動評価

Mistral AIは、1,000を超える独自のコードと一般的なキューを、外部のサードパーティベンダーと並べて評価しました。評価者は、Mistral Small 3によって生成された匿名化された結果と、別のモデルとの比較から、好みのモデルの応答を選択することになりました。Mistral AIは、人間の判断によるベンチマークが、公開されているベンチマークと大きく異なる場合があることを認識していますが、Mistral AIは評価の公平性を検証するために細心の注意を払っています。有効であると確信しています。

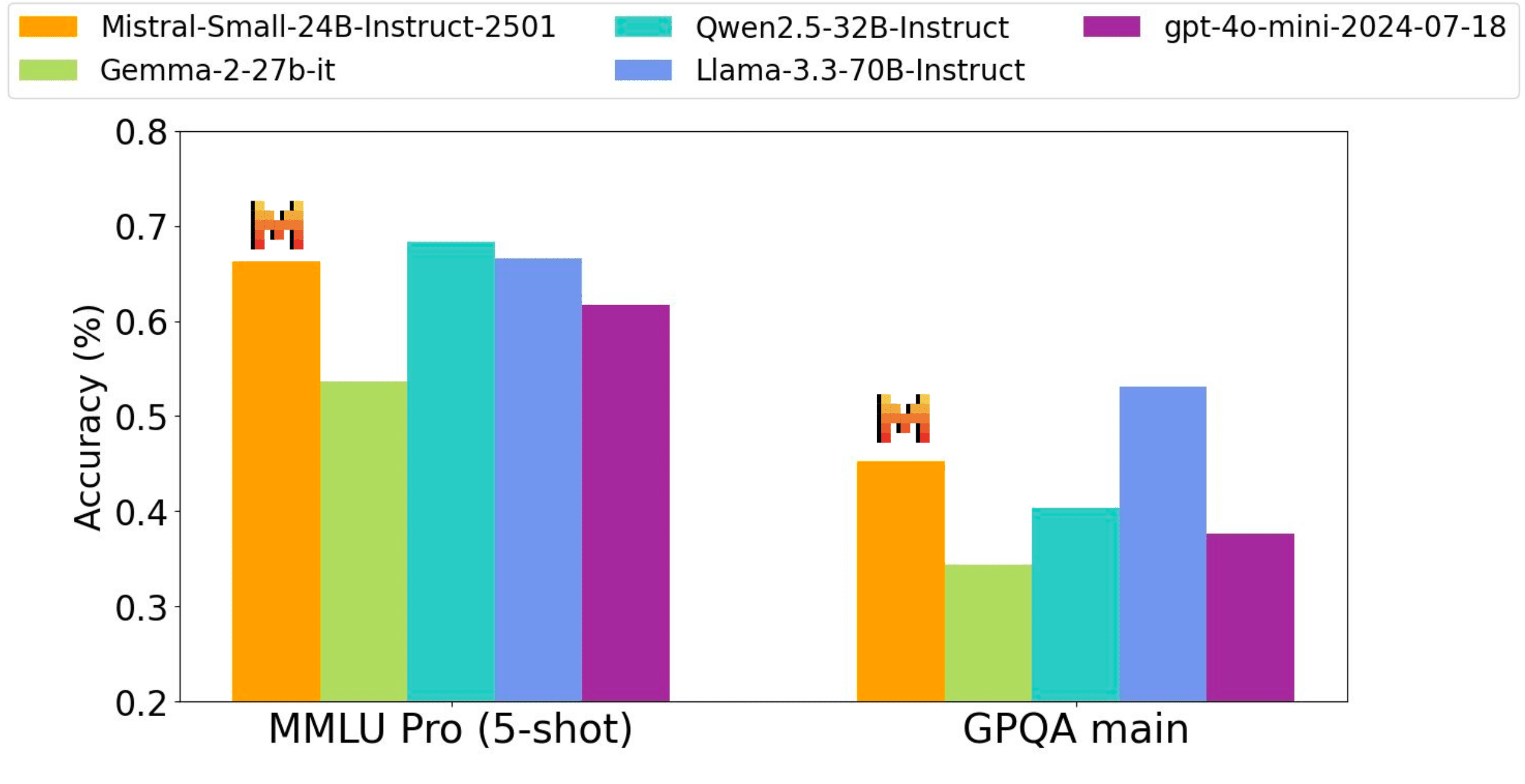

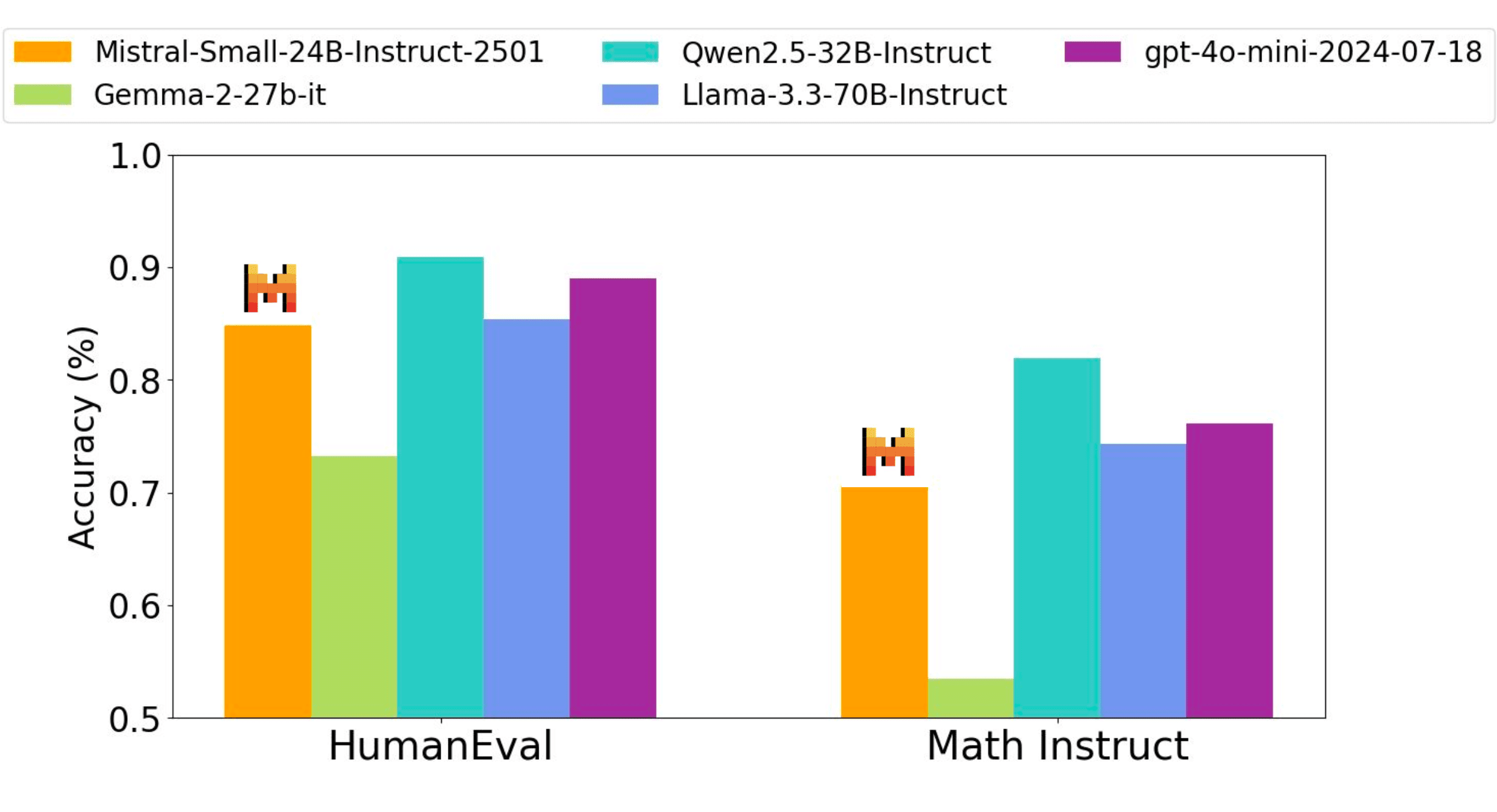

ディレクティブ関数

ミストラルAIの命令微調整モデルは、コード、数学、一般知識、命令追従ベンチマークにおいて、GPT4o-miniモデルだけでなく、3倍の大きさを持つオープンソースの重み付けモデルに対しても競争優位性を持っている。

すべてのベンチマークの性能精度は、同じ内部評価プロセスによって得られています。したがって、数値は以前に報告された性能(Qwen2.5-32B-Instruct、Llama-3.3-70B-Instruct、Gemma-2-27B-IT)と若干異なる場合があります。Wildbench、Arena hard、MTBench Judge based evals based on gpt-4o-2024-05-13.

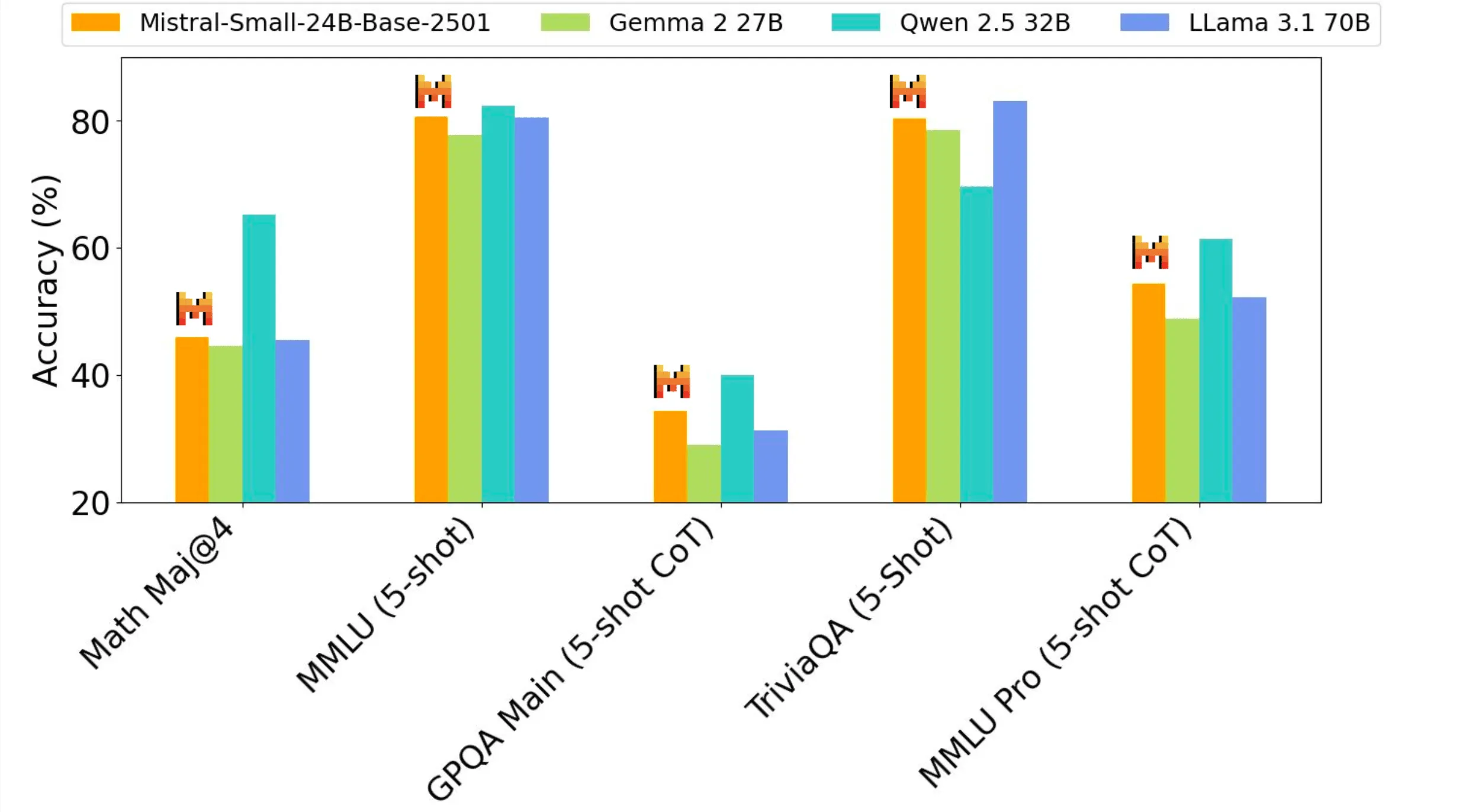

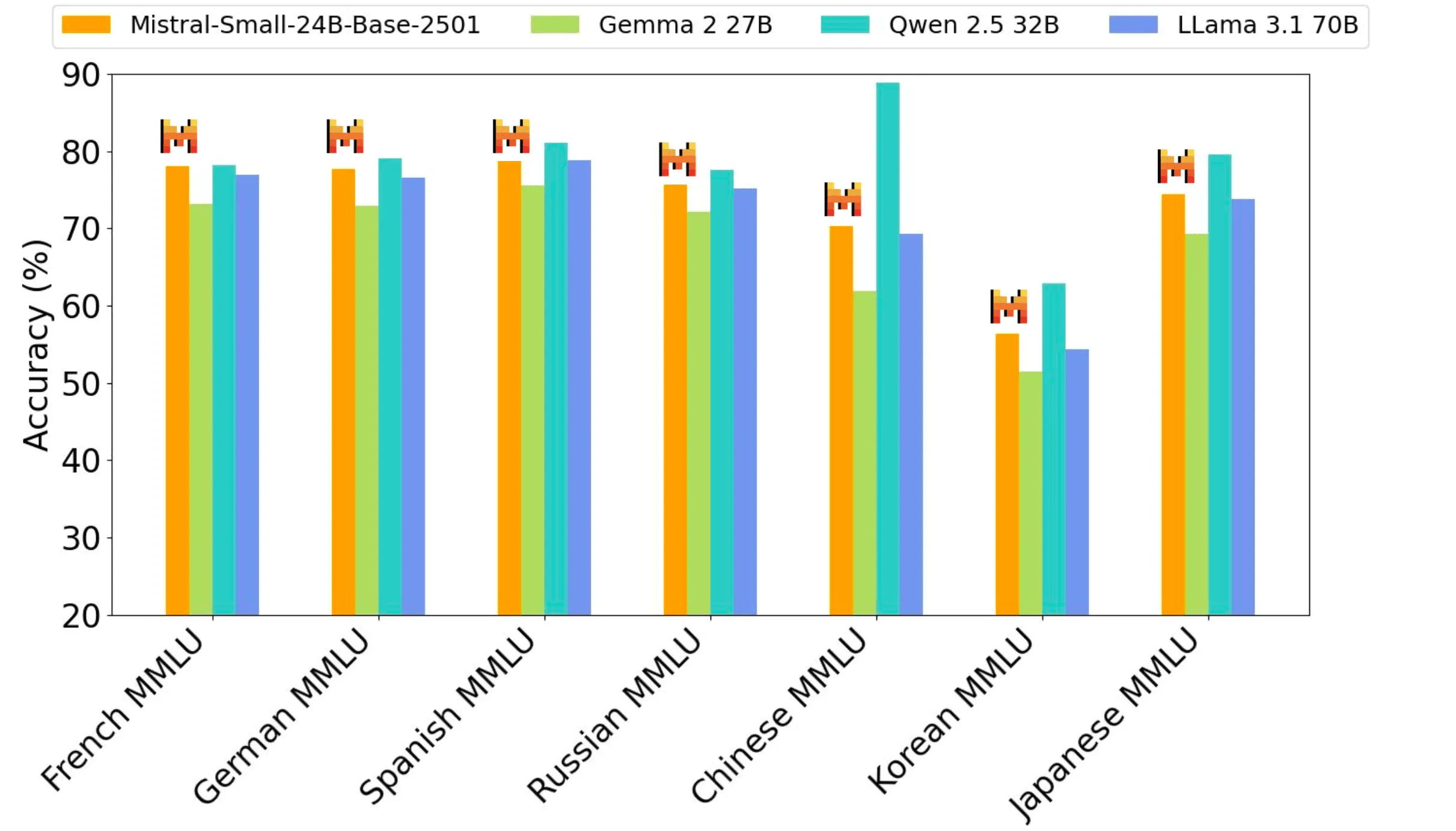

トレーニング前のパフォーマンス

ミストラル・スモール3は、24Bモデルとして、このサイズクラスで最高のパフォーマンスを発揮し、ラマ3.3 70Bのような3倍大きなモデルに匹敵する。

ミストラル・スモール3の使用時期

ミストラルAIの顧客とコミュニティーの中で、ミストラルAIは、この規模で事前訓練されたモデルを使用するユニークなユースケースをいくつか見てきました:

- 高速レスポンスの対話支援:Mistral Small 3は、高速で正確なレスポンスを必要とするシナリオに優れています。これには、ユーザーが即座のフィードバックとほぼリアルタイムの対話を期待する多くのバーチャルアシスタントシナリオが含まれます。

- 低レイテンシの関数呼び出し:Mistral Small 3は、オートメーションやエージェントワークフローの一部として使用される場合、高速関数実行を処理できます。

- 対象分野の専門家を作成するための微調整:Mistral Small 3は、特定の分野に焦点を当て、精度の高い対象分野の専門家を作成するために微調整することができます。これは、法律相談、医療診断、技術サポートなど、専門分野に特化した知識が重要な分野で特に役立ちます。

- ローカル推論:機密情報や専有情報を扱う趣味人や組織にとって特に有益です。数値化する場合、Mistral Small 3はRTX 4090または32GBのRAMを搭載したMacbook1台で個人的に実行することができます。

ミストラルAIの顧客は、以下のような複数の業界でミストラル・スモール3を評価している:

- 金融サービスのクライアントが不正検知に使用

- 医療従事者が顧客のトリアージに使用

- オンデバイス・コマンド&コントロールのためのロボット工学、自動車、製造企業

- 顧客間の水平的な使用例としては、バーチャルな顧客サービス、センチメントやフィードバックの分析などがある。

ミストラル・スモール3をお気に入りのテクノロジー・スタックで使用する

ミストラル・スモール3は現在、ラ・プラットフォームで販売中です。 mistral-small-latest もしかしたら mistral-small-2501 テキストは Mistral AI モデルの形式で提供されます。テキスト生成に Mistral AI のモデルを使用する方法については、Mistral AI のドキュメントをご参照ください。

ミストラルAIはまた、Hugging Face、Ollama、Kaggle、Together AI、Fireworks AIと提携し、本日よりそれぞれのプラットフォームでモデルを利用できるようになりました:

進むべき道

オープンソースコミュニティにとってエキサイティングな日々だ!Mistral Small 3は、最近リリースされたDeepSeekのような大規模なオープンソースの推論モデルを補完し、推論能力を前面に押し出すための強力なベースモデルとして使用することができる。

その他にも、推論機能を強化した小型・中型のミストラル・モデルが数週間以内にリリースされる予定です。ミストラルAIの旅に参加することに興味がある方(ミストラルAIは採用中です)、ミストラル・スモール3をクラックしてより良いものにすることで、その上を行くことに興味がある方は、今すぐご連絡ください!

ミストラルのオープンソースモデル

Mistral AIはMRLライセンスモデルを段階的に廃止しているため、Mistral AIはジェネリックモデルにApache 2.0プロトコルを使用するというコミットメントを再確認している。 .Mistral Small 3と同様に、モデルウェイトはダウンロードとローカル展開が可能で、自由に修正してあらゆる環境で使用することができる。モデルは、la Plateforme、Mistral AIのローカルおよびVPCデプロイメント、カスタマイズ、オーケストレーションプラットフォーム、Mistral AIの推論およびクラウドパートナー上のサーバーレスAPIを通じて利用することもできます。特別な機能(スピードとコンテキストの向上、ドメイン固有の知識、タスク固有のモデル(コード補完など))を必要とする企業や開発者は、Mistral AIのコミュニティへの貢献を補完する追加の商用モデルを利用することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません