Minima: オープンソースのRAGコンテナで、ローカルへのデプロイやChatGPTへの統合が可能。

はじめに

MinimaはオープンソースのRAG(Retrieval-Augmented Generation)ソリューションであり、ローカルでの展開と統合の両方をサポートしている。 チャットGPT 統合。このプロジェクトはdmayborodaによって保守され、柔軟で独立した ラグ Minimaは、完全に分離されたローカルインストール、ChatGPT統合のハイブリッドモード、外部サービスに完全に依存するモードの3つの動作モードを提供します。プロジェクトの目標は、効率的でスケーラブルで使いやすいRAGソリューションをユーザーに提供することです。

このプロジェクトはDockerを使ってデプロイされ、PDF、XLS、DOCX、TXT、MD、CSVなど、幅広いファイル形式のインデックス作成とクエリをサポートしています。MinimaはMozilla Public Licence v2.0 (MPLv2)の下でリリースされており、ユーザーがコードを自由に使用・変更できるようになっています。

機能一覧

- ローカル・ドキュメント・ダイアログローカルインストールによるローカルファイルとの対話。

- カスタムGPTモードカスタムGPTモデルを使用してローカルファイルを照会します。

- マルチファイル・フォーマット対応PDF、XLS、DOCX、TXT、MD、CSVファイルのインデックス作成とクエリをサポートします。

- DockerのデプロイメントDockerによる迅速なデプロイと管理。

- 環境変数の設定.envファイルを通して環境変数を設定し、ファイルパスやモデルパラメータを柔軟に設定することができます。

- 再帰インデックスフォルダ内のすべてのサブフォルダとファイルの再帰的インデックスをサポートします。

ヘルプの使用

設置プロセス

- クローン倉庫::

git clone https://github.com/dmayboroda/minima.git

cd minima

- コンテナの構築と実行::

docker-compose up --build

- 設定ファイル必要に応じて修正する

config.ymlファイルでネイティブ・モードまたは統合モードを設定する。

使用ガイドライン

ローカルモード

- サービス開始::

docker-compose up

- アクセスインターフェイスブラウザで開く

http://localhost:9001Minimaのローカルインターフェースにアクセスできる。

統合モード

- ChatGPTの設定で

config.ymlChatGPT APIキーと関連する設定を - サービス開始::

docker-compose up

- アクセスインターフェイスブラウザで開く

http://localhost:9001ChatGPTを統合したMinimaインターフェースにアクセスできます。

詳細な機能操作

- クエリー生成APIインターフェースを介してクエリーリクエストを送信すると、Minimaは設定に応じてローカルモードまたは統合モードのいずれかでクエリーリクエストを処理し、生成された結果を返します。

- 構成管理を修正することによって

config.ymlファイルで、Minimaの動作モードやパラメーターを柔軟に調整できる。 - ログビューすべての操作ログは

logsディレクトリに保存され、ユーザーがいつでも閲覧・分析できる。

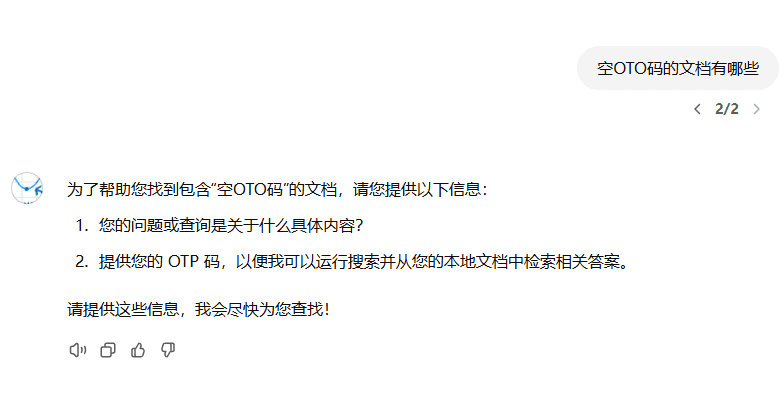

一般的な問題

- コンテナを起動できないDockerとDocker Composeが正しくインストールされ、ポートが占有されていないことを確認する。

- APIリクエストの失敗謝辞

config.yml特にAPIキーとエンドポイントアドレスが正しく設定されている。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません