OpenAI O1およびO3-mini推論モデルのためのヒントエンジニアリング

はじめに OpenAIのO1と O3ミニ は、プロンプトを処理して答えを生成する方法において、ベースとなるGPT-4(通称GPT-4o)とは異なる高度な「推論」モデルである。これらのモデルは、人間の分析を模倣し、複雑な問題についてより多くの時間をかけて「考える」ように設計されています。

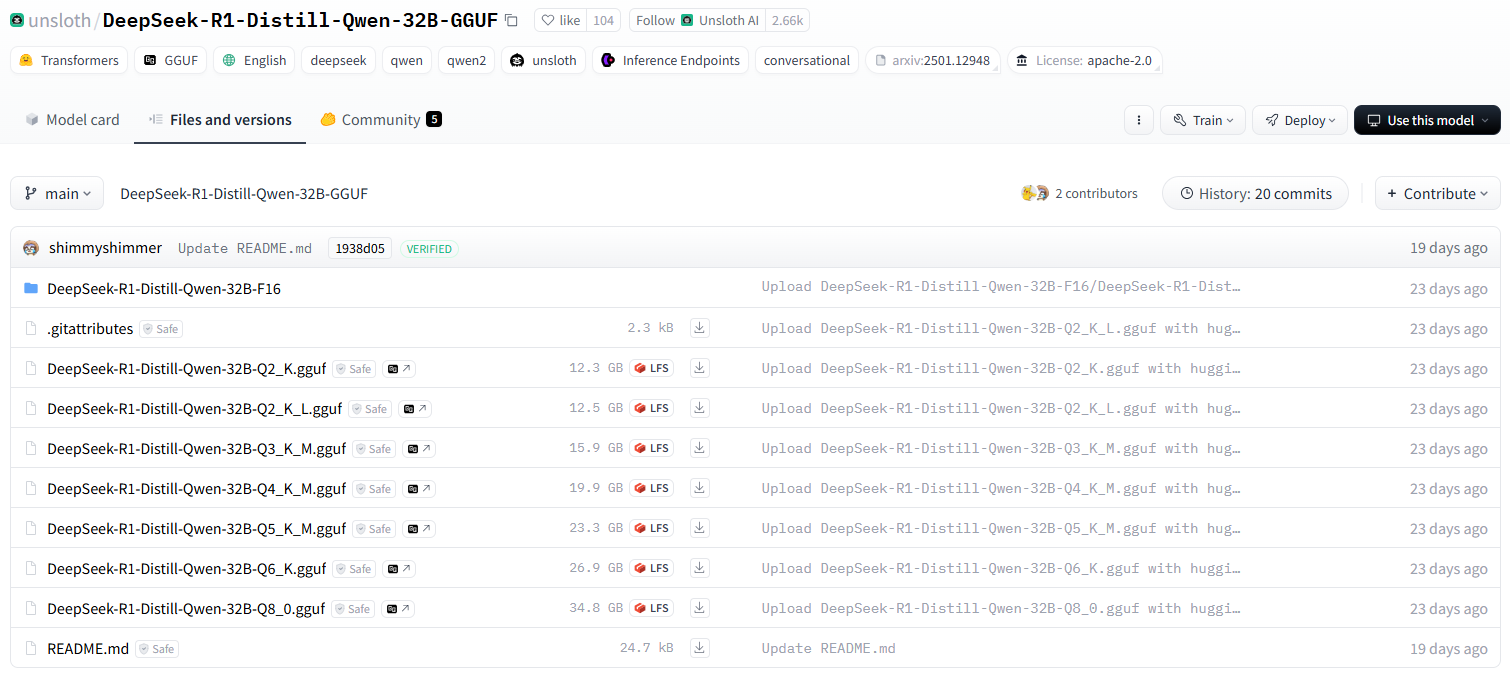

本稿では、OpenAIの詳細な情報を提供する。 O1 歌で応える O3ミニ 推論モデルのためのプロンプトエンジニアリング技術 しかし、入力構造、推論能力、応答特性、およびプロンプトのベストプラクティスに関する洞察は、この論文で述べられている。 OpenAIのモデルに限らない . 推論モデリング技術のブームに伴い、以下のようなものが流入している。 ディープシーク-R1 をはじめ、優れた推論能力を持つ多くのモデルがある。 本稿の核となる原理と技法は、読者が推論モデルを使用する際の貴重な参考資料となる。 ディープシーク-R1 や他の類似の推論モデルの可能性を最大限に引き出すことができる。 そのため、O1およびO3-miniを洞察した後、O3-miniを使用した。 プロンプトエンジニアリングその詳細には、これらの教訓をどのように統合し、より強力なAIの応用能力を引き出すために、より広い推論モデリングの分野に適用できるかについて、読者に考えてほしいという呼びかけが添えられている。

O1/O3-ミニ対GPT-4o

入力構造と文脈処理

- ビルトイン推論とキュー誘導推論の比較: O1シリーズには思考連鎖の推論スキルを内蔵つまり、キュー・ワードによる追加的なガイダンスなしに、内的に推論するのである。対照的に、GPT-4oは複雑な問題を解くとき、自動的に同じレベルの多段階推論を行わないため、通常「ステップバイステップで考えよう」といった外部からの指示を必要とします。O1/O3-miniでは、質問をするだけで、モデルが勝手に深く分析してくれます。

- 外部情報の必要性: GPT-4oは、広範な知識ベースと、いくつかのデプロイメントにおけるツール(ブラウジング、プラグイン、ビジョンなど)へのアクセスを持っており、様々なトピックに対応するのに役立っている。対照的に、O1モデルは、GPT-4oのトレーニングの焦点から外れている。狭い知識ベース.つまり、O1/O3-miniを使用する際、常識の範囲を超えたタスクの場合は重要な背景情報や文脈をプロンプトに含めること--gpt-4oはすでに判例や曖昧な詳細を知っているかもしれないが、O1はあなたがそのテキストやデータを提供する必要があるかもしれない。ヒントの例

- GPT-4o: "中絶の権利に関する最近の連邦最高裁判決の分析"(GPT-4oはすでに知識を持っているかもしれません)

- O1: 「中絶権に関する判決がアメリカ社会に与えた影響を、以下の背景情報に照らして分析しなさい。(O1はより詳細な背景情報が必要かもしれません)

- 文脈の長さ: O1は最大128kのトークン入力をサポートし、O3-miniは最大200kのトークン(最大100kのトークン出力)を受け入れ、GPT-4oのコンテキスト長を超えます。これにより、大きなケースファイルやデータセットをO1/O3に直接入力することができます。プロンプトのための大容量インプットの明確な組織化(GPT-4oとO1はどちらも長いプロンプトを扱うことができますが、O1/O3の容量が大きいため、1回の入力でより詳細なコンテキストを含めることができ、複雑な分析に非常に役立ちます。ヒントの例

- 「以下に貼り付けたこの長大な法律文書に基づいて、事件の核心的争点と裁判所の最終判断を要約してください。[数万字の法律文書を貼り付ける)" (O1/O3-miniはこのような長い入力を効率的に処理できる)

推理力と論理的推論

- 推理の深さ: O1とO3-mini体系的で多段階の推論最適化されている。解答前に「より長く考える」ことで、複雑な課題に対してより正確な解答を導き出す。例えば、O1-previewは難易度の高い数学の試験(AIME)で83%を解いたが、GPT-4oは13%の解答率であり、プロの世界でも優れた論理的推論能力を証明した。GPT-4oも強力ですが、答えを生成するのがより素直な傾向があります。明示的なプロンプトがないと、網羅的な分析を行わないことがあり、O1が捉えることができる非常に複雑な状況でエラーにつながる可能性があります。

- 複雑な仕事と単純な仕事の比較: O1ファミリーのモデルは深い推論をデフォルトとしているため、推論ステップの多い複雑な問題(多面的な解析、長い証明など)において優れた性能を発揮する。実際、5つ以上の推論ステップを必要とするタスクでは、O1-miniやO3のような推論モデルはGPT-4よりも161 TP3T以上の精度で上回る。しかし、これは次のことも意味する。非常に単純なクエリでは、O1は「考えすぎる」可能性がある。単純なタスク(推論ステップが3つ以下)では、O1の余分な分析プロセスが不利になる可能性があることがわかった。 GPT-4oは単純な質問に対して、よりストレートかつ迅速に回答することができるが、O1は不必要な分析を生成する可能性がある。重要な違いは、O1が複雑さに対して調整されていることである。そのため、些細なクイズでは効率が悪いかもしれません。ヒントの例

- 複雑なタスク(O1向き): 「気候変動が世界経済に及ぼす長期的な影響について、さまざまな産業、雇用市場、国際貿易における潜在的なリスクと機会を含めて分析し、まとめること。

- 単純作業(GPT-4o向き): 「今日の天気はどう?

- 論理的な推理スタイル: O1/O3-miniは異なる方法で論理的推論を扱います:内部対話または草稿をシミュレートします。ユーザーにとって、これはO1最終的な解答は、論理的なギャップが少なく、理路整然としていることが多い。整合性をダブルチェックするために、実際に内部で "思考の連鎖 "を完成させる。それは実際に、一貫性をダブルチェックするために内部で「思考の連鎖」を完成させる。キューイングの観点からは、通常O1に説明したり、ロジックをチェックしたりする必要はない。--これは答えを提示する前に自動的に行われます。GPT-4oの場合、論理的な厳密さを確保するために、「まず仮説を挙げ、次に結論を導く」といった指示を含めることがあります。ヒントの例

- GPT-4o: 「この論理パズルを解いてください。ステップごとに解答を示し、各ステップの理由を説明しなさい。"

- O1: 「この論理パズルを解いてください。(O1は自動的に論理的に推論し、理路整然とした答えを出す)

応答の特性化と出力の最適化

- 詳細と冗長性: その深い推論により、O1とO3-miniは通常、複雑なクエリに対して生成される。詳細で構造化された回答.例えば、O1は数学的な解決策を複数のステップに分解したり、戦略的プランの各部分の正当性を説明したりする。一方、GPT-4oは、詳細な説明を求められない限り、より簡潔な答えやハイレベルな要約を提供するのがデフォルトかもしれない。プロンプト・エンジニアリングの観点からは、これは以下を意味する。O1の回答は、より長く、より専門的なものになる可能性がある。.ディレクティブを使えば、この冗長性をうまくコントロールできる。O1に簡潔さを求めるのであれば、(GPT-4でやったように)明示的に指示しなければならない。逆に、出力を順を追って説明するGPT-4oはそれを含めるように指示する必要があるかもしれないが、O1は求められれば喜んで提供するだろう(いずれにせよ社内で推論を行ったかもしれない)。ヒントの例

- 詳細説明の要請(GPT-4o): 「各コンポーネントの具体的な役割を含め、トランスフォーマーモデルがどのように機能するかを詳しく説明し、可能な限り専門用語を使用すること。

- 簡潔な回答が求められる(O1): 「トランスフォーマーモデルの核となる考え方を3つの文章にまとめよ。

- 正確さと自己チェック: 推論モデルは自己事実確認OpenAIは、O1が応答生成中に自身の誤りを発見する能力に優れているため、複雑な応答における事実の正確性が向上すると指摘している。 GPT-4oは通常正確だが、ガイダンスがなければ、時折自信を持って間違えたり幻覚を見たりすることがある。O1のアーキテクチャは、「思考」しながら詳細を検証することで、このリスクを軽減します。実際、GPT-4oが同じレベルの信頼性を得るためには、キューイング・テクニック(例えば、GPT-4oの答えを批判したり、検証したりするように要求する)が必要な場合があるのに対して、O1はトリッキーな質問に対して不正確な答えや意味のない答えを出すことが少ないことがユーザーによって観察されています。このことは、O1/O3-miniが複雑な質問に正しく答えることを、直接プロンプトで信頼できるのに対し、GPT-4では「あなたの答えが上記の事実と一致していることを確認してください」といった指示を加える必要があるかもしれないことを意味します。とはいえ、どのモデルも絶対的な信頼性はありませんので、重要な事実の出力は常に確認する必要があります。ヒントの例

- GPT-4o(正確さ重視): 「この財務報告書の数字を分析し、会社の純利益率を計算しなさい。計算が正確かどうか、必ず数字を再確認してください。"

- O1(デフォルトのトラスト): 「この財務報告書のデータを分析し、会社の純利益率を計算しなさい。

- スピードとコスト: 特筆すべき違いは、O1モデルはより深い推論を行うにはより遅く、より高価であるということである。O1 Proは長いクエリのためにプログレスバーまで備えている。より速く、より費用対効果の高い推論モデル--O3-miniはO1やGPT-4oよりもトークン単価が安く、レイテンシも低い。しかし、O3-miniはより小さなモデルであるため、STEM推論には威力を発揮するが、一般的な知識や非常に複雑な推論ではO1やGPT-4に及ばない可能性がある。最高の応答性プロンプトエンジニアリングを行う場合、深さとスピードのバランスをとる必要がある。レイテンシが問題で、タスクが最大限の複雑さでない場合は、O3-mini(あるいはGPT-4o)がより良い選択かもしれません。OpenAIのガイダンスによると、GPT-4oは「ほとんどのヒントには依然として最良の選択」であり、本当に難しい問題には主にO1を使用します。O1を使う。要するに、仕事に適したツールを使うことです。O1を使う場合は、レスポンスタイムが長くなることを予想し、(おそらくユーザーに通知するか、システムのタイムアウトを調整することで)出力が遅くなることを想定してください。ヒントの例

- スピード優先(GPT-4oまたはO3-miniに最適): 「この記事の要点を手短にまとめてください。

- デプス優先(O1に適している):"この記事の主張の論理と証拠を深く分析し、その信憑性を評価する"

パフォーマンス・エンジニアリング・テクニックを最大限に発揮するためのヒント

O1とO3-miniの効果的な使用には、GPT-4oとは少し異なるキューイングへのアプローチが必要である。以下は、これらの推論モデルから最適な結果を得るための主要なキューイングエンジニアリングのテクニックとベストプラクティスである:

先端をすっきりさせ、最小限に抑える

要求を簡潔明瞭にO1とO3は集中的に内的推論を行うため、集中的な質問や余計な文章のない指示には興味を示さない。openAIと最近の研究は、これらのモデルに過度に複雑な、あるいはブートストラップ的なキューを使用することは避けるべきであると示唆している。実際には、これは次のことを意味します。問題や課題を明確に述べ、必要な詳細のみを提供する。修飾語」を加えたり、クエリを何度も言い直したりする必要はない。修飾語」を加えたり、クエリを何度も言い直したりする必要はありません。例えば、「この難解なパズルでは、各ステップを慎重に推理して正しい解答にたどり着いてほしい。ステップ・バイ・ステップで分解してみましょう......」と書く代わりに、「次のパズル(パズルの詳細を含む)を解いてください。理由を説明してください。"モデルは自然にステップ・バイ・ステップで考え、説明をするようになる。指示が多すぎると、かえってこじらせる-ある研究によると、手がかりとなる文脈を増やしすぎたり、例を増やしすぎたりすると、次のようなことが起こる。O1のパフォーマンス低下その推理プロセスを本質的に圧倒する。ヒント 複雑なタスクの場合、ヒントのサンプルはゼロ(タスクの説明のみ)から始め、出力がニーズを満たさないとわかったときだけ指示を追加する。多くの場合、これらの推論モデルではヒントを最小化することが最良の結果を生む。

ヒントの例

- シンプルなチップ(O1/O3-mini): "この市場調査報告書を分析し、最も重要な3つの市場トレンドを特定する"

- 冗長性のヒント(推奨しない): 「このレポートの中で最も重要な市場トレンドは何でしょうか?最も重要なトレンドを3つ挙げ、それが最も重要だと思う理由を説明するのがベストだろう。"

不必要に小さなサンプル例は避ける

従来のGPT-3/4のキューイングでは、モデルを誘導するために少ないサンプル例やデモンストレーションを使用するのが一般的です。しかし、O1/O3では、より少ないことがより重要なのです。O1シリーズは特に、多くの例を使ったキューを入れないように訓練されています。実際、複数の例を使うことはくつがえすパフォーマンスO1-previewとO1-miniの研究は、サンプル数の少ないヒントは一貫してパフォーマンスを低下させることを示唆しています。OpenAI自身のガイドラインはこれと一致しています:内部ロジックの混乱を避けるために、推論モデルを他のコンテキストや例に限定することを推奨しています。ベストプラクティス:サンプルはゼロにするか、絶対に必要な例を1つまでにしてください。例を含める場合は、関連性が高くシンプルなものにしましょう。例えば、法的分析のプロンプトでは、通常次のようにします。まい事前に完全な事例を追加してください。代わりに、新しい事例を直接要求してください。デモを使う唯一のケースは、タスクのフォーマットが非常に特殊で、モデルが指示に従わない場合です。そうでなければ、直接の問い合わせからモデルがそれを理解することを信じてください。

ヒントの例

- サンプルチップはゼロ(最適): 「以下のカルテ情報に基づき、患者が罹患している可能性のある疾患を診断しなさい。[病歴情報を貼り付ける)"

- サンプルチップは少なめ(推奨しない): 「例1]、[例2] では、以下のカルテ情報に基づいて、患者が罹患していると思われる病気を診断してください。[病歴情報の貼り付け]" (O1/O3-miniの場合、通常ゼロサンプルのプロンプトの方が効果的)

システム/開発者コマンドを使用した役割とフォーマットの設定

明示的コマンドコンテキストモデルの応答をガイドするのに役立ちます。API(またはダイアログのシステムメッセージ)を使って、モデルの役割やスタイルを簡潔に定義します。例えば、システムメッセージは、"あなたは、解決策を段階的に説明することを専門とするプロの科学研究者です。"というようなものです。O1とO3-miniはこのような役割の指示によく反応し、推論に取り入れます。しかし、彼らはすでに複雑なタスクを理解することに長けているので、あなたの指示は次のことに焦点を当てるべきであることを心に留めておいてください。の代わりに**希望する出力タイプを指定する。思考法.システム/開発者ディレクティブの良い使用例には以下が含まれる:** 。

- タスクまたは役割の範囲を定義する: 例えば、「法律アナリストとして行動する」、「数学の先生が生徒に説明するように問題を解決する」などである。これはトーンや詳細のレベルに影響する。

- 出力フォーマットを指定する: 構造化された形式(箇条書き、表、JSONなど)での回答が必要な場合は、明示的に指定してください。O1、特にO3-miniは、構造化された出力モードをサポートしており、フォーマットのリクエストに応じます。O1、特にO3-miniは、構造化された出力モードをサポートしており、フォーマット要求に従います。論理的な性質上、書式設定指示に正確に従う傾向があり、回答の一貫性を保つのに役立ちます。

- 境界線を設定する 冗長性や集中力をコントロールしたい場合は、「詳細な分析後に簡潔な結論を提供する」「提供された情報のみを使用し、外部からの仮定を行わない」などを含めることができる。推論モデルはこれらの境界線を守り、トピックから外れたり、幻想を生み出したりするのを防ぐことができる。O1は非常に詳細な分析を行うことができるので、これは重要である。

トーン、キャラクター設定、フォーマットに関するガイダンスは必ず毎回含めること。

プロンプト(システムメッセージ)の例:

- システムメッセージ: "あなたは、複雑な法律事件を分析し、専門的で厳格な法的助言を行うことを専門とする経験豊富な法律顧問です。"

- ユーザーのヒント "スミス対ジョーンズ "のケースを分析し、ジョーンズが責任を負うべきかどうかを判断しなさい。(モデルは法律顧問の役割と口調で分析する)。

コマンドによる冗長性と深さのコントロール

O1やO3-miniが自然に深く推論するのに対して、あなたはその推論を輸出にどの程度反映されるのか。もし詳細な説明**については、それを促す(例えば、「解答に段階的な推論を示してください」)。を押す必要はない。進め推論だが、もしさあしかし、彼らには情報が必要である。その代わり、模範解答が長すぎたり専門的すぎたりする場合は、もっと簡潔に、あるいは特定の側面だけに焦点を当てるように指示する。例えば、"分析を2~3段落にまとめ、最も重要なポイントのみを含める "などです。モデルは通常、このような長さや焦点に関する指示に従います。O1のデフォルトの動作は徹底したものであり、簡潔さよりも正しさに最適化されているため、より詳細な情報を提供する傾向があることを覚えておいてください。ほとんどの場合、簡潔さを求める直接的な要求がこの傾向を上書きする。**

に関してO3-mini**、OpenAIは深さを管理するための追加ツールを提供する:「推理の強さ」パラメーター(低、中、高)。この設定により、モデルは「考える」ことの難しさを知ることができます。キューに関して言えば、APIやこの機能を公開するシステムを使用している場合、非常に複雑なタスク(回答が長くなったり遅れたりする代償として、最大限の推論を保証する)にはこの設定を高くし、より単純なタスク(より速く、より合理的な回答)には低くすることができます。これは本質的に、冗長性と徹底性をコントロールするもう一つの方法です。このパラメーターに直接アクセスできない場合は、「迅速な回答をし、詳細な分析は必要ない」と明示することで、シミュレーションすることができます。低強度完全な正確さよりもスピードが重視される状況向けのモデルだ。その代わりに高強度"説明が長くなっても、正しい答えにたどり着くために必要なすべてのステップを踏んでください "と言うことができます。これらのヒントは、モデルの内部設定が機能する方法と一致しています。**

ヒントの例

- 冗長性のコントロール: "この記事の要点を200字以内でまとめる"

- コントロールの深さ: "このエッセイの論証構造を深く分析し、論理的に健全で、十分に論証されているかどうかを評価する。"

複雑な仕事を正確にこなす

難しい問題に対して最も正確な回答を得るために、以下をお願いします。プロンプト**の推論モデルを利用しましょう。O1は自己チェックができ、矛盾を発見することもできるので、これを利用するように求めることができます。例えば、"すべての事実を分析し、結論に一貫性があるかどうかダブルチェックしてください"。通常、プロンプトは表示されない。リビア・アラブ・ジャマーヒリーヤランプアップこのコマンドは、モデルに特別な注意を促す。興味深いことに、O1はすでに自己ファクトチェックを実行しているので、「各ステップを検証する」ように促す必要はほとんどない(GPT-4oの場合はより役立つ)。その代わりに、完全で明確な情報を提供することに集中してください。質問やタスクに曖昧な点がある場合は、プロンプトで明確にするか、モデルに仮定を列挙するように指示します。これにより、モデルが誤って推測することを防ぐことができます。**

ソースとデータの処理: 与えられたデータを分析する(例えば、文書を要約したり、与えられた数字に基づいて答えを計算したりする)タスクの場合、そのデータを明確に提示するようにしてください。O1/O3-miniはそれを忠実に使用します。データを箇条書きや表にして、わかりやすくすることもできます。モデルが幻想を作り出してはならない場合(例えば、法律の文脈では、法律を作り出してはなりません)、"あなたの答えは、提供された情報と常識のみに基づいています。"ということを明確にしてください。推論モデルは既知の事実に忠実であることが多く、このような指示は幻覚の可能性をさらに低くする。反復と検証: タスクがクリティカルな場合(例:複雑な法的推論や利害関係の大きい工学的計算)、迅速なエンジニアリング・テクニックが必要である。インテグレーテッドモデルの応答。これは単一のプロンプトではなく、戦略です。クエリを複数回実行し(または代替解を検討するようモデルに依頼し)、答えを比較することができます。O1のランダム性は、毎回推論の異なる経路を探索する可能性があることを意味します。出力を比較したり、後続のプロンプトでモデルに「代替説明の存在について考察する」よう求めることで、結果の信頼性を高めることができます。GPT-4oもこのアプローチから利益を得ますが、絶対的な精度が重要なO1には特に有効です。

最後に、モデルの選択はキューイングエンジニアリングの一部で あることを覚えておいてほしい。問題が実際にはO1レベルの推論を必要と しない場合、GPT-4oを使用する方がより効果的で同様に正確かもしれない。複雑な場合は、上記のテクニックを使ってO1の能力を活用する。

ヒントの例

- データソースを重視: 「以下の売上データ表に基づき、前四半期に最も売上が伸びた商品カテゴリーを分析しなさい。[販売データ表を貼り付けなさい] 分析には必ず表のデータのみを使用し、他の情報源は参照しないこと。"

- 繰り返し検証: スミス対ジョーンズ」のケースを分析し、ジョーンズが責任を負うべきかどうかを判断しなさい。最初の分析結果を示してください。次に、あなたの分析を再検討し、他に可能な説明や抜け穴があるかどうかを検討してください。最後に、両方の分析結果を組み合わせて、最終的な法的見解を述べてください。(反復と反省による法的分析の信頼性向上)

O1/O3-miniとGPT-4oの論理的推理の違い

これらの推論モデルは、GPT-4oとは根本的に異なる方法で論理的な問題を扱うので、それに応じてプロンプトの戦略を調整する必要があります:

- 思考の内部連鎖: O1とO3-miniは答えを解釈するため、内部対話やステップバイステップの解答を効果的に行う。明確な指示がない限り、GPT-4oは各ステップを厳密に行わないかもしれません。例えば、ロジックパズルや数学の語句問題では、GPT-4oはもっともらしく聞こえる答えを素早く出すかもしれませんが、推論の一部を飛ばしてしまうため、エラーのリスクが高まります。ヒントの違い:O1に "演繹を示せ "と促すのは、実際にそれを見たいとき以外はやめましょう。GPT-4oでは、CoTプロンプト(「まず、......を考え、次に......を考える」)を使って推理を改善しますが、O1ではそれを外部に伝えるように組み込まれています!そうすることは、冗長であったり、混乱を招くかもしれません。その代わり、問題を明確に述べ、O1に演繹的に推論させるようにしてください。ヒントの例

- GPT-4o(思考の連鎖を操る必要がある): 「次の数学の応用問題を解きなさい。1.問題の意味を理解する、2.既知と未知の条件を分析する、3.問題を解く手順をリストアップする、4.答えを計算する。"

- O1(ブートなし): 「次の数学の応用問題を解きなさい。(O1は自動的に論理的に推論し、答えを出します)

- 曖昧さに対処する GPT-4oは、論理的な推論の課題では、情報が不足していたり、あいまいであったりすると、すぐに仮定してしまうことがある。O1は内省的なアプローチをとるため、あいまいな点に印をつけたり、複数の可能性を考慮したりする可能性が高くなります。これを利用するために、O1に対するあなたの働きかけは、"不明確な点があれば、それを解決する前に仮定を述べてください "と直接尋ねることでもよいでしょう。GPT-4はこのプッシュをもっと必要とするかもしれません。O1は自然にそうするか、少なくとも与えられていない事実を仮定する可能性は低いでしょう。したがって、両者を比較するとO1の描写は慎重かつ徹底しているそして、GPT-4oのレンダリングは素早く広範囲に及ぶ。GPT-4oの場合は控えめに誘導し、O1の場合は主に情報を提供して任せる。ヒントの例

- O1(曖昧さへの対処): 「この契約を分析し、有効かどうかを判断しなさい。分析の過程で契約条件に曖昧な点が見つかった場合は、その点を明確に指摘し、曖昧な点に関するあなたの理解と前提を述べなさい。"

- プログレッシブ輸出: 時には、実際にそこにいたいと思うこともある。輸出指導用または透明化用)の論理的手順を参照してください。GPT-4oでは、明示的に要求する必要があります("Please show your work")。問題が十分に複雑な場合、O1はデフォルトで構造化された推論を含むかもしれませんが、通常、要求されない限り、各ステップを明示的に列挙することなく、十分に推論された答えを提供します。O1に論理の連鎖を出力させたい場合は、そのように指示すればよいのです。実際、O1-miniは(コーディング問題などで)プロンプトが出されたときに、ステップごとの分解を提供できることが指摘されている。またふもしO1に論理の長い説明をさせたいのであれば(おそらく最終的な答えが欲しいだけなのだろうが)、「最終的な答えを直接言え」と言えば、詳細な説明は省略できる。ヒントの例

- ステップ・バイ・ステップ出力(O1)が必要: 「このプログラミング問題を解きなさい。あなたが書いたコードの各行を含め、あなたの解決策を段階的に示し、そのコードが何をするのかを説明しなさい。"

- ダイレクト出力(O1)が必要: 「このプログラミング問題を解いてください。最終的なプログラムコードを説明なしで直接与えてください。"

- 論理的厳密さと創造性: もうひとつの違い:GPT-4(および4o)は創造性と生成性に特徴がある。o1はより厳格で、論理的分析に固執します。もしあなたのプロンプトに、推理とちょっとした創造性(手がかりをつなぎ合わせるなど)の両方が必要なシナリオが含まれていれば、それを例として使うことができるかもしれません。歌で応えるナレーションを加えて謎を解く)、GPT-4はナレーションを扱うのが得意かもしれないが、O1は推理に重点を置くだろう。プロンプト・プロジェクトでは、O1を使って論理的な解決策を導き出し、GPT-4を使ってプレゼンテーションを装飾する、というように、それぞれの長所を組み合わせることができる。O1/O3-miniだけにこだわる場合は、クリエイティブなタッチやより想像力豊かな回答を明確に求める必要があるかもしれないことに注意してください。ヒントの例

- 創造性を重視(GPT-4o): "あなたは探偵役となり、事件の原因、経過、結末、犯人の動機と手口など、以下の手がかりをもとに説得力のある探偵物語を推理してください。[手がかりを提示せよ]"

- 論理的厳密性を重視(O1): "以下のヒントをもとに、事件の真相を厳密に推理し、推理の各段階の論理的根拠を説明する論理学者役を演じてください。[手がかりを提供する]"

主な調整 要するに、O1/O3-miniのロジックを利用するには、最も要求の厳しい推論タスクを個々の明確に定義されたプロンプトとして提供します。彼らの思考プロセスを細かく管理することなく、内部で論理を完成させるようにします(彼らはこの目的のために作られています)。GPT-4oでは、古典的なプロンプトエンジニアリング(問題を分解する、段階的な推論を要求する、など)を引き続き使用し、同じレベルの推論を誘導する。GPT-4oが混乱するようなプロンプトでも、O1にはぴったりかもしれませんし、その逆もあります。

効果的なヒントの作成:ベストプラクティスのまとめ

上記を実行可能なガイドにまとめるために、O1またはO3-miniにプロンプトを出す際のベストプラクティスのリストを以下に示す:

- 明確で具体的な指示を出すこと: モデルに何をさせたいか、何を答えさせたいかを明確に述べる。無関係な内容は避ける。複雑な質問については、通常、直接質問で十分です(複雑なロールプレイングや複数の質問プロンプトを使用する必要はありません)。

- 必要な文脈を提供し、それ以外は省略する: モデルが最新の知識やニッチな知識を持っていない可能性があるため、モデルが必要とするドメイン情報(ケースに関する事実、数学の問題に関するデータなど)を含める。ただし、プロンプトに無関係なテキストや多すぎる例を含めないでください。弱体化注意をモデル化する。

- アンダーサンプルの例は最小限、または全くない: デフォルトでは、サンプルのプロンプトはゼロから始めます。モデルがタスクやフォーマットを誤解している場合は、ガイドとして簡単なサンプルを追加してください。それは必要なく、パフォーマンスを低下させる可能性があります。

- 必要に応じて、キャラクターや声のトーンを設定する: システム・メッセージや短い接頭辞を使って、モデルを適切な心境にさせる(例えば、「あなたは事件を分析する上級法律事務員です」)。.これは、特にトーン(フォーマルかカジュアルか)に役立ち、適切な表現を保証します。

- 出力フォーマットを指定する: 答えを特定の構造(リスト、アウトライン、JSONなど)にしたい場合は、明示的にモデルに知らせてください。推論モデルは確実にフォーマットの指示に従います。例えば、"順番に並んだステップのリストで回答してください "などです。

- 長さと詳細を説明する: 短い回答が必要な場合は、それを明示する(「1段落で回答する」または「はい/いいえのみで回答し、1文で説明する」)。詳細な分析が必要な場合は、それを促す(「詳細な説明をする」)。あなたが望む詳細レベルをモデルがデフォルトで知っていると思わないでください。

- O3-miniの推力設定を使用: APIを介してO3-miniを使用する場合、タスクに適切な推論の強さ(低/中/高)を選択します。高」はより詳細な回答を提供し(複雑な法的推論や難しい質問の場合)、「低」はより迅速で短い回答を提供します(迅速なチェックや簡単なクエリの場合)。これは、O3-miniプロンプトの動作を調整するユニークな方法です。

- 冗長な「ステップバイステップ」のプロンプトは避けてください。O1/O3-miniに「よく考えましょう」といったフレーズや思考の連鎖コマンドを追加しないでください。このようなトークンは保存しておき、GPT-4oでのみそのようなヒントを使用してください。例外は、透明性を確保するために各ステップを出力させたい場合です。輸出そのようにすることが要求されているが、それでも、次のように指示する必要はない。実践理由

- テストと反復: このようなモデルは言葉遣いに敏感な場合があるため、良い答えが得られない場合は、質問を言い換えたり、指示を強化したりしてみてください。小さな変更(例えば、自由形式のプロンプトに対して直接的な質問をする)で、かなり良い回答が得られることが分かるかもしれません。幸いなことに、O1/O3-miniは旧モデルよりも繰り返しが少なくて済みますが(複雑なタスクを1回で正確にこなすことがよくあります)、プロンプトを微調整することで、わかりやすさや書式を最適化することができます。

- 重要な出力を検証する: クリティカルなユースケースの場合、プロンプトと回答のサイクルを1回に頼らないでください。フォローアッププロンプトを使用して、モデルにその答えを検証または正当化するように求めます(「その結論に自信がありますか?その理由を説明してください。)また、プロンプトを再度実行して、一貫した結果が得られるかどうかを確認します。一貫性のある理路整然とした答えは、モデルの推論が信頼できることを示しています。

これらのテクニックに従うことで、高度に最適化されたレスポンスでO1およびO3-miniの能力をフルに活用することができる。

ベストプラクティスを法的ケーススタディに適用する

最後に、これらのヒントとなるエンジニアリング・ガイドラインを、どのようにして法的ケース分析シナリオ**(前述)。法的分析は、O1が非常に効果的である複雑な推論タスクの完璧な例です。

- コンストラクト・インプット: まず、事件の主要な事実と回答すべき法的質問を明確に概説します。例えば、背景となる事実を箇条書きまたは短い段落として列挙し、「上記の事実に照らして、当事者Aが米国法の下で契約違反の責任を負うかどうかを判断してください」と明確に法的な質問をします。このようにプロンプトを構成することで、モデルがシナリオをより簡単に解析できるようになります。また、重要な詳細が見逃されたり、見落とされたりすることもありません。

- 関連する文脈や法律を示す: 具体的な法令、判例、定義が関連する場合は、プロンプトにそれら(またはそれらの抜粋)を含めます。O1 にはブラウズ機能がなく、ニッチな法令を記憶から呼び出すことができない場合があるため、分析が特定の法令の条文に依存する場合は、それをモデルに提供します。例えば、"[法令 X の抜粋]に基づき、[テキストを提供する]......この法令をケースに適用する"。こうすることで、モデルは正確な推論を行うために必要なツールを得ることができます。

- システムメッセージにおける役割の設定 あなたは、事実に対する法律の適用を、明確なステップ・バイ・ステップで説明する法律分析家です。のような指示は、正式で理路整然とした分析を行うようモデルを促すものである。O1は慎重な推論を試みているが、この指示はその口調と構造を、法律談話で期待されるもの(例えば、事実を引用し、法律を適用し、結論を導く)に合わせている。

- 複数の例は必要ない: O1 は例題に従う必要はなく、ゼロから分析を行うことができます。ただし、「IRACフォーマット(質問、ルール、分析、結論)で解答を提供すること」という必須フォーマットについて簡単に触れておくとよいでしょう。O1はそれに従って出力を整理します。

- 必要に応じて冗長性を制御する: 事件の徹底的な分析が必要な場合は、O1にその包括的な理由を出力させる。その結果、各論点を深くカバーする数段落が出力されるかもしれない。出力が長すぎると感じる場合、または特に簡潔な要約が必要な場合(迅速な勧告的意見など)は、モデルに「分析はいくつかの重要な段落にとどめ、核心的な争点に焦点を当てる」よう指示してください。こうすることで、主要なポイントのみを確実に得ることができる。一方、最初の答案が短すぎたり、表面的すぎたりするようであれば、「もっと詳しく、特に法律をどのように事実に適用するか説明してください」と再度促します。O1は、社内ですでに重い推論を行っているので、喜んで詳しく説明するでしょう。

- 正確さと論理的一貫性: 法的分析では、事実にルールを適用する際に正確さが要求されます。O1の場合、論理的に問題を解決してくれることは信頼できますが、法的な言及や具体的な記述についてはダブルチェックするのが賢明です(学習データが詳細まで持っていない可能性があるため)。例えば、"すべての事実が解決され、結論が法律に準拠していることを再確認してください "といったヒントを最後に加えることもできる。O1は自己チェックする傾向があるため、それ自体が、何か問題がないか、他の仮定が必要かどうかを指摘してくれるかもしれない。これは、ニュアンスが重要な分野では有効なセーフティネットとなる。

- フォローアップ・クエリーを使う: 法的な場面では、フォローアップの質問をするのが一般的である。例えば、O1が分析を行った場合、「もし契約解除の条件が違っていたらどうですか?その場合、分析はどのように変わるのでしょうか?"O1はこのような反復的な質問にも推論でうまく対応することができます。プロジェクトに取り組んでいる場合、インターフェイスは現在のダイアログコンテキストを超える長期的な記憶を持っていない(ブラウズされない)ことに留意してください。ダイアログは、混乱を防ぐために、目の前の事件の事実に焦点を合わせてください。

これらのベストプラクティスを適用することで、O1またはO3-miniが質の高い法的分析を行えるようになります。要するに、ケースを明確に提示し、タスクを割り当て、推論モデルに力仕事をさせるのです。その結果、O1の論理的能力を生かした、理路整然とした段階的な法的考察が、効果的なプロンプトの構成によって最適化されるはずである。

このようにOpenAIの推論モデルを使用することで、出力のスタイルや明瞭さをコントロールしながら、複雑な問題解決においてその強みを生かすことができます。OpenAIのドキュメントでも指摘されているように、O1シリーズは調査や戦略といった分野での深い推論タスクを得意としています。GPT-4oとの違いを理解し、それに応じてプロンプトの方法を適応させることで、O1およびO3-miniのパフォーマンスを最大化し、最も難しい推論タスクであっても、正確で構造化された回答を得ることができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません