無料! GithubがAzureと手を組み、o1を含むクローズドソースのトップオープンソース・モデルAPIコールを開発者に無料提供する。

スクリーンに映し出される緻密なコードには、さまざまなモデルのAPIの設定情報が散りばめられており、テーブルの上のコーヒーはとっくに冷めていた。

面倒な環境設定、コストのかかるAPI、不十分なドキュメントのサポート......。

「すべての開発者がさまざまなAIモデルを簡単に使える統一プラットフォームがあれば、どんなに素晴らしいことだろう。

その願いが今日、ついに現実のものとなった。

GitHubはGitHub Modelsサービスを正式に開始し、世界中の1億人以上の開発者にAI開発革命をもたらす。

この画期的な新製品に飛び込もう。

静かなる開発革命

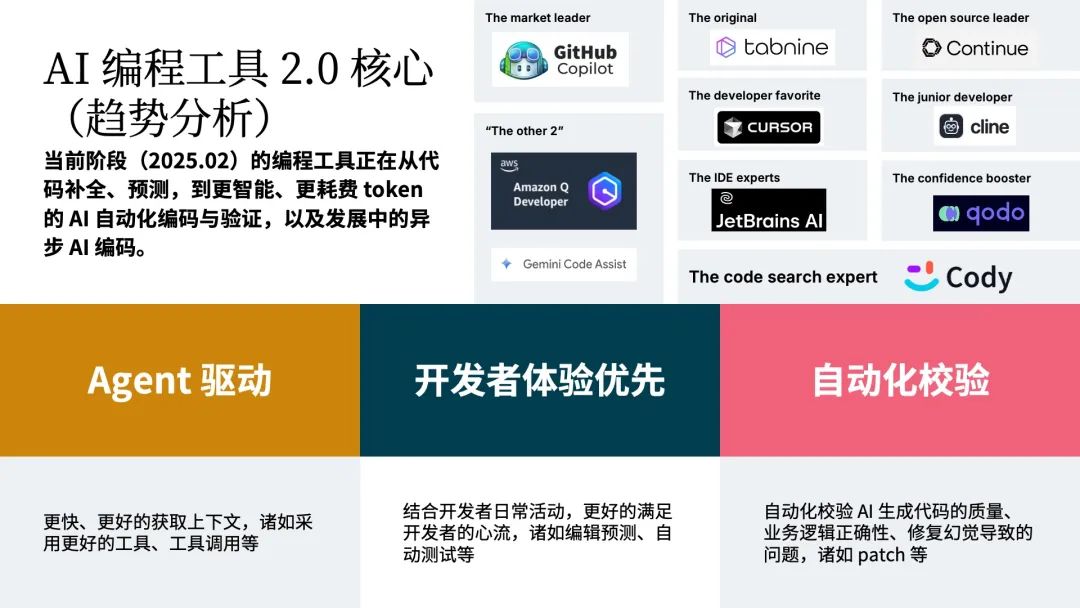

急速に進化するAIの世界で、開発者の役割は大きく変わりつつある。GitHubはGitHub Copilot Free Planを正式に発表した!

従来の「コーダー」から「AIエンジニア」へのシフトは、単なる肩書きの変更ではなく、ソフトウェア開発パラダイム全体の革命である。

ギットハブ・モデルの登場は、この歴史的な転換点を捉えている。

なぜGitHubモデルなのか?

プロジェクトでAIモデルを使用する必要がある場合は、もはや必要ありません:

- 適切なモデルを見つけるためにプラットフォームを切り替える

- モデルごとに異なる環境と依存関係を設定する

- 高額なAPIコールコストが心配

- 複雑な配備プロセスに悩まされる

これらの問題はすべて、GitHub Modelsでエレガントに解決されます。

指先で操作できるパワフルなモデル

モデルのラインナップはデラックス

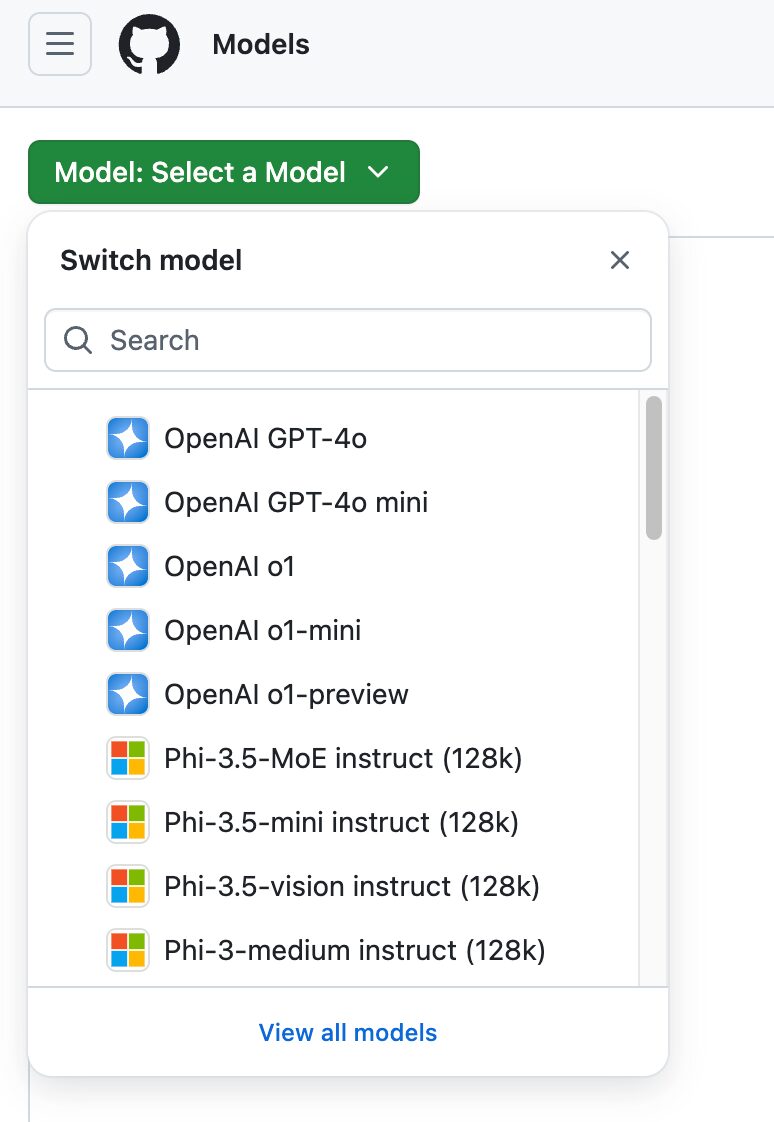

GitHub Modelsは印象的なモデルのライブラリを提供しています:

- ラマ3.1:メタの最新オープンソース・ビッグモデル、複数のベンチマークで優秀な結果を残す

- GPT-4o:マルチモーダル入力をサポートするOpenAIの最も強力な商用モデルの1つ

- GPT-4o mini:高速応答が必要なアプリケーション向けの軽量バージョン

- ファイ3:特定のタスクで驚異的なパフォーマンスを発揮するマイクロソフトの効率的モデル

- ミストラル ラージ2:低レイテンシーで知られ、リアルタイム・アプリケーション開発に適している。

各モデルにはそれぞれ独自の利点があり、開発者は特定のニーズに最も適したものを選ぶことができる。

驚くほど使いやすい

スタートアップの技術責任者である私たちのグループのImdoaaは、GitHub Modelsを使った経験を共有しました:

「以前は、AIモデルの選択とテストに特に頭を悩ませていた。高額な料金を支払うか、オープンソースのモデルをデプロイするのに多くの時間を費やす必要がありました。GitHub Modelsを使えば、こうした問題はもうありません。プレイグラウンドで様々なモデルの結果を素早く比較し、我々のニーズに最も適したものを見つけることができます。実験からデプロイまですべてのプロセスがGitHubのエコシステム内で行われ、驚くほどスムーズに利用できるのが最大の魅力です"

3つの核となる強みを深く理解する

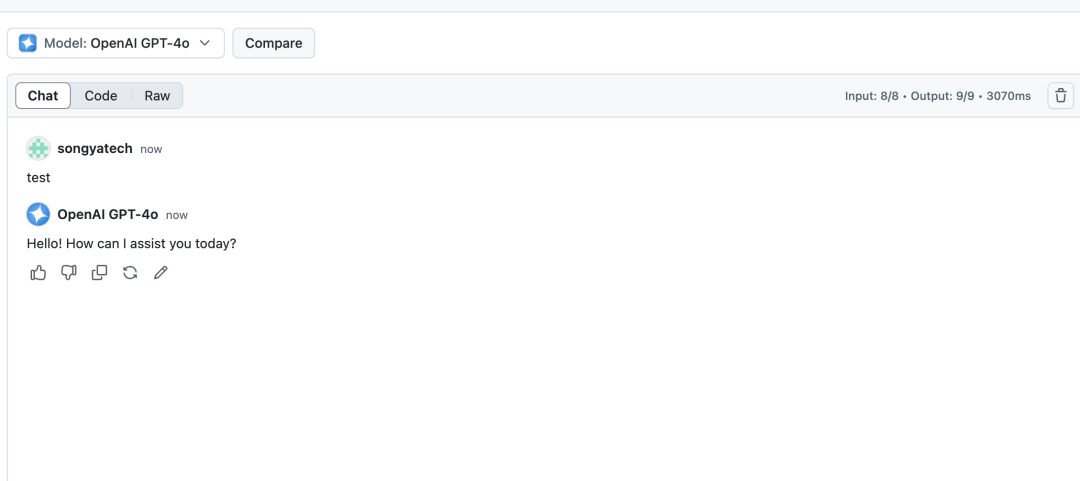

1.革命的な遊び場環境

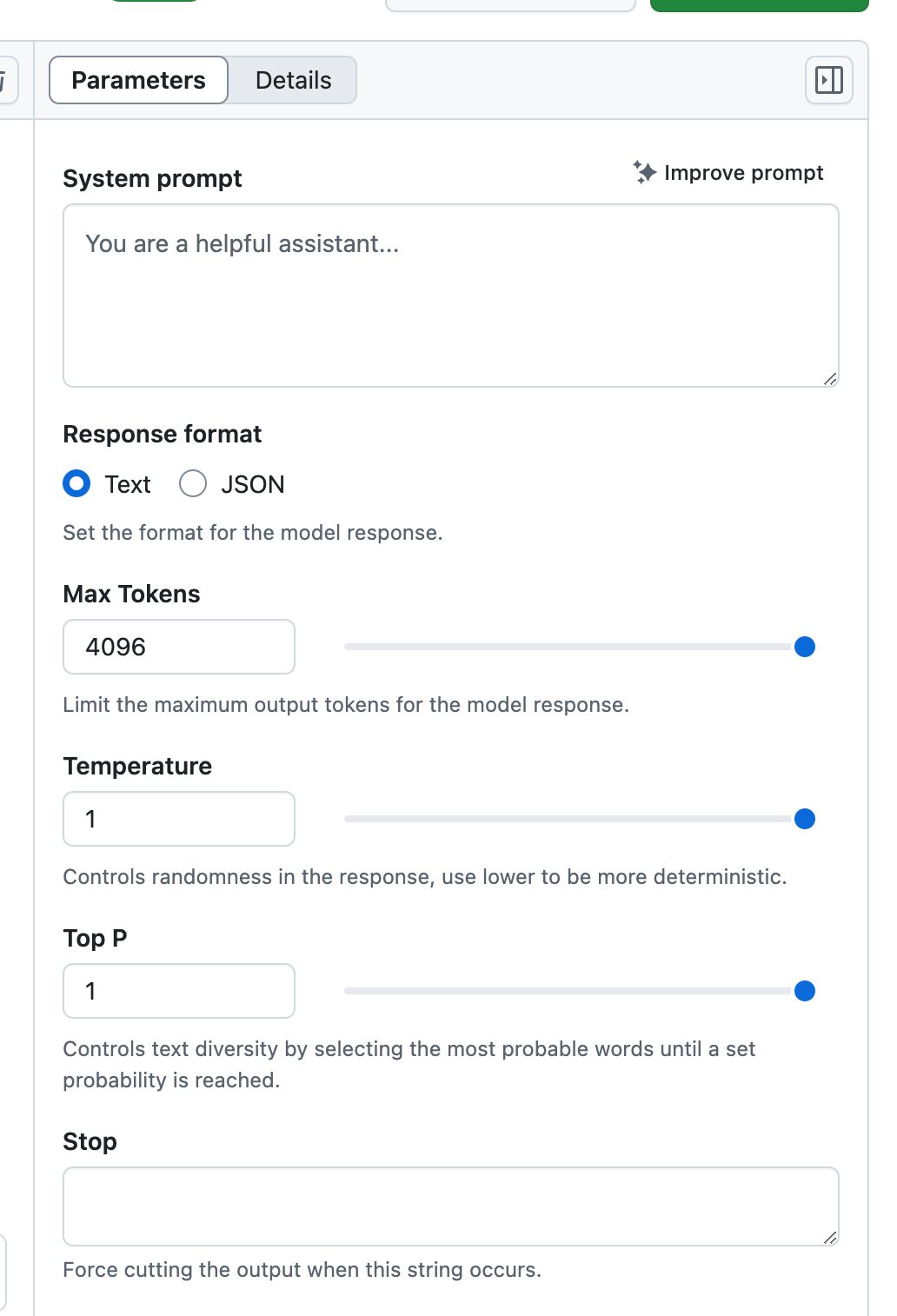

Playgroundは単なるモデルテスト環境ではなく、完全なAIラボなのだ:

- リアルタイム・パラメーター調整::

- 温度制御

- 最大トークン数設定

- トップ-pサンプリング調整

- システム・プロンプトの最適化

- マルチモデルの比較::

複数のモデルを同時に開いて比較テストを行い、同じ入力で異なるモデルのパフォーマンスの違いを視覚化することができます。 - 歴史の保存::

すべての実験手順は、その後の検討と最適化のために記録される。

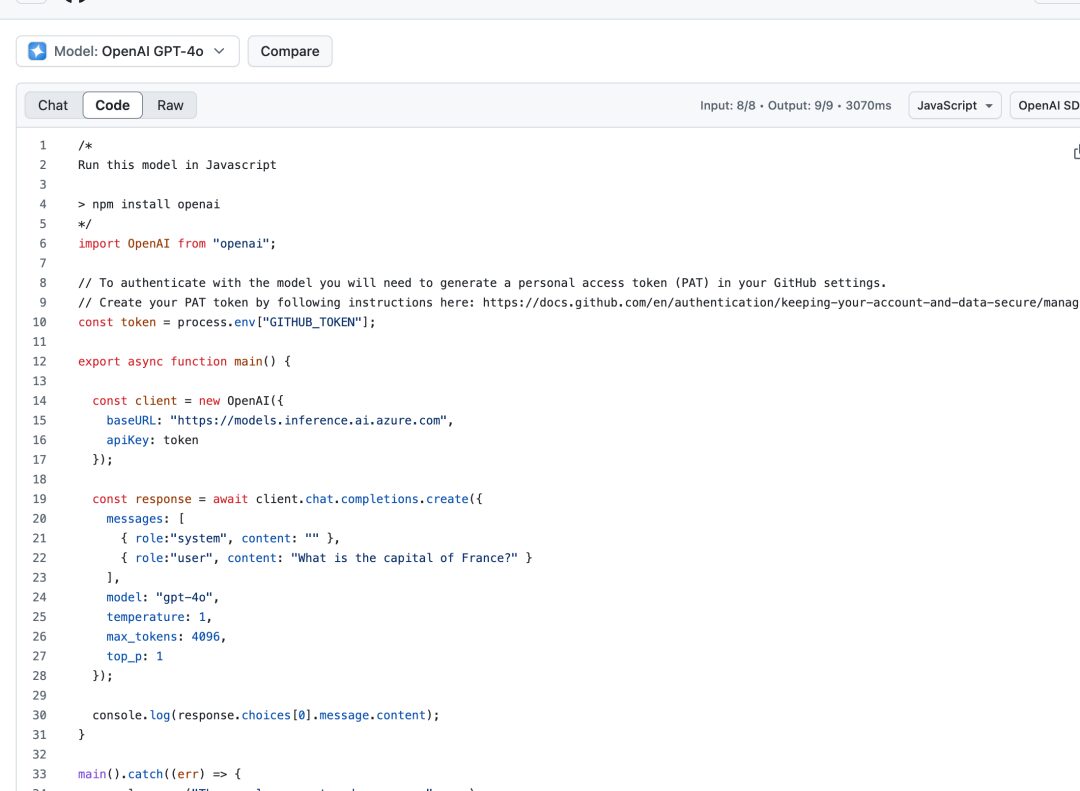

2.コードスペースのシームレスな統合

Codespacesの統合は、開発プロセスを驚くほどスムーズにする:

- 設定済み環境::

必要な依存関係や設定はすべて箱から出してすぐに使える。 - 多言語サポート::

Python、JavaScript、Java、その他主要言語用のサンプルコードとSDKを提供。

- バージョン管理::

GitHubリポジトリとの直接統合により、コード変更管理が容易になります。

3.エンタープライズレベルの展開保証

Azure AIのサポートにより、エンタープライズレベルのデプロイはシンプルで信頼性の高いものになります:

- グローバル展開::

25以上のAzureリージョンから選択できるため、世界中のユーザーが迅速にアクセスできる。 - 安全コンプライアンス::

企業レベルのセキュリティ標準に準拠し、データの暗号化とアクセス制御をサポートします。 - スケーラビリティ::

サービスの安定性を確保するため、需要に応じてリソースを自動的に拡張します。

クオータ制の徹底分析

異なるバージョンの利用クォータの設計は、GitHubの製品戦略を反映しています:

無料版とCopilot Individual

- 毎分リクエスト数:10

- 1日のノルマ:50

- トークンの制限:

- 入力:8000

- 出力:4000

- 同時リクエスト数:2

この枠は、プロジェクトの検証や学習のための個人開発者に適している。

コパイロット事業

- コンカレンシーとトークンの制限を同じにする。

- 毎日のリクエストを100件に

- 小規模チームの開発ニーズに最適

コパイロット・エンタープライズ

- 1分間のリクエスト数:15

- 1日のノルマ:150

- トークンの上限を大きくする:

- 入力:16000

- 出力:8000

- 同時リクエスト数:4

- 企業レベルのアプリケーション開発に最適

実践的なヒント

開発効率向上のヒント

- インテリジェント・キャッシング・ポリシー

# 示例代码:实现简单的结果缓存 import hashlib import json class ModelCache: def __init__(self): self.cache = {} def get_cache_key(self, prompt, params): data = f"{prompt}_{json.dumps(params, sort_keys=True)}" return hashlib.md5(data.encode()).hexdigest() def get_or_compute(self, prompt, params, model_func): key = self.get_cache_key(prompt, params) if key in self.cache: return self.cache[key] result = model_func(prompt, params) self.cache[key] = result return result - バッチ処理の最適化

リクエストのバッチを賢く整理して、頻繁なAPIコールを避ける。 - エラー処理のベストプラクティス

一時的な失敗を処理するために、インテリジェントな再試行メカニズムを実装する。

安全に関する推奨事項

- アクセストークンの管理

- レギュラー・ローテーション 個人アクセス トークン

- 最小特権の原則の使用

- コード内のトークンのハードコーディングは避ける

- データ機密保護

- モデルに送信する前にデータを減感

- データアクセス監査の有効化

- セキュリティ・ログの定期的なチェック

先を見る

ギットハブCEOのトーマス・ドームケのビジョンは、世界が今後数年で10億人の開発者という目標を達成するのを支援することだ。この野心の背景には、AIの民主化に対する強い信念がある。

今すぐAIエンジニアの旅を始めよう!

- 出願準備

- GitHubの公式モデルページを見る

- ウェイティング・リスト申請

- GitHubアカウントと個人アクセストークンを用意する

- 環境設定

import OpenAI from "openai"; const token = process.env["GITHUB_TOKEN"]; const client = new OpenAI({ baseURL: "https://models.inference.ai.azure.com", apiKey: token }); - 実験開始

- プレーグラウンドでさまざまなモデルをテスト

- サンプルコード付きクイックスタートプロジェクト

- アプリケーション機能の段階的拡大

結語

AIテクノロジーの進化は、ソフトウェア開発の未来を再構築しています。GitHub Modelsのローンチは、単なる新製品の誕生ではなく、新しい時代の幕開けです。すべての開発者がAI革命に参加し、革新的なアイデアと実践で世界を変える機会を提供します。

今、あなたの目の前にあるのは、AI開発を始めるかどうかという問題ではなく、GitHub Modelsという強力なプラットフォームをどのように活用し、AIエンジニアの道をさらに進むかという問題です。チャンスはそこにあります。

ある上級開発者は、「GitHub Modelsは単なるツールではなく、AI時代を切り開く鍵です。これを使えば、すべての開発者がAIエンジニアになることができ、あらゆるアイデアが現実になります。"

さあ、AI開発の旅に出発だ。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません