メタ:大規模言語モデルへの適応(実用化)アプローチ

原文ママ

https://ai.meta.com/blog/adapting-large-language-models-llms/

https://ai.meta.com/blog/when-to-fine-tune-llms-vs-other-techniques/

https://ai.meta.com/blog/how-to-fine-tune-llms-peft-dataset-curation/

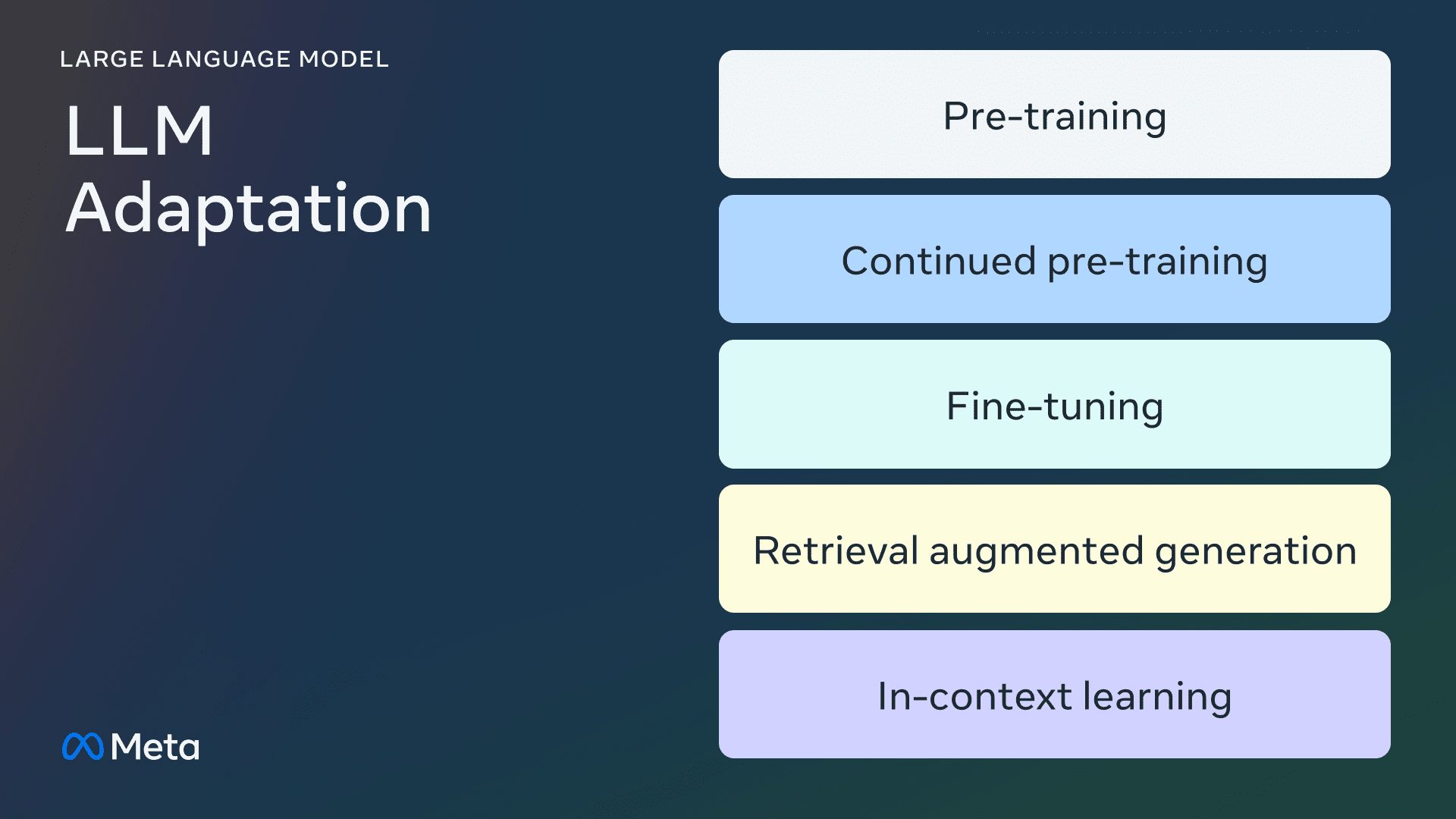

オープンソースの大規模言語モデル(Large Language Models:LLM)の適応に関する3回シリーズの最初のブログ記事です。この記事では、LLMをドメイン・データに適応させるために利用できる様々な方法について学びます。

紹介

様々な言語タスクや自然言語処理(NLP)における大規模言語モデル(LLM) ベンチマーキングこうした "汎用 "モデルに基づく製品のユースケースが増加している。このような "一般的な "モデルに基づく製品のユースケースの数は増加している。このブログポストでは、LLMを自分たちのプロジェクトに適応させ、統合しようとしている小規模なAI製品チームのためのガイダンスを提供します。まず、LLMにまつわる(しばしば混乱しがちな)用語を明確にすることから始め、次に、利用可能なさまざまな適応アプローチを簡単に比較し、最後に、ユースケースに適したアプローチを決定するためのステップ・バイ・ステップのフローチャートをお勧めします。

LLM適応法

事前トレーニング

事前トレーニングとは、何兆ものデータを使用することである。 トークン LLMをゼロからトレーニングするプロセス。モデルは自己教師ありアルゴリズムを使って学習される。最も一般的な訓練は、自己回帰によって次のモデルを予測する。 トークン を実行する(別名、因果言語モデリング)。事前学習には、通常、数千GPU時間(105 - 107 [1])を必要とする。ソース1, ソース2])が複数のGPUに分散される。事前に訓練された出力モデルは 基本モデル.

継続的な事前トレーニング

継続的な事前学習(2段階事前学習とも呼ばれる)では、新しい未知のドメインデータを使用してベースモデルをさらに学習する。最初の事前学習と同じ自己教師ありアルゴリズムが使用される。通常、すべてのモデルの重みを含み、元のデータの一部を新しいデータと混合する。

微調整

ファインチューニングとは、教師ありの方法で、または強化学習ベースの技術を用いて、注釈付きデータセットを使用して、事前に訓練された言語モデルを適応させるプロセスである。事前学習との主な違いは2つある:

- 正しいラベル/回答/プリファレンスを含む注釈付きデータセットに対する教師あり学習 - 自己教師あり学習ではない

- 必要なトークンの数は少なく(事前訓練に必要な数十億、数兆ではなく、数千、数百万)、コマンドの追従性、人間のアライメント、タスクのパフォーマンスなどを高めることが主な目的である。

現在のファインチューニング・グリッドを理解するには、パラメーターの変更率と、ファインチューニングの結果追加された新しい能力という2つの側面がある。

パラメータの変更率

パラメータを変更する数によって、2種類のアルゴリズムがある:

- 完全に微調整されている: その名の通り、XLMRやBERT(1億~3億のパラメータ)のような小規模なモデルの伝統的な微調整を含め、モデルのすべてのパラメータを変更することになる。 ラマ2GPT3のような大規模モデル(10億以上のパラメータ)のファインチューニング。

- パラメータ効率的微調整(PEFT): すべてのLLM重みを微調整するのとは異なり、PEFTアルゴリズムは、少数の追加パラメーターを微調整するか、事前学習パラメーターのサブセットを更新するだけである。

ベースモデルへの追加能力

ファインチューニングを行う目的は、事前に訓練されたモデルに機能を追加することです。例えば、指示の順守、人間のアライメントなどです。対話チューニングのためのLlama 2は、ファインチューニングされたモデルで、指示の順守やアライメントを追加する機能を備えています。 典型例.

検索強化世代 (ラグ)

組織はまた、ドメイン固有の知識ベースを追加することで、LLMに適応することができる。RAGは本質的に「検索駆動型LLMテキスト生成」である。2020年に開始されるRAGは、ユーザーの質問に基づいて検索され、LLMのヒントが注入されたダイナミックキューイングコンテキストを使用して、事前に訓練された-そして潜在的に古い-知識の代わりに、検索されたコンテンツを使用するように誘導する。-知識。チャットLangChain は、RAGを搭載したLangChainドキュメントQ&Aチャットボットの一般的な例です。

コンテクスチュアル・ラーニング(ICL)

ICLでは、プロンプトの中にプロトタイプの例を配置することでLLMを適応させており、いくつかの研究で「例によるデモンストレーション」が効果的であることが示されている。これらの例には、さまざまなタイプの情報を含めることができる:

プロンプトを修正するための戦略は他にもいろいろある。先端技術ガイド包括的な概要が含まれている。

正しい適応方法の選択

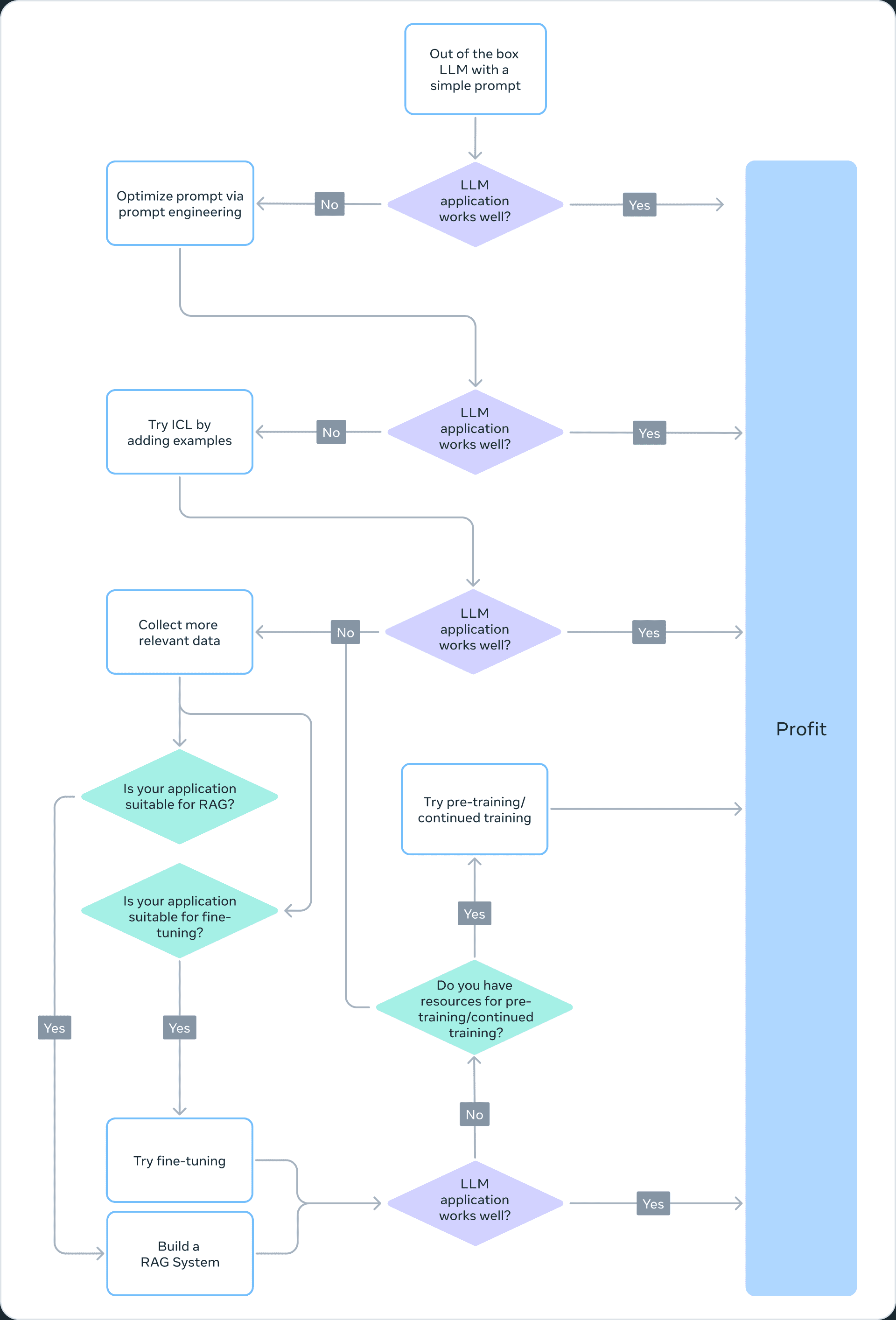

上記のどの手法が特定のアプリケーションに適しているかを決定するためには、追求するタスクに必要なモデルの能力、学習コスト、推論コスト、データセットのタイプなど、様々な要因を考慮する必要があります。以下のフローチャートは、適切な大規模言語モデル(LLM)適応法を選択するための推奨事項をまとめたものです。

事前トレーニング

事前トレーニングはLLMトレーニングの重要な部分であり、トークン予測変種を損失関数として使用する。LLMは自己教師型であるため、大量のデータで学習することができる。例えば、Llama 2は2兆個のトークンで学習された。これには大規模な計算インフラが必要である:Llama 2 70Bのコスト 1,720,320GPU時間.したがって、リソースが限られているチームにとって、LLM適応のための有効な方法として事前トレーニングを推奨することはできない。

事前学習は計算効率が悪いため、事前学習済みのモデルの重みを更新することが、LLMを特定のタスクに適応させる効果的な方法となる。事前に訓練されたモデルの重みを更新するどのようなアプローチも、壊滅的忘却という現象の影響を受けやすい。例えば本研究によると、医療領域で微調整されたモデルは、指示に従うタスクや一般的な質問と回答のタスクのパフォーマンスが低下することが示されている。他の研究でも、事前トレーニングで得た一般的な知識が、その後のトレーニングで忘れられてしまう可能性があることが示されている。例えば本研究ドメイン知識、推論、読解力に関して、LLMの知識忘却の証拠がいくつか示されている。

❌ 継続的な事前トレーニング

忘却を考慮すると、最近の進展は、継続的事前訓練(CPT)が事前訓練に必要な計算コストのほんの一部で性能をさらに改善できることを示唆している。CPTは、LLMが新たな変換スキルを獲得する必要のあるタスクに有効であると考えられる。例えばと報じられている。継続的な事前トレーニングは、多言語能力を高めることに成功している。

しかし、CPTは依然として、多大なデータと計算資源を必要とする高価なプロセスである。例えば、Pythiaスイートは2段階目の事前学習を行い、その結果として フィンピシア-6.9Bこのモデルは金融データ用に設計されている。金融データ用に特別に設計されたこのモデルは、240億トークンを含むデータセットを用いて18日間のCPTを行った。さらに、CPTは壊滅的な忘却を起こしやすい。したがって、リソースが限られているチームにとって、LLM適応の実行可能なアプローチとして継続的な事前学習を推奨しない。

結論として、(事前学習や継続的な事前学習で行われるように)LLMを適応させるために自己教師付きアルゴリズムやラベルなしのデータセットを使用することは、リソース集約的でコストがかかるため、実行可能なアプローチとしては推奨されない。

フル微調整とパラメトリック・エフィシェント・ファインチューニング(PEFT)

より小さなラベル付きデータセットによるファインチューニングは、ラベルなしのデータセットによる事前学習よりも費用対効果の高いアプローチである。事前訓練されたモデルを特定のタスクに適応させることで、ファインチューニングされたモデルは、幅広いアプリケーションや専門分野(法律、医療、金融など)において最先端の結果を達成することが示されている。

ファインチューニング、特にPEFT(Parameter Efficient Fine-Tuning)は、事前学習/連続事前学習に必要な計算リソースのほんの一部しか必要としない。したがって、これはリソースが限られているチームにとって実行可能なLLM適応手法である。このシリーズではパート3この本では、フル・ファイン・チューニング、PEFT、そしてファイン・チューニングの実践ガイドなど、ファイン・チューニングの詳細について掘り下げている。

✅ 拡張世代(RAG)の取得

RAGはもう一つのよく使われるLLM適応手法である。アプリケーションが動的な知識ベース(例えばクイズボット)から情報を抽出する必要がある場合、RAGは良い解決策になるかもしれない。RAGベースのシステムの複雑さは、主に検索エンジンの実装にある。ヒントには検索された文書が含まれ、ほとんどのプロバイダはトークンベースのモデルを使用しているため、このようなシステムの推論コストは高くなる可能性がある。この一連のパート2この中で、RAGについてより広く論じ、微調整と比較する。

✅ 文脈学習(ICL)

これはLLM.ICLを適応させる最も費用対効果の高い方法である。ICLは追加の学習データや計算リソースを必要としないため、費用対効果の高いアプローチとなる。しかし、RAGと同様に、推論時に多くのトークンを処理するため、推論のコストと待ち時間が増加する可能性がある。

概要

LLMベースのシステム作りは、反復プロセスです。シンプルなアプローチから始め、ゴールに到達するまで徐々に複雑さを増していくことをお勧めします。上記のフローチャートは、この反復プロセスの概要を示しており、LLM適応戦略の強固な基礎となります。

礼状

このブログ記事の構成と準備について建設的な意見を寄せてくれたSuraj SubramanianとVarun Vontimittaに感謝したい。

パートII:微調整をするかしないか

これは、オープンソースの大規模言語モデル(LLM)の適応に関する一連のブログ投稿の2回目です。今回は、"どのような場合に微調整を行い、どのような場合に他の技術を考慮すべきか "という疑問について説明します。

紹介

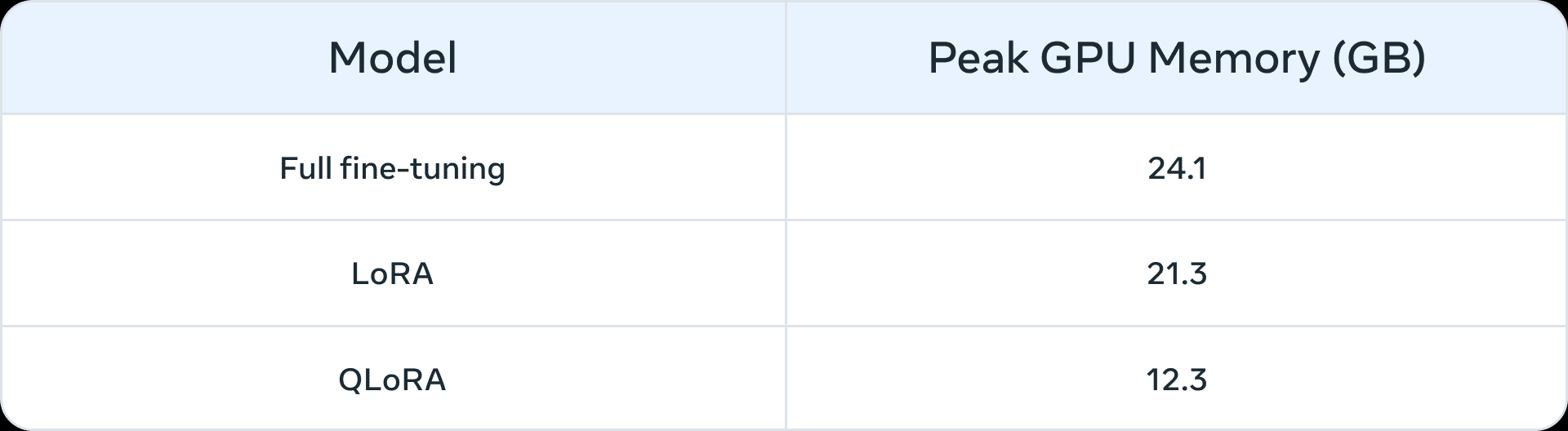

大規模な言語モデルが台頭する以前は、ファインチューニングは小規模なモデル(1億~3億パラメータ)によく使われていた。最も高度なドメイン・アプリケーションは、教師ありファインチューニング(SFT)を使用して構築されました。つまり、事前にトレーニングされたモデルは、独自のドメインや下流のタスクからアノテーションされたデータを使用してさらにトレーニングされました。しかし、より大規模なモデル(10億以上のパラメータ)の出現により、ファインチューニングの問題はより微妙になる。最も重要なことは、より大きなモデルは、微調整のために、より多くのリソースと商用ハードウェアを必要とすることである。以下の表1は、Llama 2 7BおよびLlama 2 13Bモデルを3つのシナリオで微調整したときのGPUメモリ使用量のピークを示しています。次のようなモデルがあることにお気づきでしょう。 QLoRA このようなアルゴリズムにより、限られたリソースで大規模モデルの微調整が容易になります。例えば、表1は、Llama 2 7Bにおける3つの微調整シナリオ(完全微調整、LoRA、QLoRA)のGPUメモリのピーク値を示しています。パラメトリック効率的ファインチューニング(PEFT)または定量化の結果としての同様のメモリ削減は、Llama 1でも示されています。 報告 オーバー。コンピューティング・リソースに加えて、大惨事の忘却(詳しくは、このシリーズの 前編PEFT技法は、少数のパラメータを訓練することで、これらの欠点に対処することを目的としている。

表1: LLama 2 7Bのメモリ(GB)と微調整方法(すじQLoRAは4ビットのNormalFloatを用いて定量化される。

表1: LLama 2 7Bのメモリ(GB)と微調整方法(すじQLoRAは4ビットのNormalFloatを用いて定量化される。

微調整が必要なプロトタイプ

我々は、微調整の恩恵を受けることができる一般的なユースケースとして、以下のシナリオを特定した:

- トーン、スタイル、フォーマットのカスタマイズ ユースケースによっては、特定のパーソナリティを反映するビッグランゲージモデルや、特定のオーディエンスに対応するビッグランゲージモデルが必要になる場合があります。カスタムデータセットを使用してビッグランゲージモデルを微調整することで、チャットボットの応答が特定の要件やオーディエンスの意図するエクスペリエンスにより近くなるように形成することができます。また、例えばJSON、YAML、Markdown形式など、特定の方法で出力を構造化したい場合もあります。

- 精度を高め、エッジケースに対処する: ファインチューニングは、キューエンジニアリングや文脈学習によって修正することが困難な錯覚やエラーを修正するために用いることができる。また、キューで表現することが難しい新しいスキルやタスクを実行するモデルの能力を向上させることもできる。このプロセスは、モデルが複雑なキューに従うことができない失敗を修正し、望ましい出力を生成する信頼性を向上させるのに役立ちます。2つの例を示す:

- 金融データのセンチメント分析におけるPhi-2の精度 34%から85%へアップグレード.

- チャットGPT Redditコメント感情分析の精度 25ポイント増 (48%から73%まで)、100例のみを使用。

通常、初期精度数が小さい場合(< 50%)、数百例で微調整を行うことで大幅な改善が得られます。

- 代表者の少ない分野に取り組む: 大規模な言語モデルは大量の汎用データで学習されるが、ニッチな各ドメインのニュアンスに富んだ専門用語、専門用語、特殊性に必ずしも精通しているとは限らない。法律、医療、金融などの多様なドメインでは、ファインチューニングが下流タスクの精度向上に役立つことが示されている。2つの例を挙げる:

- このように 文 患者の医療記録には、通常公開されていない非常に機密性の高いデータが含まれていることが指摘されている。したがって、医療記録を要約するための大規模言語モデルに基づくシステムは、微調整が必要である。

- PEFTテクニックを用いた、インド系言語など存在感の薄い言語の微調整 あらゆる仕事に役立つ.

- コスト削減: ファインチューニングにより、Llama 2 70B/GPT-4のような大型モデルからLlama 2 7Bのような小型モデルへのスキルの抽出が可能になり、品質を損なうことなくコストと待ち時間を削減できます。さらに、微調整を行うことで、(キュー・エンジニアリングで使用されるような)長いキューや特定のキューの必要性を減らすことができ、それによってトークンを節約し、さらにコストを削減することができます。例えばこの記事 GPT-3.5のジャッジを微調整するために、より高価なGPT-4モデルを改良することで、いかにコスト削減を達成できるかを示す。

- 新しいタスク/能力: 多くの場合、微調整によって新たな能力を達成することができる。ここでは3つの例を挙げる:

- 大規模言語モデルの微調整 検索者の文脈をよりよく利用する あるいは完全に無視する

- 大規模言語モデルの微調整 他の大規模言語モデルを評価する審査員新システムの場合、真実性、コンプライアンス、有用性といった指標を評価することは当然のことではない。

- 大規模言語モデルの微調整 コンテキストウィンドウの追加

他地域の適応技術との比較

微調整 vs. 状況に応じた(サンプル数の少ない)学習

文脈学習(ICL)は、大規模な言語モデルに基づくシステムのパフォーマンスを向上させる強力な方法である。また、ICLの実験は、微調整が下流のタスクのパフォーマンスを向上させるかどうかを評価するのに役立ちます。ICLを使用する際の一般的な考慮事項は以下のとおりです:

- 示すべき例の数が増えれば、推論コストとレイテンシも増える。

- 事例が増えるにつれ、大きな言語モデル しばしば見落とされがちなのが.つまり、入力に基づいて最も関連性の高い例を見つけるRAGベースのシステムが必要かもしれない。

- 大規模な言語モデルは、例として与えられた知識を吐き出すことがある。この問題は微調整の際にも存在する。

微調整 対 およびRAG

一般的なコンセンサスは、大規模な言語モデルの根本的な性能が不満足な場合、「RAGから始めて、その性能を評価し、不十分であることがわかったらファインチューニングに移行する」、あるいはファインチューニングよりも「RAGの方が利点があるかもしれない」というものだ(すじ).しかし、多くの場合、RAGはファインチューニングの代替とならないだけでなく、ファインチューニングを補完するアプローチであるため、このパラダイムは単純化しすぎであると我々は考えている。問題の特性に応じて、どちらか、あるいは両方のアプローチを試みるべきである。RAGの使用 この記事 という枠組みで、ファインチューニングとRAGのどちらが(あるいは両方が)あなたの問題に適しているかを判断するための質問をいくつか挙げてみよう:

- あなたのアプリケーションは外部の知識を必要としていますか?微調整は通常、新しい知識を注入することには当てはまらない。

- あなたのアプリは、カスタム・トーン/ビヘイビア/語彙/スタイルを必要としますか?このようなタイプの要求に対しては、通常、微調整が正しいアプローチです。

- あなたのアプリケーションは幻覚に対してどの程度寛容ですか?虚偽や想像による捏造の抑制が重要なアプリケーションでは、RAGシステムは幻覚を最小限に抑えるための組み込みメカニズムを提供します。

- ラベル付けされたトレーニングデータはどのくらい利用可能か?

- データはどの程度静的か動的か?もし問題が動的なコーパスのデータにアクセスする必要がある場合、大きな言語モデルの知識はすぐに古くなってしまうため、ファインチューニングは適切なアプローチではないかもしれない。

- 大規模な言語モデリング・アプリケーションには、どの程度の透明性/解釈可能性が必要ですか?RAGは基本的に、大規模な言語モデリング出力を解釈するのに有用な参照を提供することができます。

- コストと複雑さ:チームに検索システム構築の専門知識があるか、微調整の経験があるか。

- アプリのタスクはどれくらい多様ですか?

ほとんどの場合、ファインチューニングとRAGのハイブリッドソリューションが最良の結果を生むでしょう。RAGやファインチューニングが必要かどうかの判断の指針として上記の質問を参照し、可能性のあるメトリクスの利点を理解するためにエラーを分析して内部実験を行う。最後に、ファインチューニングの探求には、しっかりとしたデータ収集とデータ改善戦略が必要です。

礼状

このブログ記事の構成と準備について建設的な意見を寄せてくれたSuraj SubramanianとVarun Vontimittaに感謝したい。

パートIII:微調整の方法:効果的なデータセットに注目する

オープンソースの大規模言語モデル(LLM)の適応に関するブログシリーズの3回目の投稿です。この記事では、良質なトレーニングデータセットを作成するための経験則について見ていきます。

紹介

LLMのファインチューニングはアートとサイエンスの組み合わせであり、この分野におけるベストプラクティスはまだ生まれていない。このブログポストでは、ファインチューニングの設計変数に焦点を当て、リソースに制約のある環境におけるモデルのファインチューニングのベストプラクティスについて方向性を示します。ファインチューニング実験の戦略を立てるための出発点として、以下の情報を提案する。

フル・ファイン・チューニングとパラメトリック・エフィシェント・ファイン・チューニング(PEFT)の比較

の微調整とPEFTをフル活用 アカデミー 歌で応える 実用 これらはすべて、新しいドメインに適用した場合にダウンストリームのパフォーマン スを向上させることが示されています。最終的にどれを選択するかは、利用可能な計算リソース(GPU時間とGPUメモリ)、ターゲットとするダウンストリームタスク以外のタスクでのパフォーマンス(learn-to-forgetトレードオフ)、および手動アノテーションのコストに依存する。

フルボリュームの微調整は、2つの問題に悩まされる可能性が高い:モデルクラッシュ 歌で応える 激変的忘却.モデル崩壊とは、モデルの出力が有限の出力集合に収束し、元の内容分布の尾が消えることである。破局的忘却とは、このシリーズのように 前編 を議論することは、モデルの力を失わせることになる。いくつかの初期の実証的研究は、次のことを示している。PEFT技術に比べ、フルボリュームの微調整技術は以下のような問題が起こりやすい。もっと研究が必要だが。

PEFT技法は、微調整のための自然な正則化器として機能するように設計することができる。PEFTは通常、下流モデルの訓練に必要な計算リソースが比較的少なく、データセットサイズが限られているリソース制約のあるシナリオで使用しやすい。場合によっては、完全なファインチューニングの方が特定のタスクで優れた性能を発揮することもあるが、通常は元のモデルの能力の一部を忘れてしまうという代償を払うことになる。この「学習と忘却」のトレードオフは、特定の下流タスクでの性能と他のタスクでの性能との間で、より容易に利用される。 本稿では、このように述べた。 LoRAとフル・ファイン・チューニングの詳細な比較は、こちらで紹介している。

リソースの制約がある場合、PEFT技法はフルボリューム・ファインチューニングよりも性能向上/コスト比が良い可能性がある。リソースの制約がある状況でダウンストリームのパフォーマンスが重要な場合は、フルボリュームのファインチューニングが最も効果的です。いずれの場合でも、高品質のデータセットを作成するためには、以下の主要原則に留意することが重要である。

データセットの照合

文献におけるファインチューニング実験では、ファインチューニングのメリットを享受するためにデータセットが重要である。ここには単に「より良い品質とより多くの例」というだけではないニュアンスがあり、リソースに制約のあるファインチューニング実験でパフォーマンスを向上させるために、データセット収集に賢く投資することができる。

データの質/量

- 品質は非常に重要だ: 一般的な傾向として、量より質が重要である、つまり質の低い大量のデータより、質の高い少量のデータの方が良いということが分かっている。質の重要な原則は、一貫性のあるラベリング、エラーのないデータ、ミスラベリングされたデータ、ノイズの多い入力/出力、全体と比較した代表的な分布である。を微調整する場合LIMAデータセット 数千の入念に管理された例から構成されるアルパカ・データセットは、5万個の機械によって生成されたアルパカ・データセットよりも優れた結果を示した。OpenAI微調整ドキュメント 50から100例のデータセットでも影響を与える可能性が示唆されている。

- より難しい言語タスクは、より多くのデータを必要とする: テキスト生成や要約のような比較的難しいタスクは、分類やエンティティ抽出のような単純なタスクよりも微調整が難しく、より多くのデータを必要とする。この文脈での "難しい "とは、出力に含まれるトークンの数、必要とされる高次の人間の能力、複数の正解など、さまざまなことを意味する。

- 効果的で質の高いデータ収集: データ収集には高いコストがかかるため、サンプルの効率を高め、コストを削減するために、以下の戦略が推奨される。

- 失敗パターンを観察する:失敗した過去のML機能の例を観察し、それらの失敗パターンに対処する例を追加する。

- 人間と機械のコラボレーション:これはデータアノテーションの規模を拡大する安価な方法である。私たちはLLMを使用してベース・レスポンスの生成を自動化し、人間のアノテーターがより短時間でアノテーションを行えるようにしています。

データの多様性

簡単に言うと、ある特定のタイプの回答でモデルを過剰に訓練すると、最も適切な回答ではないにせよ、その回答をするように偏ってしまう。ここでの経験則は、学習データが現実世界でのモデルの振る舞いをできるだけ反映していることを確認することです。

- 繰り返す: は 発見 は、ファインチューニングや事前学習におけるモデル劣化の原因である。重複排除による多様性の実現は、通常、パフォーマンス指標を向上させる。

- 入力の多様性: インプットの言い換えで多様性を高めるでの SQLCoder2の微調整 チームは、SQLクエリに付随するプレーンテキストを再定式化し、構文と意味の多様性を導入した。同様に指示の逆翻訳 手動で書かれたテキストに対して、LLMに "これはどのような質問に対する答えでしょうか?"と質問することで、質問と答えのデータセットを生成した。 と問いかけ、質問と回答のデータセットを生成した。

- データセットの多様性: より一般的な下流タスク、例えば多言語適応のためにファインチューニングを行う場合、多様なデータセットを使用することで、モデルの元の能力の忘却と新しい能力の学習のトレードオフが改善されることが示されている。例えば ヒンディー語 歌で応える なんとうご ファインチューニング・モデルは、豊富な言語固有のデータセットと、次のような他のコマンドのファインチューニング・データセットを使用する。 フランそしてアルパカドリーらは多様性を導入した。

- 標準化された出力: 出力から空白を削除したり、その他のフォーマットのトリックが役に立つことがわかった。SQLCoder2 生成されたSQLから空白を取り除くことで、モデルはスペースやインデントのようなトリックではなく、重要なSQLの概念の学習に集中することができます。回答に特定のトーンが必要な場合"ヘルプデスクのチャットボットは..."というように、それぞれの例についてデータセットに追加します。

LLMベースのデータパイプライン

高品質で多様なデータセットを照合するために、データパイプラインはしばしばLLMを使用してアノテーションコストを削減している。実際には以下のような手法が見られる:

- 評価だ: 高品質なデータセットでモデルをトレーニングし、そのモデルを使用してより大きなデータセットに注釈を付け、高品質な例をフィルタリングする。

- 生成する: LLMに質の高い例をシードし、同様の質の高い例を生成するように促す。合成データセットのベストプラクティス が形になり始めている。

- 人間とコンピューターのコラボレーション: LLMを使って出力の初期セットを生成し、人間が編集したりプリファレンスを選択したりして品質を向上させる。

データセットのデバッグ

- データセットに悪い出力がないか評価する: モデルが特定の領域でまだ不十分な場合は、その領域を正しく処理する方法をモデルに直接示すトレーニング例を追加します。モデルに構文、ロジック、スタイルの問題がある場合は、同じ問題がないかデータをチェックします。例えば、モデルが「このミーティングは私が手配します」と言った場合(言うべきでない場合)、既存の例がモデルに対して、実際にはできない新しいことをできると教えていないか確認してください。

- プラスとマイナスのカテゴリーのバランスを再チェックする: データ中の60%ヘルパー・レスポンスが「その質問には答えられません」と言った場合、不合格が多すぎるかもしれませんが、5%レスポンスだけが推論時にそう言うべきです。

- 包括性と一貫性: トレーニング例には、応答に必要なすべての情報が含まれていることを確認してください。もしモデルにユーザーの個人的な特徴に基づいて褒めさせたい場合、トレーニング例には前のダイアログに現れなかった特徴に対するアシスタントの褒め言葉が含まれていると、モデルは情報をごまかすことを学習してしまうかもしれません。すべてのトレーニング例が推論時に期待されるものと同じ形式であることを確認してください。トレーニング例の一貫性をチェックする。複数の人がトレーニングデータを作成した場合、モデルの性能は対人関係の一貫性のレベルによって制限される可能性があります。例えば、テキスト抽出タスクの場合、70%の抽出されたセグメントについてしか意見が一致しない場合、モデルの性能が上がらない可能性があります。

評決を下す

ファインチューニングは、大規模な言語モデルの開発において重要な側面であり、芸術と科学の間の微妙なバランスを必要とする。データセットの品質とキュレーションは、ファインチューニングの成功に重要な役割を果たします。大きな言語の小さな微調整モデルは、特定のタスクにおいて大きなモデルを上回る傾向がある。.微調整の決定が下されたら ラマ微調整ガイド は確かな出発点を提供している。ファインチューニング・データセット・ポートフォリオの独占的性質は、ベストプラクティスの共有やオープンソースの進展を妨げてきた。この分野が進化し続けるにつれ、ファインチューニングの創造性と適応性を維持しつつ、共通のベストプラクティスが出現することを期待している。

礼状

このブログ記事の構成と準備について建設的な意見を寄せてくれたSuraj SubramanianとVarun Vontimittaに感謝したい。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません