MetaがLlama 3.2をリリース:次世代の1Bおよび3B小型言語モデルを導入

メタ社は最近、最新の言語モデルLlama 3.2を発表し、そのAI技術の範囲をさらに拡大した。この新バージョンでは、1B(10億)と3B(30億)のパラメータを持つより小さなモデルを導入し、特にリソースに制約のある環境において、より幅広いユーザーのニーズに応えることを目指している。

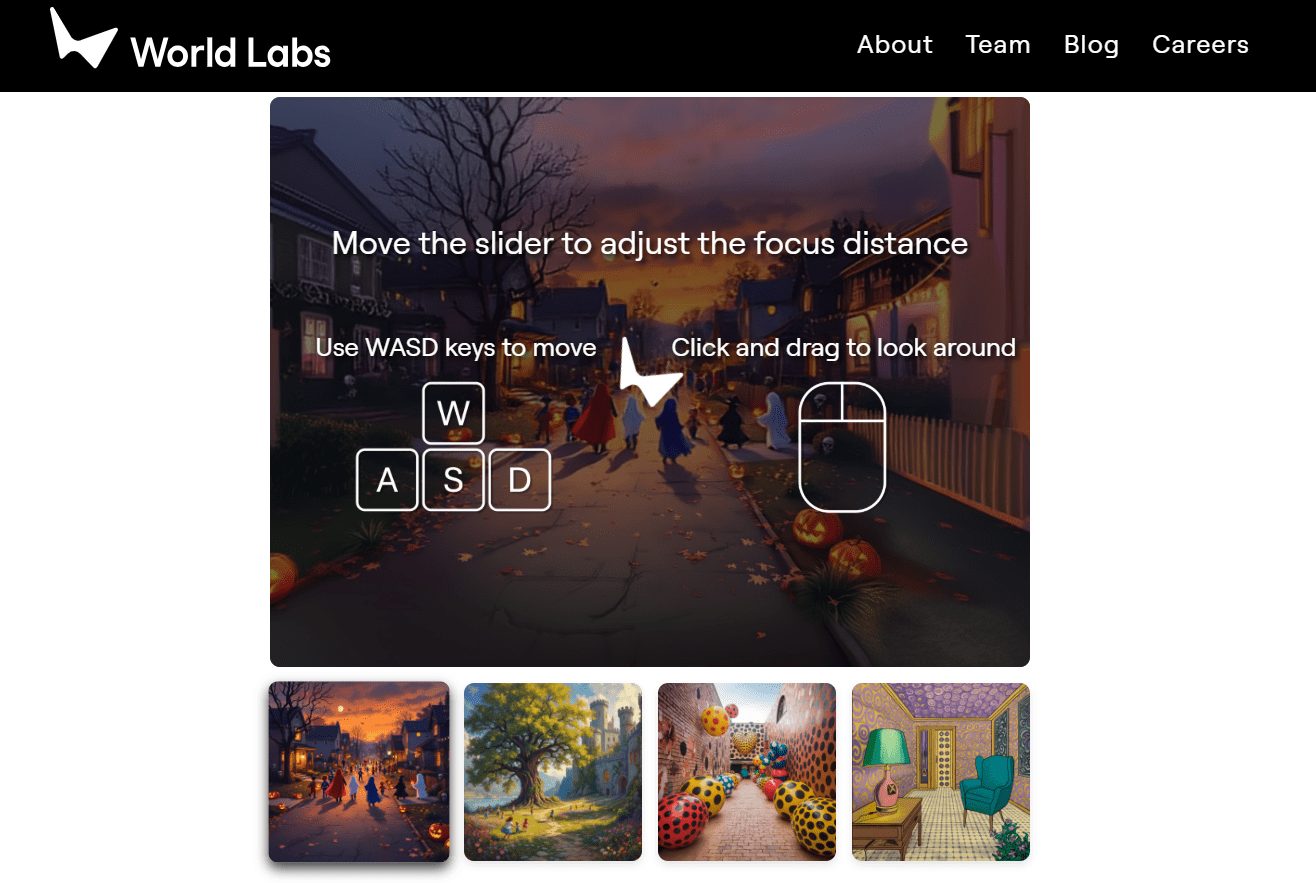

Llama 3.2は、パラメータ数を最適化するだけでなく、Q4_K_M定量化技術を採用することで、モデルのストレージ要件を大幅に削減し、パフォーマンスと効率のバランスをより良くしています。この革新的なアーキテクチャ設計により、開発者はLlama 3.2をモバイル機器やクラウド・コンピューティング・プラットフォームなど、さまざまなアプリケーション・シナリオに柔軟に導入することができます。

対応言語:英語、ドイツ語、フランス語、イタリア語、ポルトガル語、ヒンディー語、スペイン語、タイ語に正式対応。

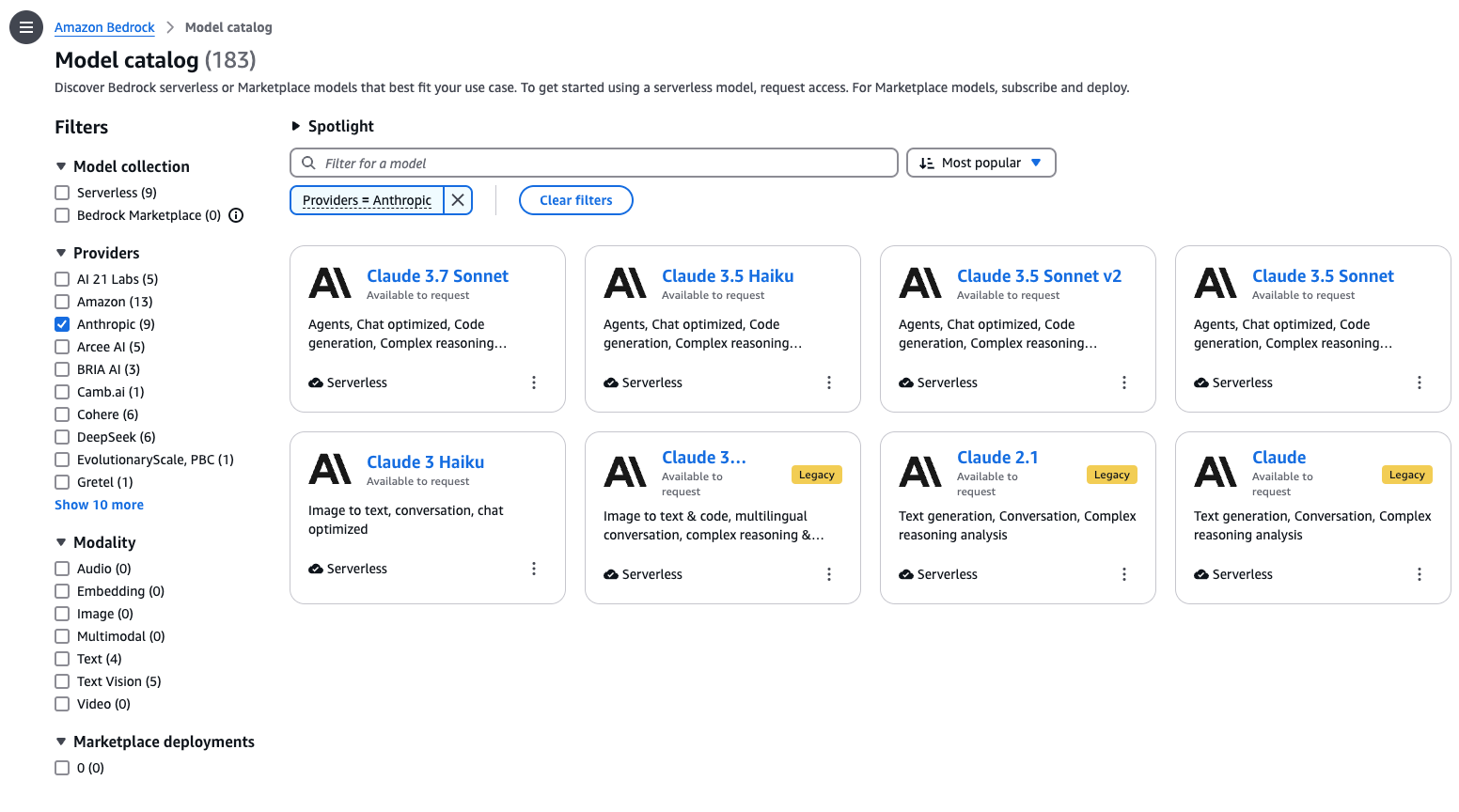

対照的に、Llama 3.2 Small (11B)とMedium (90B)の2つのバージョンは、マルチモーダル機能をサポートするモデルであり、画像理解タスクではクローズドソースのClaude 3 Haikuに勝っている。

高速体験のための推奨アップデート オラマ この3Bパラメータモデルは、指示に従う、要約する、即座に書き換える、道具を使うなどのタスクにおいて非常に安定している。同時に グロQ 90Bのパラメトリックモデルがオンラインで体験できるようになった。

このリリースは、メタ社のAIにおける継続的な革新を示すものであり、Llama 3.2の発表により、開発者や企業はあらゆる種類のアプリケーションを進化させ、開発するための可能性をさらに広げることができると期待されている。

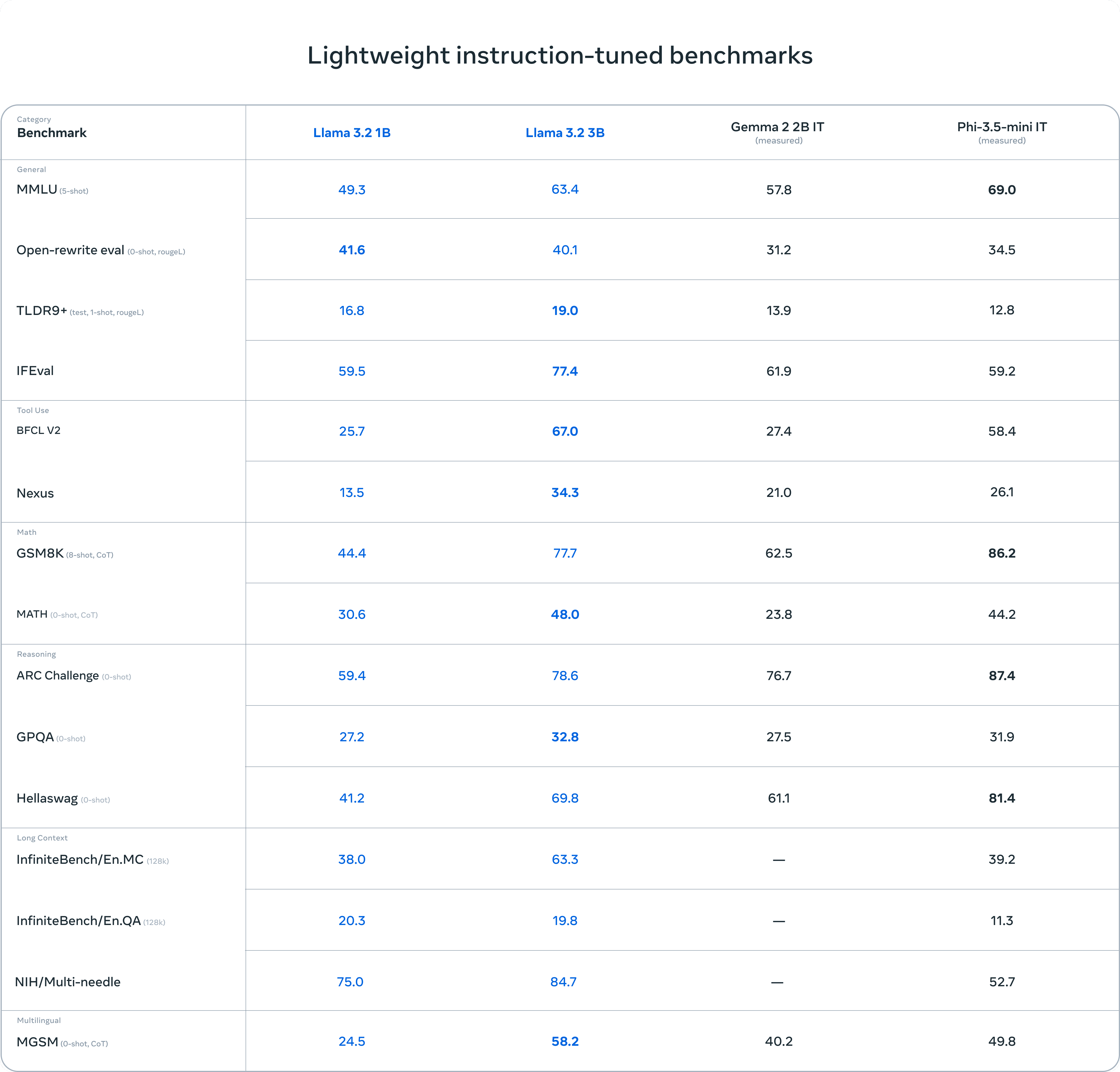

ベンチマーキング

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません