MegaTTS3:中国語音声と英語音声を合成する軽量モデル

はじめに

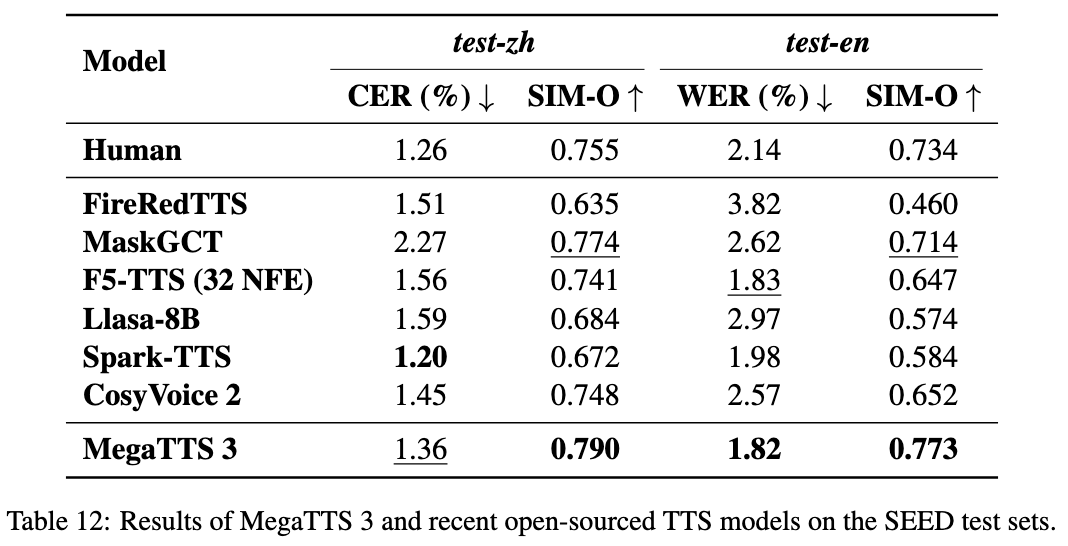

MegaTTS3は、ByteDanceが浙江大学と共同で開発したオープンソースの音声合成ツールで、高品質な中国語と英語の音声生成に重点を置いている。コアモデルのパラメータはわずか0.45Bで、軽量かつ効率的であり、中国語と英語の混在音声生成と音声クローニングをサポートしている。このプロジェクトはGitHubでホストされており、コードと訓練済みモデルを無料でダウンロードできる。MegaTTS3は数秒の音声サンプルでターゲット音声を模倣でき、アクセントの強弱の調整もサポートしている。学術研究、コンテンツ制作、音声アプリケーションの開発に適しており、将来的には発音や継続時間の制御機能も追加される予定です。

機能一覧

- 自然で滑らかな出力で中国語、英語、混合音声を生成します。

- 高品質の音声クローニングは、特定の音色を模倣した少量の音声で実現される。

- アクセントの強さの調整をサポートし、アクセントまたは標準的な発音で音声を生成することができます。

- モデルの学習効率を向上させるために音響潜在能力を使用する。

- 高品質のWaveVAEボコーダーを内蔵し、音声の明瞭度と臨場感を向上。

- 音声分析をサポートするために、アライナーとGraphme-to-Phonemeサブモジュールが用意されている。

- オープンソースコードと、ユーザー定義開発のための事前学習済みモデル。

ヘルプの使用

MegaTTS3は、基本的なプログラミング経験、特にPythonとディープラーニング環境の経験が必要です。以下はインストールと使用方法の詳細です。

設置プロセス

- 建築環境

MegaTTS3 推奨Python 3.9.これはConda仮想環境を作る:conda create -n megatts3-env python=3.9 conda activate megatts3-envアクティベーション後、すべての操作はこの環境で行われる。

- ダウンロードコード

ターミナルで以下のコマンドを実行し、クローンを作成する。GitHub倉庫:git clone https://github.com/bytedance/MegaTTS3.git cd MegaTTS3 - 依存関係のインストール

プロジェクト・オファーrequirements.txt必要なライブラリをインストールしたい場合は、以下のコマンドを実行する:pip install -r requirements.txtインストールにかかる時間はネットワークやデバイスによって異なりますが、通常は数分で完了します。

- モデルの入手

訓練済みモデルは、Google DriveまたはHugging Faceからダウンロードできる(公式リンクを参照)。README).ダウンロードして解凍し./checkpoints/フォルダ例- そうしれいかん

model.pthに入れる。./checkpoints/model.pth. - 抽出済み

latentsファイルは、指定されたリンクから同じディレクトリにダウンロードする必要があります。

- そうしれいかん

- 試験施工

簡単なテスト・コマンドを実行して環境を確認する:python tts/infer_cli.py --input_wav 'assets/Chinese_prompt.wav' --input_text "测试" --output_dir ./genエラーが報告されなければ、インストールは成功です。

主な機能

音声合成

音声の生成はMegaTTS3の中核機能である。テキストと参照音声の入力が必要です:

- 書類の準備

あるassets/フォルダをリファレンス・オーディオ(たとえばChinese_prompt.wavそしてlatentsファイル(例Chinese_prompt.npy).もしlatents事前に抽出された公式ファイルが必要です。 - コマンド実行

インプット:CUDA_VISIBLE_DEVICES=0 python tts/infer_cli.py --input_wav 'assets/Chinese_prompt.wav' --input_text "你好,这是一段测试语音" --output_dir ./gen--input_wavはリファレンス・オーディオ・パスである。--input_textは合成されるテキストである。--output_dirは出力フォルダである。

- 結果を見る

生成されたスピーチは./gen/output.wavフィルムは直接再生可能。

ボイスクローニング

特定の音を模倣するのに必要なオーディオサンプルはわずか数秒:

- クリアなリファレンス音声を用意する(5~10秒を推奨)。

- 上記の合成コマンドを使って

--input_wav. - 出力される音声は、リファレンス・トーンに限りなく近くなる。

アクセントコントロール

パラメータでアクセントの強さを調整する p_w 歌で応える t_w::

- 英語の音声をアクセント付きで入力する:

CUDA_VISIBLE_DEVICES=0 python tts/infer_cli.py --input_wav 'assets/English_prompt.wav' --input_text "这是一条有口音的音频" --output_dir ./gen --p_w 1.0 --t_w 3.0 p_wアプローチ1.0オリジナルのアクセントが保たれることもあり、標準的な発音が増える傾向にある。t_w音色の類似性をコントロールする。p_w御前0-3.- 標準化された発音を生成する:

CUDA_VISIBLE_DEVICES=0 python tts/infer_cli.py --input_wav 'assets/English_prompt.wav' --input_text "这条音频发音标准一些" --output_dir ./gen --p_w 2.5 --t_w 2.5

ウェブUIオペレーション

ウェブインターフェイスによる操作に対応:

- 走っている:

CUDA_VISIBLE_DEVICES=0 python tts/gradio_api.py - ブラウザを開き、アドレスを入力する(デフォルト)

localhost:7860)、音声とテキストをアップロードして音声を生成する。CPU環境下で約30秒。

サブモジュールの使用

アライナー

- 官能性音声とテキストの位置合わせ

- 使用状況走る

tts/frontend_function.pyの音声分割または音素認識のコード例です。

グラフからフォネームへ

- 官能性テキストを音素に変換します。

- 使用状況参考

tts/infer_cli.py発音分析に利用できる。

ウェーブVAE

- 官能性圧縮オーディオは

latentsそして再建された。 - 制約条件エンコーダのパラメータは公開されておらず、事前に抽出されたものしか使用できません。

latents.

ほら

- WaveVAEエンコーダのパラメータは、セキュリティ上の理由から使用できません。

latentsドキュメンテーション - このプロジェクトは2025年3月22日にリリースされ、現在も開発中で、新しい発音や期間の調整が予定されている。

GPU加速する推薦。CPU走るが遅い。

アプリケーションシナリオ

- 学術研究

研究者は、MegaTTS3を使って音声合成技術をテストし、次のような分析を行うことができます。latentsの効果である。 - 教材

教科書を音声に変換してオーディオブックを作成し、学習体験を向上させる。 - コンテンツ制作

ビデオやポッドキャスト用のナレーションを作成し、手作業による録音コストを節約。 - 音声対話

開発者はこれをデバイスに組み込んで、英語と中国語での音声対話を可能にすることができる。

品質保証

- 対応言語は?

中国語、英語、混合音声をサポートし、将来的には他の言語への拡張も可能。 - マスト

GPUわからない。

必要ない。CPU実行することは可能だが、速度が遅いので、次のような使い方を推奨する。GPU. - インストールに失敗した場合の対処法は?

更新pip(pip install --upgrade pip)、ネットワークのチェック、またはGitHub問題を提出する。 - WaveVAEのエンコーダーが見当たらないのはなぜですか?

安全上の理由で非公開、正式な事前抽出が必要latents.

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません