LocalGPT:ローカルデバイス上の複数のドキュメントと対話することで、データプライバシーを確保する

はじめに

LocalGPTは、ユーザーがローカルデバイス上のドキュメントと対話し、データのプライバシーを確保できるように設計されたオープンソースプロジェクトです。様々なオープンソースモデルを使用することで、LocalGPTはデータをクラウドにアップロードすることなく、ドキュメントコンテンツを処理し理解することができます。このプロジェクトは、GPU、CPU、HPU、MPSなどの複数のプラットフォームをサポートし、セッション履歴、APIインターフェース、GUIなどの豊富な機能を提供します。LocalGPTの設計目標は、高いプライバシー保護を必要とするシナリオのために、安全でプライベートなドキュメント対話環境をユーザーに提供することです。

機能一覧

- プライバシーすべてのデータ処理はローカル・デバイス上で行われるため、100%のデータ・セキュリティは保証されます。

- マルチモデル対応HF、GPTQ、GGML、GGUFなど、幅広いオープンソースモデルに対応。

- 複数の埋め込み様々なオープンソース埋め込みオプションが利用可能です。

- モデル再利用ダウンロードしたLLMは再利用できるので、何度もダウンロードする必要はありません。

- 会話史セッションでの対話の履歴を覚えておくこと。

- APIインターフェースRAGアプリケーションの構築を容易にするAPIインターフェースを提供。

- グラフィカルユーザーインターフェース(GUI)APIベースとスタンドアロンGUI(streamlitベース)を提供。

- マルチプラットフォーム対応CUDA、CPU、HPU(Intel® Gaudi®)、MPSなどのマルチプラットフォームに対応。

ヘルプの使用

設置プロセス

- クローン倉庫ターミナルで以下のコマンドを実行し、LocalGPTリポジトリをクローンする:

git clone https://github.com/PromtEngineer/localGPT.git

- 依存関係のインストールプロジェクト・ディレクトリに移動し、必要な依存関係をインストールする:

cd localGPT

pip install -r requirements.txt

- 設定環境必要に応じて環境変数やモデルのパスを設定する。

使用方法

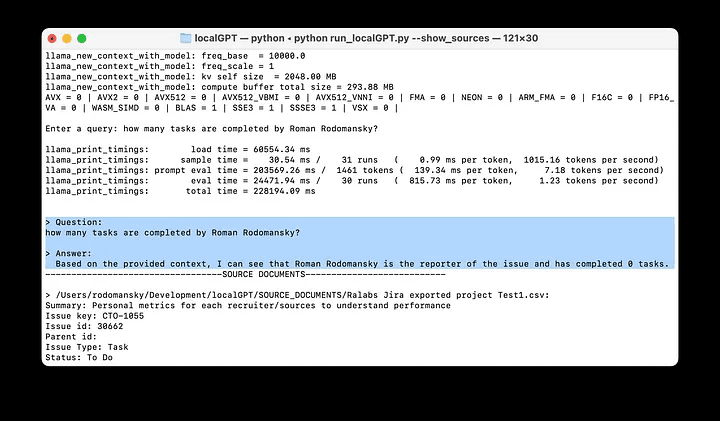

- サービス開始次のコマンドを実行して、LocalGPTサービスを開始します:

python run_localGPT.py

- アクセスインターフェイスブラウザを開き、指定されたローカルアドレスにアクセスして GUI にアクセスします。

- 文書のアップロード処理する文書をインターフェイスにアップロードします。

- 対話の開始ダイアログボックスに質問を入力すると、LocalGPTがドキュメントの内容に基づいて回答を生成します。

詳細な機能操作

- プライバシーすべてのデータ処理はローカル・デバイスで行われるため、100%のデータ・セキュリティは保証されます。ユーザーはデータ漏洩を心配する必要がありません。

- マルチモデル対応LocalGPTは様々なオープンソースモデルをサポートしており、ユーザーはニーズに応じてドキュメント処理に適したモデルを選択することができます。

- 会話史LocalGPTは、セッション内の会話履歴を記録し、ユーザーが過去の会話内容を簡単に閲覧・管理できるようにします。

- APIインターフェースLocalGPTは、開発者が独自のRAGアプリケーションを構築するために使用できるAPIインターフェイスを提供し、よりカスタマイズすることができます。

- グラフィカルユーザーインターフェース(GUI)LocalGPTは、直感的なインターフェイスでドキュメントのアップロードや対話操作を実行できる、ストリームライト・ベースのグラフィカル・ユーザー・インターフェイスを提供します。

操作手順例

- 文書のアップロード文書のアップロード」ボタンをクリックし、処理する文書ファイルを選択します。

- 入力の問題ダイアログボックスに質問を入力します。例えば「この文書の主な内容は何ですか?.

- 回答を見る: LocalGPTはドキュメントの内容に基づいて回答を生成し、ダイアログボックスに表示します。

- セッションの管理セッションの履歴を閲覧・管理することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません