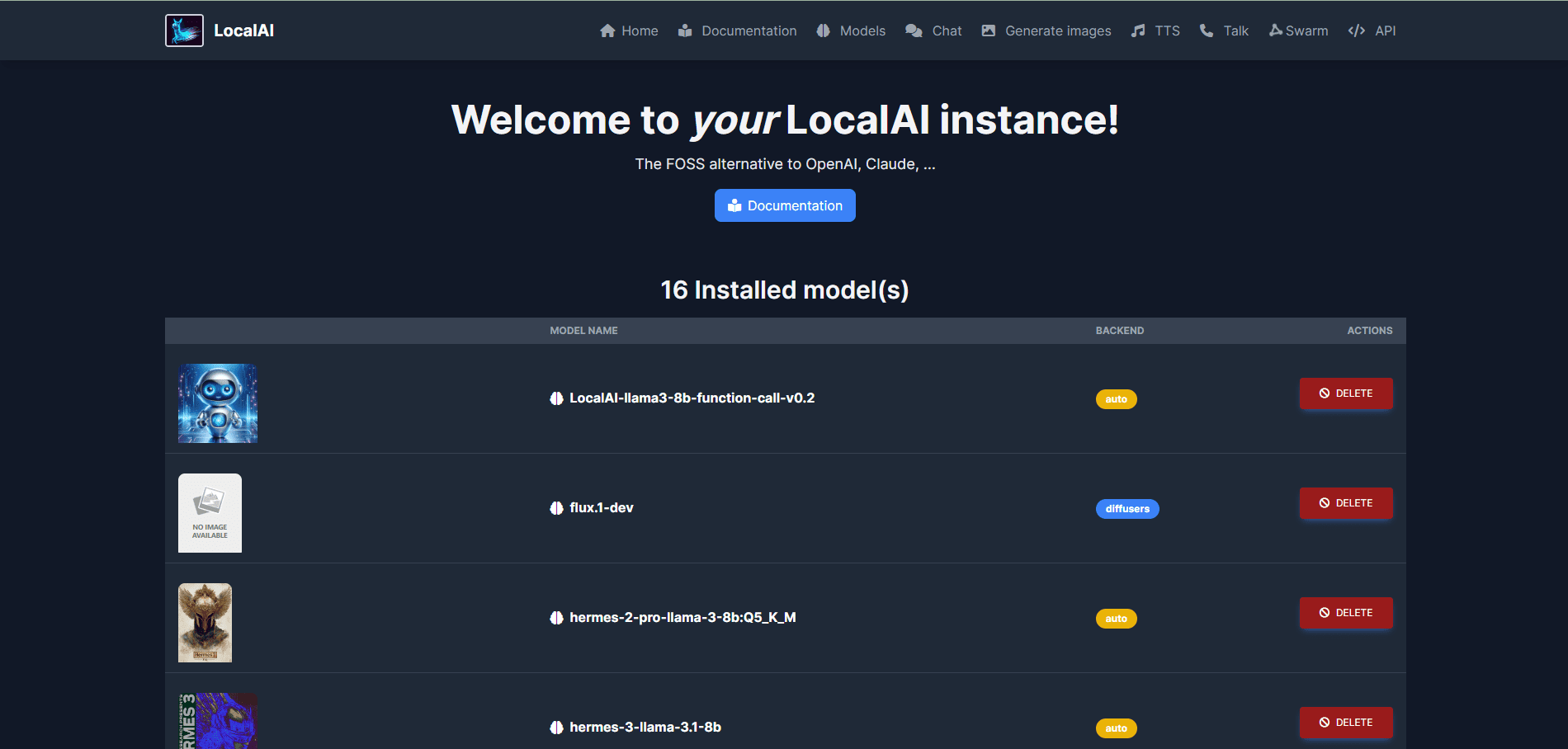

LocalAI: オープンソースのローカルAIデプロイメントソリューション、複数のモデルアーキテクチャのサポート、モデルとAPIのWebUI統合管理

はじめに

LocalAIは、OpenAIやClaudeなどと互換性のあるAPIインターフェースを提供することを目的とした、オープンソースのローカルAI代替ソフトウェアです。コンシューマーグレードのハードウェア上での実行をサポートし、GPUを必要とせず、テキスト、オーディオ、ビデオ、画像生成、スピーチクローンなどの幅広いタスクを実行することができます。LocalAIはEttore Di Giacintoによって作成され、維持されており、ローカルまたはオンプレミスのデプロイメント用にgguf、トランスフォーマー、ディフューザーなどを含む幅広いモデルアーキテクチャをサポートしています。

機能一覧

- テキスト生成:高品質のテキストコンテンツを生成できるGPTシリーズのモデルをサポート。

- 音声生成:テキストから音声への変換機能により、自然で滑らかな音声を生成します。

- 画像生成:安定した拡散モデルを用いて高品質の画像を生成する。

- 音声クローニング:音声クローニング技術により、元の音声に近い音声を生成します。

- 分散推論:モデルの推論効率を向上させるP2P推論をサポート。

- モデルのダウンロード:Huggingfaceなどのプラットフォームから直接モデルをダウンロードして実行する。

- 統合WebUI:ユーザーフレンドリーな操作のための統合Webユーザーインターフェースを提供します。

- ベクトルデータベース埋め込み生成:ベクトルデータベース埋め込み生成をサポートする。

- 制約付き構文:制約付き構文によるテキスト・コンテンツの生成をサポート。

- Vision API:画像処理・解析機能を提供。

- 並び替えAPI:テキストコンテンツの並び替えと最適化をサポートします。

設置プロセス

- インストールスクリプトの使用::

- 以下のコマンドを実行し、LocalAIをダウンロードしてインストールする:

curl -s https://localai.io/install.sh | sh

- 以下のコマンドを実行し、LocalAIをダウンロードしてインストールする:

- Dockerの使用::

- GPUがない場合は、以下のコマンドを実行してLocalAIを起動します:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu - Nvidia GPUをお持ちの場合は、以下のコマンドを実行してください:

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12

- GPUがない場合は、以下のコマンドを実行してLocalAIを起動します:

使用プロセス

- LocalAIを開始する::

- 上記のインストール手順でLocalAIを起動した後、次の手順にアクセスします。

http://localhost:8080WebUIにアクセスする。

- 上記のインストール手順でLocalAIを起動した後、次の手順にアクセスします。

- 積載モデル::

- WebUIでModelsタブに移動し、目的のモデルを選択してロードする。

- あるいは、例えばコマンドラインを使ってモデルをロードする:

local-ai run llama-3.2-1b-instruct:q4_k_m

- コンテンツの生成::

- WebUIで、適切な機能モジュール(テキスト生成、画像生成など)を選択し、必要なパラメータを入力して生成ボタンをクリックします。

- 例えば、テキストを生成するには、プロンプトを入力し、モデルを選択して、"Generate Text "ボタンをクリックします。

- 分散推論::

- 分散P2P推論を実現し、推論効率を向上させるために、複数のLocalAIインスタンスを構成する。

- 公式ドキュメントの『分散推論設定ガイド』を参照してください。

高度な機能

- カスタムモデル::

- ユーザーは、特定のニーズを満たすために、HuggingfaceまたはOCIレジストリからカスタムモデルをダウンロードしてロードすることができます。

- API統合::

- LocalAIはOpenAI APIと互換性のあるREST APIを提供しており、開発者は既存のアプリケーションに簡単に統合することができます。

- APIの詳細な使用方法については、公式APIドキュメントを参照のこと。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません