LMスピード:大規模モデルAPIのパフォーマンスを迅速にテストする

はじめに

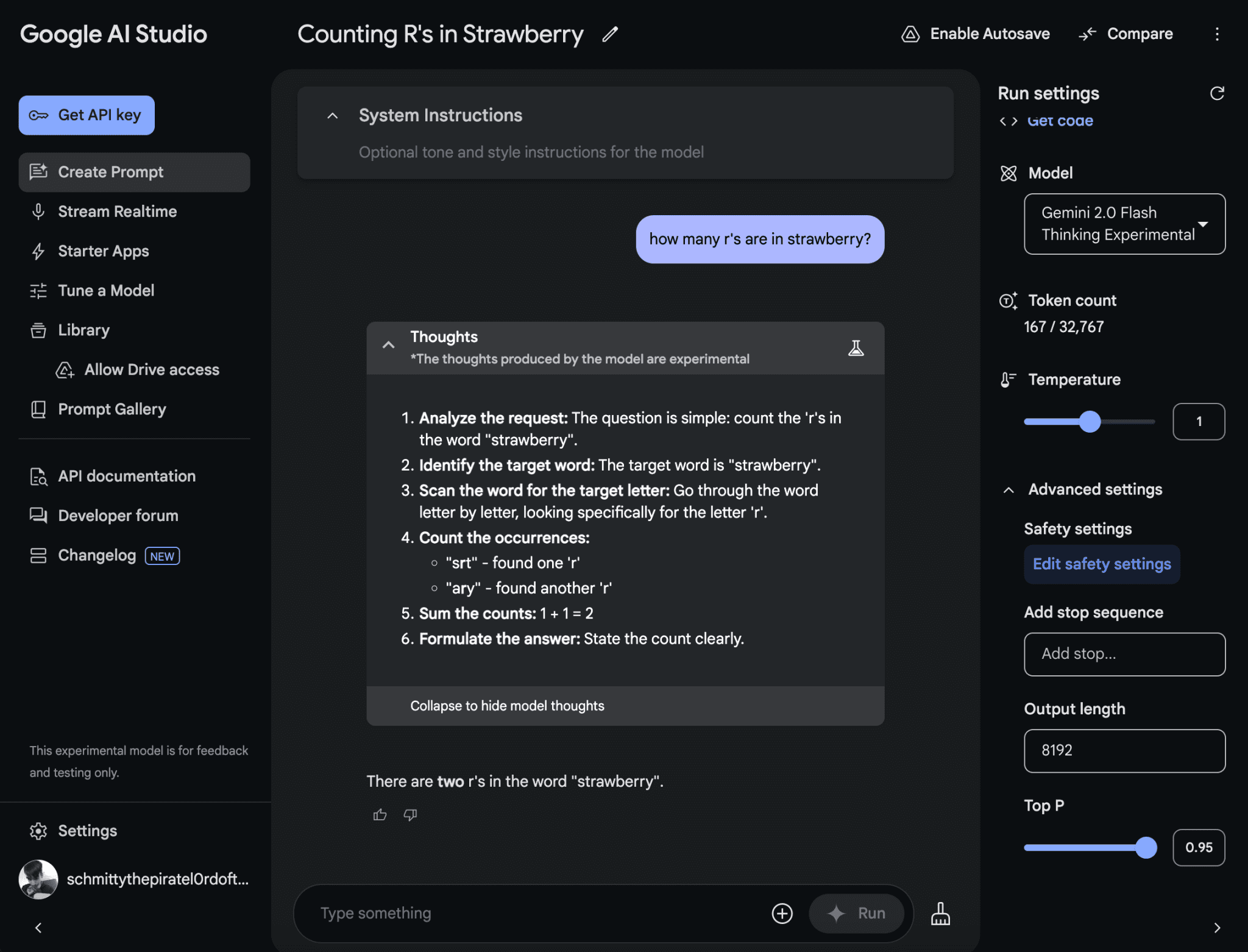

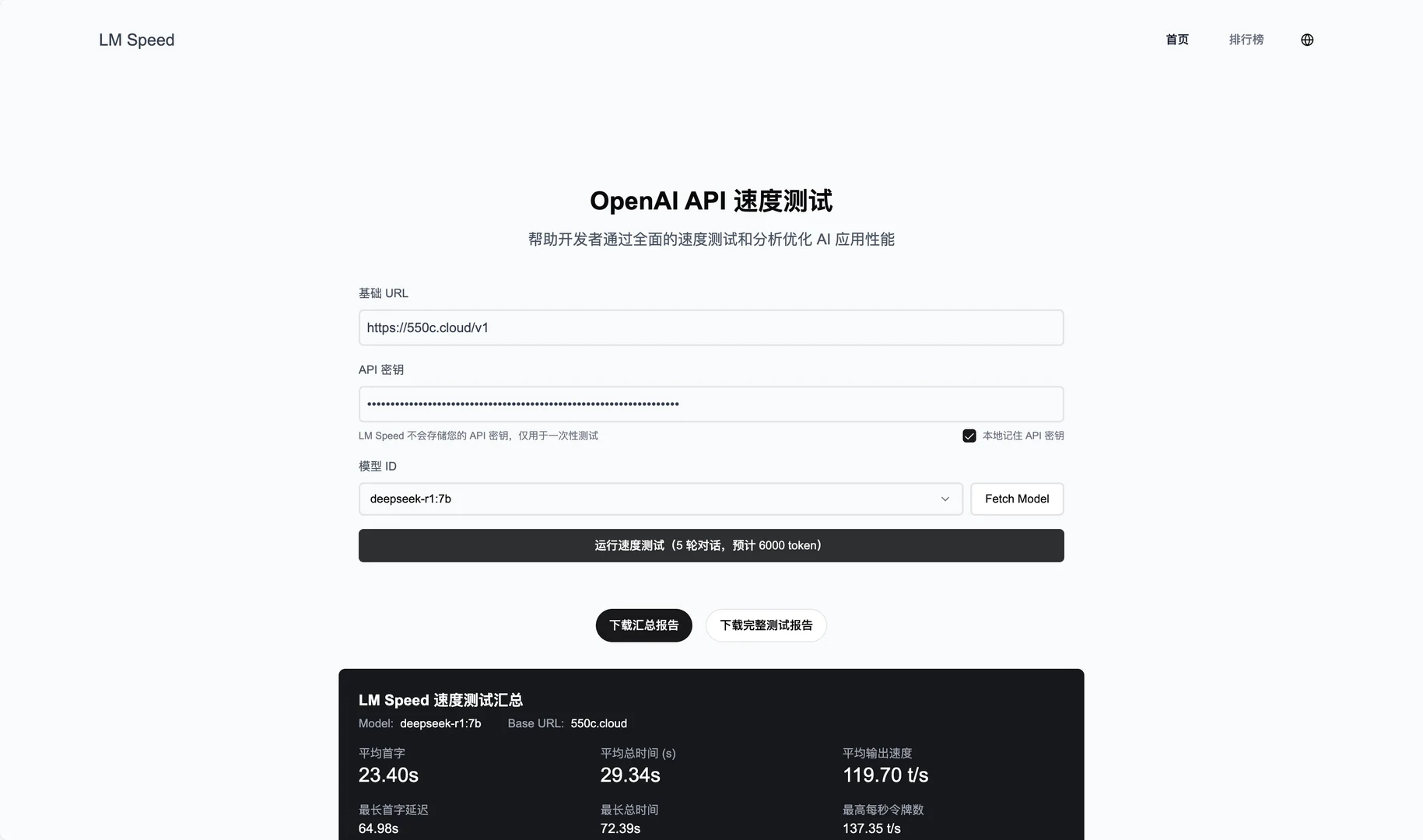

LM Speedは、AI開発者向けに特別に設計されたツールで、lmspeed.netでオンラインサービスとして提供されています。このツールの主な機能は、言語モデルAPIのパフォーマンスをテスト・分析することで、ユーザーはスピードのボトルネックを迅速に特定し、呼び出し戦略を最適化することができます。このツールは、OpenAI APIを含む様々なインターフェースをサポートし、リアルタイムのデータモニタリングと詳細なパフォーマンスレポートを提供します。個人の開発者であれ、チームであれ、LM Speed は直感的なデータチャートや自動テストにより、異なるモデルやベンダーのパフォーマンスを簡単に比較することができます。

機能一覧

- リアルタイム・パフォーマンス・モニタリング:1秒あたりの処理量など多次元データを表示 トークン 番号(TPoS)。

- 包括的なパフォーマンス評価:ファースト・トークン・レイテンシー、レスポンス・タイムなど、中核となる指標を測定します。

- データの視覚化:リッチなチャートを作成し、パフォーマンスの傾向を視覚化。

- 自動化されたストレステスト:信頼性の高いデータを確保するため、5回連続でテストを実施。

- ワンクリックでレポート作成:プロフェッショナルなテストレポートを自動的に作成し、エクスポートと共有をサポートします。

- URLパラメータのクイックテスト:手動入力なしでリンクから直接テストを起動します。

- 履歴データ保存:テスト結果を記録し、傾向分析をサポートします。

ヘルプの使用

オンライン・サービスの利用

- ウェブサイトへのアクセス

ブラウザを開き、https://lmspeed.net。 - 入力試験パラメータ

ページフォームに以下の情報を記入する:baseUrl例:APIサービスアドレスhttps://api.deepseek.com/v1.apiKeyAPIキーmodelIdテストするモデルのID。free:QwQ-32B.

- 起動テスト

Start Test "ボタンをクリックすると、システムが自動的に5ラウンドのストレステストを実行します。テスト中は、TPoSと応答時間を含むリアルタイムのデータ更新が表示されます。 - 結果を見る

テストが完了すると、ファースト・トークン・レイテンシーや平均パフォーマンスなどの詳細なグラフやメトリクスが表示されます。レポート作成」ボタンをクリックしてPDFをダウンロードしたり、チームで共有することができます。 - URLパラメータのクイックテスト

手動で入力したくない場合は、リンクを使用して直接テストを開始できます。例

https://lmspeed.net/?baseUrl=https://api.suanli.cn/v1&apiKey=sk-你的密钥&modelId=free:QwQ-32B

リンクを開くと、テストが自動的に開始されます。注:セキュリティ上の理由から、URLで直接APIキーを渡さないことをお勧めします。

ローカル・デプロイメント・インストール・プロセス

- 環境を整える

お使いのコンピューターにGit、Node.js(v16以上を推奨)、Docker、Docker Composeがインストールされていることを確認してください。 - クローン倉庫

ターミナルを開き、以下のコマンドを入力してコードをダウンロードする:

git clone https://github.com/nexmoe/lm-speed.git

cd lm-speed

- Dockerのデプロイメント

- 確立

docker-compose.ymlファイルを開き、公式に提供されているコードをコピーする:version: '3.8' services: app: image: nexmoe/lmspeed:latest ports: - "8650:3000" environment: - DATABASE_URL=postgresql://postgres:postgres@db:5432/nexmoe - NODE_ENV=production depends_on: - db restart: always db: image: postgres:16 restart: always environment: POSTGRES_USER: postgres POSTGRES_PASSWORD: postgres POSTGRES_DB: nexmoe volumes: - postgres_data:/var/lib/postgresql/data volumes: postgres_data: - ターミナルで実行:

docker-compose up -d - デプロイに成功したら

http://localhost:8650サービスを見る。

- 手動配備

- 依存関係をインストールします:

npm install - 環境変数をコピーして設定する:

cp .env.example .envコンパイラ

.envファイルに、データベース・アドレスとAPI設定を記入する。 - サービスを開始する:

npm run dev - インタビュー

http://localhost:3000.

注目の機能操作

- リアルタイム・モニタリング

オンラインテストの際、ページにはTPoSと応答時間の変化が動的に表示されます。グラフの上にマウスを置くと、正確な値を見ることができます。 - 自動テスト

Start Test "をクリックすると、システムは自動的に5ラウンドのテストを実施する。各ラウンドの結果が記録され、最後に平均値と変動幅が生成されるので、APIの安定性を判断するのに役立ちます。 - レポートのエクスポート

テストが完了したら、"Export Report "をクリックし、PDF 形式を選択します。レポートにはテスト環境、パフォーマンス指標、グラフが含まれ、チームでの共有やアーカイブに適しています。 - 過去のデータ分析

オンライン・サービスでは、テストの記録を保存しています。ログイン後、「履歴」ページで過去のテスト結果やパフォーマンスの傾向をご覧ください。

ほら

- APIキーが有効であることを確認してください。

- ローカルに配備する場合は、ファイアウォールでポートが開いていることを確認する(デフォルトは3000または8650)。

- チャートの読み込みが遅い場合は、ネットワークに問題がある可能性がありますので、ページを更新して再試行することをお勧めします。

以上の手順で、Language Modelling APIのパフォーマンスをオンラインまたはローカルでLM Speedを使ってテストすることができます。操作は簡単で、結果は明確であり、非常に便利です。

アプリケーションシナリオ

- 開発者はAPIサービスを選ぶ

LM Speedによる開発者テスト ディープシーク やSilicon FlowなどのAPIを使用して、プロジェクトに最適なベンダーを選択する。 - チーム最適化モデルの呼び出し

AIチームはこれを使用して、高負荷時のAPIのパフォーマンスを監視し、アプリケーションの効率を改善するためにコール戦略を調整する。 - 研究者がパフォーマンスの変動を分析

- 研究者たちは、5回にわたるテストと過去のデータを通じて、さまざまな条件下でのモデルの性能の変化を研究し、学術的な報告書を執筆した。

品質保証

- LM SpeedはどのAPIをサポートしていますか?

主にDeepSeekやSuanliなどのOpenAI形式のAPIに対応している。OpenAI SDKと互換性のあるAPIであればテスト可能です。 - 不安定な検査結果については?

ネットワーク接続が安定していることを確認するか、テストラウンド数を増やしてください(ローカル展開用にコードを修正できます)。結果が大きく変動する場合は、APIプロバイダーに問題がある可能性があります。 - 支払いは必要ですか?

オンラインサービスは現在無料だが、機能が制限される場合がある。ローカル展開は完全に無料で、コードはオープンソースです。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません