LLManager:インテリジェントな自動プロセス承認と人間による監査を組み合わせた管理ツール

はじめに

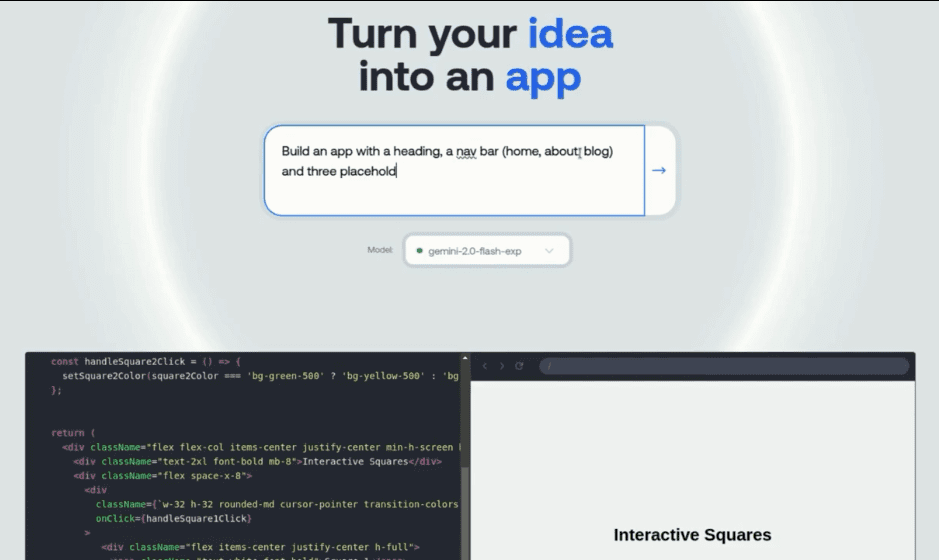

LLManagerはオープンソースのインテリジェントな承認管理ツールで、LangChainの ラングラフ 承認リクエストの自動処理に重点を置きながら、人間によるレビューと連動して意思決定を最適化するために開発されたフレームワーク。セマンティック検索、サンプルレス学習、リフレクティブメカニズムを通じて過去の承認から学習し、承認精度を向上させる。ユーザーは エージェント受信箱 リクエストの表示と応答、カスタム承認・却下基準のサポート、複数の言語モデル(OpenAI、Anthropicなど)への適応など、LLManagerは企業の予算承認、プロジェクト管理、コンプライアンス審査のシナリオに適しており、コードはGitHubでホストされているため、開発者は自由に機能を拡張できる。このツールはAIと人間のコラボレーションを重視し、効率性と信頼性のバランスをとっている。

機能一覧

- 自動化された承認ユーザー定義の承認・却下基準に基づいて、承認勧告を自動的に生成します。

- 人間監査AIが作成した承認の手動による承認、修正、拒否をサポートし、正確な意思決定を保証します。

- セマンティックサーチ過去のリクエストから意味的に類似した10個のサンプルを抽出し、承認の文脈的関連性を向上させます。

- 少ないサンプルで学ぶ過去の承認データに基づき、モデルの将来の意思決定能力を最適化する。

- 反射メカニズム修正された承認の結果を分析し、モデルのパフォーマンスを向上させるための反映レポートを作成する。

- モデルのカスタマイズOpenAI、Anthropicなどのモデルをサポートし、ツール呼び出し機能をサポート。

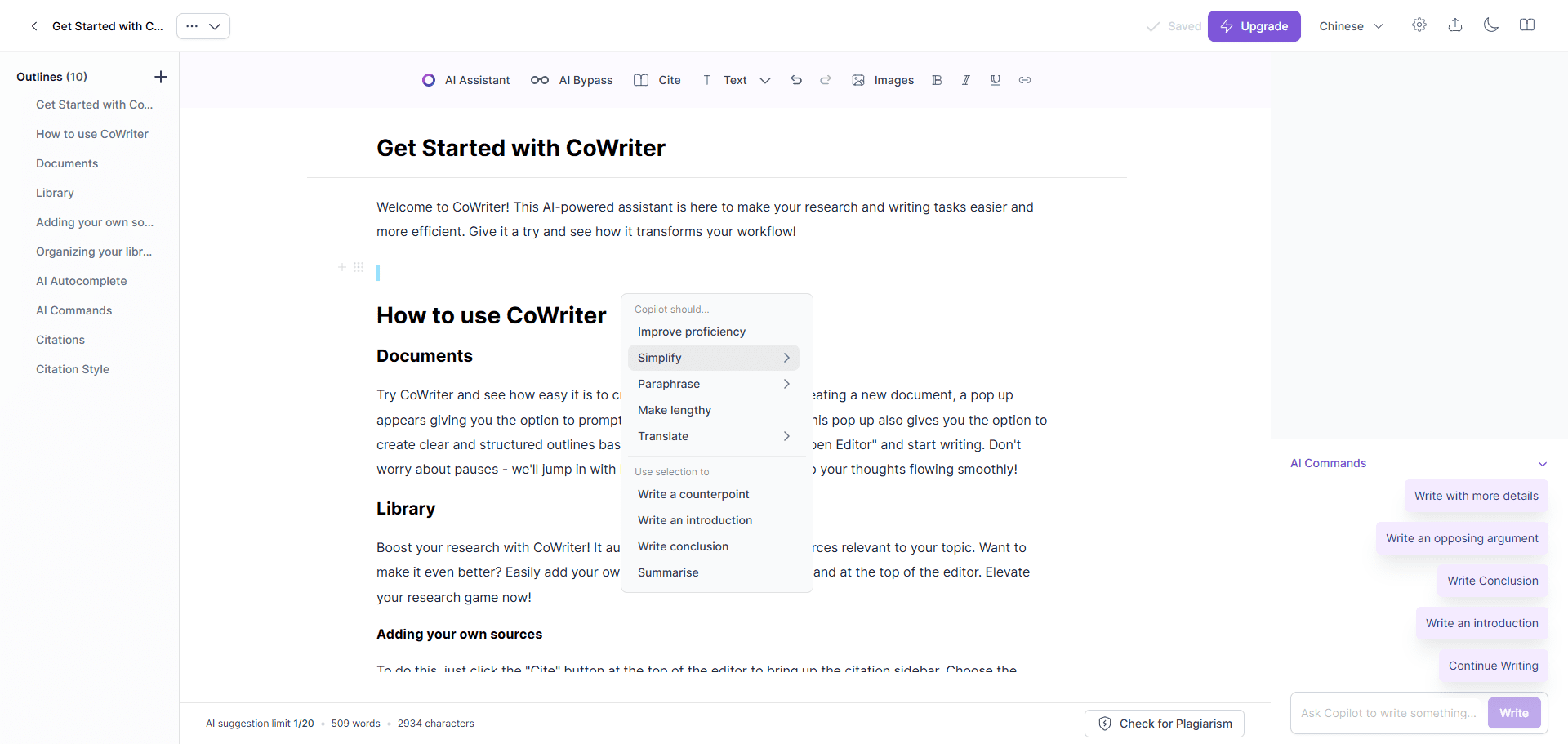

- エージェント・インボックス・インタラクティブ承認依頼の閲覧、回答、管理のための直感的なインターフェイスを提供します。

- ダイナミックなキュー作り様々な承認シナリオに合わせて、リクエストに基づいてプロンプトを動的に調整します。

- エンド・ツー・エンドの評価テストケースを実行し、ワークフローの信頼性と正確性を検証する。

ヘルプの使用

設置プロセス

LLManagerはLangChainとLangGraphのオープンソースプロジェクトに基づいています。以下は詳しいインストール手順です:

- コードベースのクローン::

ターミナルで以下のコマンドを実行し、LLManagerコードを取得する:git clone https://github.com/langchain-ai/llmanager.git cd llmanager - 依存関係のインストール::

Python 3.11以降とNode.js(Yarn用)がシステムにインストールされていることを確認する。仮想環境を作成し、依存関係をインストールします:python3 -m venv venv source venv/bin/activate yarn installデフォルトの依存関係には、LangChainとAnthropic/OpenAI統合パッケージが含まれます。他のモデル(Google GenAIなど)を使用する場合は、追加のインストールが必要です:

yarn install @langchain/google-genai - 環境変数の設定::

サンプル環境ファイルをコピーし、必要な情報を記入する:cp .env.example .envコンパイラ

.envファイルに、LangSmith API キーと アンソロピック APIキー(Anthropicモデルを使用している場合):LANGCHAIN_PROJECT="default" LANGCHAIN_API_KEY="lsv2_..." LANGCHAIN_TRACING_V2="true" LANGSMITH_TEST_TRACKING="true" ANTHROPIC_API_KEY="your_anthropic_key"LangSmithはトレースとデバッグに使用され、有効にすることが推奨される。

- 開発サーバーの起動::

以下のコマンドを実行してLangGraphサーバを起動する:yarn devサーバーはデフォルトで

http://localhost:2024本番環境では、クラウドサーバーにデプロイしてURLを更新してください。本番環境では、クラウドサーバーにデプロイしてURLを更新してください。

使用方法

LLManagerの核となるのは、エージェント受信箱を通して承認依頼を管理し、対応することです。以下に詳細な操作フローを示します:

- エンド・ツー・エンド評価の実施::

- 次のコマンドを実行して、新しい承認アシスタントを生成し、25のテストケースを実行します:

yarn test:single evals/e2e.int.test.ts - 端末は新しいアシスタントのUUIDを出力し、このIDをエージェント受信トレイ設定用に記録します。

- 同じアシスタントを再利用する必要がある場合は

evals/e2e.int.test.ts固定ヘルパーIDを使用する場合は、固定ヘルパーIDを使用してください。

- 次のコマンドを実行して、新しい承認アシスタントを生成し、25のテストケースを実行します:

- 承認ルールの設定::

- ある

config.jsonで承認と拒否の基準を設定します。例{ "approvalCriteria": "请求需包含详细预算和时间表", "rejectionCriteria": "缺少必要文件或预算超标", "modelId": "anthropic/claude-3-7-sonnet-latest" } - ルールが設定されていない場合、LLManagerは過去のデータに基づいて学習するが、ルールを設定することでモデルの適応が加速する。

modelIdアジュバントprovider/model_nameのような形式を使用します。openai/gpt-4oもしかしたらanthropic/claude-3-5-sonnet-latest.

- ある

- エージェント受信トレイの使用::

- dev.agentinbox.aiにアクセスし、"Add Inbox "をクリックする。

- 以下の情報を入力してください:

- アシスタント/グラフIDエンド・ツー・エンドの評価によって生成されるUUID。

- 配備URL::

http://localhost:2024(開発環境)。 - 名称名前をカスタマイズする。

LLManager.

- 送信後に受信トレイを更新すると、保留中のリクエストが表示されます。

- 各リクエストに対して、エージェントの受信トレイが表示されます:

- AIが作成した承認勧告と理由レポート。

- アクションのオプション:受諾、修正(提案または指示を編集)、または拒否(理由を記入)。

- 変更または承認されたリクエストは、その後の承認を最適化するために、Less Sample Example ライブラリに自動的に保存されます。

- 承認履歴の表示と最適化::

- エージェントの受信トレイで、[処理済みリクエスト]をクリックすると、承認の詳細、AI推論レポート、および手動修正ログが表示されます。

- このシステムは、セマンティック検索を通じて、文脈入力モデルとして履歴から類似のリクエストを抽出する。

- 修正されたリクエストはリフレクションメカニズムをトリガーし、リフレクションリポジトリに保存され、モデルを改善するために使用されるリフレクションレポートを生成する。

注目の機能操作

- セマンティックサーチ新しいリクエストが到着すると、システムは、承認精度を向上させるためのプロンプトコンテキストとして、履歴から10個の意味的に類似したリクエスト(リクエスト内容、最終的な回答、説明を含む)を抽出します。

- 反射メカニズム::

- マニュアルが説明を修正しただけの場合(正解だが推論が正しくない)、以下のようにトリガーします。

explanation_reflectionノードで推論の誤りを分析し、新たな反省を生み出す。 - 答えと説明の両方が変更された場合、以下のトリガーがかかります。

full_reflectionノードを分析し、全体的なエラーを分析し、反射を生成する。 - リフレクション・レポートはリフレクション・バンクに保管され、その後の推論を最適化する。

- マニュアルが説明を修正しただけの場合(正解だが推論が正しくない)、以下のようにトリガーします。

- ダイナミックなキュー作りリクエストの内容や過去のデータに基づいてプロンプトを動的に調整し、承認がさまざまなシナリオに適合するようにします。

- モデル切り替えを修正することによって

config.json正鵠を得るmodelIdツール・コールをサポートするモデル(例.openai/gpt-4o)、対応する統合パッケージがインストールされていることを確認する必要がある。

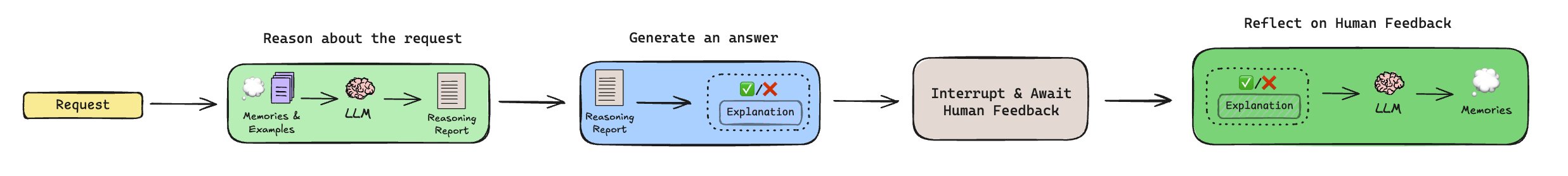

ワークフローの説明

LLManagerの承認プロセスには以下のステップがあります:

- 推論::

- 歴史的な反省とより少ないサンプル例を抽出する(セマンティック検索経由)。

- 要求が許可されるべきかどうかを分析する理由レポートを生成するが、最終決定は行わない。

- 回答を生成する::

- 理由レポートとコンテキストを組み合わせて、最終的な承認勧告(承認または却下)と説明を生成します。

- ヒューマン・レビュー::

- ワークフローを一時停止し、エージェントの受信トレイで手動レビューを待ちます。

- 人間は提案を受け入れ、修正し、あるいは拒否することができ、修正されたものはより少ないサンプル例ライブラリに預けられる。

- リフレクション::

- 勧告が修正された場合、改善のための勧告を生成するための反映メカニズムが起動する。

- 未修正のリクエストはこのステップをスキップする。

ほら

- LangSmithのAPIキーが有効で、開発環境と本番環境の両方が安定したネットワークであることを確認してください。

- 非OpenAI/Anthropicモデルは、追加の統合パッケージをインストールする必要があります。

- 本番環境では、LangGraphサーバをクラウドに移動し、Agent InboxのURLを更新する必要があります。

アプリケーションシナリオ

- 企業予算の承認

LLManagerは、従業員の予算要求の処理を自動化し、事前に定義されたルール(予算上限、プロジェクトタイプなど)に基づいて推奨を生成します。財務チームは、Agent Inboxを介して結果をレビュー、修正、確認し、反復作業を削減します。 - プロジェクト・タスクの割り当て

プロジェクトマネージャーは、LLManagerを使ってタスク割り当て要求を承認する。システムはタスクの優先順位とリソース要件を分析し、割り当ての推奨を生成する。マネージャーは、効率的で合理的なタスク割り当てを確実にするために、リクエストを手動でレビューする。 - コンプライアンス審査

LLManagerは、提出された文書が規制に準拠しているかをチェックし、潜在的な問題点にフラグを立てます。コンプライアンスチームは、Inboxを通じて結果を確認または調整し、レビューの効率を高めます。 - 顧客リクエスト管理

カスタマーサービスチームはLLManagerを使用して、顧客の払い戻しやサービスリクエストを承認している。システムは過去のデータに基づいて推奨事項を生成し、チームはそれを手作業でレビューして、決定が公正で一貫性のあるものであることを確認します。

品質保証

- LLManagerはどのようなモデルをサポートしていますか?

OpenAI、Anthropicなどのサポートモデルは、ツール呼び出し機能をサポートする必要があります。デフォルト以外のモデルでは、以下のようなLangChain統合パッケージのインストールが必要です。@langchain/google-genai. - 同じアシスタントを再利用するには?

修正evals/e2e.int.test.ts固定のヘルパーIDを使用する場合、または評価を実行する前に既存のIDを検索する場合は、新しいヘルパーの生成は避けてください。 - 本番環境ではどのように導入するのですか?

LangGraphをクラウドサーバにデプロイし、Agent InboxのDeployment URLを更新し、LangSmithを使ってワークフローのパフォーマンスを監視します。 - ワークフローをカスタマイズするには?

特定の承認シナリオに適応させるために、推論サブグラフ(プロンプト生成ロジッ クを調整する)または反映サブグラフ(反映生成ルールを制御する)を編集する。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません