LlamaEdge:LLMをローカルで実行し、微調整する最も迅速な方法!

はじめに

LlamaEdgeは、ローカルデバイスやエッジデバイス上での大規模言語モデル(LLM)の実行と微調整のプロセスを簡素化するために設計されたオープンソースプロジェクトです。LlamaEdgeはRustとWasmの技術スタックを活用し、AI推論のための強力な代替手段を提供します。LlamaEdgeは、RustとWasmの技術スタックを活用し、AI推論のための強力な代替手段を提供します。ユーザーは、簡単なコマンドライン操作で素早くモデルを立ち上げ、必要に応じて微調整や拡張を行うことができます。

機能一覧

- LLMをローカルで実行するLlama2シリーズをローカルデバイスやエッジデバイスで動作させることができます。

- OpenAI対応APIサービスチャット、音声読み上げ、テキスト読み上げ、画像生成などをサポートするOpenAI API互換のサービスエンドポイントを提供します。

- クロスプラットフォーム対応幅広いCPUとGPUデバイスをサポートし、クロスプラットフォームのWasmアプリケーションを提供します。

- クイックスタートモデルは、簡単なコマンドライン操作で素早くダウンロードし、実行することができます。

- 微調整と拡大ユーザーは、特定のニーズを満たすために、必要に応じてソースコードを変更および拡張することができます。

- ドキュメンテーションとチュートリアル詳細な公式ドキュメントとチュートリアルが用意されているので、すぐに使い始めることができます。

ヘルプの使用

設置プロセス

- ワスムエッジの設置まず、WasmEdgeをインストールする必要がありますが、これは以下のコマンドラインで実行できます:

curl -sSf https://raw.githubusercontent.com/WasmEdge/WasmEdge/master/utils/install_v2.sh | bash

- LLMモデルファイルのダウンロードMeta Llama 3.2 1Bモデルを例にとって、次のコマンドでダウンロードしてください:

curl -LO https://huggingface.co/second-state/Llama-3.2-1B-Instruct-GGUF/resolve/main/Llama-3.2-1B-Instruct-Q5_K_M.gguf

- LlamaEdge CLIチャットアプリのダウンロードクロスプラットフォームのWasmアプリケーションをダウンロードするには、次のコマンドを使用します:

curl -LO https://github.com/second-state/LlamaEdge/releases/latest/download/llama-chat.wasm

- チャットアプリケーションの実行LLMとチャットするには以下のコマンドを使ってください:

wasmedge --dir .:. --nn-preload default:GGML:AUTO:Llama-3.2-1B-Instruct-Q5_K_M.gguf llama-chat.wasm -p llama-3-chat

機能 操作の流れ

- APIサービスの開始APIサービスは以下のコマンドで起動できる:

wasmedge --dir .:. --env API_KEY=your_api_key llama-api-server.wasm --model-name llama-3.2-1B --prompt-template llama-chat --reverse-prompt "[INST]" --ctx-size 32000

- ウェブインターフェースを使ったLLMとの対話APIサービスを開始すると、ウェブ・インターフェイスを通じてローカルLLMと対話することができます。

- カスタムAPIサービスの作成音声合成、テキスト読み上げ、画像生成など、必要に応じてカスタムAPIサービスのエンドポイントを作成できます。

- 微調整と拡大ユーザーは、特定の機能要件を満たすために、ソースコード内の設定ファイルやパラメータを変更することができます。

LlamaEdge ラップトップで蒸留を高速実行 DeepSeek-R1

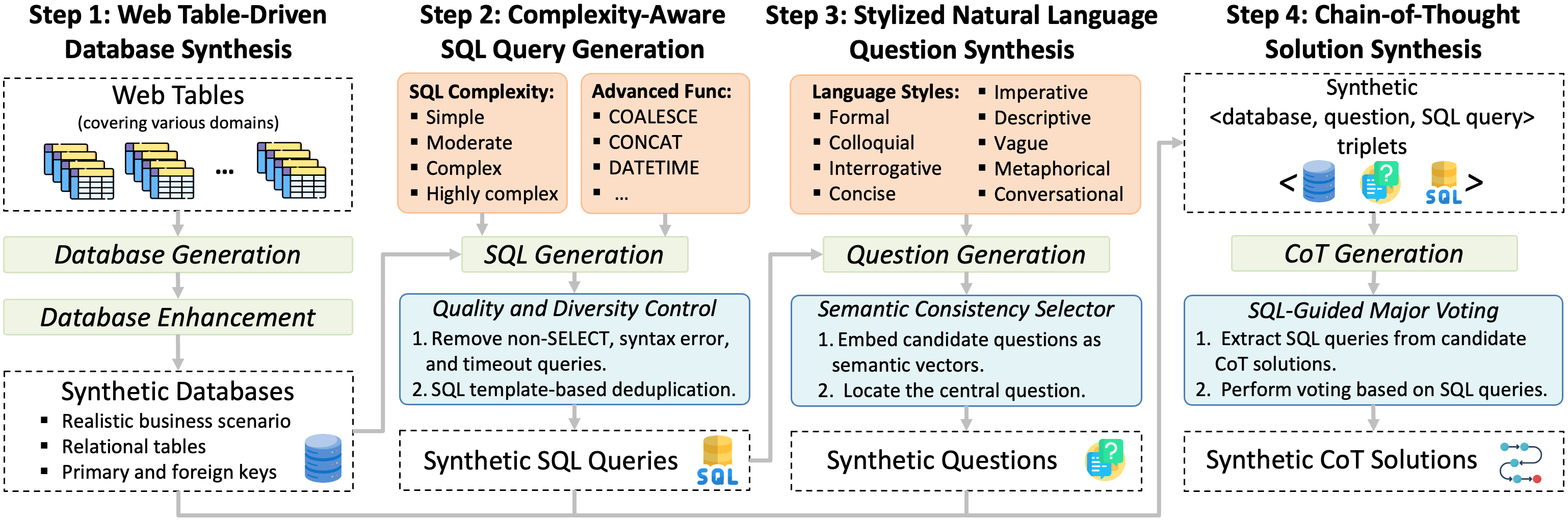

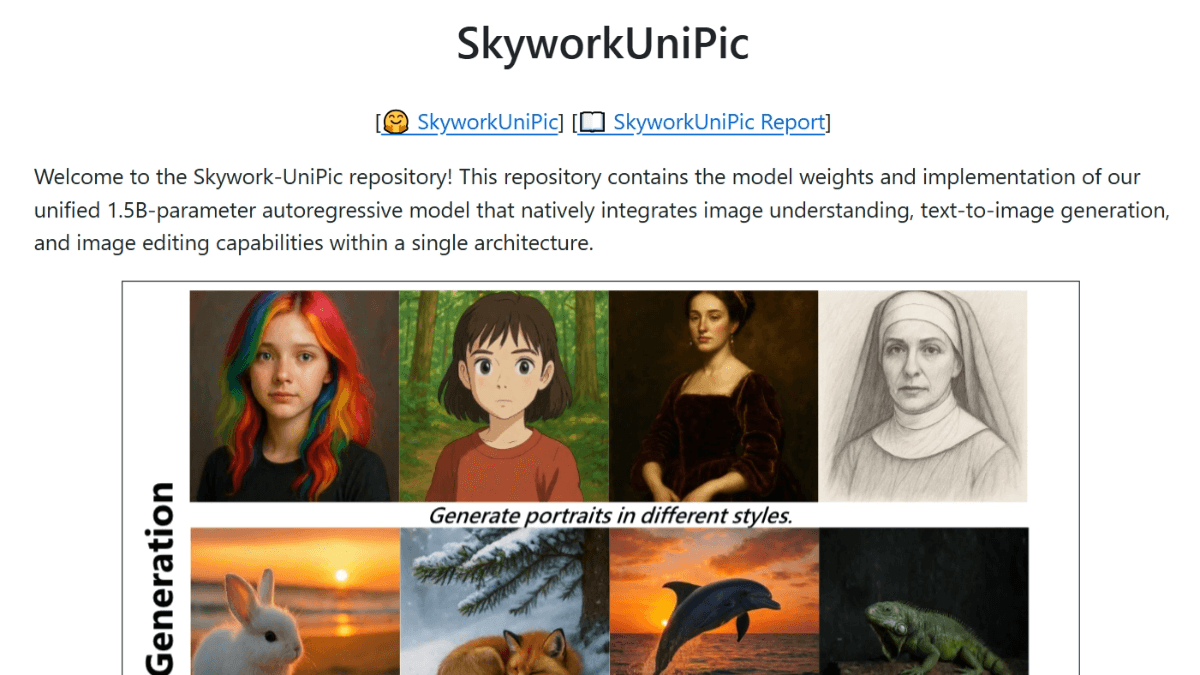

DeepSeek-R1は、その高度な推論能力、費用対効果、オープンソースでの利用可能性により、OpenAIのような既存のプレイヤーに挑戦する強力で汎用性の高いAIモデルです。いくつかの制限はあるものの、その革新的なアプローチと堅牢な性能により、開発者、研究者、企業にとって貴重なツールとなっている。その能力を探求することに興味がある人のために、モデルとそのライトバージョンは、Hugging FaceやGitHubなどのプラットフォームで利用可能です。

GPUに制約のある中国のチームによって訓練されたこのモデルは、数学、コーディング、そしてかなり複雑な推論に優れている。最も興味深いのは、これが「ライト」モデルであることで、ベースとなっている巨大なモデルよりも小型で効率的だということだ。これは、人々が実際に使用し、構築することをより現実的なものにするため、重要なことである。

この記事では

- 自分のデバイスでオープンソースを実行する方法 ディープシーク モデリング

- 最新のDeepSeekモデルを使用してOpenAI互換のAPIサービスを作成する方法

私たちはLlamaEdge(Rust + Wasmテクノロジースタック)を使って、このモデルのアプリケーションを開発し、デプロイします。複雑なPythonパッケージやC++ツールチェーンをインストールする必要はありません!私たちがこのテクノロジーを選んだ理由をご覧ください。

DeepSeek-R1-Distill-Llama-8Bモデルをご自身の装置で実行してください!

ステップ1:以下のコマンドラインでWasmEgeをインストールする。

curl -sSf https://raw.githubusercontent.com/WasmEdge/WasmEdge/master/utils/install_v2.sh | bash -s -- -v 0.14.1

ステップ 2: 定量化された DeepSeek-R1-Distill-Llama-8B-GGUF モデル・ファイルをダウンロードします。

モデルのサイズが5.73GBなので、時間がかかるかもしれない。

curl -LO https://huggingface.co/second-state/DeepSeek-R1-Distill-Llama-8B-GGUF/resolve/main/DeepSeek-R1-Distill-Llama-8B-Q5_K_M.gguf`

ステップ3: LlamaEdge APIサーバーアプリケーションをダウンロードします。

また、多くのCPUやGPUデバイスで動作する、クロスプラットフォームでポータブルなWasmアプリケーションでもある。

curl -LO https://github.com/LlamaEdge/LlamaEdge/releases/latest/download/llama-api-server.wasm

ステップ4:チャットボットUIのダウンロード

を使用して、ブラウザでDeepSeek-R1-Distill-Llama-8Bモデルと対話します。

curl -LO https://github.com/LlamaEdge/chatbot-ui/releases/latest/download/chatbot-ui.tar.gz tar xzf chatbot-ui.tar.gz rm chatbot-ui.tar.gz

次に、以下のコマンド動作モデルを使用して LlamaEdge API サーバーを起動します。

wasmedge --dir .:. --nn-preload default:GGML:AUTO:DeepSeek-R1-Distill-Llama-8B-Q5_K_M.gguf \ llama-api-server.wasm \ --prompt-template llama-3-chat \ --ctx-size 8096

その後、ブラウザを開き、http://localhost:8080、チャットを開始する!または、モデルにAPIリクエストを送ることもできます。

curl -X POST http://localhost:8080/v1/chat/completions \

-H 'accept:application/json' \

-H 'Content-Type: application/json' \

-d '{"messages":[{"role":"system", "content": "You are a helpful assistant."}, {"role":"user", "content": "What is the capital of France?"}], "model": "DeepSeek-R1-Distill-Llama-8B"}'

{"id":"chatcmpl-68158f69-8577-4da2-a24b-ae8614f88fea","object":"chat.completion","created":1737533170,"model":"default","choices":[{"index":0,"message":{"content":"The capital of France is Paris.\n</think>\n\nThe capital of France is Paris.<|end▁of▁sentence|>","role":"assistant"},"finish_reason":"stop","logprobs":null}],"usage":{"prompt_tokens":34,"completion_tokens":18,"total_tokens":52}}

DeepSeek-R1-Distill-Llama-8B用のOpenAI互換APIサービスの作成

LlamaEdgeは軽量で、実行にデーモンやsudoプロセスを必要としません。独自のアプリケーションに簡単に組み込むことができる!チャットや埋め込みモデルのサポートにより、LlamaEdgeはあなたのローカルマシン上のアプリケーション内でOpenAI APIの代替となることができます!

次に、新しい関数を ディープシーク-R1 モデルとエンベッディング・モデルを使用して、完全なAPIサーバーを起動します。 chat/completions 歌で応える embeddings エンドポイント。前節のステップに加え、次のことが必要である:

ステップ5:埋め込みモデルをダウンロードする。

curl -LO https://huggingface.co/second-state/Nomic-embed-text-v1.5-Embedding-GGUF/resolve/main/nomic-embed-text-v1.5.f16.gguf

以下のコマンドラインを使用して、チャットと埋め込みモデルを持つLlamaEdge APIサーバーを起動することができます。より詳細な手順については、ドキュメント - LlamaEdge APIサービスの起動を参照してください。

wasmedge --dir .:. \ --nn-preload default:GGML:AUTO:DeepSeek-R1-Distill-Llama-8B-Q5_K_M.gguf \ --nn-preload embedding:GGML:AUTO:nomic-embed-text-v1.5.f16.gguf \ llama-api-server.wasm -p llama-3-chat,embedding \ --model-name DeepSeek-R1-Distill-Llama-8B,nomic-embed-text-v1.5.f16 \ --ctx-size 8192,8192 \ --batch-size 128,8192 \ --log-prompts --log-stat

最後に、これらのチュートリアルに従って、LlamaEdge APIサーバをOpenAIの代替として他のAgentフレームワークと統合することができます。具体的には、アプリケーションまたはAgentの設定で、OpenAI APIを以下の値で置き換えてください。

| 設定オプション | (価値がある |

|---|---|

| ベースAPI URL | http://localhost:8080/v1 |

| モデル名(大型モデル) | ディープシーク-R1-ディスティル-ラマ-8B |

| モデル名(テキスト埋め込み) | ノミックエンベッド |

以上です!今すぐLlamaEdgeリポジトリにアクセスし、あなたの最初のAIエージェントを構築してください!もし面白いと思ったら、こちらのリポジトリにスターを付けてください。このモデルの実行について質問がある場合は、レポにアクセスして質問するか、私たちにデモを予約して、デバイス間で独自のLLMを実行してください!

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません