ラマ4シリーズがデビュー:ネイティブ・マルチモーダルAIイノベーションの新たなスタート?

2025年4月5日、メタ社は大規模言語モデルLlamaファミリーの最新版であるLlama 4をリリースし、AI分野、特にネイティブ・マルチモダリティとモデル・アーキテクチャにおいて大きな進歩を遂げた。今回の発表の中心となるのは、Llama 4 ScoutとLlama 4 Maverickモデル、そしてこのテクノロジーを支える巨大な「教師」モデル、Llama 4 Behemothのプレビューである。この動きは、業界のトップモデルに追いつき、凌駕しようとするメタ社のコミットメントを示すだけでなく、オープンソースのAIエコシステムを推進する同社の戦略を継続するものでもある。

ラマ4シリーズのコアモデルの概要

Meta社は、開発者やアプリケーション向けにLlama 4シリーズから2機種を発売する:

- ラマ4スカウトこのモデルは170億のアクティブ・パラメーターと16のエキスパート、合計1090億のパラメーターを持つ。ハイライトはクラス最高のマルチモーダル機能で、これまでのラマ・モデルを凌駕している。さらに注目すべきは、最大1,000万個のパラメータをサポートしていることだ。 トークン コンテクスト・ウィンドウは、ラマ3の128Kをはるかに上回っている。 ジェマ3 そして ジェミニ 2.0フラッシュライトと ミストラルAI な ミストラル 3.1とInt4で定量化され、単一のNVIDIA H100 GPUで展開され、効率に重点を置いていることがわかる。

- ラマ4マーベリックアクティブパラメータは170億だが、128人のエキスパートと4,000億の総パラメータを備えている。このクラスでトップのマルチモーダルモデルと位置づけられ、OpenAIのGPT-4oやGoogleのGemini 2.0 Flashに挑戦することを目指している。Metaが発表したデータによると、Maverickはいくつかのベンチマークで好成績を収め、推論とコーディング能力において、アクティブ・パラメーターの2倍のパラメーターを持つに迫っている。 ディープシーク v3 .チャットの実験的なバージョンは、以下で利用可能です。 LMArena リーダーボードは1417のELOスコアを獲得し、対話能力の可能性を示した。このモデルは、NVIDIA H100 DGXホスト1台で実行できます。

さらに、メタは次のようにプレビューした。 ラマ4ベヒーモス モデリング。これは、2,880億のアクティブ・パラメーター、16人のエキスパート、2兆人近い総参加者を持つ巨大なものだ。まだトレーニング中で、リリースはされていないが、ScoutとMaverickの「教師」モデルとして機能し、知識の抽出を通じて後者のパフォーマンスを高める。 Behemothは数学、多言語、画像のベンチマークに優れており、MetaはMATH-500やGPQA DiamondといったいくつかのSTEMベンチマークでGPT-4.5を上回ると主張している、 アンソロピック な クロード ソネット3.7とグーグルのジェミニ2.0プロ。

主な技術革新:MoE、マルチモダリティ、ロング・コンテクスト

ラマ4シリーズは、性能向上を支える数々の重要な技術革新を導入している。

ハイブリッド専門家モデル(MoE)アーキテクチャ

Llama 4は、Meta初のMixed Expert(MoE)アーキテクチャを採用したモデルファミリーである。MoEアーキテクチャは、総パラメータ数が多い一方で、推論時に少数のパラメータ(すなわち「エキスパート」)のみを活性化させることができるモデルであり、近年注目を集めている。この設計により、与えられた訓練計算予算に対して、従来の密な(Dense)モデルよりも高い性能を実現し、訓練と推論の計算効率を向上させることができる。

例として、Llama 4 Maverickには、128人のルーティング・エキスパートと1人の共有エキスパートに分散された合計4000億のパラメータがある。推論時、各トークンは共有エキスパートとルーティング・エキスパートの両方に送られる。このモデルでは、性能と効率のバランスをとるために、密なレイヤーとMoEレイヤーを交互に使用している。このアーキテクチャにより、Maverickは単一のH100 DGXホスト上に展開することも、分散推論によって効率を最大化し、モデルサービスのコストとレイテンシを削減することもできる。

ネイティブのマルチモーダリティと早期統合

言語モデルを学習してから視覚機能に適応させるこれまでのアプローチとは異なり、Llama 4はネイティブのマルチモーダルモデルとして設計されている。モデルのバックボーンネットワークにテキストと視覚のトークンをシームレスに統合するアーリーフュージョン戦略を採用している。これは、大量のラベル付けされていないテキスト、画像、ビデオデータを使ってモデルを共同で事前訓練できることを意味する。 Llama 4はビジュアルエンコーダーも改良しており、MetaCLIPをベースにしていますが、大規模な言語モデルに対応できるよう、凍結されたLlamaモデルと共同訓練されています。このモデルは、事前学習では最大48の画像入力を扱うことができ、事後学習テストでは最大8つの画像入力で良好な結果を出し、視覚的推論と理解のために複数の画像入力とテキストキューを扱うことができる。

画期的な1000万トークン・コンテクスト・ウィンドウ

Llama 4 Scoutのもう一つの特徴は、業界をリードする最大1000万トークンのコンテキストウィンドウです。このような巨大なコンテキスト容量は、例えば、非常に長い文書の処理、大規模なデータセットの分析、長期記憶を必要とする対話の実施などに新たな可能性を開きます:

- 複数の長大なレポートや書籍の要約と質疑応答。

- コードベース全体を分析し、依存関係を理解したり、エラーを発見したりする。

- 数週間、あるいは数ヶ月にわたるユーザーのアクティビティに基づいて、パーソナライズされた詳細なサービスを提供する。

- 法律や医療など、大量のテキストを処理する必要がある分野での情報抽出と分析。

メタは、スカウトの長いコンテクスト能力は革新的なものであるとしている。 iRoPE アーキテクチャこのアーキテクチャは、事前学習と事後学習の両方に256Kのコンテキスト長を使用し、長さの汎化を強化するために、インターリーブされた注意層(位置埋め込みなし)と推論時間の温度スケーリングを組み合わせている。i "はインターリーブ、"RoPE "はRotary Position Embeddingsを意味し、"無限 "をサポートすることを示唆している。i」はインターリーブ、「RoPE」はRotary Position Embeddingsを意味し、「無限」の文脈長をサポートするという長期的な目標を示唆している。

トレーニング方法とパフォーマンス

ラマ4の開発には、トレーニング・プロセスに多くの改良が加えられた。

トレーニング前の段階:

- データと規模学習データの総量は30兆トークンを超え、Llama 3の2倍以上。テキスト、画像、動画の多様なデータセットを含む。200の言語をサポートし、100以上の言語が10億トークン以上の学習データを持つ。

- 効率と精度トレーニングはFP8精度で実行され、計算効率(32K GPU上のBehemothでは390 TFLOPs/GPU)を向上させる一方、品質は犠牲にしないと主張しています。

- ハイパーパラメータの最適化主要なハイパーパラメータ(レイヤごとの学習率、初期化スケールなど)を確実に設定するためのMetaPと呼ばれる新しい手法を開発し、これらのパラメータがバッチサイズ、モデル幅、深さ、学習トークン数にわたってうまく移行することを発見した。

- トレーニング中長いコンテキストの能力を拡張し、コアパフォーマンスを向上させるために、事前訓練後に特定の訓練方法とデータセットを導入する。

トレーニング後の段階:

- 新プロセス軽量教師付き微調整(SFT)→オンライン強化学習(RL)→軽量直接選好最適化(DPO)という新しいプロセスが採用された。 メタは、従来のSFTとDPOがモデルを過度に制約し、RL段階での探索を制限し、推論、コーディング、数学的能力に影響を与えることを発見した。

- データのフィルタリングLlamaモデルを判定に使用し、より難しいデータセットでは軽量SFTに集中することで、「簡単」とラベル付けされた50%以上のSFTデータを削除。

- オンライン集中学習マルチモーダルオンラインRLの段階で、より難しいプロンプト(促し)を注意深く選択することで、大幅な性能向上が達成された。連続的なオンラインRL戦略を採用し、モデルの訓練と、モデルでフィルタリングされたデータの使用を交互に行い、中程度から難易度の高いプロンプトのみを残すことで、計算量と精度のバランスをとった。

- 軽量DPO最後に、モデルのインテリジェンスと対話能力のバランスを取りながら、モデルの応答の質に関連する境界ケースに対処するために、軽量DPOが実行される。

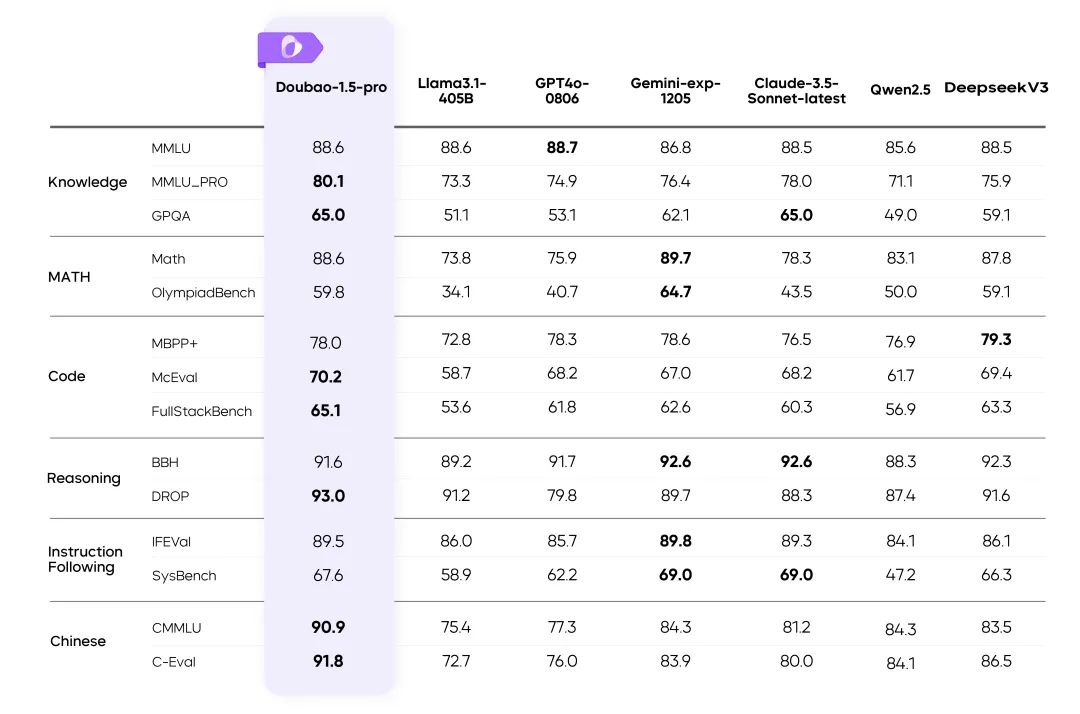

パフォーマンス比較:

メタはベンチマーク結果を発表した:

- ラマ4マーベリックコーディング、推論、多言語、長い文脈、画像ベンチマークにおいてGPT-4oとGemini 2.0を上回る。コーディングと推論において、より大きなパラメータスケールでDeepSeek v3.1に匹敵。

- ラマ4スカウトGemma 3、Gemini 2.0 Flash-Lite、Mistral 3.1、そして前世代のLlama全モデルを凌ぐ、クラス最高のパフォーマンス。イメージ・グラウンディングにおいて、ラマ前モデルを凌駕。

ベンチマーク結果は通常、特定の条件下で得られたものであり、実際のアプリケーションでの性能は異なる可能性があることに注意することが重要である。しかし、これらのデータは、少なくともラマ4が多くの次元で業界をリードするモデルと競合する可能性を持っていることを示している。

ベヒーモス:2兆パラメータを持つ "教師 "とトレーニングの課題

Llama 4 Behemothは、非常に大規模なモデルを訓練するMetaの能力を実証するためだけでなく、Llama 4の開発における「教師」として機能するために存在する。コディスティレーションによって、Behemothはその数学、多言語、画像理解の力をより小さなMaverickモデルに移し、Metaは新しいコディスティレーション損失関数を開発し、学習プロセス中にソフトターゲット(教師モデルからの確率分布)とハードターゲット(実際のラベル)の重みを動的に調整した。の重みを調整する。この事前学習中の協調的な蒸留は、生徒モデルの蒸留ターゲットを計算するための多大な計算コストを軽減する。

2兆ものパラメーターを持つモデルをトレーニングすることは、それ自体が巨大なエンジニアリングの挑戦である:

- データ・プルーニングパフォーマンスを最大化するために、SFTのデータは小型モデルよりも積極的に刈り込まれる必要があり、95%も刈り込まれる。

- 集中学習軽量SFT後の大規模RLは、モデルの推論とコーディング能力を向上させるために特に重要である。RL戦略は、pass@k分析を通じて困難なキューを選択し、難易度を上げていくトレーニングセッションを構築することに重点を置いている。ゼロアドバンテージのキューを動的にフィルタリングし、異なる能力次元のキューを訓練バッチに混ぜることは、数学的、推論的、コーディング的パフォーマンスを向上させるために重要である。

- 指示は以下の通り。多様なシステム命令(システムインストラクション)をサンプリングすることは、推論やコーディングの作業においてモデルが命令の忠実性を維持するために非常に重要です。

- インフラMoEアーキテクチャとハイパースケールのために、Metaは並列化設計を最適化し、完全非同期オンラインRLトレーニングフレームワークを開発しました。このフレームワークは、異なるモデルを異なるGPUに柔軟に割り当てることを可能にし、計算速度に基づいてリソースをバランスさせ、トレーニング効率は前世代に比べて〜10倍向上したと報告されています。

セキュリティとバイアスの緩和

すべての大規模モデル開発者と同様に、Meta社はLlama 4の開発においてセキュリティと責任あるAIに重点を置いている。そのアプローチは、モデル開発のライフサイクル全体をカバーしている:

- トレーニング前後の緩和: : 学習前段階ではデータフィルタリングなどの手段を使用し、学習後段階では、モデルを使用戦略に適合させるために各段階で適切な量の安全データを注入するなど、様々な手法を適用する。

- システムレベルのツールMetaは、開発者が統合できるさまざまなセキュリティ・ツールをオープンソース化している:

- ラマ・ガード:: MLCommonsのリスク分類法に基づいて開発された入出力セキュリティ検出モデル。

- プロンプト・ガード:: 悪意のあるヒント(例:脱獄攻撃)やインジェクション攻撃を検出するための分類モデル。

- サイバーセック評価生成AIネットワークのセキュリティリスクを評価し、軽減するための評価ツール。

Meta社は、これらのツールのカスタマイズ可能性を強調し、開発者がセキュリティ・ポリシーを自身のニーズに適応させることを可能にする。

- 評価とレッドチームテスト自動および手動の敵対的プロービングによるシステムのモデルテストを実施。というシステムを開発した。 GOAT(ジェネレイティブ・オフェンス・エージェント・テスト) の新しいアプローチでは、中程度のスキルを持つ攻撃者による複数回のやりとりをシミュレートすることで、テストのカバレッジと効率を向上させ、人間のレッドチーム専門家がより最先端のリスク領域に集中できるようにしている。

偏見への対応

Metaは、大規模な言語モデルに蔓延するバイアスの問題を認識しており、特に、論争の的となる政治的・社会的トピックについて特定の立場を支持する歴史的な傾向は、インターネット学習データに内在するバイアスに一部起因している。 Llama 4の目標は、モデルのバイアスを除去し、論争的な問題のさまざまな側面を偏見や判断なしに理解し、表現できるようにすることです。

Metaは、Llama 4はこの分野で大きな進歩を遂げ、Llama 3を凌駕し、Llama 3と比較しても有利であると主張している。 グロック かなりね:

- 物議を醸す政治的・社会的問題については、回答拒否の割合がラマ3.3の7%から2%以下に減少した。

- プロンプトのうち、不均等な(偏った)拒否回答を示した割合は、拒否回答の1%よりも低かった。

- 物議を醸すような政治的・社会的問題については、ラマ4世は強い政治的バイアスを示し、グロクと同程度の回答頻度で、ラマ3.3の約半分である。

メタ社は、モデルの偏り率を減らす努力を続けるとしている。

オープン性、ユーザビリティ、エコシステム

Llama 4 ScoutとLlama 4 Maverickは現在llama.comとHugging Faceでダウンロード可能で、すべての主要なクラウド、データ、エッジ・コンピューティング・パートナーに提供される予定です。ユーザーはLlama 4を搭載した メタAI .

メタ社は、オープンなエコシステムへのコミットメントを再度強調し、オープン性がイノベーションを促進すると信じている。 Llama 4のリリース、特にそのMoEアーキテクチャ、ネイティブのマルチモーダル機能、超ロングコンテキストウィンドウは、AI開発者や研究者に強力な新ツールを提供することは間違いない。しかし、これらの高度なモデルの実際の性能、使いやすさ、微調整のコスト、そして「パーソナライズされた体験」を推進する際にそれらがもたらす潜在的なリスクは、まだテストされ観察される必要がある。 Llama 4シリーズが本当にMetaが主導するAIの新時代を切り開くかどうかは、最終的には市場が答えを出すことになるだろう。 Metaは4月29日に開催されるLlamaConでも、そのビジョンについてさらなる情報を共有する予定だ。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません