kun-lab: Ollamaベースのネイティブ軽量AI対話クライアント

はじめに

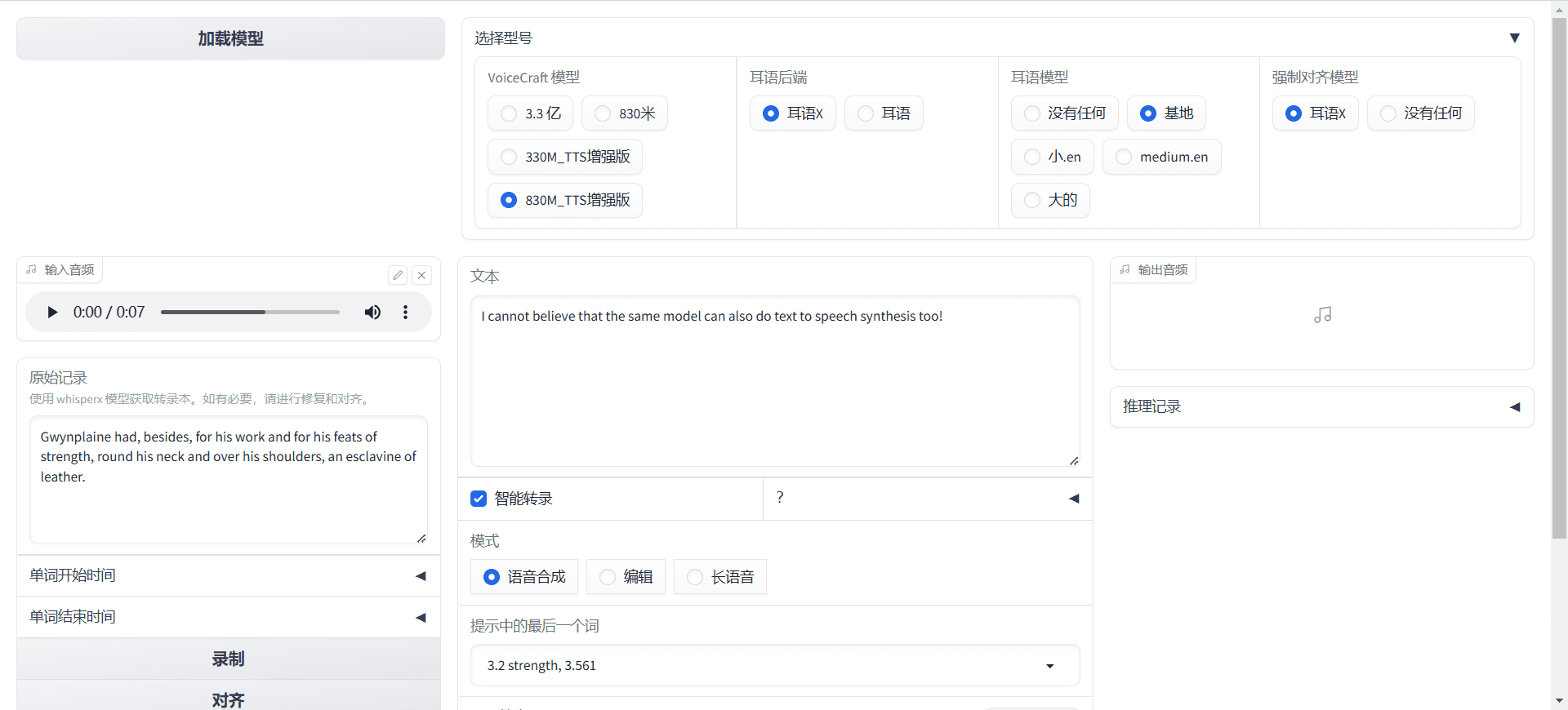

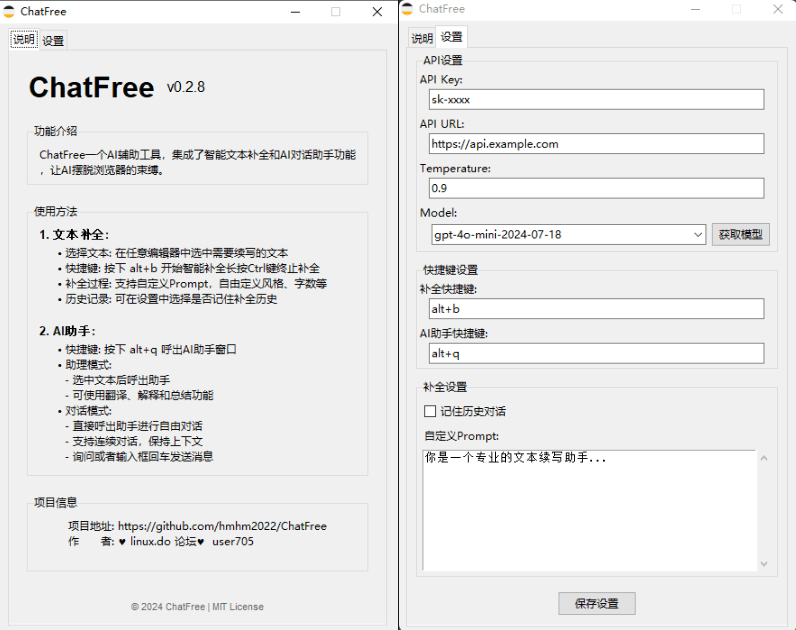

kun-labは、次のようなプログラムです。 オーラマ は、軽量、高速、ローカライズされたインテリジェントな対話体験を提供することに重点を置いたオープンソースのAI対話アプリです。Windows、macOS、Linuxをサポートし(現在はWindowsがメイン)、使用するのに複雑な設定は必要ない。ユーザーはAIとスムーズな複数ラウンドの会話を行い、文書を解析し、画像を識別し、オンラインで答えを検索することもできる。kun-labは、開発者、学生、または効率的なAIツールを必要とする人のために、コードレンダリング、プロンプトテンプレート、多言語インターフェースも提供している。

機能一覧

- 知的対話複数ラウンドのリアルタイム対話、スムーズなAI応答、より包括的な回答のためのネットワーク検索をサポートしています。

- 文書解像度PDF、DOC、PPT、TXTファイルをアップロードしてください。

- 画像認識JPG、PNG画像の認識、テキスト抽出、シーン分析、多ラウンド対話をサポートします。

- モデル・マネージメントGGUFとsafetensorsのフォーマットをサポートしています。

- キュー・ワードのテンプレート内蔵のテンプレートとカスタマイズのサポートにより、AIの創造性を簡単に刺激することができます。

- コード・レンダリング複数のプログラミング言語コードを自動的にハイライトし、わかりやすく表示します。

- 簡単なメモMarkdown構文、リアルタイムプレビュー、ワンクリックでのエクスポートをサポートします。

- マルチユーザーサポート複数の人が同時にログインし、それぞれ独立した対話スペースを持つことができます。

- 多言語インターフェース中国語、英語と他の言語をサポートし、よりフレンドリーな操作。

ヘルプの使用

kun-labは、Ollama上で動作する機能豊富なAI対話ツールで、操作が簡単でローカルでの使用に適しています。以下に、インストール手順、コア機能、使い始めの手順について詳しく説明します。

kun-labのインストール

kun-labはデスクトップアプリケーションとソースコードデプロイの両方を提供しています。現在、デスクトップアプリケーションはWindowsのみ、ソースコードデプロイはWindows、macOS、Linuxをサポートしています。

モード1:デスクトップアプリケーション(推奨)

- GitHubのリリースページ(https://github.com/bahamutww/kun-lab/releases)をご覧ください。

- お使いのシステムに適したインストールパッケージをダウンロードしてください:

- ウィンドウズ

.exeドキュメンテーション - macOS:

.dmgドキュメント(将来のサポート)。 - Linuxだ:

.AppImageもしかしたら.debドキュメント(将来のサポート)。

- ウィンドウズ

- インストールパッケージをダブルクリックし、プロンプトに従ってインストールを完了します。

- インストール後、デスクトップアイコンをクリックすると、追加設定なしでkun-labが起動します。

- 起動後、言語を選択し(デフォルトで中国語をサポート)、メインインターフェイスに入ります。

アプローチ2:ソースコードの展開

カスタマイズや開発をしたい場合は、環境をインストールしてコードを実行する必要がある。以下はその詳細な手順である:

- 環境を整える::

- システムがWindows、macOS、またはLinuxであることを確認してください。

- Python 3.10以降をインストールする(ダウンロード:https://www.python.org)。

- Node.js 20.16.0以降をインストールする(ダウンロード:https://nodejs.org)。

- Ollamaをインストールし、サービスを開始する(参考:https://ollama.com)。

- クローン倉庫::

git clone https://github.com/bahamutww/kun-lab.git cd kun-lab - 仮想環境の構築::

python -m venv venv .\venv\Scripts\activate # Windows # source venv/bin/activate # macOS/Linux - バックエンドの依存関係のインストール::

cd backend pip install -r requirements.txt - フロントエンドの依存関係をインストールする::

cd frontend npm install - 環境変数の設定::

cp .env.example .env- テキストエディタで開く

.envファイルを開き、必要に応じて設定(ポート番号など)を変更する。

- テキストエディタで開く

- アプリケーションを起動する::

python run_dev.py - ブラウザを開き、http://localhost:5173。

コア機能の操作

ここでは、kun-labの主な機能と具体的な操作方法について説明します。

1.インテリジェントなAI対話

- 対話の開始::

- kun-labを開き、「チャットダイアログ」または「新規ダイアログ」をクリックします。

- モデルリストからモデルを選択します(デフォルトではOllamaが提供するモデルがあります)。

- 質問を入力すると、AIがリアルタイムで回答する。

- インターネット検索::

- 質問が最新の情報を必要とする場合は、「ウェブ検索を有効にする」にチェックを入れてください。

- AIはウェブページのデータを組み合わせて、より包括的な答えを出す。

- 歴史の管理::

- 会話は自動的に保存され、サイドバーの「履歴」をクリックすると見ることができる。

- ダイアログは削除またはエクスポートできます。

- コードサポート::

- コードに関連する質問を入力すると、AIがコードをハイライト表示する。

- Python、JavaScript、その他の言語をサポート。

2.文書解析

- 文書のアップロード::

- ドキュメントダイアログ画面をクリックします。

- アップロード」ボタンをクリックし、PDF、DOC、PPT、またはTXTファイルを選択します。

- 文書が解析されると、AIは文書の要約を表示する。

- 質問をする::

- ダイアログボックスに文書に関する質問を入力します。

- AIは内容に基づいて回答し、文脈をサポートする。

- 検索内容::

- キーワードを入力すると、AIが文書の該当箇所をすばやく検索します。

- 結果をクリックすると元記事の場所にジャンプします。

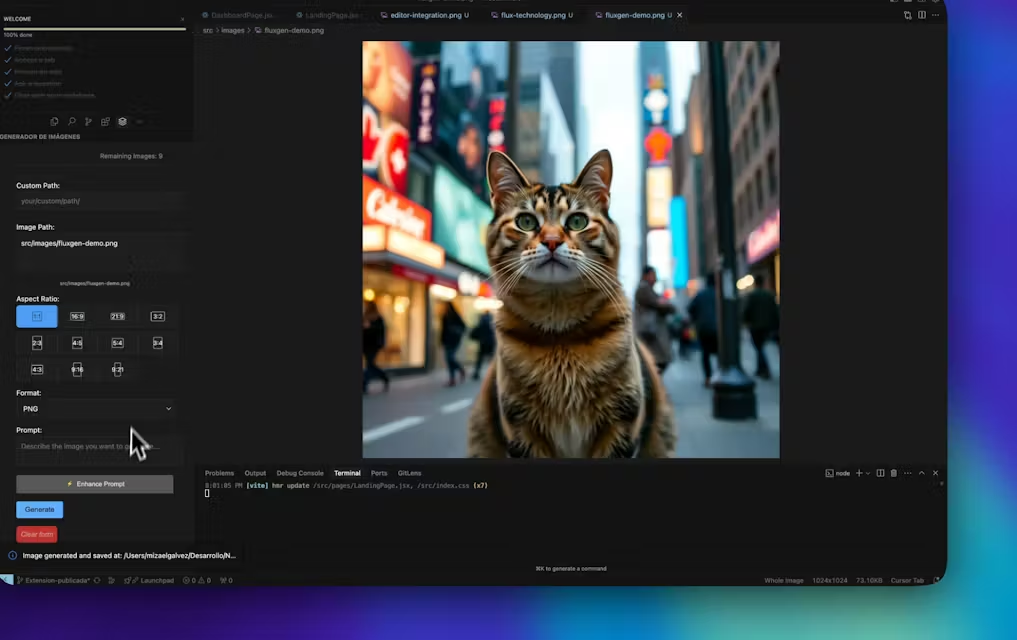

3.画像認識

- 写真をアップロードする::

- ピクチャー・ダイアログ」のページへ。

- 画像のアップロード」をクリックし、JPG、PNG、JPEGファイルを選択します。

- AIが自動的にシーンを認識したり、テキストを抽出したりする。

- 重層的対話::

- "この写真には何が写っていますか?"など、写真に基づいた質問をする。.

- AIが答えた後、さらに深い質問を続けることができる。

- OCR機能::

- 画像にテキストが含まれている場合、AIはそれを抽出して表示する。

- テキストをコピーしたり、テキストベースの質問をすることができる。

4.モデル管理

- プルモデル::

- モデル・ライブラリーのページに行く。

- プルモデル」をクリックする。

- 次のようなコマンドを入力する。

ollama run qwq:32bもしかしたらollama run hf.co/Qwen/QwQ-32B-GGUF:Q2_K. - ダウンロードが完了し、モデルが使用可能になるのを待ちます。

- モデルの切り替え::

- ダイアログページで、Modelドロップダウンメニューをクリックする。

- ダウンロードしたモデルを選択し、すぐに切り替える。

- カスタムモデル::

- カスタマイズ」ボタンをクリックする。

- モデル名とシステムプロンプト(「Play Maths Teacher」など)を入力します。

- ベースモデルを選択し、「作成」をクリックします。

5.キュー・マネジメント

- テンプレートの使用::

- プロンプト」画面を開く。

- 記事の概要を書く」や「コードのデバッグ」のような組み込みのテンプレートを閲覧します。

- ダイアログに直接適用するには、テンプレートをクリックしてください。

- カスタム・キュー::

- New Cue "をクリックしてください。

- 名前と内容を入力して保存すれば、並べ替えや管理ができる。

- クイックアプリ::

- 対話中にプロンプトの単語を選択すると、AIは設定されたとおりに応答する。

6.クイックノート

- ノートの作成::

- ノートページをクリックします。

- タイトル、リスト、コードなどのコンテンツをMarkdown形式で入力します。

- 右側のエフェクトのリアルタイムプレビュー。

- ノートのエクスポート::

- エクスポート "ボタンをクリックし、名前を付けて保存する。

.mdドキュメンテーション - 他のツールとの共有やインポートが可能。

- エクスポート "ボタンをクリックし、名前を付けて保存する。

ほら

- Ollamaサービスが起動していることを確認してください。起動していない場合、AI機能は使用できません。

- 初めてモデルを引っ張り出すには時間がかかるかもしれないので、インターネット接続をチェックすることをお勧めする。

- ローカルに保存されたデータは多くのスペースを占め、定期的に履歴を消去する。

- 問題が発生した場合は、GitHubの

issuesページをご覧いただくか、ご意見をお寄せください。

以上の手順で、kun-labの機能を簡単にインストールして使うことができます。対話でも、文書解析でも、画像解析でも、直感的で便利な操作が可能です。

アプリケーションシナリオ

- パーソナル・ラーニング・アシスタント

学生はkun-labを使って教材や教科書を解析し、質問をするとAIが詳しく答えてくれる。数学のプリントをアップロードすれば、AIが公式を順を追って説明してくれる。 - 開発ツール

プログラマーは、kun-labを使ってコードをデバッグしたり、新しい言語を学ぶことができる。コード・スニペットを入力すると、AIが最適化の提案を行い、ハイライト表示する。 - ドキュメンテーション

キャリアプロフェッショナルは、ドキュメント解析機能を使ってレポートを素早く要約することができます。長いPPTをアップロードすると、AIが重要なポイントを抽出し、簡潔なメモを生成します。 - 創造的探求

クリエイターは、プロンプトのワードテンプレートを使ってストーリーやデザインのインスピレーションを生み出すことができます。スケッチをアップロードすると、AIが分析して改善点を提案します。

品質保証

- kun-labはインターネットに接続する必要がありますか?

コア機能はローカルで実行され、ネットワークを必要としない。ネットワーク検索機能はオプションで、手動でオンにする必要があります。 - どのような文書フォーマットに対応していますか?

PDF、DOC、PPT、TXTファイルをサポートし、将来的にはさらに多くのフォーマットに対応する可能性があります。 - 新しいモデルを追加するには?

モデルライブラリ画面でollama runコマンドでオーラマやハギング・フェイスのモデルを引っ張る。 - データは安全か?

プライバシーとセキュリティを確保するため、データはすべてローカルに保存され、クラウドにはアップロードされない。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません