ココロTTS API: 高速音声合成のためのDocker化FastAPIラッパー (ココロ-82Mモデル)

はじめに

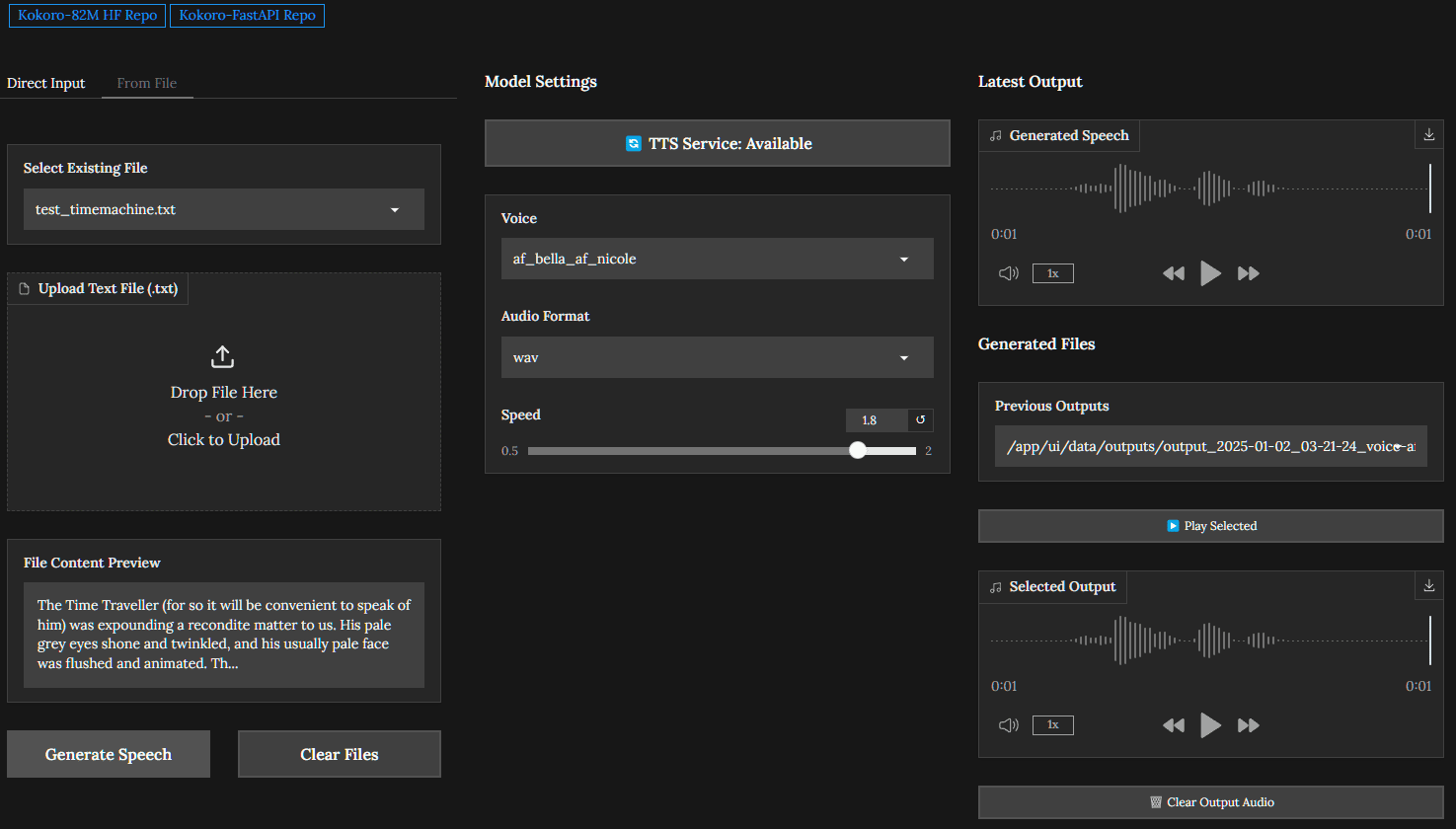

Kokoro-FastAPIは、Kokoro-82M音声合成モデルのサポートを提供するために設計されたDockerベースのFastAPIパッケージです。このプロジェクトはNVIDIA GPUアクセラレーションをサポートし、生の成長したテキストの音声出力をより効率的で首尾一貫したものにするためのキュー処理と自動スプライシングを提供します。このプロジェクトはGitHubユーザーのremskyによって開発され、GitHubで公開されている。ユーザーはAPIインターフェースを通じて音声合成のリクエストを行うことができ、音声生成を必要とする様々なアプリケーションシナリオで高品質の音声出力を得ることができる。

機能一覧

- ココロ-82M音声合成モデルのAPIパッケージの提供

- NVIDIA GPUアクセラレーションに対応し、音声生成効率を向上

- 同時リクエストをサポートするキュー処理機能

- 自動スプライシング機能により、長文の一貫した音声出力を実現

- Docker化されたデプロイメントにより、インストールと設定を簡素化

- 開発者が使い始めるためのサンプルコードとドキュメントを提供する。

ヘルプの使用

設置プロセス

- DockerとNVIDIA Dockerサポートがインストールされていることを確認してください。

- Kokoro-FastAPIプロジェクトリポジトリをクローンします:

git clone https://github.com/remsky/Kokoro-FastAPI.git

- プロジェクト・ディレクトリに移動し、Dockerイメージをビルドする:

cd Kokoro-FastAPI docker build -t kokoro-fastapi . - Dockerコンテナを起動する:

docker run --gpus all -d -p 8000:8000 kokoro-fastapi

APIインターフェースの使用

- APIドキュメントにアクセスする:

ブラウザを開き、http://localhost:8000/docs、APIドキュメントを閲覧し、インターフェイスをテストする。 - 音声合成リクエストを送信する:

POSTリクエストを使って、メッセージを/generateインターフェースは、例えばテキストデータを送信する:curl -X POST "http://localhost:8000/generate" -H "accept: application/json" -H "Content-Type: application/json" -d '{"text": "你好,世界!"}' - 音声出力を得る:

リクエストに成功すると、生成された音声ファイルのURLが返され、ユーザーはファイルをダウンロードまたは再生することができます。

サンプルコード

このプロジェクトは、開発者がすぐに始められるようにサンプルコードを提供している:

- test_openai_tts.pyのサンプルは、APIを使用して音声合成リクエストを行う方法を示しています。

詳しい操作手順

- システムがハードウェアおよびソフトウェアの要件、特にNVIDIA GPUおよびCUDAドライバを満たしていることを確認します。

- インストール手順に従って、Kokoro-FastAPIサービスをインストールし、起動します。

- 音声合成リクエストを送信するには、APIドキュメントとサンプルコードを参照してください。

- 音声出力ファイルの取得とその後の処理および使用。

以上の手順により、ユーザはココロ-FastAPIを簡単に導入・利用することができ、効率的な音声合成機能を実現し、様々なアプリケーションシナリオに高品質な音声生成サービスを提供することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません