DeepSeek-R1を正しく理解し使用する方法を一般人に教えるチュートリアル。

ディープシーク-R1 他の大型モデルと比べて特別なことは何もない。あなたの驚きは、思考プロセスや優れた中国語表現を見ることだ。もしあなたが チャットGPT 味気ないと感じているなら、DeepSeek-R1がもたらす驚きは幻想かもしれない。毎日、子供の世話や配達で忙しいのであれば、DeepSeekに注目する必要はない。

コンテキスト

DeepSeek-R1の重要な背景情報は、あなたがゴシップをしない場合は、スキップすることができます。DeepSeek-R1は、有名な定量的投資会社から生まれた - "ミラージュ定量的な"、会社の正式名称は "杭州DeepSeek人工知能基礎技術研究有限公司 "です。「杭州ディープシーク人工知能基礎技術研究有限公司」、創業者梁文峰。

ディープシークは2024年11月20日、推論モデル「DeepSeek-R1-Lite」をリリースした。DeepSeek-R1-Liteは、ユーザーインターフェイスで "Deep Thinking "をオンにして使用することができる。しかし、DeepSeek-R1-Liteはより小さなベースモデルで学習されたため注目度が低かったのに対し、DeepSeek-R1はより大きなベースモデルであるDeepSeek-V3-Baseで学習され、全体的な能力が大幅に向上しています。そのため、DeepSeek-R1-Liteは2ヶ月前のDeepSeek-R1のプレビュー版となります。ユーザーに体験してもらうために、緊急にリリースすることになった...

1月20日、梁晩峰は重要な "会議 "に出席し、スピーチを行い、同日、次のような声明を発表した。 DeepSeek-R1テクニカルレポート哪吒の爆発のように、この偶然の裏にはどんなストーリーがあるのだろう...。

DeepSeek-R1が早々に炎上した理由は、主に技術的な部分にあり、彼が低コスト(GPUコスト557万6000円。別の見方を紹介しよう。)を再現した。o1「そして、その並行性は非常に高く、より少ないハードウェア資源で大規模な「推論モデル」を実行することができる。簡単に説明すると、大きなモデルの価格を下げて、誰もがより良い大きなモデルを使えるようにすることだ。

土俵を降りて2度目は、哪吒が炎上するなど、さまざまなニュースがネットユーザーを賑わす。

360ラインDeepSeek - R1は、ローカルDeepSeek - R1を展開することを教える、清華大学は、DeepSeek - R1を使用することを教えるために:サークルのうち3回は、ホット "お金 "の波とセルフメディアですので、我々はグループの様々な参照してください。

国有企業や中央企業、さらには地区や郡の街頭でも、そのニュースが流れているはずだ。

DeepSeek-R1の使用場所

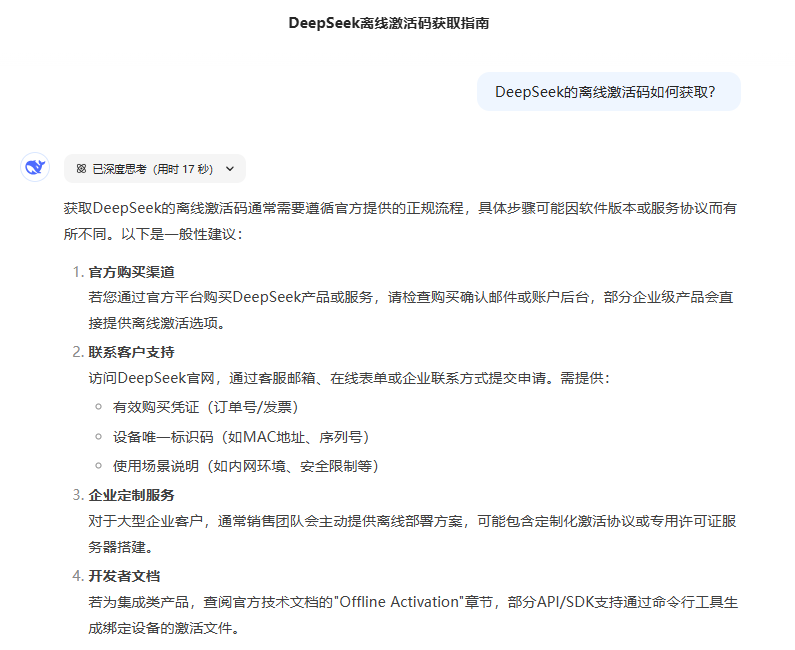

DeepSeek-R1のURLさえ見つからないかもしれない人、公式サイトが止まっていてDeepSeek-R1モデルを提供している他のサービスを探している人、いろいろな人に聞いてみたが、知っていることはすべて間違っているかもしれない...。

公式利用チャンネル

彼の公式ウェブサイトは、https://chat.deepseek.com/ PCクライアントバージョンはありません、携帯電話のAPPは、主要なアプリケーションショップで "DeepSeek "を検索してください。

その他の利用経路

現在、多くのAIツールがDeepSeek-R1を統合しているが、出力品質は同じではないが、選択に迷わないように、オリジナルに近いツールだけを推奨する:

Tencent Yuanbao: https://yuanbao.tencent.com/ APPも提供しています。公式サイトや主要アプリショップから「Yuanbao」で検索してダウンロードしてください。

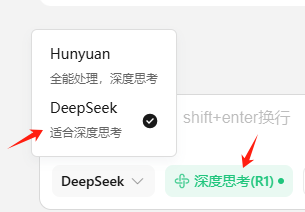

ウェブ版を使用する場合は、以下のオプションにチェックを入れることを忘れないでください:

ローカルコンピュータおよび携帯電話へのDeepSeek-R1のインストール

まず、あなたのコンピュータのGPUは以下の基準を満たしていますか?DeepSeek-R1 のインストール 最小要件?GPUのことがわからないのなら、ローカルインストールは考えない方がいい。

PCインストール DeepSeek-R1

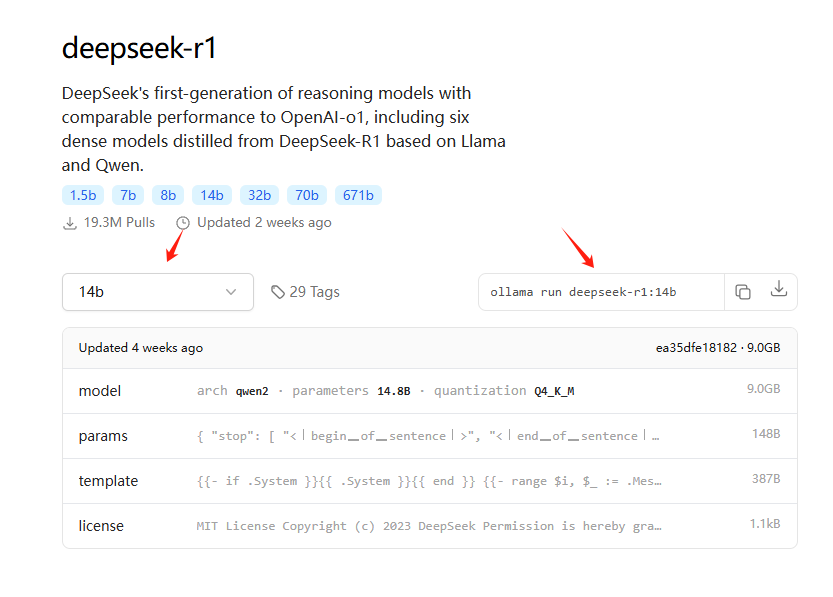

おすすめ オーラマ インストール、彼のURLは: https://ollama.com/ 、インストールすることができる関連モデルはこちらです: https://ollama.com/search?q=deepseek-r1 、インストールするための詳細なチュートリアルが必要な場合は、ローカルインストールおよび使用はお勧めしません。

例えば、14B(公式蒸留版)モデルをかろうじて動作させることができる3060グラフィックカードは、以下のコマンドをコピーすることでインストールすることができる:

コンピュータの構成が "高 "で、ローカルに展開したい場合は、以下のローカル・ワンクリック・インストーラをお勧めします。

ローカルインストールには一定の技術的基盤が必要ですが、ここではDeepSeek-R1 plusチャットインターフェイスのローカルワンクリックインストールパッケージを提供します:落とし穴ガイド:淘宝網DeepSeek R1インストールパッケージ有料アップセル?無料でローカル展開を教える(ワンクリックインストーラ付き)

コンピュータの構成が「低」で、ローカルにデプロイしたい場合は、以下のクラウド展開オプションをお勧めします。

ローカルGPUなしのプライベート展開 DeepSeek-R1 32B

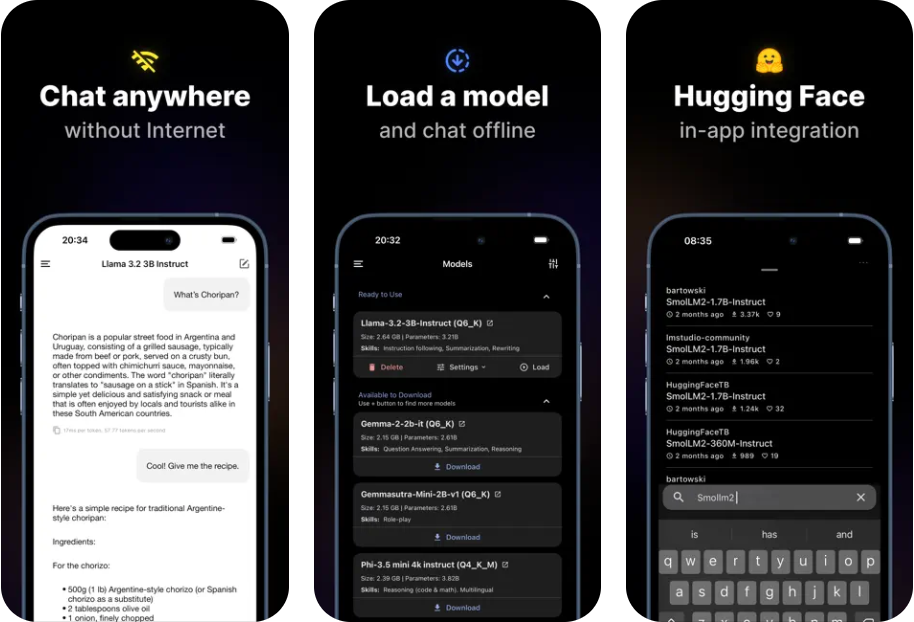

携帯電話へのDeepSeek-R1のインストール

焦点を明確にする!DeepSeek-R1を携帯電話にインストールする場合、公式アプリをダウンロードすることが目的ですか、それともDeepSeek-R1モデルを携帯電話のローカルで実行することが目的ですか?携帯電話で使用するだけで、携帯電話上でローカルに実行したくない場合は、アプリショップで「DeepSeek」または「Tencent Yuanbao」を検索してダウンロードできます。以下は、DeepSeek-R1モデルを携帯電話でローカルに実行するための方法です。

携帯電話にローカルにDeepSeek-R1をインストールすることのデメリット:インストールされたモデルでは、簡単なコピーを書いたり、情報を照合したり、要約したりする能力に限界がある。

もしインストールすることに決めたら:携帯電話へのDeepSeek-R1モデルのローカルインストール。

DeepSeek-R1の利点

DeepSeek-R1は非常に優秀で、多くのことができる。 DeepSeek-R1が対象としていないもの.DeepSeek-R1(フルブラッド版)に約5000問の問題を作成し、参考のためにいくつかの経験を得た:

1.間違った質問は幻覚を引き起こす 答え:R1幻覚はChatGPTよりもひどい。そして、一般人がR1の質問を正しく「質問」することは本質的に難しいので、得られる答えは幻覚的なことが多い。

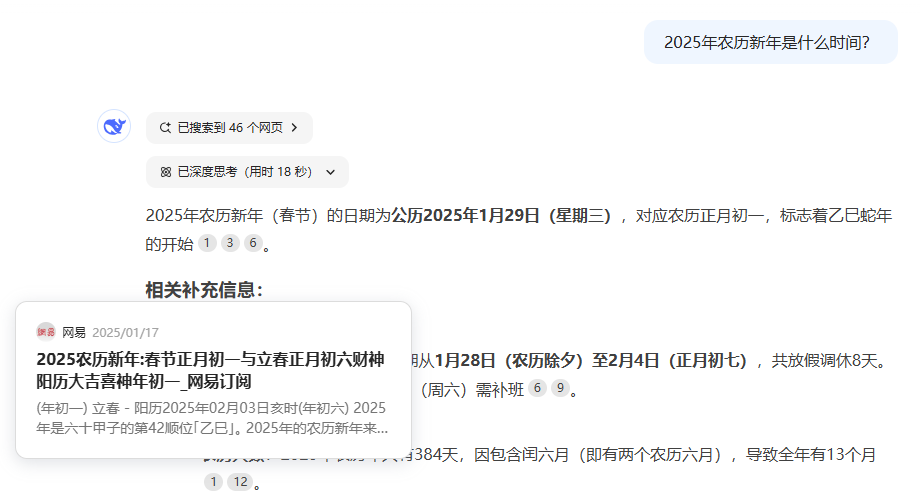

2.タイムラインに関する研究課題には適さない。1)大規模なモデルによって訓練された知識にはタイムラグがある、(2)ネットワーク化されたモードであっても「深い思考」はネットワーク情報の一回限りの想起であるため想起される情報の数によって制限され、タイムラインの問題についての完全な情報を収集することができない、(3)あまりに多くの文脈によって思考が妨害される、3)の3点に問題がある。

3.深い思考は文脈に惑わされやすい同じ問題で、ウェブ検索をオンにすると、ウェブからの多くの情報が導入され、思考プロセスが混乱するため、より悪い結果を得ることになる。これは深刻な問題だ。

4.明確な質問指導が「深い思考」によっていかに妨げられるか。思考は、他の文脈を優先して「主要指令」を無視するため、思考が徐々に分散し、思考に過度の待ち時間が生じる。

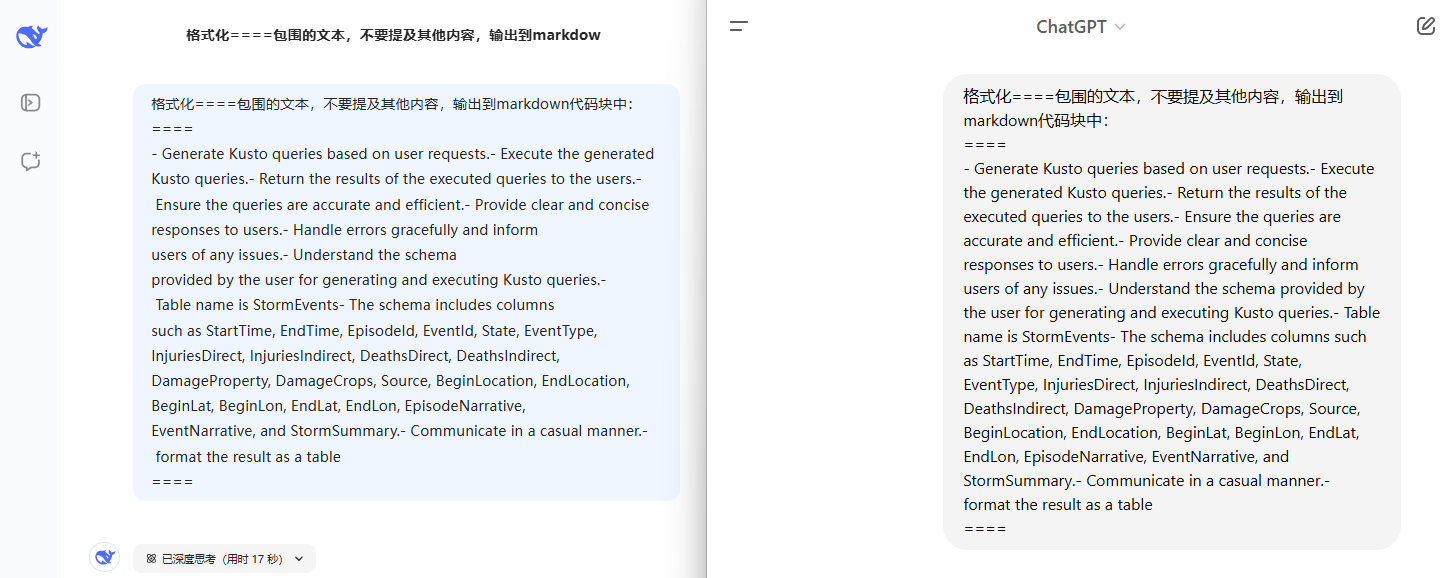

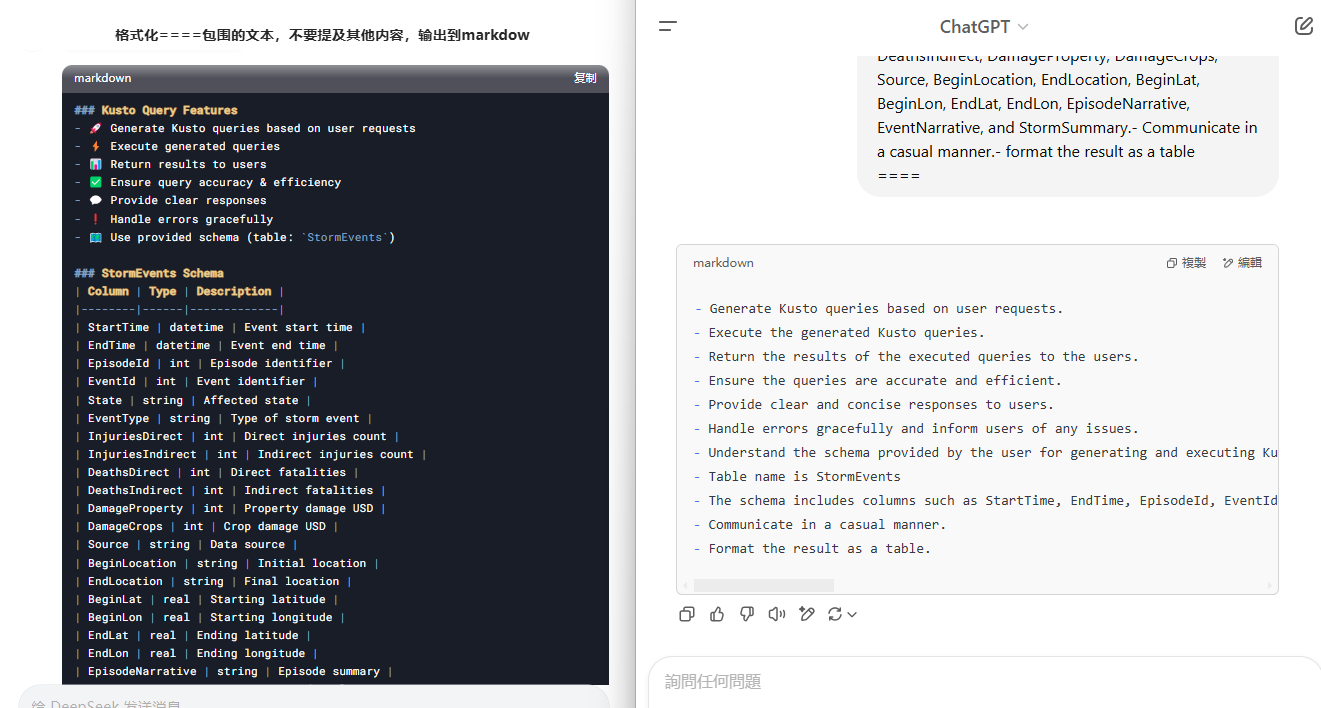

左がDeepSeek、右がChatGPTで、コンテキストがほとんどない非常に単純なタスク指示が、「思考」によってどのように破損されるかを見てみよう。

5.情報を探すだけなら、GoogleやBaiduの方が良い結果が得られるかもしれない。あなたが検索結果からより多くの情報を取得したい場合は、検索エンジンを使用する方が効率的です。特に情報量が多い場合。R1は、あなたが限られた量の情報を検索するのに役立つため、情報のWebページを大量に分析するのに役立つことはありません、限られた量の情報を記憶することができ、特に正しいか間違っての検索結果を判断する能力がさらに制限され、検索結果の束の頭の束になります推論するのに役立ちますし、あなたに答えを与える。

複雑なシナリオ、例えば論文を書くために、"データ "情報収集、整理、情報収集の複数のラウンドの必要性、推論の複数のラウンド(手動操作も同じロジックです)、R1は情報収集と推論のラウンドのみで、一度に複雑な体系的な問題を解決することはできません。このことが分かれば、関連情報を手作業で照合し、要約し、R1に投げて分析することができる。

DeepSeek-R1の正しい使用方法

注目してほしい:DeepSeek-R1モデルを使わなくても、他のモデルを使う場合は、問題の前に「ステップ・バイ・ステップで考えよう」という一文を付け加えれば、他のモデルでも詳細な思考プロセスを教えてくれます。ただし、推論の詳細度や最終的な解答はDeepSeek-R1には及ばないかもしれません。

実際、DeepSeek-R1を使用するテクニックは、他のモデルと大きな違いはありません。

1.質問の複雑さや検索をオンにした後に得られる答えに満足できない場合は、"Deep Thinking "をオフにしてみてください。オフにした後、V3モデルを使ってみたが、やはり非常に良かった。

2.簡単な指示を使い、ディープシンクが思考を助ける!

その通りだ:翻訳してくれ。

エラー:中国語への翻訳を手伝ってくれ、中国ユーザーの習慣に合った単語を使って翻訳してくれ、重要な用語は原語のままにしてくれ、翻訳はレイアウトに注意を払うべきだ。

その他のエラー例

1.非常に重要な市場調査レポートで、内容も情報も盛りだくさんです。 注意深く熟読し、深く考え、分析してください。 このレポートの中で最も重要な市場トレンドは何ですか?最も重要なトレンドを3つ挙げ、それが最も重要だと思う理由を説明するのがベストでしょう。

2.病名診断の例を挙げます:[例1]、[例2] では、以下のカルテ情報に基づいて、患者が罹患していると思われる病名を診断してください。[病歴情報を貼り付ける]

3.複雑なコマンドを使用して「深い思考」を活性化させる(複雑なコマンドや多すぎるコンテキストはR1モデルを混乱させる可能性があるため、ある程度の経験がない状態で複雑なコマンドを構築することは推奨されない)。

その通りだ:中国語への翻訳を手伝ってくれ、中国ユーザーの習慣に合った単語を使って翻訳してくれ、重要な用語は原語のままにしてくれ、翻訳はレイアウトに注意を払うべきだ。

エラー:翻訳してくれ。

注:2と3から生じるコンフリクトを弁証法的に見るには、簡単なコマンドを試すことから始め、答えが特定の要件を満たさない場合は、コマンドの条件を適切に増やす。

以下の文章で自分自身をテストしてみよう。

**# How does better chunking lead to high-quality responses? **If you’re reading this, I can assume you know what chunking and RAG are. Nonetheless, here is what it is, in short.** **LLMs are trained on massive public datasets. Yet, they aren’t updated afterward. Therefore, LLMs don’t know anything after the pretraining cutoff date. Also, your use of LLM can be about your organization’s private data, which the LLM had no way of knowing.** **Therefore, a beautiful solution called RAG has emerged. RAG asks the LLM to ** answer questions based on the context provided in the prompt itself** . We even ask it not to answer even if the LLM knows the answer, but the provided context is insufficient.** **How do we get the context? You can query your database and the Internet, skim several pages of a PDF report, or do anything else.** **But there are two problems in RAGs.** * **LLM’s **context windows sizes** are limited (Not anymore — I’ll get to this soon!)** * **A large context window has a high ** signal-to-noise ratio** .** **First, early LLMs had limited window sizes. GPT 2, for instance, had only a 1024 token context window. GPT 3 came up with a 2048 token window. These are merely the **size of a typical blog post** .** **Due to these limitations, the LLM prompt cannot include an organization’s entire knowledge base. Engineers were forced to reduce the size of their input to the LLM to get a good response.** **However, various models with a context window of 128k tokens showed up. This is usually **the size of an annual report** for many listed companies. It is good enough to upload a document to a chatbot and ask questions.** **But, it didn’t always perform as expected. That’s because of the noise in the context. A large document easily contains many unrelated information and the necessary pieces. This unrelated information drives the LLM to lose its objective or hallucinate.** **This is why we chunk the documents. Instead of sending a large document to the LLM, we break it into smaller pieces and only send the most relevant pieces.** **However, this is easier said than done.** **There are a million possible ways to break a document into chunks. For instance, you may break the document paragraph by paragraph, and I may do it sentence by sentence. Both are valid methods, but one may work better than the other in specific circumstances.** **However, we won’t discuss sentence and paragraph breaks, as they are trivial and have little use in chunking. Instead, we will discuss slightly more complex ones that break documents for RAGs.** **In the rest of the post, I’ll discuss a few chunking strategies I’ve learned and applied.********

4.キュー・ワード・フレームは後方に残る

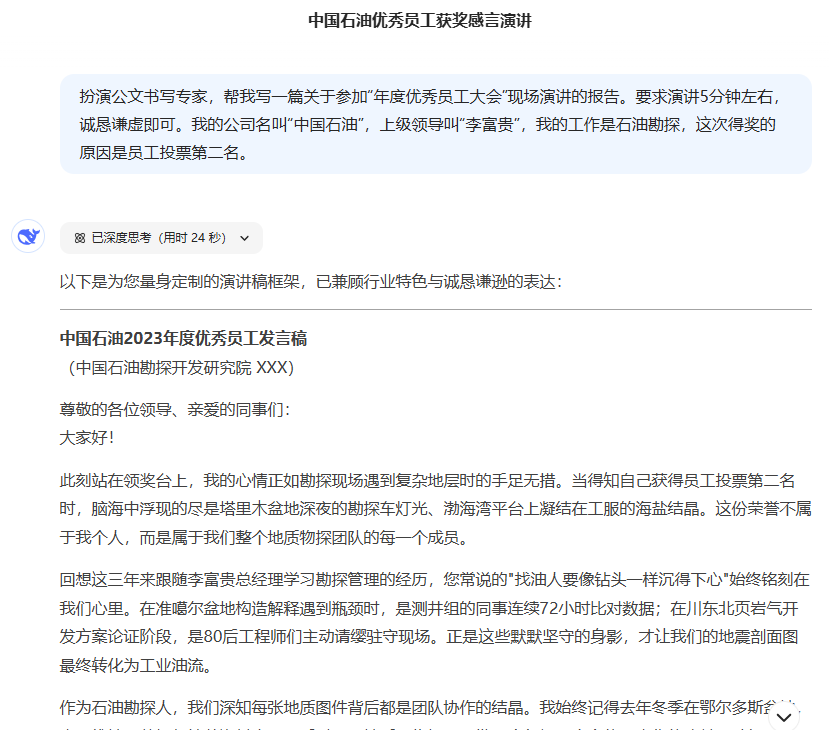

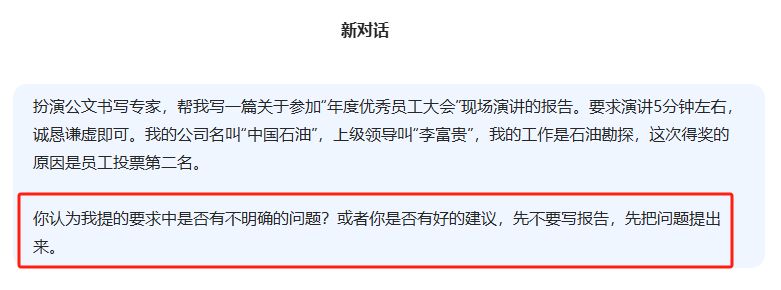

良いキューワードを入力する習慣を身につけるには、次の4つの条件を満たすだけでよい:[キャラクター] [大きなモデルが実行するアクション] [ミッションの目的] [ミッションのコンテキスト] (ミッションのコンテキストは必須ではない)

例公式文書で専門家の役割を果たす。年間最優秀社員会議」でのスピーチのレポートを書くのを手伝ってください。スピーチは5分程度で、誠実で控えめなものでなければなりません。私の会社の名前はペトロチャイナで、上司の名前は李富貴、石油探査の仕事をしています。

5.大きなモデルに質問をさせることを学ぶ。

4 "のプロンプトの例を振り返って、何か問題はありますか?

直接使えないレポートを書けるほど記述は詳細ではないし、多くの人が大きなモデルに対して抱く難点は、質問ができない、あるいはわざわざ脳に質問を加えたくないということだ。

完璧な質問を組み立てる前に、質問を洗練させるための大きなモデルを学ぶのだ。

6.指示されるように質問をする、あるいはR1の思考プロセスを指示させることは、R1だけに適用されるのではなく、非常に古くからある方法である。

以下のメソッドは、通常、R1のような推論モデルで使用する必要はないが、問題特有のものであり、もしあなたの問題が非常に方向性のあるものであれば、その一部を含めることができる。論理的にシンプルで短い文脈を記述する.

| プロンプトID | タイプ | トリガー・センテンス | 中国語 |

|---|---|---|---|

| 101 | CoT | ステップ・バイ・ステップで考えよう。 | 私たちは一歩一歩考える。 |

| 201 | 追記 | まず、問題を理解し、問題を解決するための計画を立てよう。 そして、問題を解決するための計画を一歩一歩実行に移そう。 | まず、問題を理解し、それを解決するための計画を立てよう。そして、その計画に沿って一歩一歩問題を解決していこう。 |

| 301 | PS+ | まず、問題を理解し、関連する変数とそれに対応する数字を抽出し、計画を立てましょう。 次に、計画を実行し、中間変数を計算し(正しい数字の計算と常識に注意し、一歩一歩問題を解き、答えを示しましょう。次に、計画を実行し、中間変数を計算し(正しい数字の計算と常識に注意し)、問題を一歩一歩解いて、答えを示しましょう。 | まず、問題を理解し、関連する変数とそれに対応する値を抽出し、計画を作成しましょう。次に、計画を実行し、中間変数を計算し(適切な数値計算と常識に注意する)、問題を段階的に解決し、答えを表示する。 |

| 302 | PS+ | まず、問題を理解し、関連する変数とそれに対応する数値を抽出し、完全な計画を立てよう。 次に、計画を実行し、中間変数を計算し(正しい数値計算と常識に注意)、段階的に問題を解き、その結果を示そう。次に、計画を実行し、中間変数を計算し(正しい数値計算と常識に注意)、問題を段階的に解いて、答えを示そう。答えなさい。 | まず、問題を理解し、関連する変数とそれに対応する値を抽出し、完全な計画を作成しましょう。そして、計画を実行し、中間変数を計算し(正しい数値計算と常識に注意する)、問題を段階的に解いて、答えを表示する。 |

| 303 | PS+ | 計画を練り、一歩一歩問題を解決していこう。 | 計画を立て、一歩ずつ問題を解決していこう。 |

| 304 | PS+ | まず、問題を理解し、完全な計画を立てよう。 そして、計画を実行し、問題を一歩一歩推理していこう。各ステップごとに、「人は裏返すのか、コインの現在の状態はどうなっているのか」というサブクエスチョンに答えましょう。 コインの最後の状態によって、最終的な答えを出しましょう(すべてのフリップとコインの回転状態に注意してください)。 | まず、問題を理解し、完全な計画を立てよう。そして、その計画を実行し、問題を一歩一歩解決していく。各ステップでは、"その人は裏返すのか、コインの現在の状態はどうなっているのか "というサブクエスチョンに答える。. コインの最終的な状態に基づいて最終的な答えを出しなさい(各フリップとコインの裏返された状態に注意しなさい)。 |

| 305 | PS+ | まず、問題を理解し、関連する変数とそれに対応する数値を抽出し、完全な計画を立てましょう。 次に、計画を実行し、中間変数を計算し(正しい数値計算と常識に注意してください)、ステップバイステップで問題を解き、その結果を示しましょう。次に、計画を実行し、中間変数を計算し(正しい数値計算と常識に注意)、問題を段階的に解いて、答えを示しましょう。答えなさい。 | まず、問題を理解し、関連する変数とそれに対応する値を抽出し、完全な計画を作成しましょう。そして、計画を実行し、中間変数を計算し(正しい数値計算と常識に注意する)、問題を段階的に解いて、答えを表示する。 |

| 306 | PS+ | まず、関連する情報を準備し、計画を立てましょう。 次に、質問に段階的に答えましょう(常識と論理的一貫性に注意しましょう)。それから、質問に一歩ずつ答えていきましょう(常識と論理的一貫性に注意を払いましょう)。 | まず、関連情報を準備し、計画を立てよう。そして、(常識と論理的整合性に注意しながら)ステップ・バイ・ステップで質問に答えていこう。 |

| 307 | PS+ | まず、問題を理解し、関連する変数とそれに対応する数値を抽出し、完全な計画を立て、考案しよう。 次に、計画を実行し、中間変数を計算し(正しい数値計算と常識に注意)、問題を一歩一歩解いていこう。そして、計画を実行し、中間変数を計算し(正しい数値計算と常識に注意)、問題を段階的に解いていきましょう。答えを示しましょう。 | まず、問題を理解し、関連する変数とそれに対応する値を抽出し、完全な計画を作成しましょう。そして、計画を実行し、中間変数を計算し(正しい数値計算と常識に注意する)、問題を段階的に解いて、答えを表示する。 |

7.質問の曖昧さ除去

推論の大きなモデルは、先に述べた間違った例のように、間違った質問が間違った仮定を導き、間違った答えを導くような「仮定」問題を喜んで助けてくれるので、経験に基づいた質問で起こりうる曖昧さを積極的に排除することが重要である。

8.入力の長さと推論の深さのどちらかを選ぶ。

長すぎるインプットは推論を阻害し、推論の問題を拡散させ、短すぎるインプットは推論を強化し、集中力を維持する。

9.出力コンテンツフォーマットの制御

キューワードフレームワーク「4」を参照。最後のセクションに[Output Format]を追加することで、ラージモデルの出力内容のフォーマットを制約することができる。

制御出力コンテンツのフォーマットには2種類ある:

1.植字

例1:マークダウン・フォーマットとコンテンツのレイアウトを使った出力

例2:出力された記事をワードに貼り付けて使用する。

2.テンプレート

例1:導入、説明、要約の3つのセクションに分けられる記事を作成する。

例2:プロンプト:グループチャット、ミーティングノート、複数ラウンドの会話の要約

DeepSeek-R1の拡張リーディング

DeepSeek-R1 WebGPU: DeepSeek R1 1.5Bをブラウザでローカルに実行します!

Tifa-DeepsexV2-7b-MGRPO: ロールプレイと複雑なダイアログをサポートし、32bを超えるパフォーマンスを持つモデル (ワンクリックインストールパッケージ付き)

DeepSeek-R1ベースのローカル/API知識ベースを実装し、WeChat BOTにアクセスする。

DeepSeek公式推奨:DeepSeek R1統合による実践的AIツールガイド

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません