1月:オープンソースのオフラインAIアシスタント、ChatGPTの代替、ローカルAIモデルの実行またはクラウドAIへの接続

はじめに

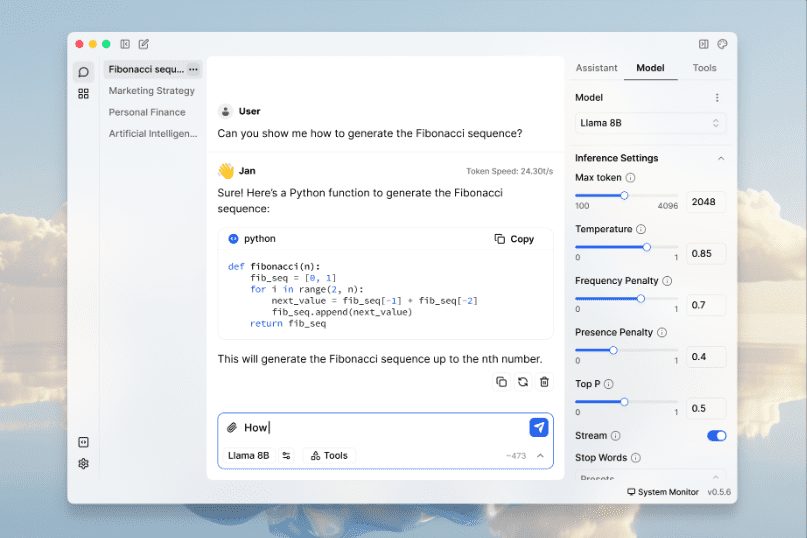

ヤンはオープンソース チャットGPT Janは、ユーザーのデバイス100%にダウンロードしてオフラインで実行できるモデルの豊富なライブラリを提供します。Cortexエンジンによって駆動され、NVIDIA GPUやAppleのMシリーズチップを含む幅広いハードウェアプラットフォームをサポートしています。 Janは、ユーザーがダウンロードして実行できるLlama、Gemma、およびCortexエンジンを含む豊富なモデルライブラリを提供しています。 ミストラル Janは、PCからマルチGPUクラスタまで、あらゆるハードウェア上で動作する組み込み可能なネイティブAIエンジンであるCortexを搭載している。

機能一覧

- AIモデルをローカルで実行するラマ、ジェンマ、ミストラル、その他多くの人気モデルをサポート。

- マルチエンジン・サポートllama.cpp、TensorRT-LLM、その他多くのエンジンと互換性があります。

- オフライン操作インターネット接続は不要で、すべてのデータ処理はローカルで行われます。

- モデルライブラリ豊富なモデルのダウンロードと管理機能を提供します。

- リモートAI接続OpenAI、Groq、CohereなどのリモートAIサービスに接続。

- ローカルAPIサーバーOpenAI互換のローカルAPIサーバーをセットアップし、実行します。

- 高さはカスタマイズ可能拡張プラグインによる機能のカスタマイズに対応。

- プライバシーすべてのデータはローカルに保存され、ユーザーはデータを完全にコントロールできる。

ヘルプの使用

設置プロセス

- ダウンロードアクセス ヤン・オフィシャルウェブサイト もしかしたら GitHubページ Windows、MacOS、Linux用のインストールパッケージをダウンロードしてください。

- 取り付け::

- ウィンドウズダウンロードした

jan.exeファイルを開き、プロンプトに従ってインストールを完了します。 - マックオスダウンロード

jan.dmgファイルをダブルクリックして開き、JanをApplicationsフォルダにドラッグします。 - リナックスダウンロード

.debもしかしたら.AppImageファイルでインストールするか、コマンドラインを使ってインストールするか、直接実行する。

- ウィンドウズダウンロードした

使用ガイドライン

- アプリケーションを起動するインストールが完了したら、Janアプリケーションを開きます。

- モデルを選択Llama, Gemma, Mistralなど、モデルライブラリから希望のAIモデルを選択し、ダウンロードします。

- ローカルオペレーションダウンロードしたモデルを選択し、"Run "ボタンをクリックすると、ローカルデバイス上でモデルが起動します。

- リモートAIとの接続さらに計算能力が必要な場合は、OpenAIやGroqなどのリモートAIサービスを設定し、接続することができます。

- APIサーバーの使用設定でローカルAPIサーバーを有効にし、プロンプトに従ってAPIキーを設定すれば、OpenAI互換のAPIで開発やテストができます。

- カスタムエクステンションエクステンションセンターで必要なエクステンションプラグインをダウンロードしてインストールし、特定のニーズに合わせてヤンの機能をカスタマイズしてください。

詳しい操作手順

- モデルのダウンロードと管理::

- Janアプリケーションを開き、モデルライブラリに移動します。

- 利用可能なモデルを参照し、「ダウンロード」ボタンをクリックしてダウンロードします。

- ダウンロードが完了すると、そのモデルは「ダウンロード済み」リストに表示されます。

- モデルを選択し、"Run "ボタンをクリックしてモデルを開始する。

- ローカルAPIサーバーの設定::

- 設定 "ページに行き、"APIサーバー "オプションを見つける。

- APIサーバーを有効にし、APIキーを設定します。

- 提供されているAPIドキュメントを使用して、ネイティブAPIを呼び出して開発を開始する。

- 拡張プラグインのインストール::

- エクステンションセンターで利用可能なエクステンションをご覧ください。

- インストール」ボタンをクリックし、画面の指示に従ってインストールを完了します。

- インストール後、拡張機能は「インストール済み」リストに表示されます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません