Xinference: 簡単な分散AIモデルのデプロイとサービング

はじめに

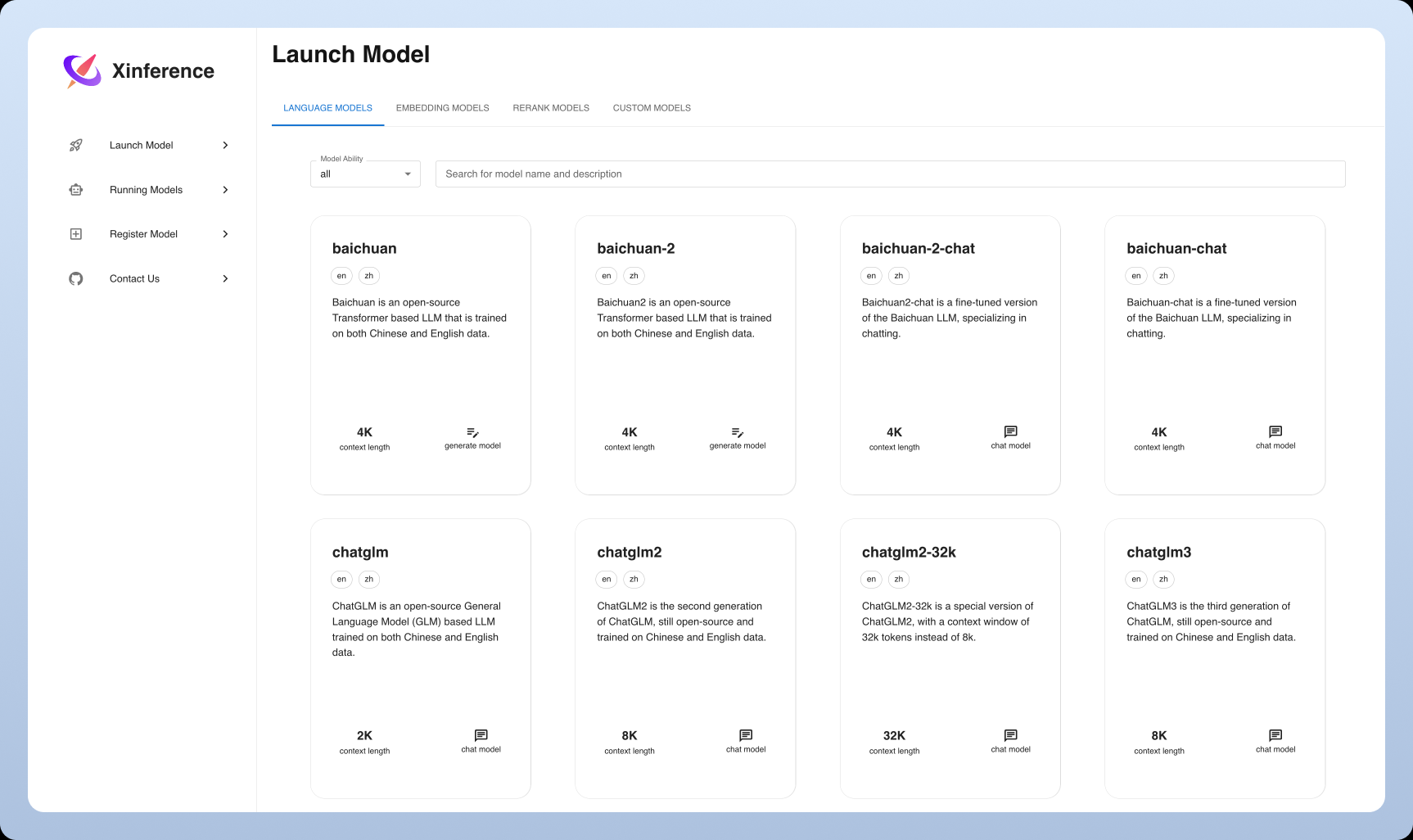

Xorbits Inference(略してXinference)は、言語モデル、音声認識モデル、マルチモーダルモデルの分散デプロイと配信に特化した、強力で汎用性の高いライブラリです。Xorbits Inferenceを使用すると、ユーザーは独自のモデルやビルトインの高度なモデルをコマンド1つで簡単にデプロイし、提供することができます。クラウド、ローカルサーバー、パーソナルコンピュータのいずれでも、Xorbits Inferenceは効率的に動作します。このライブラリは特に研究者、開発者、データ科学者に適しており、最先端のAIモデルの可能性を最大限に引き出すことができます。

機能一覧

- 分散配置分散配置シナリオをサポートし、モデル推論タスクを複数のデバイスやマシンにシームレスに分散できます。

- モデリングサービス大規模な言語モデル、音声認識モデル、マルチモーダルモデルの提供プロセスを簡素化。

- シングルコマンド展開実験環境でも本番環境でも、1つのコマンドでモデルをデプロイし、サービスを提供します。

- 異種ハードウェアの利用インテリジェンスは、GPUやCPUなどのヘテロジニアスハードウェアを活用して、モデル推論タスクを高速化します。

- 柔軟なAPIとインターフェースRPC、RESTful API(OpenAI APIと互換性あり)、CLI、WebUIをサポートしています。

- 高度なモデルを内蔵最先端のオープンソースモデルを幅広くサポートし、ユーザーが直接実験に使用できます。

ヘルプの使用

設置プロセス

- 環境準備Python 3.7以降がインストールされていることを確認してください。

- Xorbits推論のインストール::

pip install xorbits-inference

- インストールの確認インストールが完了したら、以下のコマンドでインストールが成功したことを確認できます:

xinference --version

使用ガイドライン

配備モデル

- 積載モデル訓練済みモデルをロードするには、以下のコマンドを使用します:

xinference load-model --model-name <模型名称>

例

xinference load-model --model-name gpt-3

- サービス開始モデルをロードしたら、サービスを開始します:

xinference serve --model-name <模型名称>

例

xinference serve --model-name gpt-3

- APIの呼び出しサービスが開始されると、RESTful APIを介してサービスを呼び出すことができる:

curl -X POST http://localhost:8000/predict -d '{"input": "你好"}'

内蔵モデルの使用

Xorbits Inferenceは、ユーザーが直接実験に使用できる高度なモデルを幅広くサポートしています。例

- 言語モデルGPT-3、BERTなど。

- 音声認識モデル例:DeepSpeechなど。

- マルチモーダルモデルCLIPなど。

分散配置

Xorbits Inferenceは分散デプロイメントをサポートしており、ユーザーはモデル推論タスクを複数のデバイスやマシンにシームレスに分散させることができます。以下にその手順を説明する:

- 分散環境の設定各ノードにXorbits Inferenceをインストールし、ネットワーク接続を設定します。

- 分散サービスの開始マスターノードで分散サービスを開始する:

xinference serve --distributed --nodes <节点列表>

例

xinference serve --distributed --nodes "node1,node2,node3"

- 分散APIの呼び出しシングルノードのデプロイメントと同様に、RESTful API経由で呼び出される:

curl -X POST http://<主节点IP>:8000/predict -d '{"input": "你好"}'

一般的な問題

- モデルを更新するには? モデルを更新するには以下のコマンドを使用する:

xinference update-model --model-name <模型名称>

- ログはどうやって見るのですか? サービスログを表示するには、以下のコマンドを使用する:

xinference logs --model-name <模型名称>© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません