ハギング・フェイス、エンドデバイス上で動作する小型マルチモーダルモデルSmolVLMを発表

SmolVLMは、画像とテキストの任意の組み合わせから入力を受け付け、テキスト出力を生成する、パラメータ数20億の小さなマルチモーダルモデルである。

7月に軽量言語モデル「SmolLM」を発表したAIアプリ開発プラットフォームのハギング・フェイスは今週、軽量かつ高性能を重視した軽量マルチモーダルモデル「SmolVLM」をリリースし、小型言語モデルのラインアップに加わった。

SmolVLMは、20億の参照を持つ小さなマルチモーダルモデルで、このクラス(State-of-the-Art、SOTA)のパフォーマンスリーダーとして知られています。SmolVLMは、画像に関する質問に答えたり、画像の内容を説明したり、複数の画像に基づいてストーリーを語ったり、純粋に言語モデルとして使用したりすることができる。開発チームによると、SmolVLMは軽量アーキテクチャに基づいており、マルチモーダルなタスクをうまく実行しながらも、デバイス上で実行するのに適している。

SmolVLMのアーキテクチャは、Hugging Faceが以前に紹介したビジョンモデル、IDEFICS 3に基づいている。 変圧器 実装は同じだ。しかし、ハギング・フェイスも同様の実装で アイディフィクス いくつかの改良が加えられた。第二に、SmolVLMは、ピクセル・シャッフル戦略や視覚的により大きなパッチなど、より高度な画像圧縮技術を使用しています。 トークン その結果、コーディング効率が向上し、推論が高速化し、メモリ使用量が削減された。

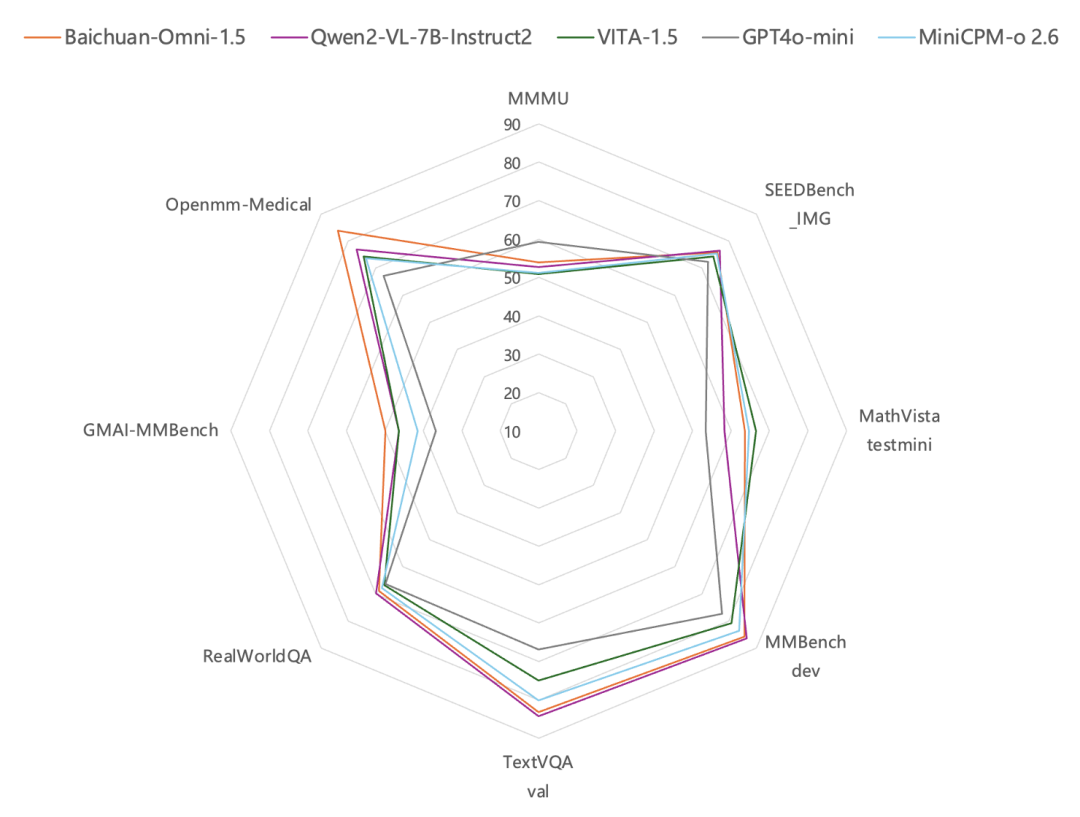

Hugging Face は、SmolVLM の効率とメモリ使用量の優位性を強調し、同等のパラメトリック・モデルとの比較テスト・データを公開しています。SmolVLM は、マルチモーダル理解、推論、数学、テキスト理解において、InternVL2、PaliGemma、MM1.5、moondream、MiniCPM-V-2 などのモデルを上回っています。また、GPUメモリの使用効率においても、ほとんどのモデルを上回っている。アリババのQwen2-V2と比較すると、SmolVLMは、プリ・ポピュレーション・スループットが3.3~4.5倍、ジェネレーション・スループットが7.5~16倍高速です。

Hugging Faceは、SmolVLMファミリーの3つのモデル・バージョンをリリースしました。これには、微調整用のSmolVLM-Base、合成データセットに基づく微調整用のSmolVLM-Synthetic、そしてエンドユーザーとの直接対話が可能なコマンド微調整バージョンのSmolVLM Instructが含まれます。SmolVLMのすべてのモデル・チェックポイント、トレーニング・データセット、トレーニング方法、ツールは、Apache 2.0 Frameworkに基づいています。オープンソースライセンス.

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません