HiveChat:企業内で迅速に展開できるAIチャットボット

はじめに

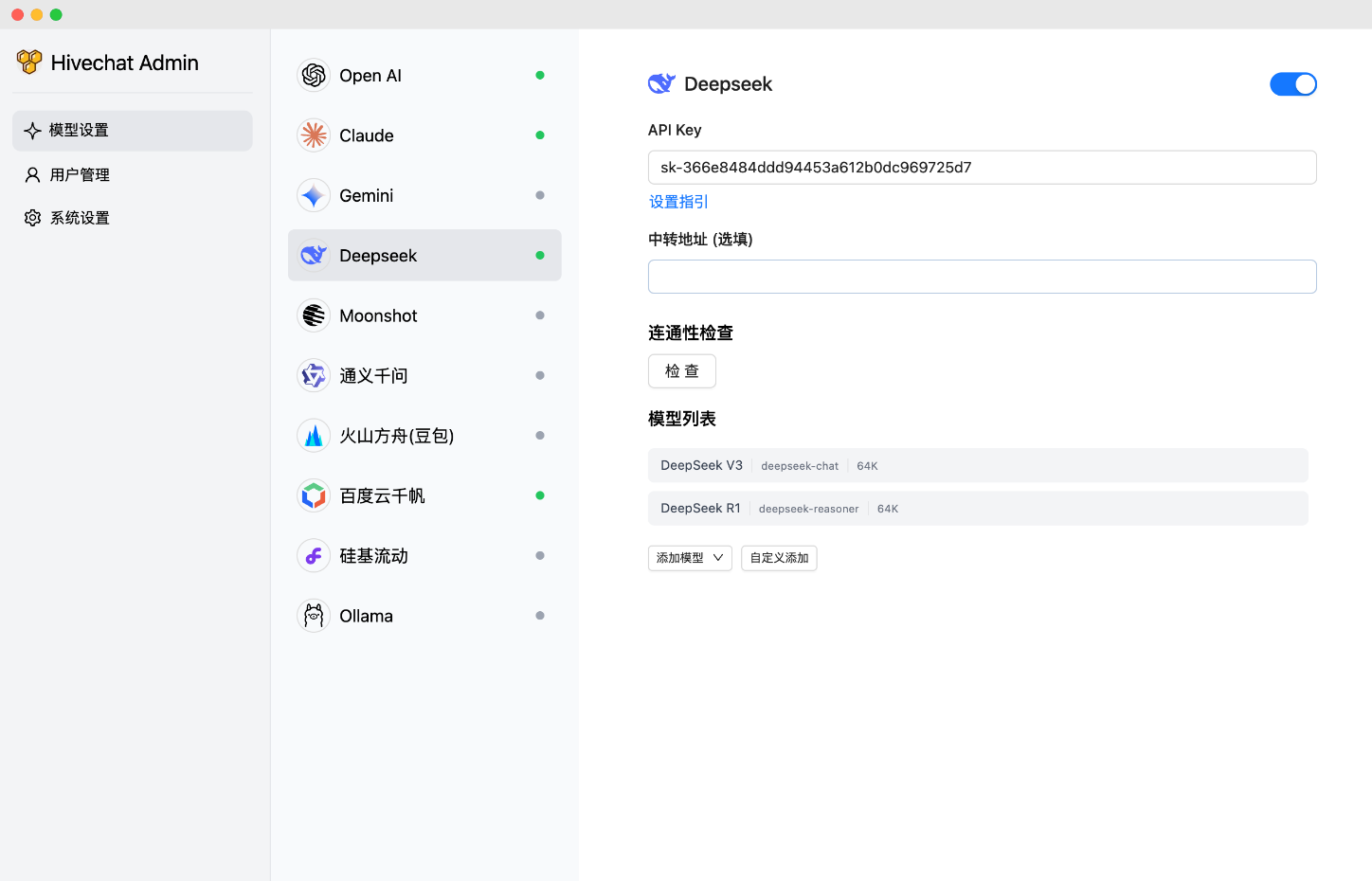

HiveChatは中小規模のチーム向けのAIチャットボットで、管理者は複数のAIモデル(Deepseek、OpenAI、Claude、Geminiなど)を一度に設定し、チームメンバーが簡単に使用できるようにすることができます。LaTeXおよびMarkdownレンダリング、DeepSeek推論チェーン表示、画像理解、AIエージェントおよびクラウドデータストレージを備え、10の大規模モデルプロバイダーをサポートしています。このプロジェクトは、Next.js、Tailwindcss、PostgreSQLの技術スタックを使用しており、ローカルまたはVercelとDocker経由でデプロイできます。

機能一覧

- サポートするAIモデル:HiveChatは、Deepseek、OpenAI、Claude、Gemini、Moonshot、Volcano Engine Ark、Ali Bailian(Qianwen)、Baidu Qianfan、Ollama、および以下を含むAIモデルをサポートしています。 シリコンフロー グローバル化されたチームのための国内および国際的な主流オプションを含む、10社の大規模モデルプロバイダー。

- レンダリングと表示: LaTeXとMarkdownのレンダリングをサポートしており、技術文書を扱うチームに便利です。DeepSeekの推論チェーン表示機能は、ユーザーがAIの推論プロセスを理解するのに役立ちます。

- マルチメディア・サポート:画像理解能力、視覚関連のタスクを処理するのに適している。

- AIエージェント:AIエージェント機能を統合し、自動化機能を強化。

- データ管理:クラウドデータストレージを提供し、チームデータの安全性と永続性を確保。

ヘルプの使用

テクノロジー・スタックと展開オプション

HiveChatは最新のフロントエンドとバックエンドの技術スタックを使用しています:

| 技術 | 説明 |

|---|---|

| Next.js | のサーバーサイド・レンダリングを構築するために使用される。 反応 アプライアンス |

| テールウィンドcss | 高速なCSSフレームワークを提供 |

| Auth.js | ユーザー認証の処理 |

| PostgreSQL | データ保存をサポートするリレーショナル・データベース |

| ドリズルORM | データベース操作 ORMツール |

| アント・デザイン | ユーザー・エクスペリエンスを向上させるUIコンポーネント・ライブラリ |

デプロイメントオプションには、ローカルデプロイメント、Dockerデプロイメント、Vercelデプロイメントがある:

- ローカル展開ユーザーはリポジトリをクローンし、以下のコマンドを実行する必要がある。

npm install依存関係をインストールする。npm run initdbデータベースを初期化する。npm run dev開発環境の起動npm run build歌で応えるnpm run start本番環境での使用 - Dockerのデプロイメントリポジトリをクローンし

docker compose build歌で応えるdocker compose up -dコンテナ化されたサービスを開始することができる。 - ヴェルセル配備スルー ヴェルセル配備リンク ワンクリックでデプロイするには、DATABASE_URL、AUTH_SECRET、ADMIN_CODEなどの環境変数を設定する必要があります。

デプロイが完了したら、管理者はhttp://localhost:3000/setup(または実際のドメイン/ポート)にアクセスして管理者アカウントを設定する必要があります。

詳細ヘルプ

HiveChatをすぐに使い始めることができるよう、インストールと使用方法について詳しく説明します:

設置プロセス

- クローン倉庫::

- ターミナルを開き、以下のコマンドを実行して GitHub リポジトリをクローンします:

git clone https://github.com/HiveNexus/HiveChat.git cd HiveChat

- ターミナルを開き、以下のコマンドを実行して GitHub リポジトリをクローンします:

- 配備方法を選択::

- ローカル展開::

- Node.jsとPostgreSQLがインストールされていることを確認する。

- うごきだす

npm install依存関係をインストールします。 - コンフィグ

.envファイルで、以下の環境変数を設定する:DATABASE_URL=postgres://postgres:password@localhost/hivechat(実際のデータベース接続に置き換える必要があります。例としてローカルのPostgreSQLがあります)。AUTH_SECRET使用openssl rand -base64 3232ビットのランダム文字列を生成する。ADMIN_CODE管理者認証コードを設定します。22113344その場合は、カスタム値で置き換えることをお勧めします。NEXTAUTH_URL=http://127.0.0.1:3000(テスト環境はデフォルトのままで構いませんが、本番環境は正式なドメイン名に変更する必要があります)。

- うごきだす

npm run initdbデータベースを初期化する。 - 開発環境の稼働

npm run dev生産環境の運用npm run build女帝npm run start.

- Dockerのデプロイメント::

- DockerとDocker Composeがインストールされていることを確認する。

- うごきだす

docker compose build鏡像を作る。 - うごきだす

docker compose up -dコンテナをスタートさせる。 - 環境変数の設定は、ローカルでのデプロイメントと同じで、次のように行う必要がある。

docker-compose.ymlで指定する。

- ヴェルセル配備::

- インタビュー ヴェルセル配備リンク.

- プロンプトに従って、DATABASE_URL、AUTH_SECRET、およびADMIN_CODEを設定する。

- Deployをクリックし、Vercelがビルドを終えるのを待つ。

- ローカル展開::

- 管理者の初期化::

- 配置が完了したら、http://localhost:3000/setup(ローカル配置)または実際のドメイ ン名にアクセスし、ADMIN_CODE を入力して管理者アカウントを設定します。

使用方法

- 管理者の操作::

- ログインして管理者ダッシュボードに移動し、AIモデルプロバイダ(OpenAI API Keyなど)を設定します。

- 手動でユーザーを追加したり、登録を有効にしたりして、すべてのユーザーアカウントを管理します。

- チームの使用統計を表示し、パフォーマンスを最適化するためにモデル構成を調整します。

- 一般ユーザーの操作::

- ログインすると、テキスト入力とマルチメディア(画像など)のアップロードに対応したチャットインターフェイスにアクセスできます。

- LaTeXとMarkdownを使って、技術的なディスカッションのためのチャットをフォーマットする。

- 異なるAIモデルを選択する(例 ディープシーク またはクロード)と対話し、DeepSeekの推論チェーンを表示することで、AIの意思決定プロセスを理解することができます。

- データは自動的にクラウドに保存されるため、セッション履歴はいつでも確認できる。

- 注目の機能操作::

- 図形理解画像をアップロードすると、AIが内容を分析して説明文を生成します。

- AIエージェントAIは設定により、レポートの作成やよくある質問への回答など、特定のタスクを自動化することができます。

- クラウドデータストレージすべてのチャットと設定はクラウドに保存され、デバイスを越えてチームメンバーがアクセスできます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません