中国初の専門的ドメイン知識強化サービス・フレームワークであるKAGの技術レポート。

最近、アントグループの知識エンジンの責任者である梁磊は、外灘会議で、知識グラフと大規模言語モデルの融合研究における過去6ヶ月間のチームの作業進捗状況を共有し、中国初の専門領域向け知識強化サービスフレームワークであるKAGをリリースした。本稿はその内容をテキスト化したものである。

関連技術レポート arXivアドレスhttps://arxiv.org/pdf/2409.13731

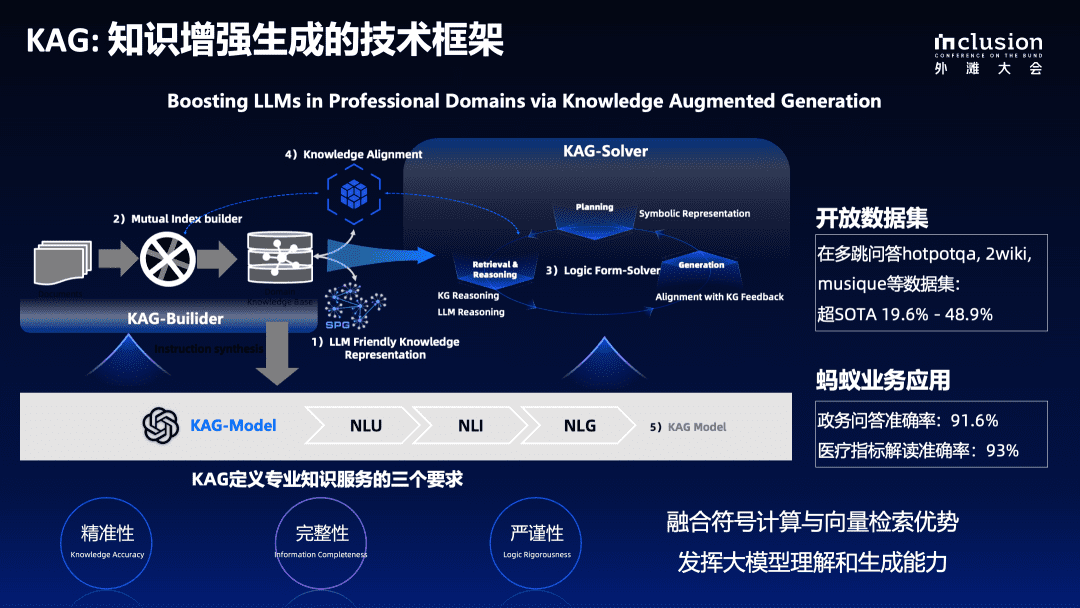

今回発表されたのは KAG 技術報告書全体の記号計算と知識グラフのベクトル検索は多くの点で相補的であるため、両者の利点を真に融合させたいと考えている。同時に、大規模言語モデルの理解・生成能力を活用することで、知識拡張型大規模言語モデル生成システムを構築する。KAGの技術的枠組みは今後も反復され、技術報告書は更新される予定である。

我々はこれから オープンSPG KAGフレームワークはオープンソースプロジェクトのGitHubアドレスで公開されている:

https://github.com/OpenSPG/KAG

大規模モデリングの垂直適用における主要課題

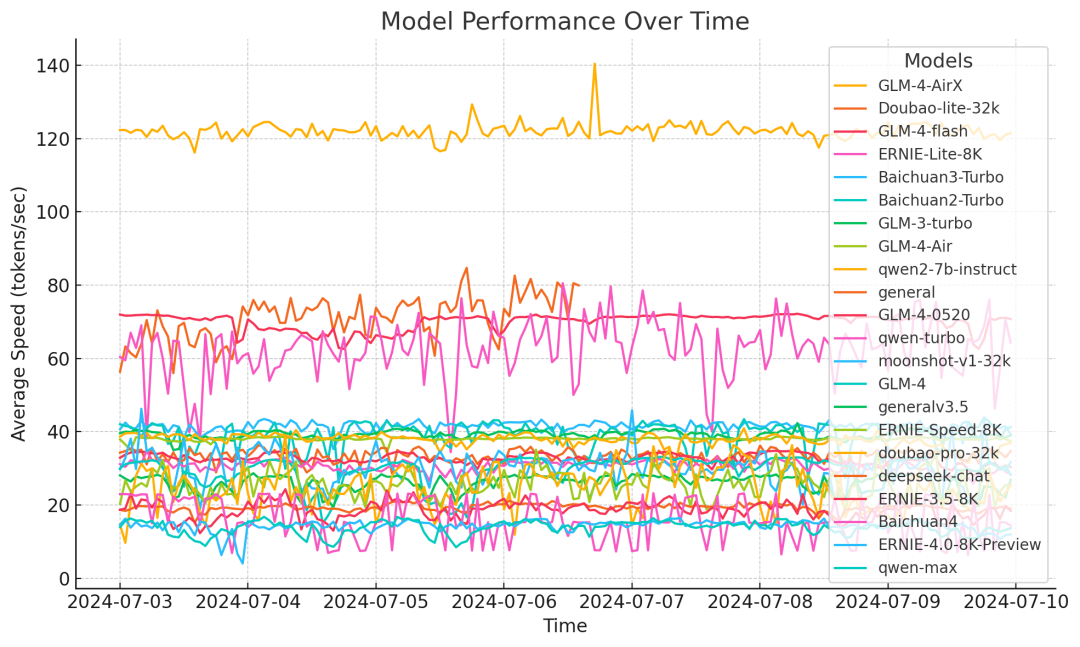

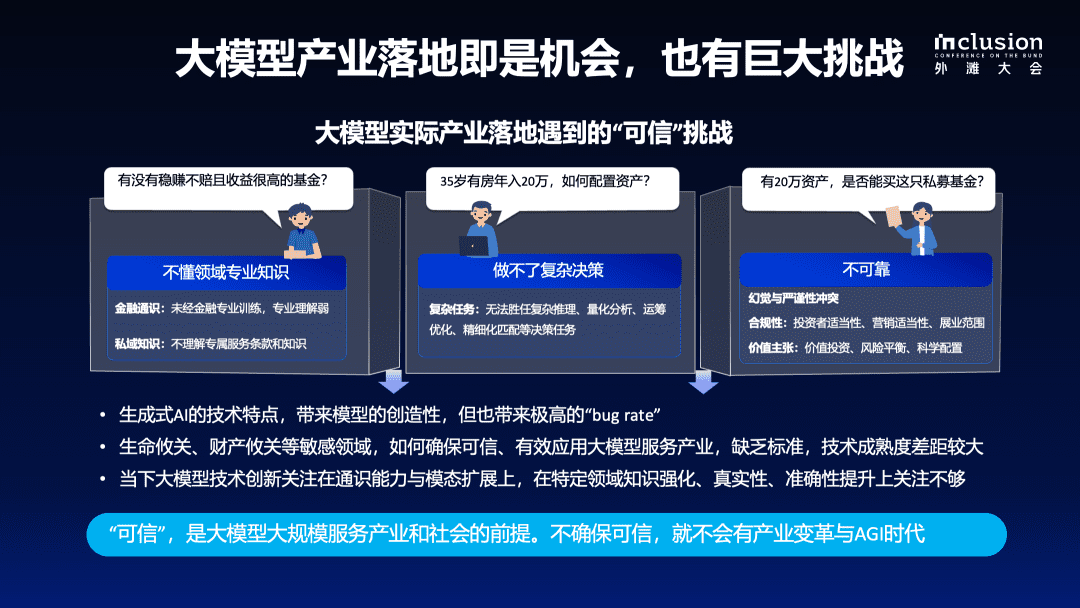

年近くの研究と実践の後、業界はビッグ・ランゲージ・モデルの長所と限界、そして業界特有のアプリケーションにおける課題を一般的に認識するようになった。ビッグ・ランゲージ・モデルは強力な理解力と生成能力を実証していますが、ドメイン知識の欠如、複雑な意思決定の難しさ、専門的なドメインにおける信頼性の欠如といった問題が残っています。私たちは、ビッグ・ランゲージ・モデルを実世界のシナリオに実装するためには、「信頼性」が重要な前提条件であると考えています。

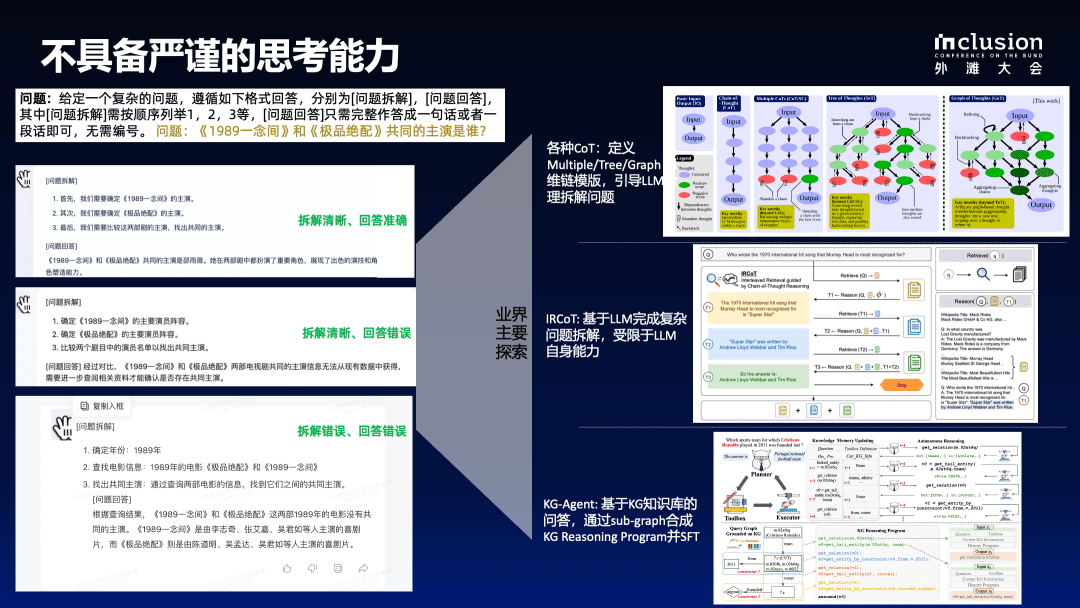

1.1 LLMには批判的に考える能力がない

第一に、大規模な言語モデルは厳密な推論能力を提供しない。例えば、"1989 A ThoughtとThe Best Matchの共通スターは誰か?"という質問を使用した。この質問で、中国の複数の大規模言語モデルを個別にテストしたところ、回答の精度と一貫性が低いという結果が出た。回答できるモデルがあっても、論理エラーがあったり、問題の分解が不適切だったりする。条件を「男性主演俳優」「女性主演俳優」に変えたり、時間制約を加えるなど、条件が複雑になればなるほど、精度と安定性は低下し続ける。

このような問題を解決するために、業界では様々な試みが行われてきた。例えば、思考連鎖(COT)モデルを構築し、複数/木/グラフの思考連鎖テンプレートを定義することで、LLMは問題を合理的に分解するよう導かれている。今年、より多くの研究が、LLMの思考連鎖モデルを、LLMの思考連鎖モデルに近づけることに集中している。 ラグ のテクニックをビッグ・ランゲージ・モデルに導入し、事実情報の不足を補っている。さらなる発展として、検索メカニズムを最適化するためにグラフ構造を採用したGraphRAGがある。

外部知識ベースの導入は今日広く行われているが、RAGのような技術を導入してドメイン固有の知識ベースやファクトファイルを大規模言語モデルで再生成できるようにしても、生成される回答の精度はまだ完全には保証されていない。

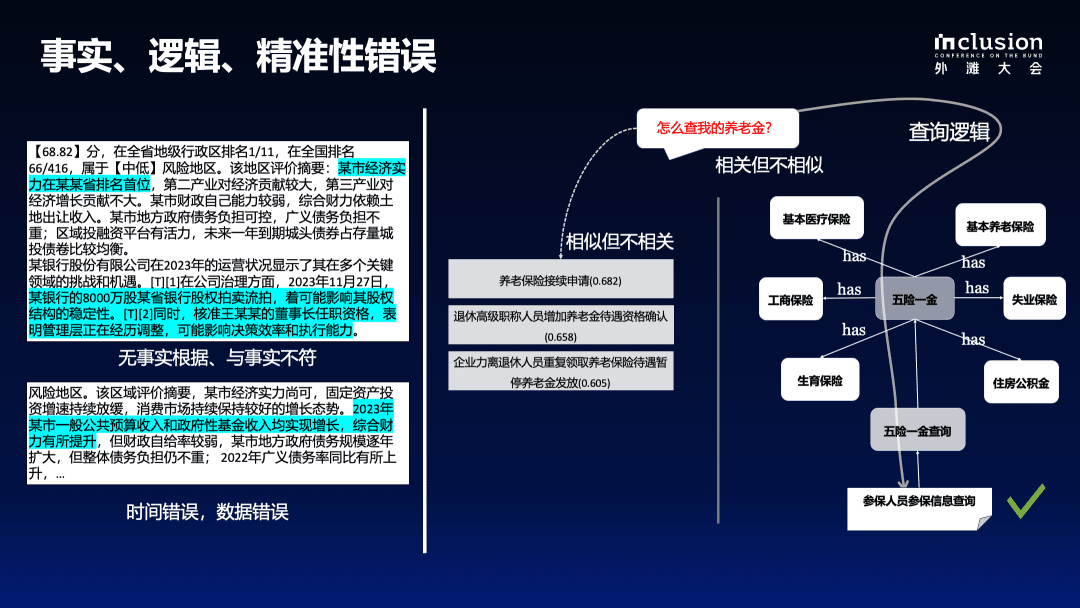

1.2 事実、論理、精度の誤り

下図の左側は、政府報告書の指標をビッグモデルで解釈した例である。 事前にビジネスパーソンがマークしていても、ビッグモデルでは独自の理解が加わってしまい、歪んだ情報や裏付けのない誤りが生じてしまう。例えば、ある都市がある県で1位という記載があるが、これはビジネスの観点からは正しくない。同様に、ある銀行の8000万ドルの株式が競売にかけられたという情報は、原文には存在しない。さらに悪いことに、このモデルは数値的・論理的エラーも発生させる。元の文書で提供されたビジネス指標は2022年のものだが、生成されたコンテンツは2023年とラベル付けされている。

想起プロセスにおける不正確さは、外部の知識ベースが提供された場合でも問題として残る。右の例はベクトル計算に基づくRAGアプローチの欠点を示している。例えば、年金の探し方をクエリする場合、想起された文書を計算するためにベクトルを直接使用することは、ビジネスエキスパートによって定義された知識と相関しない。

垂直領域では、表面的には似ていないように見えても、実は多くの知識が密接に関連している。例えば、「年金」は「5つの保険と1つの年金」というカテゴリーに属し、国の政策と密接に関係しており、大規模なモデルではこのような情報を任意に生成することはできない。したがって、モデルの振る舞いを制約し、効果的な知識入力を提供するためには、あらかじめ定義されたドメイン知識構造が必要となる。

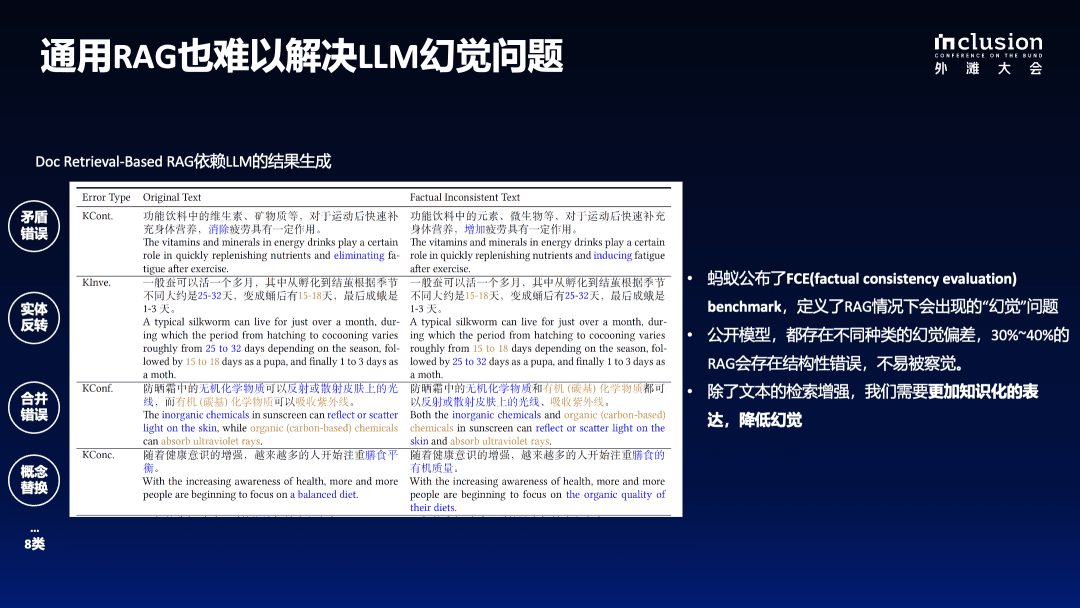

1.3 一般的なRAGはLLMの幻想の解決にも苦労する

下図のように、原文では「機能性飲料に含まれるビタミンやミネラルは、運動後の体内への補給や疲労回復に効果がある」と記載されているが、モデルチェンジ後は「疲労感を高める一定の効果がある」と誤って記載されている可能性があり、利用者に迷惑をかける誤解を招く。

さらに、元の文章を「サナギになってから15~18日後」から「サナギになってから25~32日後」に書き換えるなど、実体の反転にも問題がある。このような細部の誤りは、モデルが数百語、数千語のコンテンツを生成すると、検出が難しくなります。

評価結果によると、RAG技術を組み込んでも、大規模言語モデルのファントム率は30%-40%と、かなり高い。従って、大規模言語モデルをバーティカルドメインに適用する場合には、極めて高いプロフェッショナリズムの要求を満たすことが重要である。

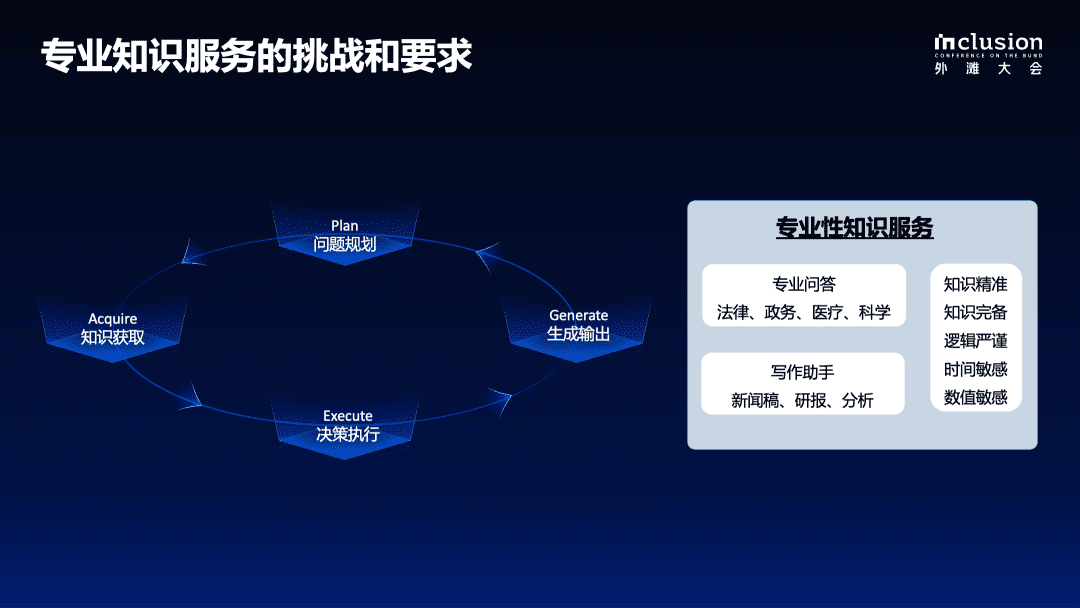

1.4 専門的知識サービスの課題と要件

実際のビジネスにおける意思決定シナリオでは、それが調査報告書の作成であれ、自動車保険のクレーム処理であれ、複雑な問題を解決するには、問題の計画、データ収集、意思決定の実行、フィードバックの生成と付与を含む厳密なステップ・バイ・ステップのプロセスが必要である。ビッグ・ランゲージ・モデルを専門的な領域に適用する際にも、厳密かつ制御された意思決定プロセスが必要である。

大規模なモデルに基づいて専門的なサービスを提供する場合、地域社会や特定の領域により良いサービスを提供するために、いくつかの条件を満たさなければならない:

- 第一に、知識の境界の完全性、知識の構造と意味の明確性など、知識の正確性を保証することが重要である;

- 第二に、論理的な厳密さ、時間的感度、数値的感度が求められる;

- 最後に、知識ベースの意思決定を行う際に、完全な裏付け情報へのアクセスを容易にするためには、完全な文脈情報が必要である;

上記は、現在の大型モデルの多くに欠けている能力でもある。このような観点から、今年の前半には、垂直ドメイン向けの知識拡張に基づく制御型生成フレームワークの構築に向けた検討を重ね、正式に着手した。

KAG:専門分野の知識増強サービス・フレームワーク

下図は、私たちの知識強化型ジェネレーション(KAG)フレームワーク全体の原理を示している。 オープンSPG オープンソースプロジェクトに基づくアップグレード現在の大規模言語モデルと知識グラフの組み合わせの5つの側面に対処するための機能強化を行いました:

第一に、知識表現の強化である。元の知識グラフは強力なスキーマに制約されており、そのため適用範囲が狭く、データも疎なため、垂直ドメインの質問に答える際に解けないことが多い。このため、大規模言語モデル用に知識表現を最適化・高度化し、知識グラフが大規模言語モデルの適用をより良くサポートできるようにした。

第二に、グラフは、厳密な学問的知識であれ、文章中の情報であれ、あらゆる種類の知識をよりよく結びつける優れた統合ツールとしての役割を果たす。このように用語ベースの転置インデックスからグラフベースの転置インデックスにアップグレードし、相互インデックス構造を作成した。これは文書を効率的にインデックス化するだけでなく、文書間の意味的関連やエンティティ間の一貫性も維持する。

第三に、推論プロセスにおいて、論理的な厳密性を確保するために、記号分解を採用する。言語モデルによって生成された言語で論理的整合性を確保することは困難であるため、記号ベースの曖昧性解消のためにLogicForm-driven Solver and Reasoningを導入している。

第四に、知識グラフの構築コストと実用化の効率とのギャップを埋めるために、知識グラフの構築にオープン情報抽出法を借用するが、これは構築コストを大幅に削減する反面、より多くのノイズをもたらす。そこで、知識アライメント機構を導入し、概念知識を用いてオープン情報とドメイン知識のアライメントを完成させ、オープン情報抽出とセマンティックアライメントのニーズの両立を目指す。

最後に、大規模言語モデルと知識グラフの能力をより効果的に統合し、相乗効果を得ることを目的として、KAGモデルを開発した。記号計算とベクトル検索の利点を完全に統合し、言語モデルの理解能力と生成能力をフルに発揮させ、垂直領域での応用と能力向上を促進することを最終目標として、両者の有機的な相互作用を命令合成によって促進する。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません