GPUStack:GPUクラスターを管理し、大規模な言語モデルを実行し、LLMのための一般的な推論サービスを迅速に統合する。

はじめに

GPUStackは、大規模言語モデル(LLM)を実行するために設計されたオープンソースのGPUクラスタ管理ツールです。GPUStackは、Apple MacBook、Windows PC、Linuxサーバを含む幅広いハードウェアをサポートし、GPUとノードの数を簡単に拡張して、コンピューティング需要の増加に対応します。 GPUStackは、分散推論機能を提供し、シングルノードマルチGPUとマルチノードの推論とサービスをサポートし、OpenAI APIと互換性があり、ユーザとAPIキー管理を簡素化し、GPUのパフォーマンスと利用率をリアルタイムに監視します。OpenAI APIと互換性があり、ユーザーとAPIキーの管理を簡素化し、GPUパフォーマンスと利用率をリアルタイムで監視します。軽量なPythonパッケージ設計により、依存性と運用オーバーヘッドを最小限に抑え、開発者や研究者に最適です。

機能一覧

- 幅広いハードウェアに対応:Apple Metal、NVIDIA CUDA、Ascend CANN、Moore Threads MUSAなどに対応。

- 分散推論:シングルノード・マルチGPU、マルチノードの推論とサービスをサポート。

- 複数の推論バックエンド: llama-box (llama.cpp) と vLLM をサポート。

- 軽量Pythonパッケージ:依存性と運用オーバーヘッドを最小化。

- OpenAI互換API:OpenAI標準と互換性のあるAPIサービスを提供します。

- ユーザーとAPIキーの管理:ユーザーとAPIキーの管理を簡素化します。

- GPUパフォーマンス監視:GPUのパフォーマンスと利用状況をリアルタイムで監視します。

- トークン使用量とレートの監視:トークン使用量とレート制限を効率的に管理します。

ヘルプの使用

設置プロセス

LinuxまたはMacOS

- ターミナルを開く。

- 以下のコマンドを実行し、GPUStackをインストールしてください:

curl -sfL https://get.gpustack.ai | sh -s -

- インストール後、GPUStackはsystemdまたはlaunchdシステム上のサービスとして実行されます。

ウィンドウズ

- PowerShellを管理者として実行する(PowerShell ISEの使用は避ける)。

- 以下のコマンドを実行し、GPUStackをインストールしてください:

Invoke-Expression (Invoke-WebRequest -Uri "https://get.gpustack.ai" -UseBasicParsing).Content

使用ガイドライン

初期設定

- GPUStack UIへのアクセス:ブラウザで開く

http://myserver. - デフォルトのユーザー名を使う

adminと初期パスワードを入力してログインします。初期パスワードの取得方法- LinuxまたはMacOS:実行

cat /var/lib/gpustack/initial_admin_password. - ウィンドウズ:実行中

Get-Content -Path "$env:APPDATA\gpustack\initial_admin_password" -Raw.

- LinuxまたはMacOS:実行

APIキーの作成

- GPUStackのUIにログイン後、ナビゲーションメニューの「API Keys」をクリックしてください。

- New API Key "ボタンをクリックし、名前を入力して保存します。

- 生成されたAPIキーをコピーし、適切に保存します(作成時のみ表示されます)。

APIの使用

- 環境変数の設定:

export GPUSTACK_API_KEY=myapikey

- OpenAI互換のAPIにアクセスするにはcurlを使う:

curl http://myserver/v1-openai/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $GPUSTACK_API_KEY" \

-d '{

"model": "llama3.2",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

],

"stream": true

}'

ラン&チャット

- ターミナルで以下のコマンドを実行し、llama3.2モデルとチャットする:

gpustack chat llama3.2 "tell me a joke."

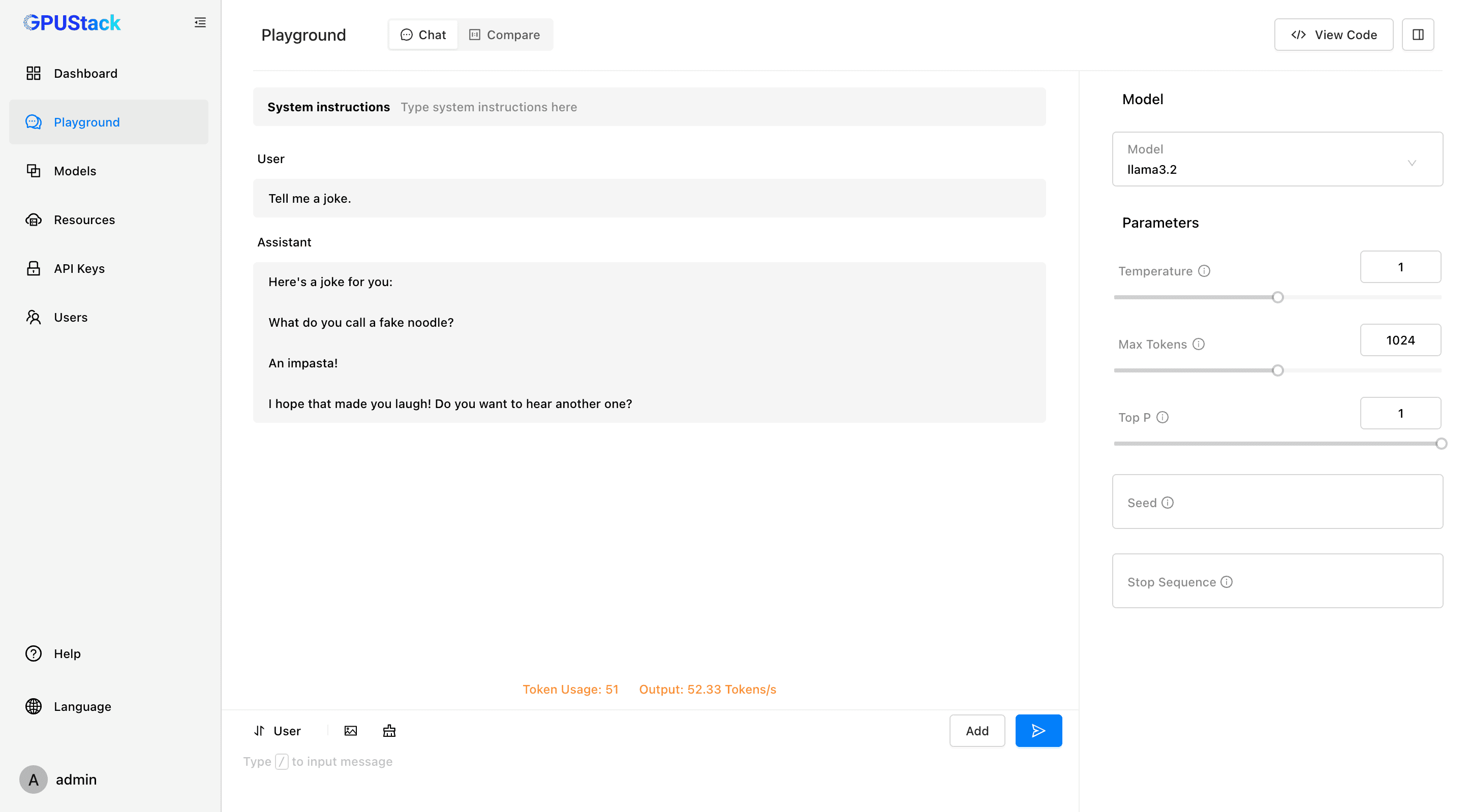

- GPUStack UIの "Playground "をクリックしてください。

モニタリングと管理

- GPUのパフォーマンスと使用率をリアルタイムで監視。

- ユーザーキーとAPIキーを管理し、トークンの使用状況とレートを追跡します。

対応モデルとプラットフォーム

- 対応機種:LLaMA、Mistral 7B、Mixtral MoE、Falcon、Baichuan、Yi、Deepseek、Qwen、Phi、Grok-1など。

- 対応マルチモーダルモデル:Llama3.2-Vision、Pixtral、Qwen2-VL、LLaVA、InternVL2、その他。

- 対応プラットフォーム:macOS、Linux、Windows。

- 対応アクセラレータ:Apple Metal、NVIDIA CUDA、Ascend CANN、Moore Threads MUSA、将来的にはAMD ROCm、Intel oneAPI、Qualcomm AI Engineをサポートする予定。

ドキュメンテーションとコミュニティ

- 公式文書:こちら GPUStackドキュメント 完全なガイドとAPIドキュメントを入手する。

- 貢献ガイド:読書 寄付ガイドライン GPUStackに貢献する方法をご覧ください。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません