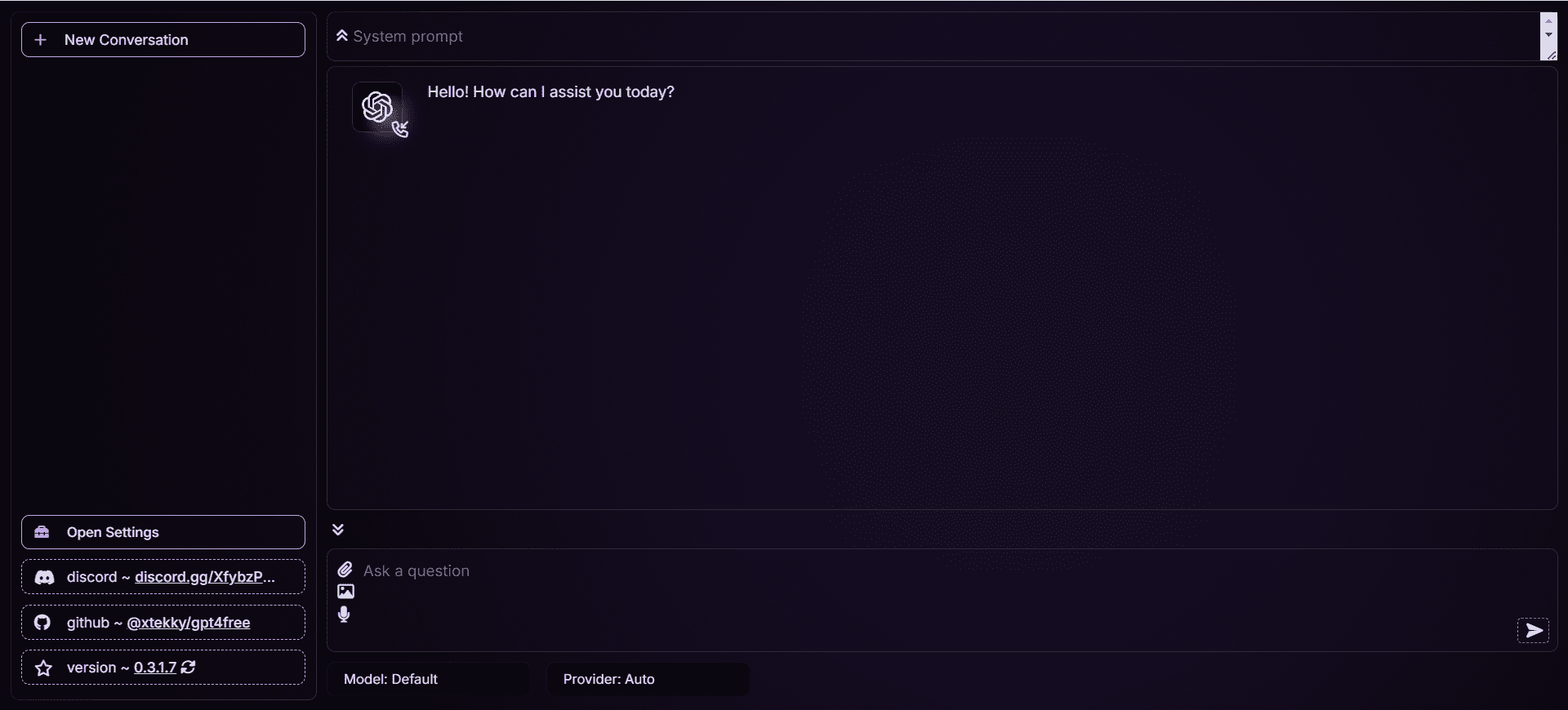

GPT4Free: 複数のGPTモデルを自由に使用するためのAI対話ウェブサイトのインターフェイスをデコンパイルします。

はじめに

GPT4Freeは、GPT-3.5、GPT-4、Llama、Gemini-Pro、Bardを含む幅広い強力な言語モデルを無料で提供することを目的とし、開発者xtekkyによってGitHubで公開されているオープンソースプロジェクトです。 クロード などがある。このプロジェクトは、タイムアウト、ロードバランシング、複数のAPIリクエストのアセンブルによるフロー制御などの機能を提供する。 ユーザーは簡単なインストールと設定によって、これらの高級言語モデルを簡単に使うことができる。

このプロジェクトは、多くのサービスに依存する必要があり、ウェブサイトのインターフェイスが廃止されているデコンパイル、あなたは、最新バージョンを展開するプロジェクトを分岐することができます。推奨https://github.com/xiangsx/gpt4free-ts 、またはSealosのワンクリックデプロイメントを使用してください。

オンライン経験:https://gptgod.online/

機能一覧

- マルチモデル対応GPT-3.5、GPT-4、Llama、Gemini-Pro、Bard、Claudeなど複数の言語モデルをサポート。

- オープンソースで無料完全なオープンソースであるため、ユーザーは無料でコードを使用、変更することができます。

- APIの統合タイムアウト、負荷分散、フロー制御をサポートする幅広いAPIリクエスト機能を提供。

- ドキュメンテーションとチュートリアル詳細なドキュメンテーションとチュートリアルで、すぐに使い始めることができます。

- 地域支援GitHub、Telegram、Discordでユーザーがコミュニケーションをとり、助けを得ることができる活発なコミュニティサポート。

ヘルプの使用

設置プロセス

- ダウンロードコード::

- ターミナルを開き、以下のコマンドを実行してプロジェクトをクローンする:

git clone https://github.com/xtekky/gpt4free.git

- ターミナルを開き、以下のコマンドを実行してプロジェクトをクローンする:

- 依存関係のインストール::

- プロジェクト・ディレクトリに移動し、以下のコマンドを実行して必要な依存関係をインストールする:

cd gpt4free pip install -r requirements.txt

- プロジェクト・ディレクトリに移動し、以下のコマンドを実行して必要な依存関係をインストールする:

- 設定環境::

- 必要に応じて環境変数とAPIキーを設定する。具体的な手順については、プロジェクトのドキュメントを参照すること。

使用ガイドライン

- サービス開始::

- 以下のコマンドを実行してサービスを開始する:

python main.py

- 以下のコマンドを実行してサービスを開始する:

- APIの呼び出し::

- リクエストは提供されたAPIを使って行われる。簡単な例を以下に示す:

import requests url = "http://localhost:8000/api/v1/gpt4" payload = { "model": "gpt-4", "prompt": "你好,GPT-4!", "max_tokens": 100 } response = requests.post(url, json=payload) print(response.json())

- リクエストは提供されたAPIを使って行われる。簡単な例を以下に示す:

- Dockerの使用::

- Dockerを使いたい場合は、以下のコマンドを実行してDockerコンテナを起動できる:

docker-compose up -d

- Dockerを使いたい場合は、以下のコマンドを実行してDockerコンテナを起動できる:

一般的な問題

- APIキーの取得方法を教えてください。

- APIキーの取得と設定に関する詳細な手順については、プロジェクトのドキュメントを参照してください。

- エラーが発生したらどうすればいいのか?

- 依存関係が正しくインストールされているか、環境変数が正しく設定されているか、あるいはコミュニティで助けを求める。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません