gpt-oss - OpenAIによるオープンソースの推論モデルファミリー

gpt-ossとは

gpt-ossはOpenAIのオープンソースの推論モデルファミリーで、開発者向けに効率的で柔軟性があり、導入が容易なAIソリューションを可能にします。gpt-ossは2つのバージョンで構成され、gpt-oss-120Bは1170億のパラメータを持ち、80GBのGPUでの実行をサポートし、gpt-oss-20Bは210億のパラメータを持ち、16GBのRAMを持つ通常のデバイスでの使用をサポートします。gpt-oss-20Bは210億のパラメータを持ち、16GBのRAMを搭載した通常のデバイスでの使用をサポートします。どちらもMoEアーキテクチャをベースとしており、128kのコンテキスト長をサポートし、クローズドソースのo4-miniやgpt-oss-20Bに近いパフォーマンスで高速推論を行います。 o3-ミニgpt-ossは、ツールの呼び出し、連鎖思考をサポートし、多段階の推論タスクに適しており、様々なシナリオに対応するために、オープンソースの重みと推論の強さを調整する機能を提供します。

gpt-ossの主な特徴

- 金型能力ウェブ検索やPythonコードの実行など、外部ツールの呼び出しをサポートし、複雑なタスクの解決を支援します。

- 連鎖推論のサポート複雑なタスクをステップごとに分解し、それをひとつずつ解決していくモデルで、多段階の推論が必要な問題を扱うのに適している。

- 低資源gpt-oss-20Bは16GBのRAMを搭載した一般的なデバイス上での動作に対応し、gpt-oss-120Bは80GBのGPU1つでの動作に対応しているため、さまざまなハードウェア環境に対応できる。

- 迅速な推論応答このモデルは40~50トークン/秒の推論速度が可能で、高速応答が要求されるシナリオで優れた性能を発揮する。

- オープンソースとカスタマイズ完全なモデルウェイトとコードが提供され、ユーザーは特定のタスクの要件を満たすためにローカルで微調整やカスタマイズを行うことができます。

- 推論の強さを調整可能セクション:低、中、高の推論強度設定をサポートし、ユーザーは特定のニーズやシナリオに応じて調整し、最高の使用を達成するために、待ち時間とパフォーマンスの関係のバランスをとる。

gpt-ossの公式ウェブサイトのアドレス

- プロジェクトのウェブサイト:: https://openai.com/zh-Hans-CN/index/introducing-gpt-oss/

- GitHubリポジトリ:: https://github.com/openai/gpt-oss

- HuggingFaceモデルライブラリ:: https://huggingface.co/collections/openai/gpt-oss-68911959590a1634ba11c7a4

- オンライン体験デモ:: https://gpt-oss.com/

gpt-ossのパフォーマンス

- 競技プログラミングCodeforcesの競技プログラミング・テストでは、gpt-oss-120Bが2622点、gpt-oss-20Bが2516点でした。どちらのバージョンも、オープンソースのいくつかのモデルより良いスコアで、クローズドソースのモデルより少し悪いスコアだった。 o3-ミニ とo4-miniで、強力なプログラミング能力を示している。

- 一般的な問題解決gpt-oss-120Bは、OpenAIのo3-miniを上回り、MMLU(Multi-task Language Understanding)とHLE(Human Level Evaluation)テストではo4-miniに近いレベルです。これは、gpt-ossが一般的な問題を扱う際に高い精度と論理的推論能力を持つことを示している。

- ツールコールgpt-oss-120Bとgpt-oss-20Bは、TauBench Intelligent Body Evaluation Suiteにおいて、OpenAIのo3-miniを上回り、o4-miniのレベルにまで達しています。これは、gpt-ossが外部ツール(ウェブ検索、コードインタプリタなど)を呼び出す際に高い効率と精度を持ち、複雑な問題を効果的に解決できることを示している。

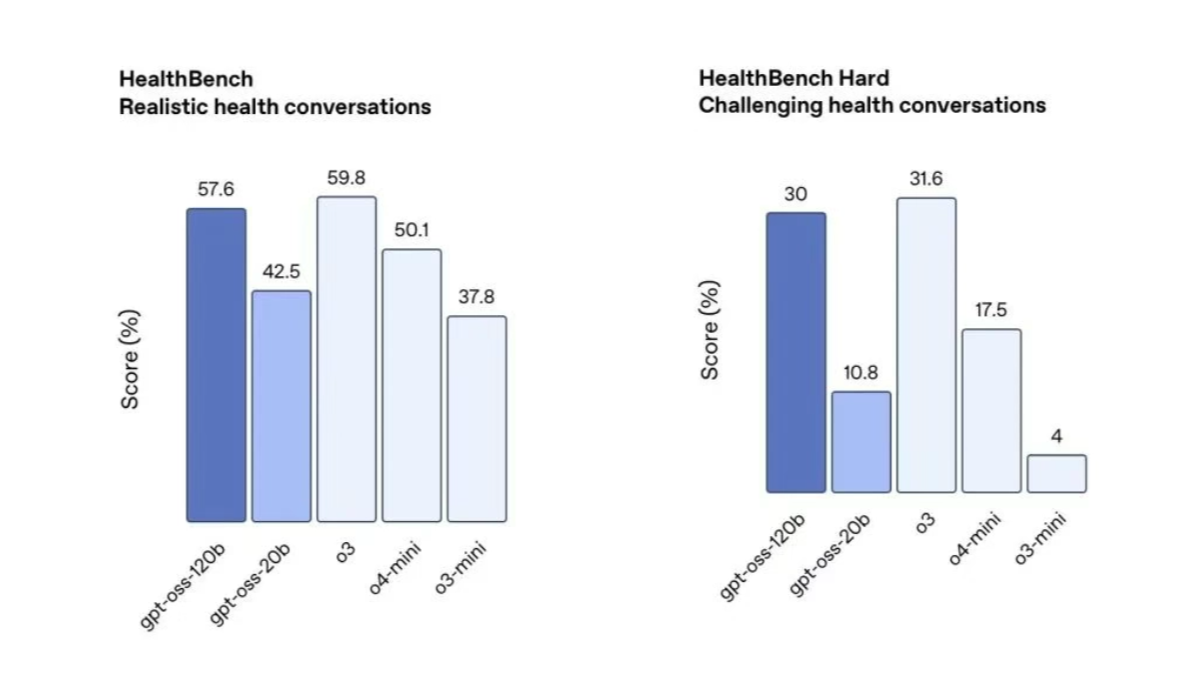

- 健康Q&Aヘルスベンチテストでは、gpt-oss-120Bはo4-miniを上回り、gpt-oss-20Bはo3-miniに匹敵するレベルに達しています。これは、gpt-ossが健康に関する問題に対して高い精度と信頼性を持ち、ユーザーに価値あるアドバイスや情報を提供できることを示している。

gpt-ossの使い方

- オンライン体験プラットフォーム::

- オンライン体験アドレスhttps://gpt-oss.com/。

- 手続き::

- 上のリンクを開いてください。

- ウェブページに質問や指示を入力する。

- Submit(送信)」をクリックして、モデルからの返答を得る。

- GitHubリポジトリのデプロイ::

- GitHubリポジトリにアクセスする:: https://github.com/openai/gpt-oss

- クローン倉庫::

git clone https://github.com/openai/gpt-oss.git

cd gpt-oss- 依存関係のインストール::

pip install -r requirements.txt- モデルウェイトのダウンロードgpt-oss-20b または gpt-oss-120b 用のウェイトファイルを必要に応じて選択し、指定のディレクトリに配置します。

- 運用モデルリポジトリの指示に従ってモデル推論スクリプトを実行します。例

python run_inference.py --model gpt-oss-20b --input "你的输入文本"gpt-ossの主な利点

- オープンソースと柔軟性フルモデルウェイトとコードが提供され、特定のニーズを満たすためのローカルな微調整とカスタマイズをサポートします。

- 効率的な推論パフォーマンス推論速度は最大40-50トークン/秒、高速応答シナリオのための低レイテンシ設計。

- 幅広い適用範囲同社は、16GBのRAMを搭載した平均的なデバイスから、80GBのGPUを搭載した高性能デバイスまで、幅広いハードウェア環境をサポートしている。

- 強い推論連鎖推論とツール呼び出しに対応し、複雑な問題を段階的に解決できるようになり、応用範囲が広がる。

- 安全性と信頼性プレトレーニングフェーズでは、有害なデータをフィルタリングし、モデルの安全性と信頼性を確保するために敵対的な微調整を行う。

gpt-ossの対象者

- 開発者とエンジニア開発者やエンジニアは、プロジェクト開発、ラピッドプロトタイピング、カスタマイズのためにオープンソースモデルを必要としており、モデルによって提供される柔軟性とオープンソースコードは、これらのニーズを満たすことができます。

- データサイエンティストと研究者データサイエンティストや研究者は、モデルの内部メカニズムに興味を持ち、それを微調整したり、実験したり、調査したりすることを望んでいる。

- ビジネスユーザービジネスユーザーは、インテリジェントなカスタマーサービス、データ分析、または自動化タスクのために、高性能で低コストの推論モデルを必要としています。

- 教育者と学生教育分野では、生徒が質問に答えたり、文章を書いたり、プログラミングの練習をしたりするための学習補助教材。

- クリエイティブワーカーこのモデルは、作家、脚本家、ゲーム開発者などが、創造的なコンテンツを生み出し、インスピレーションを与え、創造効率を向上させるのに役立つ。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません