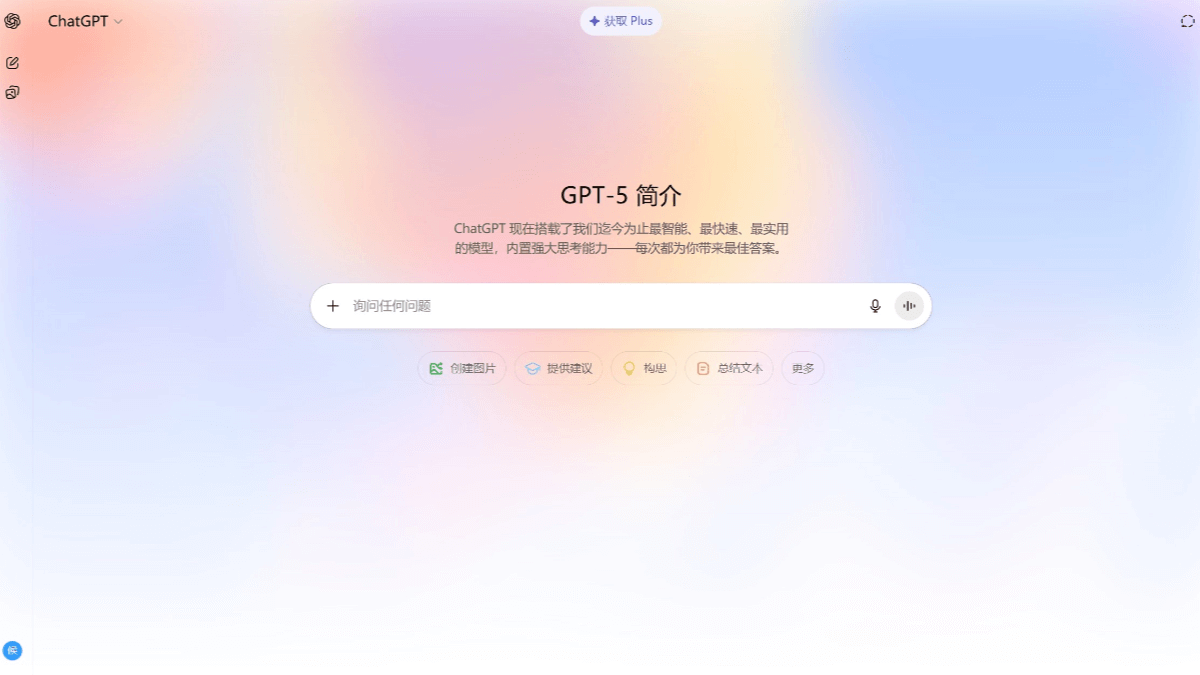

GPT-5 - 統合知能システムOpenAIが導入した最強の言語モデル

GPT-5とは?

GPT-5はOpenAIがリリースした最新の言語モデルで、いくつかのアップグレードが施されています。GPT-5には、一般ユーザー向けのGPT-5、軽量タスク向けのGPT-5 miniとnano、企業や上級ユーザー向けのGPT-5 Proモデルなどのバージョンがある。後者は、超難解な科学的問題を得意としています。

性能面では、GPT-5の錯誤率が大幅に低減され、事実誤認率は前モデルのGPT-4oより45%低く、ディープシンキングモードではo3より80%低い。プログラミング能力も大幅に向上し、複雑なコーディング作業を効率的にこなし、コードエラーを自動的に修正することができる。ライティング能力も向上し、より文学的で自然なセンスのテキストを生成する。

GPT-5の特徴

- 統合インテリジェント・システムGPT-5は、質問の複雑さに応じて適切なモデルを自動的に選択するリアルタイム・ルーターを内蔵した統合インテリジェント・システムです。通常の質問には効率的なモードで素早く回答し、複雑な質問には深く考えるモードに切り替えます。

- マルチバージョンの選択GPT-5、GPT-5 mini、GPT-5 nano、そして企業や上級者向けのGPT-5 Proモデルがあります。

- 幻覚出現率の減少GPT-5の事実誤答率はGPT-4oより45%低く、深層思考モードではo3より80%低く、回答の信頼性が大幅に向上した。

- プログラミング・スキルの向上フロントエンド開発、コードデバッグ、自動バグ修正などの複雑なコーディング作業をこなし、美しくデザインされたウェブサイトやアプリを生成することもできる。

- ライティング能力の向上自由詩のような文学的な深みと韻を踏んだ作品を作ることができ、草稿やメール、物語に装飾を加えることも得意。

- 文脈処理能力の向上従来のモデルよりはるかに多い400kまでの長さのコンテキストをサポートし、長いテキストを扱う際の精度が大幅に向上し、複雑なタスクに役立ちます。

- 価格優位性GPT-5のAPI価格はGPT-4.1よりも低く、開発者や企業ユーザーにとってより競争力のある魅力的なものとなっています。

- ユーザー・エクスペリエンスの最適化GPT-5は、無料ユーザーを含むすべてのユーザーに公開されており、以下のサイトで入手できます。チャットGPTPlusユーザーは利用制限が高く、ProユーザーはGPT-5を無制限に利用できる。

GPT-5コアの利点

- インテリジェント・ルーティング・システム問題の難易度に応じて、回答スピードと回答の質を考慮し、効率的思考モードと深い思考モードを自動的に切り替えるリアルタイム・ルーターを内蔵。

- 幻覚の割合が有意に減少した事実誤認率は、GPT-4oと比較して45%が有意に減少し、深い思考モードではo3と比較して80%が有意に減少し、回答の信頼性が向上した。

- プログラミングスキルの大幅な向上複雑なコーディング作業を効率的に完了し、コードエラーを自動的に修正し、大規模なコードベースのフロントエンド開発とデバッグをサポートします。

- ライティング能力の向上より文学的で自然な雰囲気の文章を創作し、文学的な深みとリズムのある作品を創作する。

- 文脈理解能力の飛躍長さ400kまでのコンテクストをサポートし、精度を大幅に向上。

GPT-5の公式ウェブサイトは?

- 公式ウェブサイトアドレス:: https://openai.com/index/introducing-gpt-5/

GPT-5 該当者

- 愛用者GPT-5は、無料ユーザーを含むすべての個人ユーザーに開放されており、日常的な対話、情報照会、簡単なタスクのニーズを満たすことができる。

- 開発者GPT-5シリーズはAPIを通じて呼び出され、様々なアプリケーションやサービスを開発することができます。

- ビジネスユーザーGPT-5 ProモデルはEnterprise Editionのユーザー向けに提供され、データ分析や科学研究など、複雑なタスクや高精度の要件に対応する必要がある企業に適しています。

- 教育者と学生GPT-5は、ライティング、プログラミング、知識習得の面で強化されているため、教育や学習の助けとなる強力なツールです。

- プロフェッショナルプログラマー、ライター、研究者など、GPT-5のプログラミングやライティングスキル向上は、作業効率や作品の質を向上させるのに役立ちます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません