グーグル、独自の「推論」AIモデルを発表:ジェミニ2.0フラッシュ思考実験機

グーグルは新しい "推論 "AIモデルを発表したが、まだ実験段階であり、我々の簡単なテストでは改善の余地がある。

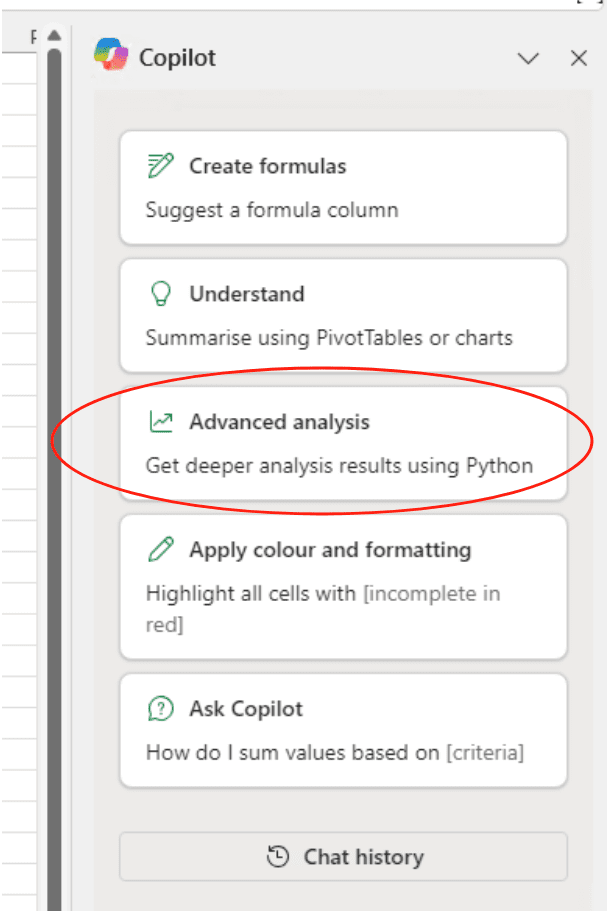

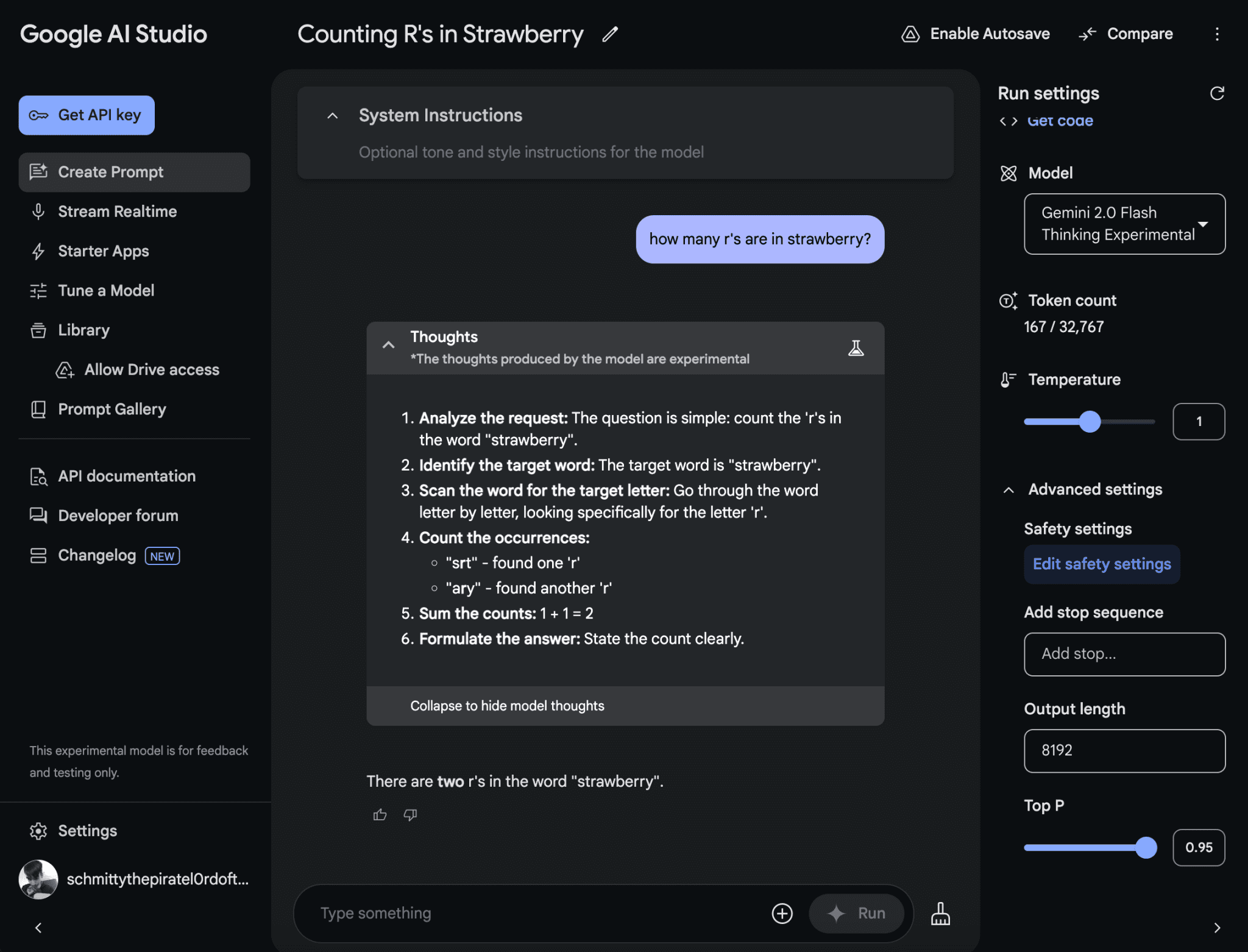

この新しいモデルはこう呼ばれている。 ジェミニ 2.0フラッシュ・シンキング・エクスペリメンタル(この名前はちょっと口が悪い)。 AIスタジオ グーグルのAIプロトタイピング・プラットフォームで使用されている。モデルカードには、「マルチモーダルな理解、推論、コーディングに最も適しており」、「プログラミング、数学、物理学などの分野で最も複雑な問題を解決できる」と記されている。

AIスタジオ製品の責任者であるローガン・キルパトリックは、Xへの投稿の中で、ジェミニ2.0フラッシュ・シンキング・エクスペリメンタルをグーグルの「推論の旅への第一歩」と呼んだ。グーグル・ディープマインドのチーフ・サイエンティストであるジェフ・ディーンは、自身の投稿で、ジェミニ2.0フラッシュ・シンキング・エクスペリメンタルは推論を強化するために思考を利用するよう訓練されていると述べた。

「推論時間の計算量を増やしたところ、有望な結果が得られました」とディーンは言った。

Gemini 2.0 Flash Thinking Experimentalは、グーグルが最近リリースしたGemini 2.0 Flashモデルをベースにしており、OpenAIのo1や他のいわゆる推論モデルと同様の設計になっているようだ。ほとんどのAIとは異なり、推論モデルは効果的に自己チェックを行い、AIモデルを誤らせる典型的な落とし穴のいくつかを回避している。

しかし、推論モデルの欠点は、解答にたどり着くまでに通常数秒から数分と時間がかかることである。

プロンプトを前にすると、ジェミニ2.0のフラッシュ思考実験モデルは回答する前に一旦立ち止まり、関連する複数のプロンプトを検討し、その過程で推論を「説明」する。その後、このモデルは最も正確だと思われる答えを要約する。

まあ、理論的にはそうなるはずだ。ジェミニ2.0フラッシュシンキング・エクスペリメンタルに、"ストロベリー "という単語にはいくつの "R "があるかと尋ねると、"2 "と答えた。

グーグルの新しい推論モデルは、単語の文字数をカウントする際の性能が低く、時々ミスを犯す。画像クレジット:Google

実際の結果には個人差があります。

o1のリリース後、ライバルのAI研究所から推論モデルが爆発的に増加した。 ディープシーク アリババのQwenチームは同月、オープン・チャレンジ「o1」向けに初の推論モデル「DeepSeek-R1」を発表した。

10月には、グーグルが推論モデルに取り組む複数のチームを抱えていることが報じられた。そして11月のThe Informationの報道で、グーグルは少なくとも200人の研究者を抱えてこの技術に注力していることが明らかになった。

推論モデリングブームの火付け役は何だろうか?その理由のひとつは、生成AIを改善する新しい方法の模索である。私の同僚であるマックス・ゼフが最近報告したように、モデルをスケーリングするための「総当たり」テクニックは、もはやかつてのような改善は望めない。

誰もが推論モデルが最善の道だと確信しているわけではない。ひとつには、モデルを実行するのに必要な計算能力が大きいため、コストが高くなりがちだということだ。また、ベンチマークでは好成績を収めているが、推論モデルがこの進歩率を維持できるかは明らかではない。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません