Gemini Cursor:見て、聞いて、話すことができるGemini上に構築されたAIデスクトップスマートアシスタント

はじめに

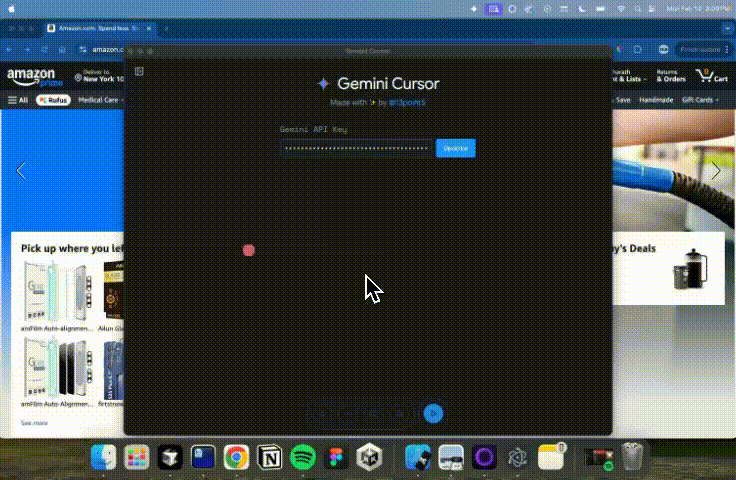

ジェミニカーソル は、GoogleのGemini 2.0 Flash(実験的)モデルをベースにしたデスクトップ知的アシスタントである。マルチモーダルAPIを通じて視覚、聴覚、音声によるインタラクションを可能にし、リアルタイムで遅延の少ないユーザー体験を提供する。13point5によって作成されたこのプロジェクトは、AIアシスタントを使用して、研究論文の複雑な図を理解したり、ウェブサイト上でタスクを実行したり(例:Amazonで支払い方法を追加する)、ホワイトボードを使用してリアルタイムのAI教師として教えたりするなど、ユーザーが複雑なタスクをより効率的に実行できるようにすることを目指している。

機能一覧

- AIインテリジェント・アシスタント画面を見て、ユーザーの声を聞き、話しかけることができるインテリジェントなアシスタントをデスクトップに追加します。

- マルチモーダルインタラクション視覚、聴覚、音声によるインタラクションをサポートし、より自然なユーザー体験を実現。

- リアルタイム低遅延ユーザーエクスペリエンスを向上させるため、インタラクション時のレイテンシーを低くします。

- 複雑なタスクのナビゲーション支払い方法の追加など、ユーザーが複雑なウェブサイト上でタスクを実行できるようにします。

- リアルタイムAI教師複雑なダイアグラムやアーキテクチャー・マップを理解するためのホワイトボード機能によるリアルタイム・ティーチング。

ヘルプの使用

設置プロセス

- クローン倉庫::

git clone https://github.com/13point5/gemini-cursor.git

cd gemini-cursor

- 依存関係のインストール::

npm install

- アプリケーションの実行::

npm run start

- APIキーの設定::

- アプリケーションで ジェミニAPI 鍵だ。

- 再生ボタンと画面共有ボタンをクリックします。

- アプリを最小化して開始する。

機能操作ガイド

- AIインテリジェント・アシスタント::

- アプリを起動すると、AIアシスタントがデスクトップに表示される。

- アシスタントは画面の内容を見ることができ、ユーザーの音声コマンドを聞き、音声でユーザーと対話することができる。

- マルチモーダルインタラクション::

- このアプリは、カメラを通して画面の内容をキャプチャし、マイクを通してユーザーの音声コマンドを受信することをサポートしている。

- ユーザーは音声コマンドを使ってアシスタントを操作し、ファイルを開いたりウェブを閲覧したりといったさまざまな操作を行うことができる。

- 複雑なタスクのナビゲーション::

- ユーザーは音声コマンドを使って、複雑なウェブサイトのタスクをアシスタントに実行させることができる。

- 例えば、アマゾンで支払い方法を追加する場合、ユーザーは完了する必要のあるステップをアシスタントに伝えるだけで、アシスタントが自動的にナビゲートし、アクションを実行する。

- リアルタイムAI教師::

- ホワイトボード機能を起動すると、ユーザーは音声コマンドを使ってアシスタントにホワイトボードに図やハイライトなどを描かせることができる。

- 研究論文のダイアグラムや建築図など、複雑な概念の教育やデモンストレーションに最適です。

一般的な問題

- Gemini APIキーはどのように入手できますか?

- ユーザーはGoogleのGemini APIプラットフォームにアクセスして登録し、APIキーを取得する必要がある。

- アプリの実行中にエラーが発生した場合はどうすればいいですか?

- Node.jsのバージョンがv16以上であり、すべての依存関係が適切にインストールされていることを確認する。

- APIキーが正しく設定されていることを確認する。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません