FunClip:ビデオコンテンツをショートフィルムにインテリジェントに編集。

はじめに

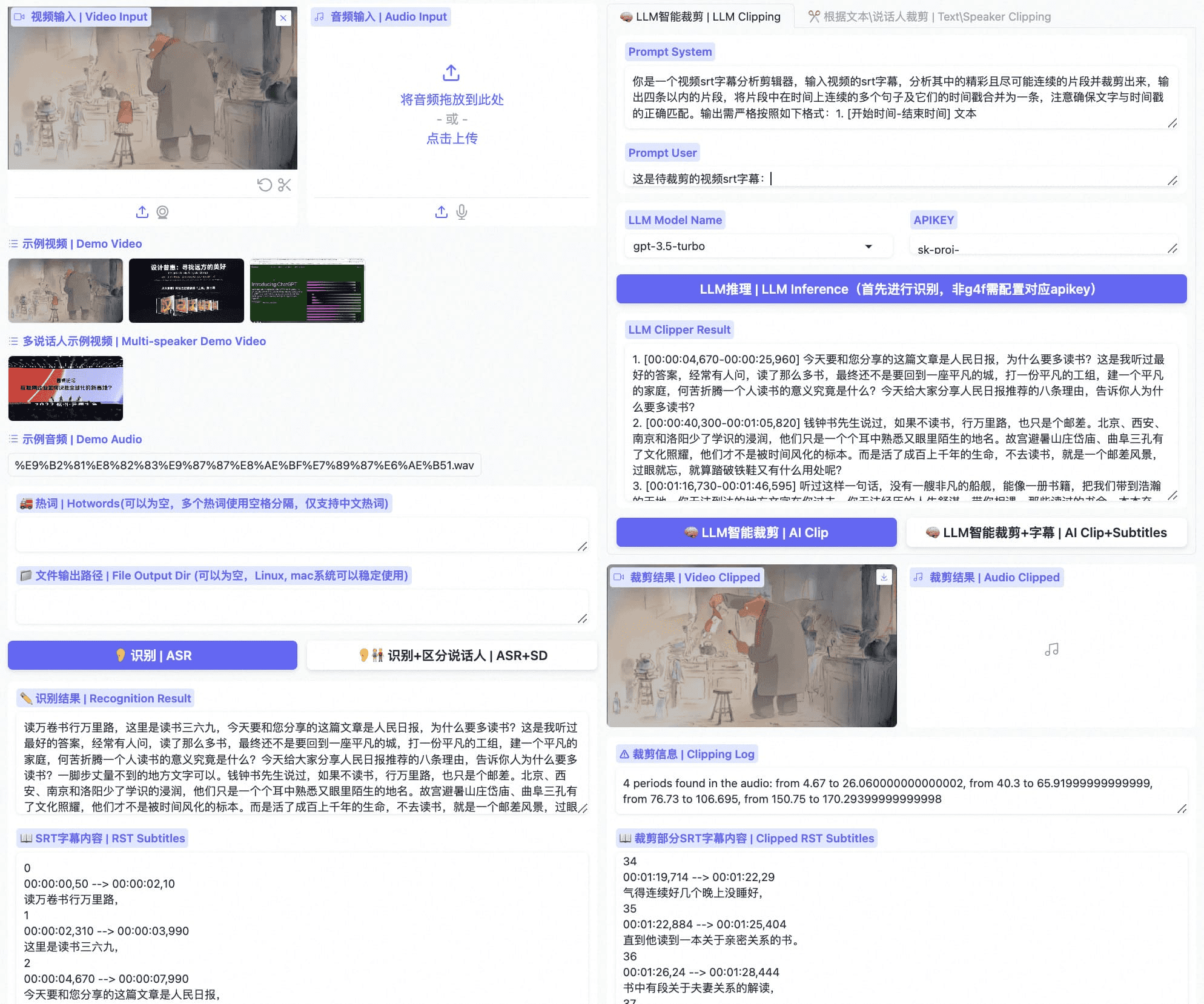

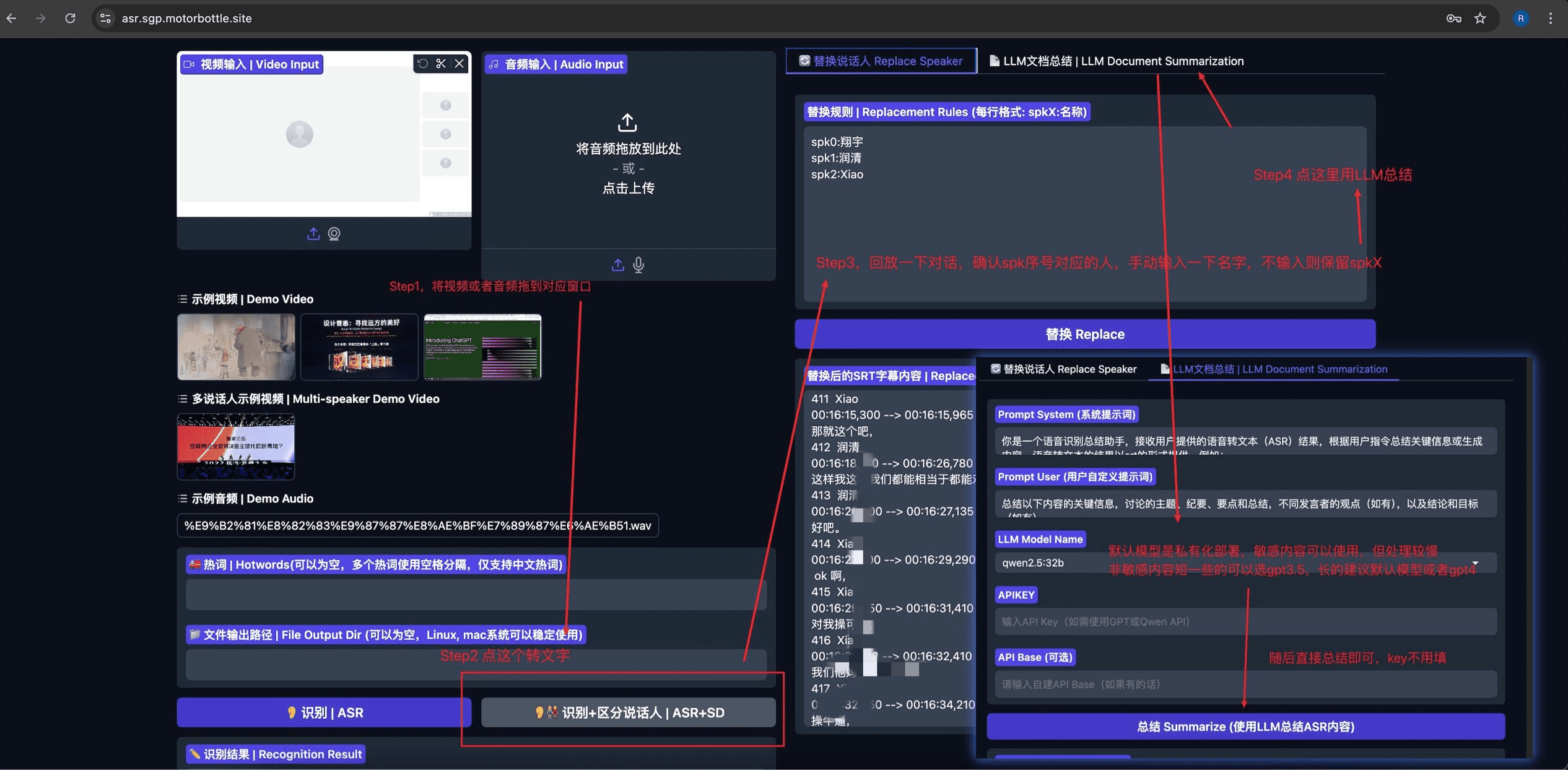

FunClipはAlibaba Dharma InstituteのTONGYI Speech Labによって開発された完全オープンソースのローカライズされた自動ビデオ編集ツールです。このツールは、産業グレードのParaformer-Large音声認識モデルを統合しており、ビデオ内の音声コンテンツを正確に識別し、テキストに変換することができます。FunClipの特徴は、ラージ言語モデリング(LLM)によるインテリジェント編集をサポートし、話者認識を統合して異なる話者を自動的に識別することです。ユーザーは簡単なインターフェース操作で、興味のあるテキストクリップを選択し、ワンクリックで対応するビデオクリップをエクスポートできます。このツールは、マルチセグメント自由編集をサポートし、完全なSRT字幕ファイルとターゲットセグメント用の字幕を自動的に生成することができ、ユーザーに簡単で便利なビデオ処理体験を提供します。最新バージョンは、バイリンガル認識をサポートし、豊富な字幕の埋め込みとエクスポート機能を提供し、強力で使いやすいオープンソースのビデオ処理ツールです。

ファンクリップ最適化 - プライベート-ASR

プライベート-ASR オープンソースプロジェクトに基づく ファンクリップ 自動音声認識(ASR)、話者分離、SRT字幕編集、LLMベースの要約を統合するように変更。このプロジェクトでは グラディオ 直感的で使いやすいユーザーインターフェースを提供。

機能一覧

- 正確な音声認識:アリババのオープンソースParaformer-Largeモデルを統合し、中国語と英語の音声認識をサポート。

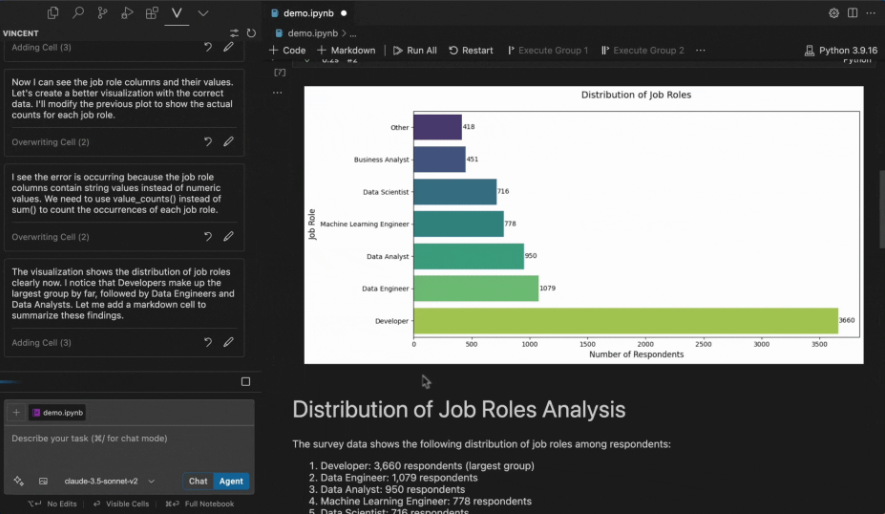

- LLMインテリジェントクリップ:大規模な言語モデルにより、コンテンツのインテリジェントな分析とクリップポイントの自動決定をサポートします。

- 話者認識:CAM++話者認識モデルを統合し、異なる話者のアイデンティティを自動的に認識することができる。

- ホットワードカスタマイズ: SeACo-Paraformerのホットワードカスタマイズ機能をサポートし、特定の単語の認識精度を向上させます。

- 複数セグメントの編集:バッチ編集のために複数のテキストセグメントを自由に選択可能

- 字幕生成:フルビデオのSRT字幕とターゲットクリップの字幕を自動的に生成します。

- バイリンガルサポート:中国語と英語のビデオ認識と編集をサポート

- ローカル展開:完全なオープンソース、ローカル展開のサポート、プライバシーとデータセキュリティの保護

- 親しみやすいインターフェース:Gradioフレームワークの開発に基づいており、シンプルで直感的なウェブインターフェースを提供します。

ヘルプの使用

1.インストールと展開

基本環境のインストール

- コードリポジトリをクローンする:

git clone https://github.com/alibaba-damo-academy/FunClip.git

cd FunClip

- Pythonの依存関係をインストールします:

pip install -r ./requirements.txt

オプション機能のインストール(埋め込み字幕用)

字幕埋め込み機能を使うには、ffmpegとimagemagickをインストールする必要があります:

- Ubuntu:

apt-get -y update && apt-get -y install ffmpeg imagemagick

sed -i 's/none/read,write/g' /etc/ImageMagick-6/policy.xml

- MacOS:

brew install imagemagick

sed -i 's/none/read,write/g' /usr/local/Cellar/imagemagick/7.1.1-8_1/etc/ImageMagick-7/policy.xml

- ウィンドウズ

- 公式ウェブサイト https://imagemagick.org/script/download.php#windows から imagemagick をダウンロードしてインストールします。

- Pythonのインストールパスを見つけて

site-packages\moviepy\config_defaults.py正鵠を得るIMAGEMAGICK_BINARYimagemagick のインストールパス - フォントファイルをダウンロードする:

wget https://isv-data.oss-cn-hangzhou.aliyuncs.com/ics/MaaS/ClipVideo/STHeitiMedium.ttc -O font/STHeitiMedium.ttc

2.使用方法

A. ローカル・グラディオ・サービスの利用

- サービスを開始する:

python funclip/launch.py

# 使用 -l en 参数支持英文识别

# 使用 -p xxx 设置端口号

# 使用 -s True 开启公共访问

- インタビュー

localhost:7860以下の手順に従ってください:

- ステップ1:動画ファイルのアップロード

- ステップ2:目的のテキストクリップを「Text to Clip」エリアにコピーする。

- ステップ3:必要に応じて字幕設定を調整する

- ステップ4:「クリップ」または「クリップして字幕を生成」をクリックして編集する。

B. LLM スマートクリップ

- 認識が完了したら、大きな言語モデルを選択し、apikeyを設定します。

- LLM推論」ボタンをクリックすると、システムは自動的にビデオ字幕とプリセットキューを組み合わせます。

- AIクリップ」ボタンをクリックすると、大規模言語モデルの出力に基づいて編集用のタイムスタンプが自動的に抽出されます。

- 大規模な言語モデルの出力は、手がかりとなる単語を修正することで最適化できる。

C. コマンドラインの使用

- 音声認識:

python funclip/videoclipper.py --stage 1 \

--file examples/video.mp4 \

--output_dir ./output

- ビデオクリップ

python funclip/videoclipper.py --stage 2 \

--file examples/video.mp4 \

--output_dir ./output \

--dest_text '待剪辑文本' \

--start_ost 0 \

--end_ost 100 \

--output_file './output/res.mp4'

さらに、ユーザーは以下のオンライン・プラットフォームを通じてFunClipを体験することができる:

- モデルスコープ空間:FunClip@モデルスコープスペース

- ハギング・フェイス・スペースFunClip@ハギング・フェイス・スペース

使用上の問題が発生した場合は、プロジェクトが提供するピングループやweiboグループを通じてコミュニティサポートを受けることができる。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません