FunASR: オープンソース音声認識ツールキット、話者分離/多人数対話音声認識

はじめに

FunASRはアリババのDharma Instituteによって開発されたオープンソースの音声認識ツールキットで、学術研究と産業アプリケーションの橋渡しをする。FunASRは、音声認識(ASR)、音声終端検出(VAD)、句読点復元、言語モデリング、話者検証、話者分離、複数人対話音声認識など、幅広い音声認識機能をサポートしています。FunASRは、事前に学習させたモデルの推論と微調整をサポートする便利なスクリプトとチュートリアルを提供し、ユーザーが効率的な音声認識サービスを迅速に構築できるよう支援します。

様々なオーディオ・ビデオ形式の入力をサポートし、数十時間に及ぶ長時間のオーディオやビデオを句読点を含むテキストに識別することができ、数百の同時転写要求をサポート 中国語、英語、日本語、広東語、韓国語をサポート。

オンライン経験:https://www.funasr.com/

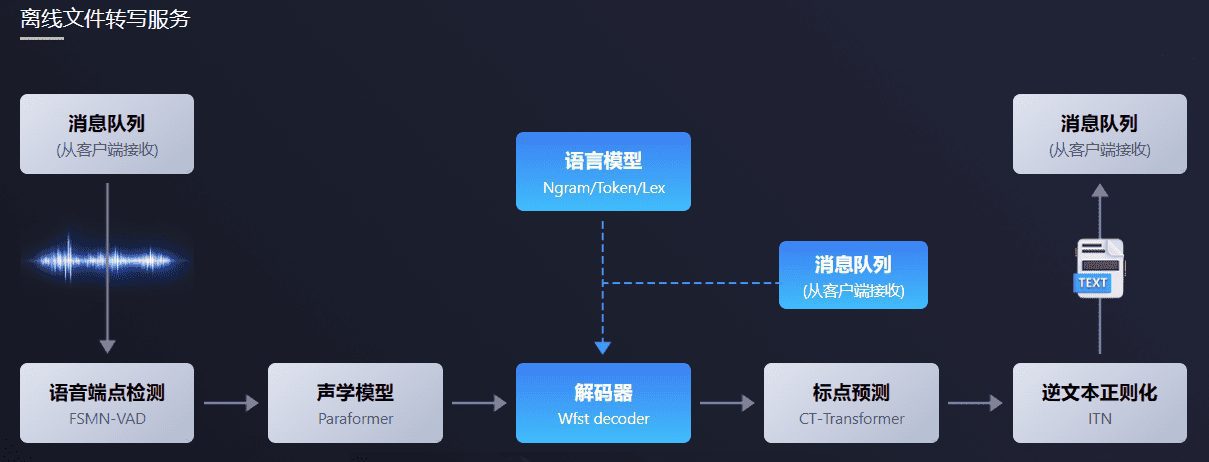

FunASRオフラインファイル書き起こしソフトウェアパッケージは、強力な音声オフラインファイル書き起こしサービスを提供します。音声終端検出、音声認識、句読点、その他のモデルを組み合わせた完全な音声認識リンクにより、何十時間もの長時間の音声やビデオを句読点付きテキストとして認識することができ、何百もの同時テープ起こし要求をサポートします。出力は、単語レベルのタイムスタンプを持つ句読点付きテキストで、ITNとユーザー定義のホットワードをサポートします。ffmpegとサーバーサイドで統合し、様々なオーディオ・ビデオフォーマット入力をサポート。このパッケージは、html、python、c++、java、c#などのプログラミング言語のクライアントを提供し、ユーザーが直接使用し、さらに開発することができます。

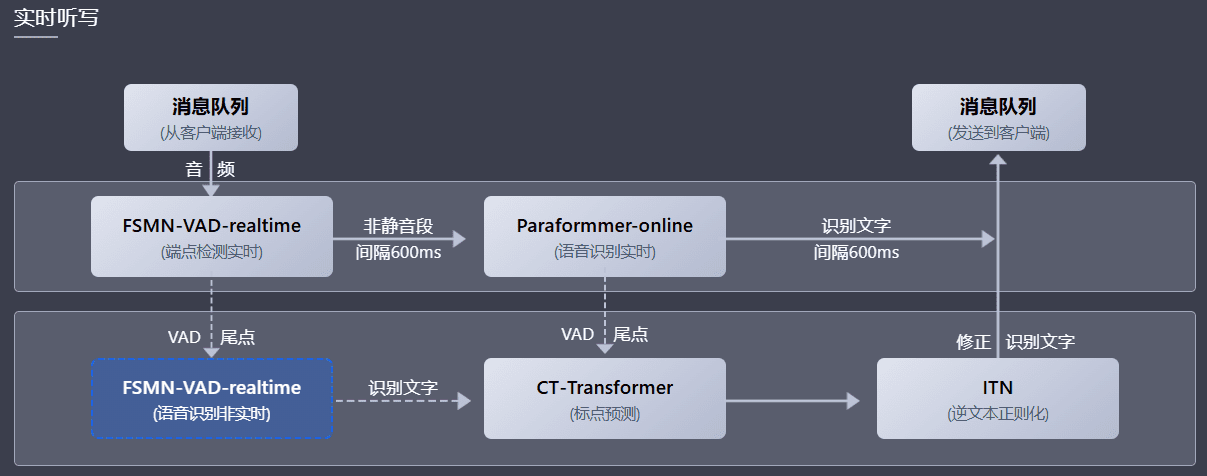

FunASRリアルタイム音声ディクテーションソフトウェアパッケージは、リアルタイム版の音声終点検出モデル、音声認識、音声認識、句読点予測モデルなどを統合しています。マルチモデルの相乗効果により、リアルタイムの音声テキスト化だけでなく、文末の高精度な書き起こしテキストや、句読点を含む出力テキストの修正、複数のリクエストへの対応も可能です。様々なユーザーシナリオに応じて、リアルタイム音声ディクテーションサービス(オンライン)、非リアルタイム文章書き起こし(オフライン)、リアルタイム・非リアルタイム統合コラボレーション(2pass)の3つのサービスモードをサポートします。本ソフトウェアパッケージは、html、python、c++、java、c#クライアントなど様々なプログラミング言語を提供し、ユーザーは直接使用することができ、さらに開発を進めることができます。

機能一覧

- 音声認識(ASR):オフラインおよびリアルタイムの音声認識をサポート。

- 音声終点検出(VAD):音声信号の開始と終了を検出する。

- 句読点の回復:テキストの読みやすさを向上させるために句読点を自動的に追加します。

- 言語モデル:複数の言語モデルの統合をサポート。

- 発言者確認:発言者の身元を確認する。

- 話者分離:異なる話者の音声を区別すること。

- 複数会話の音声認識:複数同時会話の音声認識をサポート。

- モデルの推論と微調整:事前に訓練されたモデルの推論と微調整機能を提供する。

ヘルプの使用

設置プロセス

- 環境準備::

- Python 3.7以上がインストールされていることを確認する。

- 必要な依存ライブラリをインストールする:

pip install -r requirements.txt

- ダウンロードモデル::

- ModelScopeまたはHuggingFaceから訓練済みモデルをダウンロードする:

git clone https://github.com/modelscope/FunASR.git cd FunASR

- ModelScopeまたはHuggingFaceから訓練済みモデルをダウンロードする:

- 設定環境::

- 環境変数を設定する:

export MODEL_DIR=/path/to/your/model

- 環境変数を設定する:

使用プロセス

- 音声認識::

- 音声認識にはコマンドラインを使う:

python recognize.py --model paraformer --input your_audio.wav - Pythonコードによる音声認識:

from funasr import AutoModel model = AutoModel.from_pretrained("paraformer") result = model.recognize("your_audio.wav") print(result)

- 音声認識にはコマンドラインを使う:

- 音声エンドポイント検出::

- 音声エンドポイントの検出にはコマンドラインを使用する:

python vad.py --model fsmn-vad --input your_audio.wav - Pythonコードによる音声エンドポイント検出:

from funasr import AutoModel vad_model = AutoModel.from_pretrained("fsmn-vad") vad_result = vad_model.detect("your_audio.wav") print(vad_result)

- 音声エンドポイントの検出にはコマンドラインを使用する:

- 句読点の回復::

- 句読点の回復にはコマンドラインを使用する:

python punctuate.py --model ct-punc --input your_text.txt - Pythonコードによる句読点の回復:

from funasr import AutoModel punc_model = AutoModel.from_pretrained("ct-punc") punc_result = punc_model.punctuate("your_text.txt") print(punc_result)

- 句読点の回復にはコマンドラインを使用する:

- スピーカー検証::

- スピーカーの確認にはコマンドラインを使用する:

python verify.py --model speaker-verification --input your_audio.wav - Pythonコードによるスピーカー検証:

from funasr import AutoModel verify_model = AutoModel.from_pretrained("speaker-verification") verify_result = verify_model.verify("your_audio.wav") print(verify_result)

- スピーカーの確認にはコマンドラインを使用する:

- マルチトークの音声認識::

- コマンドラインを使った複数人での会話の音声認識:

python multi_asr.py --model multi-talker-asr --input your_audio.wav - Pythonコードによる多人数会話の音声認識:

from funasr import AutoModel multi_asr_model = AutoModel.from_pretrained("multi-talker-asr") multi_asr_result = multi_asr_model.recognize("your_audio.wav") print(multi_asr_result)

- コマンドラインを使った複数人での会話の音声認識:

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません