FramePack:6Gの低グラフィックスメモリは、長いビデオオープンソースプロジェクトの高速成長

はじめに

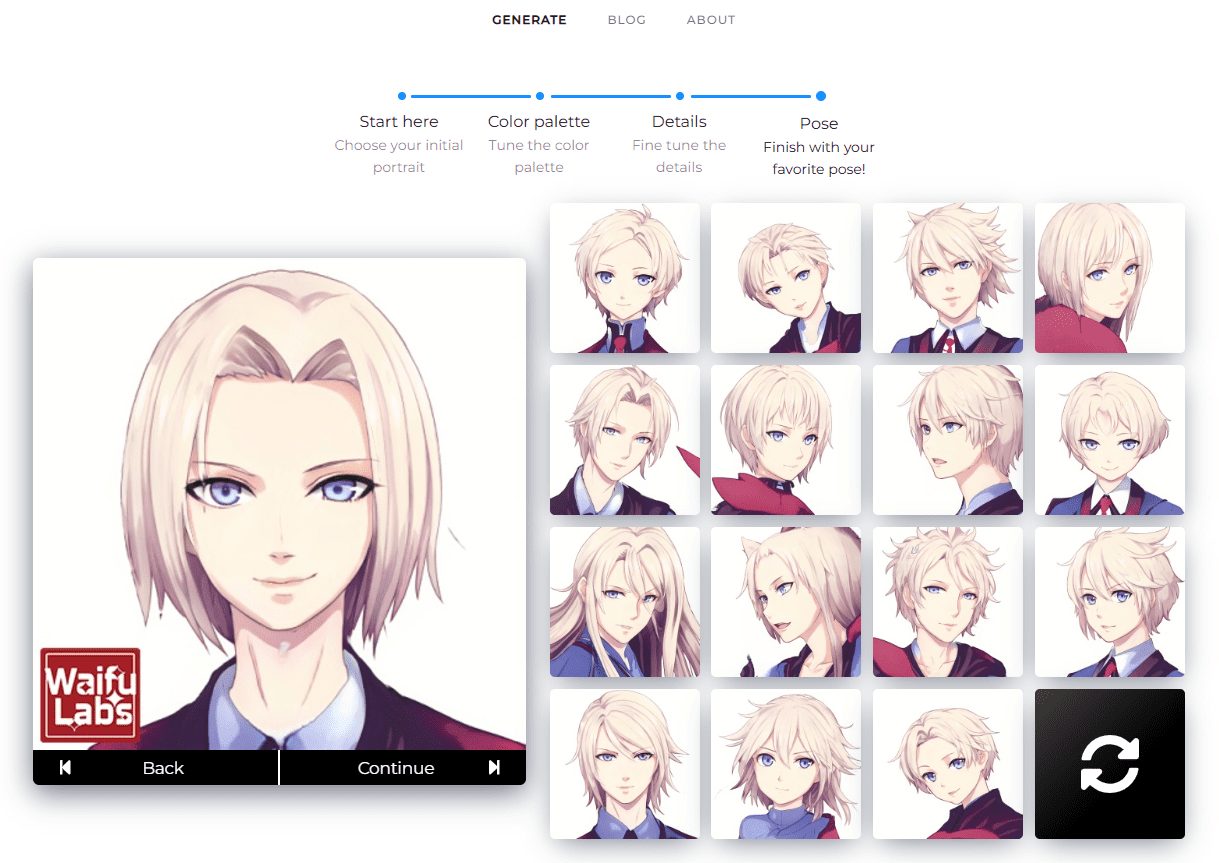

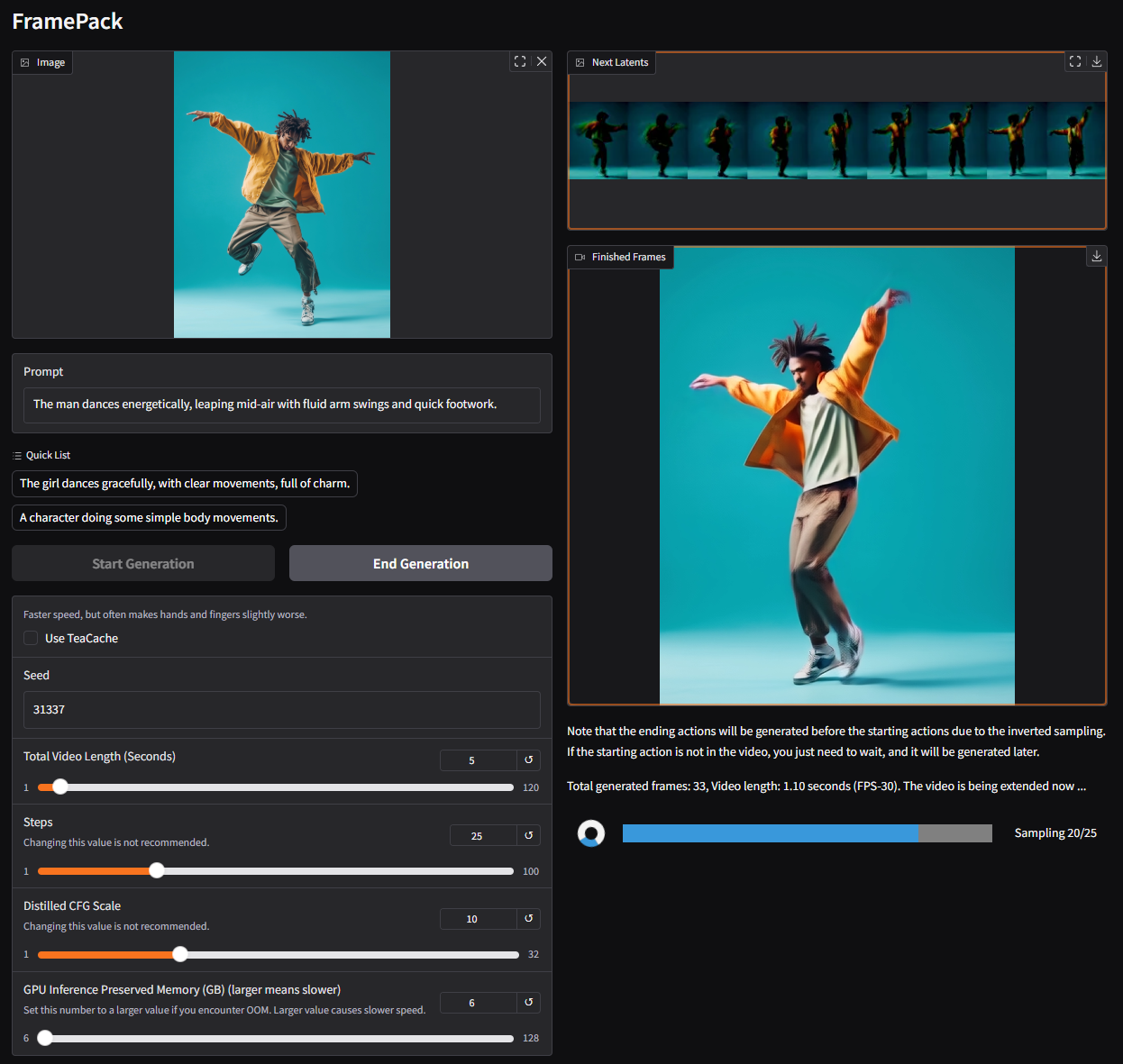

FramePackは、動画拡散技術をより実用的にすることに焦点を当てたオープンソースの動画生成ツールである。独自の次フレーム予測ニューラルネットワークによって入力フレームを固定長に圧縮することで、生成作業をビデオの長さから切り離します。このプロジェクトはLvmin Zhangによって開発され、わずか13億のモデルパラメータに最適化されたHunyuanビデオモデルに基づいており、効率性と軽量化を兼ね備えています。FramePackは、1フレームあたり最大1.5秒という最適化された速度で画像から動画への生成をサポートする、使いやすいGradioインターフェースを提供します。コンテンツ制作者、開発者、動画生成に興味のある一般ユーザーに適しています。

機能一覧

- 画像から動画生成:1枚の画像からモーション・ビデオを生成します。

- 低RAM最適化:わずか6GBのRAMで60秒間の30fpsビデオを生成できます。

- 次フレーム予測:コンテキストを圧縮することで、ビデオの長さに依存しない作業量を生成する。

- グラディオのユーザーインターフェース:画像のアップロード、プロンプトの入力、生成されたビデオのプレビューなど、直感的な機能を提供します。

- 複数のアテンション機構のサポート: PyTorch, xformers, flash-attn, sage-attention がサポートされています。

- クロスプラットフォーム互換性:LinuxとWindowsをサポートし、NVIDIA RTX 30XX/40XX/50XXシリーズGPUと互換性があります。

- 最適化された生成速度:1フレームあたり最大1.5秒のteacacheによる最適化。

- バッチトレーニングサポート:画像拡散と同様の超大規模バッチトレーニングをサポート。

ヘルプの使用

設置プロセス

FramePackのインストールはより技術的で、PythonやGPU環境の設定にある程度の経験があるユーザーに向いている。以下は、WindowsとLinuxシステム用の詳細なインストール手順と、公式GitHubページとWebリソースです。

環境要件

- オペレーティングシステムLinuxまたはWindows。

- GPU: NVIDIA RTX 30XX/40XX/50XXシリーズ、fp16およびbf16をサポート(GTX 10XX/20XXは未テスト)。

- メモリー最低6GB(60秒の30fpsビデオを生成)。

- パイソン版Python 3.10を推奨する(注:Pythonのバージョンは厳密に合わせる必要があり、そうしないとライブラリの非互換性が生じる可能性がある)。

- CUDACUDA 12.6など、GPUと互換性のあるバージョンのCUDAをインストールする必要があります。

インストール手順

- クローンフレームパック倉庫

ターミナルかコマンドプロンプトを開き、以下のコマンドを実行してプロジェクトをクローンする:git clone https://github.com/lllyasviel/FramePack.git cd FramePack - 仮想環境の構築

依存関係の衝突を避けるために、Pythonの仮想環境を作成することをお勧めします:python -m venv venv仮想環境をアクティブにする:

- ウィンドウズ

venv\Scripts\activate.bat - Linuxだ:

source venv/bin/activate

- ウィンドウズ

- PyTorchのインストールと依存関係

CUDAのバージョン(例えばCUDA 12.6)に合わせてPyTorchをインストールする:pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126プロジェクトの依存関係をインストールします:

pip install -r requirements.txt - (オプション)セージ・アテンションまたはフラッシュ・アテンションのインストール

パフォーマンスを向上させるには、Sage Attentionをインストールします(CUDAとPythonのバージョンに合ったホイールファイルを選択する必要があります):pip install https://github.com/woct0rdho/SageAttention/releases/download/v2.1.1-windows/sageattention-2.1.1+cu126torch2.6.0-cp312-cp312-win_amd64.whl注:セージ・アテンションは生成品質に若干の影響を与える可能性があります。

- Gradioインターフェースの起動

インストールが完了したら、以下のコマンドを実行してインターフェースを起動する:python demo_gradio.py起動後、ターミナルには次のように表示される。

http://127.0.0.1:7860/FramePackのGradioインターフェイスには、ブラウザでURLにアクセスすることでアクセスできます。

一般的なインストールの問題

- Pythonバージョンの不一致依存関係のインストールに失敗した場合は、Pythonのバージョンが3.10であることを確認してください。

python --version現在のバージョンを見る - 依存の対立もし

requirements.txtライブラリのバージョンに互換性がない場合はavそしてnumpyそしてscipyバージョンを指定する場合は、最新バージョンを再インストールしてください:pip install av numpy scipy - ビデオメモリ不足ビデオメモリが6GB未満の場合、生成に失敗することがあります。より大きなメモリを搭載したGPUを使用するか、ビデオの長さを短くすることをお勧めします。

使用方法

FramePackのコア機能は、1枚の画像からビデオを生成し、キューワードによるビデオコンテンツのコントロールをサポートすることです。以下に詳しい操作手順を示します。

1.グラディオのインターフェイスへのアクセス

アクティベート demo_gradio.py その後、ブラウザにFramePackのユーザーインターフェイスが表示されます。インターフェイスは左右に分かれています:

- 左:画像をアップロードし、プロンプトの言葉を入力。

- 右:生成されたビデオと潜在プレビュー(latent preview)が表示されます。

2.画像のアップロード

左側の画像アップロード領域をクリックし、ローカル画像を選択します(推奨解像度544x704または同等のサイズ)FramePackはこの画像に基づいてビデオコンテンツを生成します。

3.入力プロンプト

ビデオのアクションを説明する短い文章を、Cue Word テキスト ボックスに入力します。簡潔でアクション指向のキュー ワードがお勧めです:

The girl dances gracefully, with clear movements, full of charm.A robot jumps energetically, spinning in a futuristic city.

FramePackは公式に、GPT経由でアクションキューを生成することを推奨しています:

あなたは、画像をアニメーションさせるための、動きに焦点を当てた短いプロンプトを書くアシスタントです。 ユーザーが画像を送信したら、視覚的な動きを説明する簡潔なプロンプト1つで応答してください。視覚的な動きを描写する

4.動画生成

インターフェイスの生成ボタンをクリックすると、FramePackが処理を開始します。生成プロセスはセグメントごとに行われ、各セグメントは約1秒間のビデオを生成し、徐々につなぎ合わされて完全なビデオになります。生成の進行状況は、プログレスバーと潜在的なプレビューによって表示されます。生成されたファイルは ./outputs/ フォルダー

5.表示と調整

生成プロセスの最初には、短いビデオ(例えば1秒)しか得られないかもしれません。これは通常のことで、完全なビデオを完成させるには、さらにクリップが生成されるのを待つ必要があります。結果に満足できない場合は、プロンプトを調整するか、入力画像を変更して再生することができます。

発電速度の最適化

- 使い始める ティーキャッシュ生成設定でteacacheを有効にすると2.5秒/フレームから1.5秒/フレームに高速化されます。

- NVIDIA 4090のような高性能GPUによる高速化。

- Sage-attentionを無効にする:Sage-attentionがインストールされている場合、最初のテストではSage-attentionを無効にすることで、高品質の生成を保証することができる。

注目の機能操作

低メモリ生成

FramePackの核となる強みは、必要なビデオメモリが少ないことだ。入力コンテキストを圧縮することで、60秒間の30fpsビデオを生成するのに必要なビデオメモリはわずか6GBです。追加の設定は必要なく、システムが自動的にグラフィックス・メモリの割り当てを最適化します。

次のフレーム予測

FramePackは、次のフレームを予測するニューラルネットワークを使用して、フレームごとにビデオを生成します。ユーザーは、生成された各セグメントの潜在的なプレビューをGradioインターフェイスでリアルタイムに表示し、ビデオコンテンツが期待通りであることを確認できます。

グラディオ・インターフェイス

グラディオのインターフェイスはシンプルで直感的で、迅速なアップロードとプレビューをサポートしています。ユーザーは --share パラメータを使用してパブリック・ネットワークとインターフェイスを共有することもできます。 --port 歌で応える --server カスタム・ポートとサーバー・アドレス:

python demo_gradio.py --share --port 7861 --server 0.0.0.0

アプリケーションシナリオ

- コンテンツ制作

FramePackは、映像クリエイターが短いダイナミックな動画を生成するのに適しています。例えば、ソーシャルメディアのコンテンツ制作のために、キャラクター画像からダンスビデオを生成する。必要なビデオメモリが少ないので、一般のユーザーでも簡単に始められます。 - ゲーム開発

開発者は、FramePackを使用して、キャラクターの移動や環境の変化などの動的なシーンアニメーションを生成し、手作業によるモデリングの時間を節約することができます。軽量モデルは、リアルタイムレンダリングの可能性をサポートします。 - 教育とデモンストレーション

教師やトレーナーは、静止画像から教育ビデオを作成し、動的なプロセス(例えば、科学実験のシミュレーション)を示すことができます。 - エッジコンピューティング

FramePackの13億パラメータ・モデルは、ローカライズされたビデオ生成のために、モバイル機器や組み込みシステムなどのエッジ・デバイスへの展開に適している。

品質保証

- FramePackはどのGPUをサポートしていますか?

最低6GBのRAMを搭載したNVIDIA RTX 30XX、40XX、50XXシリーズGPUをサポート。 GTX 10XX/20XXはテストされていないため、互換性がない可能性があります。 - ビデオの作成にはどれくらいの時間がかかりますか?

NVIDIA 4090では、最適化なしで2.5秒/フレーム、teacacheを有効にすると1.5秒/フレームです。5秒間のビデオを生成するのに約3-4分かかる。 - 発電の質はどうすれば向上するのか?

高品質の入力画像を使用し、明確なアクションキューを書き、セージアテンションを無効にし、最終的な高品質生成のためにティーキャッシュをオフにする。 - 特別に長いビデオを作成することは可能ですか?

はい、FramePackは何千ものビデオフレーム(例えば30fpsで60秒)の生成をサポートしています。ビデオメモリ要件は固定であり、ビデオの長さによって増加することはありません。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません