フィッシュ・スピーチ:少ないサンプル数で中国語と英語の音声を高速かつ高精度にクローニング

はじめに

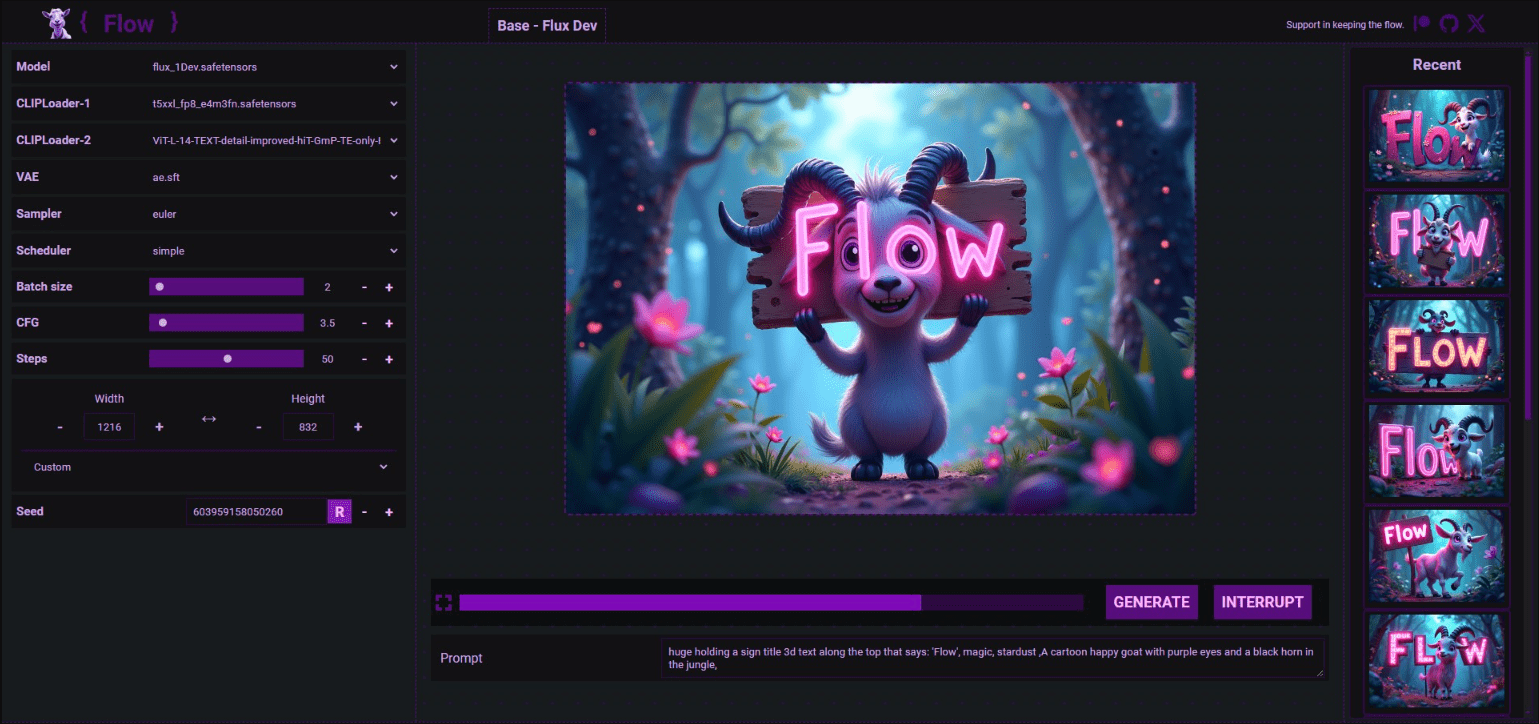

フィッシュ・スピーチはフィッシュ・オーディオによって開発されたオープンソースの音声合成ツールです。このツールは、VQ-GAN、Llama、VITSなどの最先端のAI技術に基づいており、テキストをリアルな音声に変換することができます。フィッシュ・スピーチは、多言語をサポートするだけでなく、吹き替え、音声アシスタント、アクセシブル・リーディングなど、さまざまなアプリケーション・シナリオに対応する高効率な音声合成ソリューションを提供します。

音声クローンプロジェクトFishSpeech 1.5アップデート〜例えば、私が共有した以前のものと似ている F5-TTS そして マスクGCT FishSpeechは、たった5〜10秒の音声サンプルで人の声の特徴を高度に再現するボイス・クローニング・プロジェクトで、中国語、英語、日本語、韓国語など多言語のやり取りをサポートしている。

オープンソースのFish Speech v1.5.0 Optimised One Piece Integration Packが提供されました。

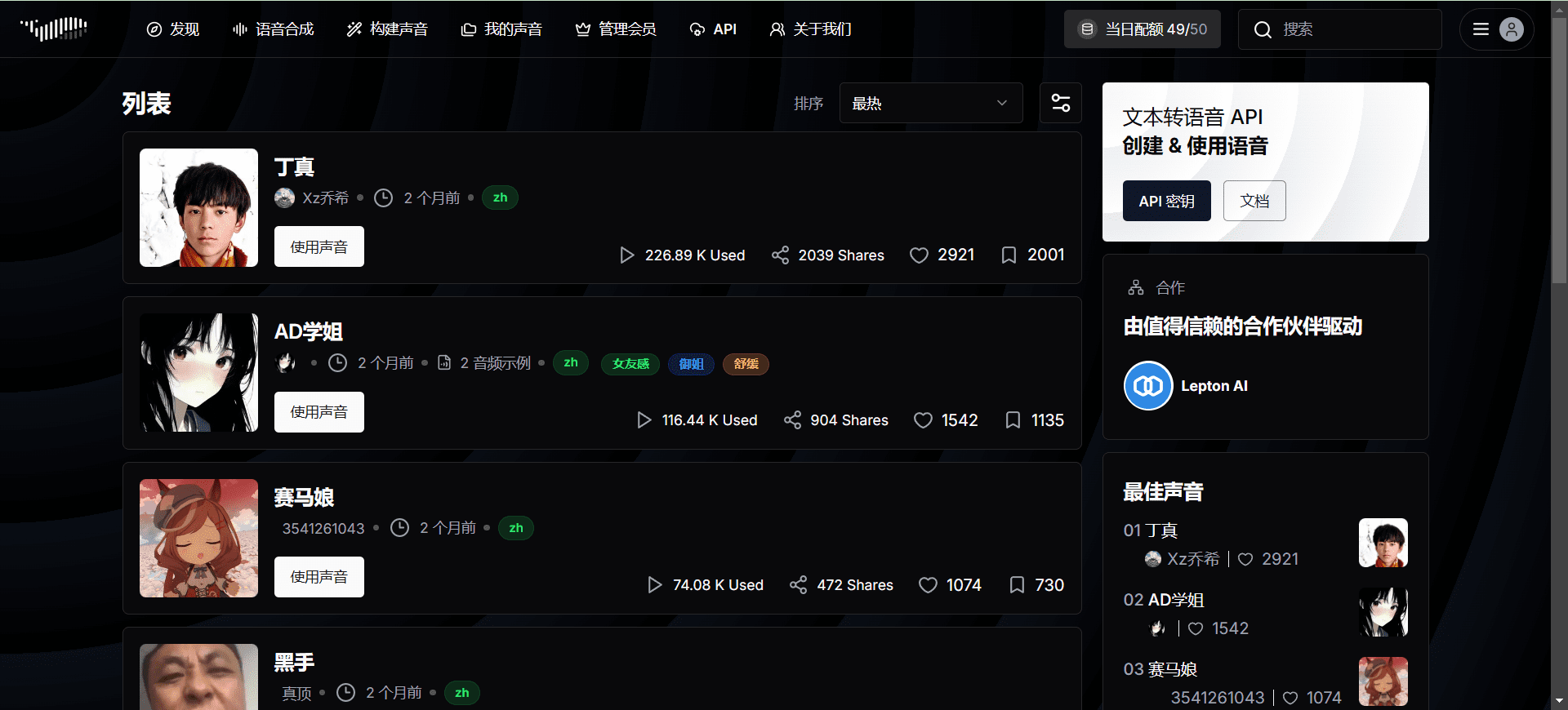

https://fish.audio/zh-CN/ でのオンライン体験

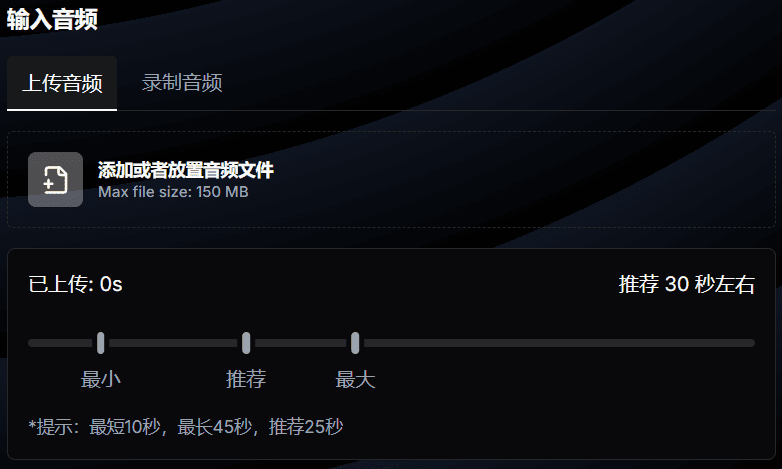

推奨30秒オーディオ

機能一覧

- 多言語サポート多言語の音声合成に対応。

- 効率的な合成VQ-GAN、Llama、VITSなどの技術に基づく効率的な音声合成。

- オープンソースプロジェクトコードはオープンソースで、ユーザーは自由にダウンロードして使うことができる。

- オンラインデモオンラインデモ機能を提供し、ユーザーは直接音声合成の効果を体験することができます。

- モデルダウンロードHugging Faceプラットフォームからの事前学習済みモデルのダウンロードをサポート。

ヘルプの使用

設置プロセス

システム要件

- GPUメモリー4GB(推論用)、8GB(微調整用)

- システムLinux、Windows

Windowsの構成

プロ・ユーザー

- コードベースの実行には、WSL2またはDockerの使用を検討してください。

ノンプロフェッショナルユーザー

- プロジェクトのzipを解凍する.

- 打込む install_env.bat インストール環境.

- ミラーダウンロードを使用するかどうかは、install_env.bat の USE_MIRROR エントリを編集することで決定できます。

USE_MIRROR=falseトーチ環境の最新安定版をダウンロードするには、本家サイトをご利用ください。USE_MIRROR=trueミラーサイトを使って最新のトーチ環境をダウンロードしてください(デフォルト)。

- コンパイル可能な環境のダウンロードを有効にするかどうかは、install_env.batのINSTALL_TYPEエントリーを編集することで決定できる。

INSTALL_TYPE=previewコンパイル環境の開発版をダウンロードする。INSTALL_TYPE=stableコンパイル環境なしの安定版をダウンロードする。

- ミラーダウンロードを使用するかどうかは、install_env.bat の USE_MIRROR エントリを編集することで決定できます。

- ステップ2の場合 INSTALL_TYPE=previewコンパイル済みモデル環境がない場合は、このステップを実行します(省略可能、このステップでコンパイル済みモデル環境が有効になります)。

- LLVMコンパイラーをダウンロードする:

- LLVM-17.0.6(オリジナルサイトダウンロード)

- LLVM-17.0.6(ミラーサイトダウンロード)

- LLVM-17.0.6-win64.exeをダウンロードした後、ダブルクリックしてインストールし、適切なインストール場所を選択し、環境変数を追加するためにカレント・ユーザーにパスを追加にチェックを入れる。

- LLVMコンパイラーをダウンロードする:

- Microsoft Visual C++ 再頒布可能パッケージのダウンロードとインストール.dllが失われる可能性のある問題を解決する。

- Visual Studio Community EditionをダウンロードしてインストールするMSVC++コンパイル・ツールにLLVMヘッダー・ファイルの依存関係を解決させる。

- Visual Studio ダウンロード

- Visual Studio Installerをインストールした後、Visual Studio Community 2022をダウンロードしてください。

- Modify ボタンをクリックし、Desktop Development using C++ 項目を見つけ、Download にチェックを入れます。

- ダウンロードとインストール CUDAツールキット12.

- ダブルクリック スタートバット Training Reasoning WebUIの管理インターフェイスを開きます。.必要であれば、以下に示すようにAPI_FLAGSを変更する。

- Reasoning WebUI インターフェースを起動しますか?プロジェクトのルート・ディレクトリにあるAPI_FLAGS.txtを編集し、最初の3行を以下のフォーマットに変更してください:

--infer # --api # --listen ... - APIサーバーを起動しますか?プロジェクトのルート・ディレクトリにあるAPI_FLAGS.txtを編集し、最初の3行を以下のフォーマットに変更してください:

# --infer --api --listen ...

- Reasoning WebUI インターフェースを起動しますか?プロジェクトのルート・ディレクトリにあるAPI_FLAGS.txtを編集し、最初の3行を以下のフォーマットに変更してください:

- ダブルクリック ラン_cmd.bat このプロジェクトのconda/pythonコマンドライン環境に入る。.

Linuxの設定

- python 3.10の仮想環境の作成virtualenvを使うこともできる:

conda create -n fish-speech python=3.10 conda activate fish-speech - pytorchのインストール::

pip3 install torch torchvision torchaudio - フィッシュ・スピーチをインストールする::

pip3 install -e .[stable] - (Ubuntu / Debian ユーザ) sox をインストールする。::

apt install libsox-dev

Dockerの設定

- NVIDIA Container Toolkitのインストール::

- Ubuntuユーザーへ:

curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg \ && curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | \ sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | \ sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list sudo apt-get update sudo apt-get install -y nvidia-container-toolkit sudo systemctl restart docker - 他のLinuxディストリビューションをお使いの方は、NVIDIA Container Toolkit Install-guideをご参照ください。

- Ubuntuユーザーへ:

- フィッシュ・スピーチ・イメージを引っ張り出して実行する::

docker pull lengyue233/fish-speech docker run -it \ --name fish-speech \ --gpus all \ -p 7860:7860 \ lengyue233/fish-speech \ zsh- 別のポートを使用する必要がある場合は、以下のように変更してください。

-pパラメーターYourPort:7860.

- 別のポートを使用する必要がある場合は、以下のように変更してください。

- モデルの依存関係をダウンロード::

- 必要なvqganとllamaモデルをhuggingfaceリポジトリからダウンロードする前に、dockerコンテナ内のターミナルにいることを確認してください:

huggingface-cli download fishaudio/fish-speech-1.4 --local-dir checkpoints/fish-speech-1.4 - 中国本土のユーザーは、ミラーサイトからダウンロードできる:

HF_ENDPOINT=https://hf-mirror.com huggingface-cli download fishaudio/fish-speech-1.4 --local-dir checkpoints/fish-speech-1.4

- 必要なvqganとllamaモデルをhuggingfaceリポジトリからダウンロードする前に、dockerコンテナ内のターミナルにいることを確認してください:

- 環境変数を設定するには、WebUIにアクセスします。::

- ドッカー・コンテナ内のターミナルで、次のようにタイプする:

export GRADIO_SERVER_NAME="0.0.0.0" - 次に、ドッカー・コンテナ内のターミナルで、次のようにタイプする:

python tools/webui.py - WSLまたはMacOSの場合は

http://localhost:7860WebUI インターフェースが開きます。 - サーバーに配置する場合は

localhostはサーバーIPです。

- ドッカー・コンテナ内のターミナルで、次のようにタイプする:

フィッシュオーディオ・ワンクリックインストーラー

ニウの最新バージョン、復号コードを推薦する:niugee.com

https://drive.google.com/drive/folders/1KeYuZ9fYplDEgA3jg2IUKtECpT0wsz6V?usp=drive_link

リンクhttps://pan.baidu.com/s/1pWaziAC7xMV908TuOkYdyw?pwd=niug 抽出コード: niug

Sword 27 Special Edition: https://pan.quark.cn/s/30608499dee1 解凍パスワードは jian27 または jian27.com です。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません