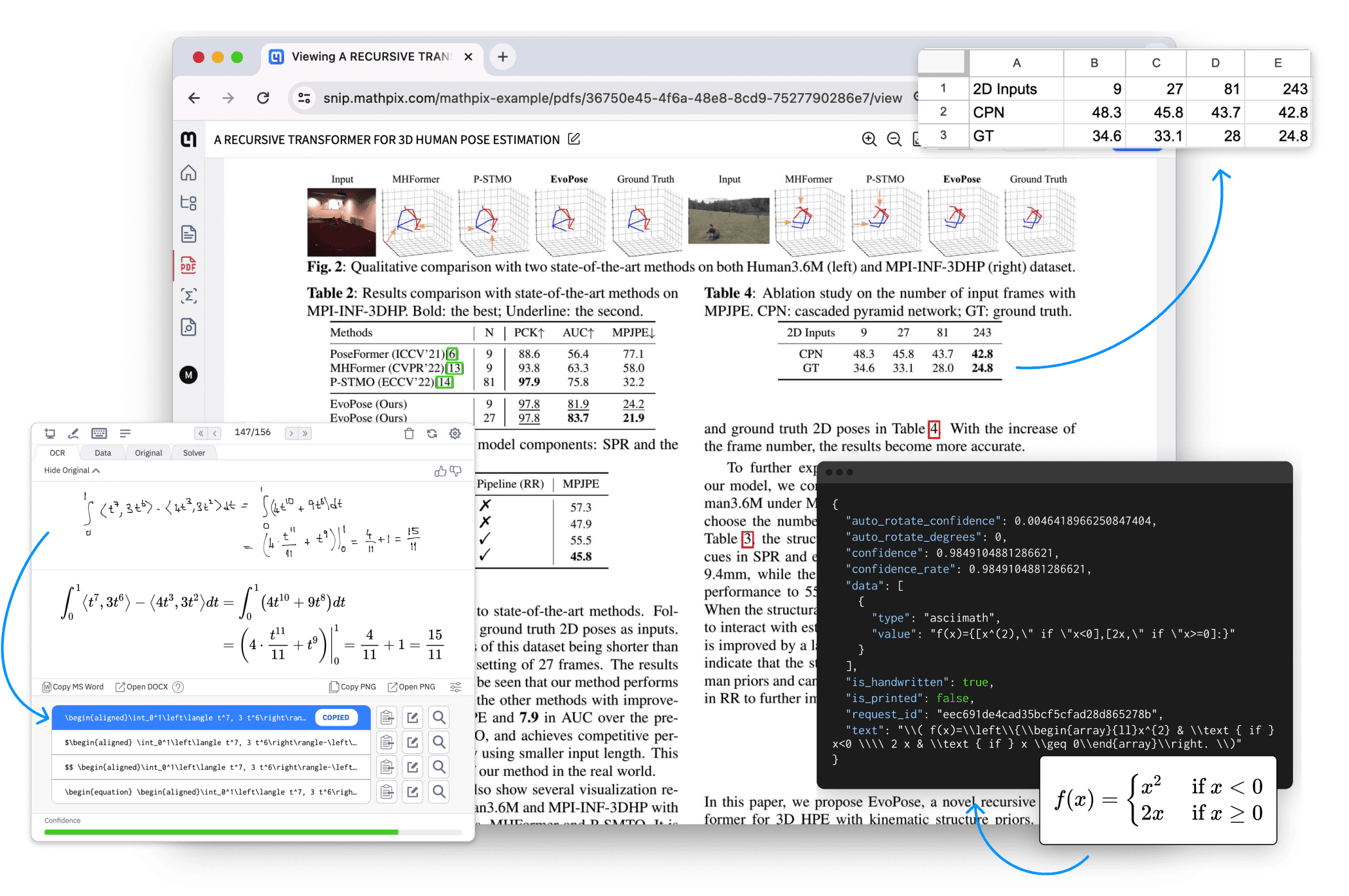

フィッシュ・エージェント:エンド・ツー・エンドのAIボイス・クローン・アシスタント、リアルタイム音声対話アシスタント、フィッシュ・スピーチ・スピンオフ・プロジェクト

はじめに

魚のスピーチ 派生プロジェクトフィッシュエージェントは、V0.1 3Bモデルアーキテクチャに基づいて開発された、革命的なエンドツーエンドのAI音声クローニングシステムです。完全なエンドツーエンドの音声クローニング処理システムとして、その最大の特徴は、革新的なセマンティックタグレスアーキテクチャで設計されており、Whisperのような従来のセマンティックエンコーダ/デコーダに依存することなく、音声から音声への変換を直接実現できることです。超低遅延(最短150ミリ秒)により、周囲の音声情報を正確に取り込み、生成することで、ほぼリアルタイムの音声クローニング効果を実現します。Fish Agentは、事前にトレーニングされたモデルのダウンロードを開放し、ローカル展開のトレーニングやクラウドサービスの呼び出しをサポートすることで、開発者やユーザーに柔軟な利用プランを提供します。統合された音声認識と音声合成機能、そして正確なトーン・コントロール・システムにより、フィッシュ・エージェントは自然でスムーズな音声対話体験を作り出すことができます。

エンド・ツー・エンド・アーキテクチャー、ゼロサンプルのサウンドクローニング、30億パラメータのコンパクトモデル、多言語対応、高速レスポンス。トレーニングデータには70万時間の多言語音声が含まれます。Qwen-2.5-3B-Instructをベースに事前学習を継続。フィッシュエージェント・バージョン3Bと名付けられたこのモデルは、ASRとTTSコンポーネントを自動的に統合し、外部モデルの必要性を排除し、従来の3段階(ASR + LLM + TTS)処理とは一線を画す真のエンドツーエンド処理を可能にします。

経験:https://huggingface.co/spaces/fishaudio/fish-agent

機能一覧

- 超低遅延ボイスクローニング:応答時間150ms、リアルタイム音声変換に対応

- セマンティックフリー・タギング・アーキテクチャ:革新的なエンド・ツー・エンドの音声処理ソリューション

- プレシジョン・トーン・コントロール:リファレンス・オーディオによる正確なトーン調整

- アンビエントオーディオ処理:環境音情報を忠実に再現

- オープンな事前学習済みモデル:地域ごとの展開とトレーニングをサポート

- クラウドサービスAPI:便利なクラウドインターフェースコールを提供

- パーソナライズドトレーニング:カスタマイズされたサウンドモデルトレーニングをサポート

ヘルプの使用

1.システム要件

- Python 3.8以上

- NVIDIA GPU(推奨)

- 8GB以上のシステムメモリ

- CUDAサポート(推奨)

2.インストール手順

- 環境準備

# 创建虚拟环境

python -m venv fish-agent-env

source fish-agent-env/bin/activate # Linux/Mac

# 或

fish-agent-env\Scripts\activate # Windows

- フィッシュエージェントのインストール

# 直接安装

pip install fish-agent

# 或从源码安装

git clone https://github.com/fishaudio/fish-agent

cd fish-agent

pip install -e .

3.ご利用の流れ

3.1 オンライン・サービスの利用

SmartBodyのデモをオンラインでお試しいただけます。ドキュメンテーションに従って、英語のライブチャット、英語と中国語のローカルチャットをお試しください。

このデモは初期のアルファテスト版であり、推論速度の最適化が必要であり、修正すべきバグがたくさんあります。バグを見つけたり、修正したい場合は、質問やプルリクエストを受け付けています。

https://fish.audio/zh-CN/demo/live/

3.2 現地展開

- サービス・アクティベーション

from fish_agent import VoiceAgent

# 初始化Fish Agent

agent = VoiceAgent()

# 启动本地服务

agent.start_server(port=7860)

- スピーチのクローニング例

# 加载参考音频

reference_audio = "path/to/reference.wav"

agent.load_reference(reference_audio)

# 生成克隆语音

text = "这是一段测试语音"

output_path = "output.wav"

agent.generate_speech(text, output_path)

- リアルタイム変換設定

# 启动实时语音转换

agent.start_realtime_conversion(

input_device=0, # 输入设备ID

output_device=1, # 输出设备ID

reference_audio="path/to/reference.wav"

)

4.高度な機能設定

4.1 音色のパラメーター調整

- トーン・コントロールのパラメーター:

- ピッチ:-12~12

- 話すスピード:0.5~2.0

- 感情強度:0~1.0

4.2 バッチ処理

# 批量文本处理

texts = ["文本1", "文本2", "文本3"]

agent.batch_process(texts, output_dir="outputs/")

4.3 APIコール

# API调用示例

import requests

url = "https://speech.fish.audio/api/v1/generate"

payload = {

"text": "要转换的文本",

"reference_audio": "base64编码的音频文件"

}

response = requests.post(url, json=payload)

5.使用上の注意

- リファレンス・オーディオの音質は、クローン作成結果に大きな影響を与えるため、バックグラウンド・ノイズのないクリアな録音を使用することをお勧めします。

- 1つの文章は200ワード以内にまとめることを推奨する。

- リアルタイム変換には、より良い結果を得るために良いマイクが必要です。

- 商業利用には特定の認可が必要

- 最適なパフォーマンスを得るためには、定期的にモデルをアップデートすることをお勧めします。

6.一般的な問題の解決

- 音声出力の問題

- オーディオ出力デバイス設定の確認

- システムボリュームの構成を確認する

- オーディオ・フォーマットのサポートを確認する

- パフォーマンス最適化

- GPUが正しく有効になっていることを確認する

- バッチパラメータの調整

- 定期的なキャッシュクリーニング

- インストール関連

- Pythonのバージョン互換性の確認

- CUDA環境設定の確認

- conda環境を考える

- APIの使用

- ネットワーク接続状況の確認

- APIパーミッション設定の確認

- サーバーの応答を確認する

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません